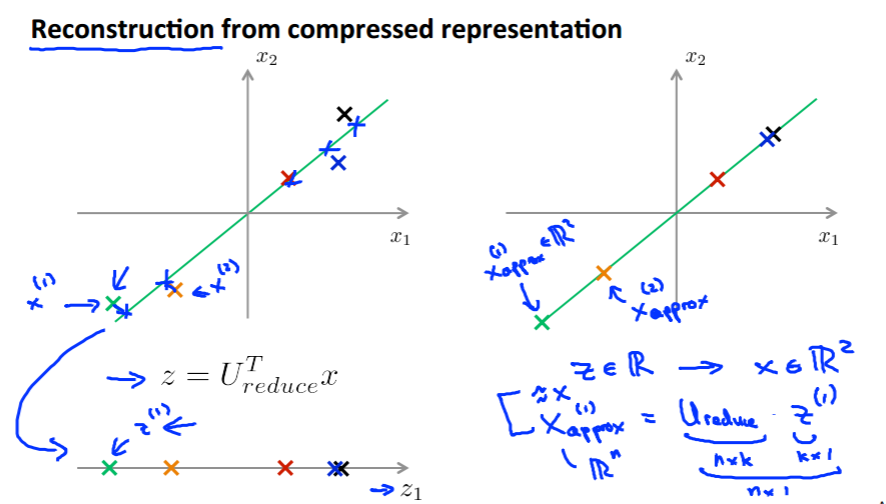

我们通过PCA把二维数据降到一维。

那么怎么把一维数据变回二维

通过X=UZ

我们得到的点都在z轴上

这个X十分解决x了

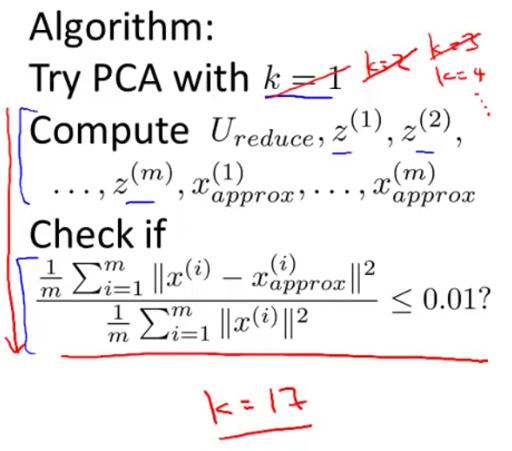

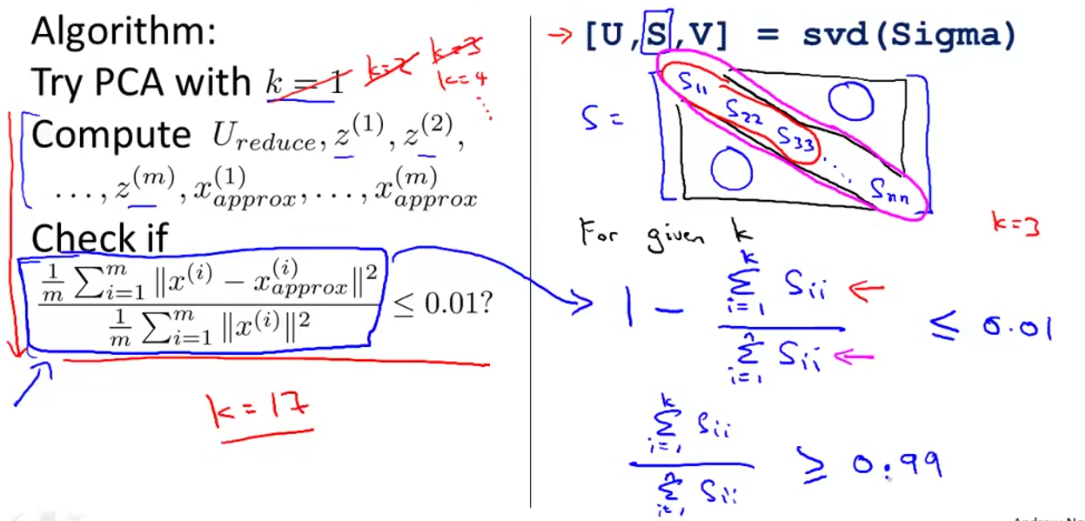

如何去选择k值

PCA的成本函数:

![]()

总变差(这些x长度的平方均值):

意味这我的平均向量离0向量有多远

我们选择k使下面的公式成立:

使得99%差异性得到保留

除了0.01,人们也用0.1,0.05

总过程:

优化辨别式:

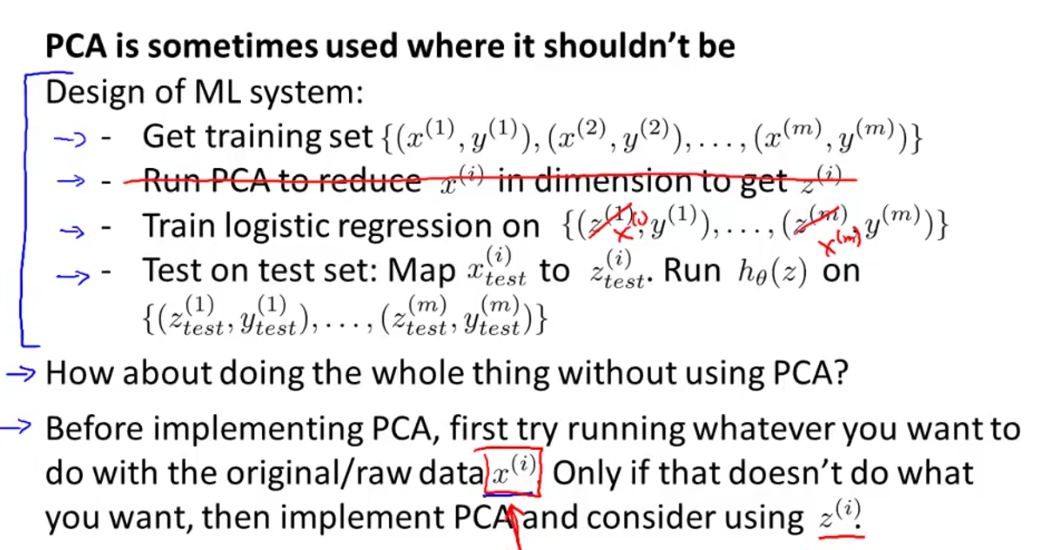

一些PCA的建议:

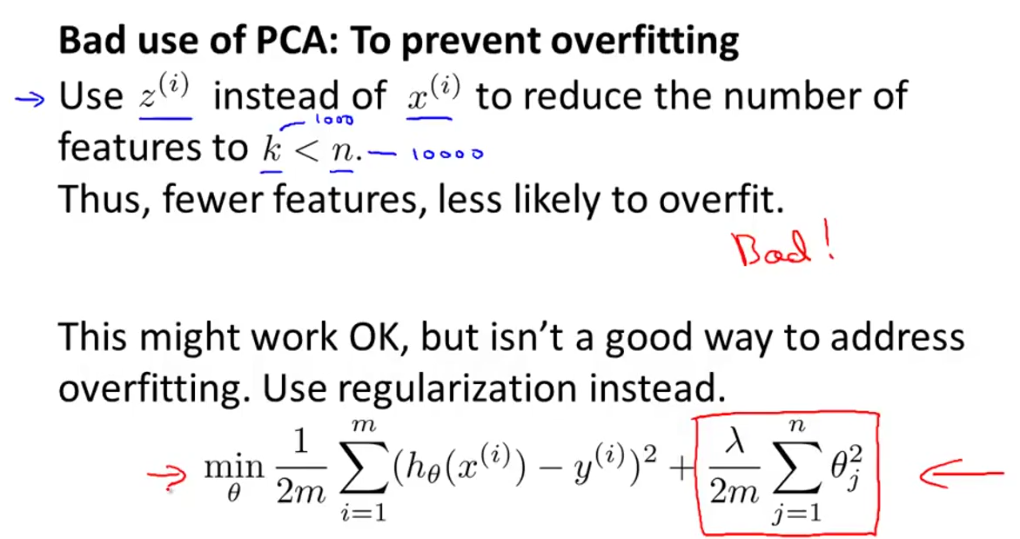

不好的使用:来避免过拟合

错误观点:有人认为把特征变量的维数降下来会使数据更容易

拟合,但这是错误的。

过拟合还是需要正则项来解决:

一开始不要一下就把PCA算法加入你的学习算法,

要先用原始数据进行测试。如果占用内存,运算时间,

等不理想,才来用PCA压缩数据。