本导读将向您介绍使用 Jenkins、Jenkins 的主要特性和 Jenkins Pipeline 的基本知识。 本导读使用“独立”的 Jenkins 发行版,它可以在您自己本地的机器上运行。

准备工作

第一次使用 Jenkins,您需要:

-

机器要求:

-

256 MB 内存,建议大于 512 MB

-

10 GB 的硬盘空间(用于 Jenkins 和 Docker 镜像)

-

-

需要安装以下软件:

-

Java 8 ( JRE 或者 JDK 都可以)

-

Docker (导航到网站顶部的Get Docker链接以访问适合您平台的Docker下载)

-

下载并运行 Jenkins

-

打开终端进入到下载目录.

-

运行命令

java -jar jenkins.war --httpPort=8080. -

打开浏览器进入链接

http://localhost:8080. -

按照说明完成安装.

安装完成后,您可以开始使用 Jenkins!

创建您的第一个Pipeline

Table of Contents

什么是 Jenkins Pipeline?

Jenkins Pipeline(或简称为 "Pipeline")是一套插件,将持续交付的实现和实施集成到 Jenkins 中。

持续交付 Pipeline 自动化的表达了这样一种流程:将基于版本控制管理的软件持续的交付到您的用户和消费者手中。

Jenkins Pipeline 提供了一套可扩展的工具,用于将“简单到复杂”的交付流程实现为“持续交付即代码”。Jenkins Pipeline 的定义通常被写入到一个文本文件(称为 Jenkinsfile )中,该文件可以被放入项目的源代码控制库中。 [1]]

Pipeline 和 Jenkinsfile 的更多相关信息,请参考用户手册中的相关链接 Pipeline 和 使用 Jenkinsfile

快速开始使用 Pipeline:

-

将以下示例 复制到您的仓库中并命名为

Jenkinsfile -

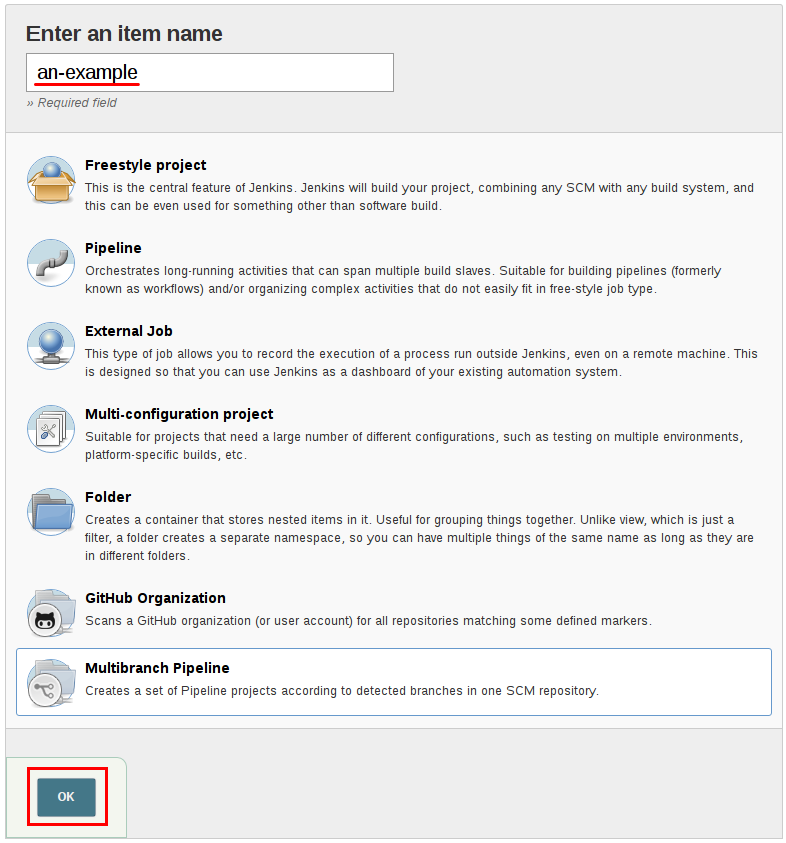

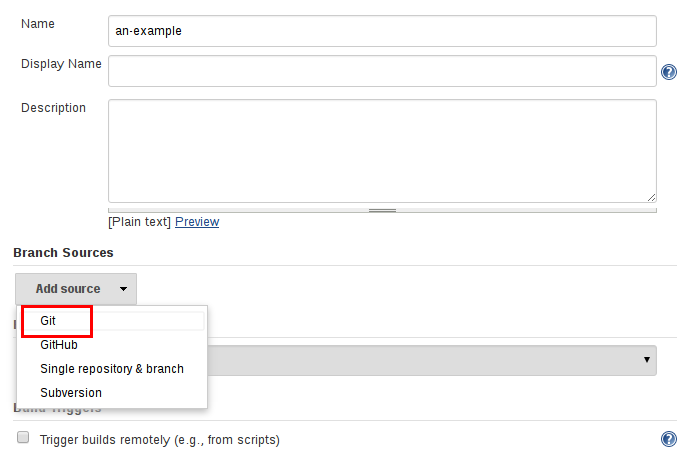

单击Jenkins中的 New Item 菜单

-

为您的新工程起一个名字 (例如 My Pipeline) ,选择 Multibranch Pipeline

-

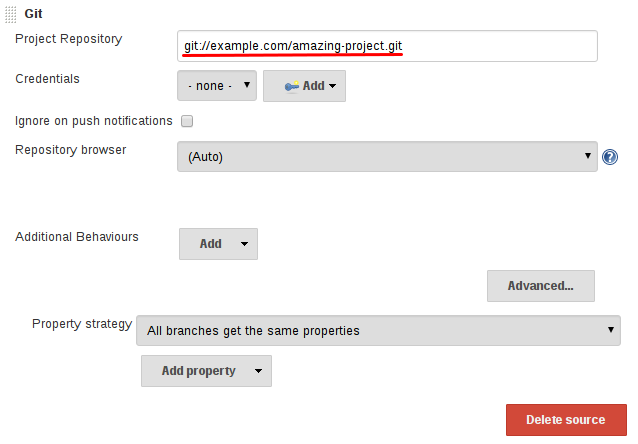

单击 Add Source 按钮,选择您想要使用的仓库类型并填写详细信息.

-

单击 Save 按钮,观察您的第一个Pipeline运行!

您可能需要修改 Jenkinsfile 以便应用在您自己的项目中。尝试修改 sh 命令,使其与您本地运行的命令相同。

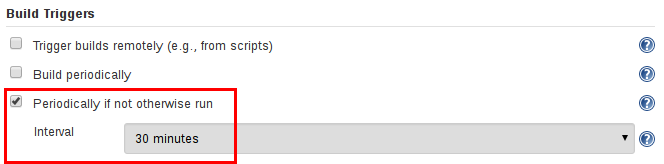

在配置好 Pipeline 之后,Jenkins 会自动检测您仓库中创建的任何新的分支或合并请求, 并开始为它们运行 Pipelines。

快速开始示例

下面是一个简单的 Pipeline 各种语言的复制和粘贴示例。

Java

Jenkinsfile (Declarative Pipeline)

pipeline {

agent { docker 'maven:3.3.3' }

stages {

stage('build') {

steps {

sh 'mvn --version'

}

}

}

}

Toggle Scripted Pipeline (Advanced)

Node.js / JavaScript

Jenkinsfile (Declarative Pipeline)

pipeline {

agent { docker 'node:6.3' }

stages {

stage('build') {

steps {

sh 'npm --version'

}

}

}

}

Toggle Scripted Pipeline (Advanced)

Ruby

Jenkinsfile (Declarative Pipeline)

pipeline {

agent { docker 'ruby' }

stages {

stage('build') {

steps {

sh 'ruby --version'

}

}

}

}

Toggle Scripted Pipeline (Advanced)

Python

Jenkinsfile (Declarative Pipeline)

pipeline {

agent { docker 'python:3.5.1' }

stages {

stage('build') {

steps {

sh 'python --version'

}

}

}

}

Toggle Scripted Pipeline (Advanced)

PHP

Jenkinsfile (Declarative Pipeline)

pipeline {

agent { docker 'php' }

stages {

stage('build') {

steps {

sh 'php --version'

}

}

}

}

Toggle Scripted Pipeline (Advanced)

1. https://en.wikipedia.org/wiki/Source_control_management[Source Control Management

执行多个步骤(step)

Table of Contents

Pipelines 由多个步骤(step)组成,允许你构建、测试和部署应用。 Jenkins Pipeline 允许您使用一种简单的方式组合多个步骤, 以帮助您实现多种类型的自动化构建过程。

可以把“步骤(step)”看作一个执行单一动作的单一的命令。 当一个步骤运行成功时继续运行下一个步骤。 当任何一个步骤执行失败时,Pipeline 的执行结果也为失败。

当所有的步骤都执行完成并且为成功时,Pipeline 的执行结果为成功。

Linux、BSD 和 Mac OS

在 Linux、BSD 和 Mac OS(类 Unix ) 系统中的 shell 命令, 对应于 Pipeline 中的一个 sh 步骤(step)。

Jenkinsfile (Declarative Pipeline)

pipeline {

agent any

stages {

stage('Build') {

steps {

sh 'echo "Hello World"'

sh '''

echo "Multiline shell steps works too"

ls -lah

'''

}

}

}

}

Toggle Scripted Pipeline (Advanced)

Windows

基于 Windows 的系统使用 bat 步骤表示执行批处理命令。

Jenkinsfile (Declarative Pipeline)

pipeline {

agent any

stages {

stage('Build') {

steps {

bat 'set'

}

}

}

}

Toggle Scripted Pipeline (Advanced)

超时、重试和更多

Jenkins Pipeline 提供了很多的步骤(step),这些步骤可以相互组合嵌套,方便地解决像重复执行步骤直到成功(重试)和如果一个步骤执行花费的时间太长则退出(超时)等问题。

Jenkinsfile (Declarative Pipeline)

pipeline {

agent any

stages {

stage('Deploy') {

steps {

retry(3) {

sh './flakey-deploy.sh'

}

timeout(time: 3, unit: 'MINUTES') {

sh './health-check.sh'

}

}

}

}

}

Toggle Scripted Pipeline (Advanced)

“Deploy”阶段(stage)重复执行 flakey-deploy.sh 脚本3次,然后等待 health-check.sh 脚本最长执行3分钟。 如果 health-check.sh 脚本在 3 分钟内没有完成,Pipeline 将会标记在“Deploy”阶段失败。

内嵌类型的步骤,例如 timeout 和 retry 可以包含其他的步骤,包括 timeout 和 retry 。

我们也可以组合这些步骤。例如,如果我们想要重试部署任务 5 次,但是总共花费的时间不能超过 3 分钟。

Jenkinsfile (Declarative Pipeline)

pipeline {

agent any

stages {

stage('Deploy') {

steps {

timeout(time: 3, unit: 'MINUTES') {

retry(5) {

sh './flakey-deploy.sh'

}

}

}

}

}

}

Toggle Scripted Pipeline (Advanced)

完成时动作

当 Pipeline 运行完成时,你可能需要做一些清理工作或者基于 Pipeline 的运行结果执行不同的操作, 这些操作可以放在 post 部分。

Jenkinsfile (Declarative Pipeline)

pipeline {

agent any

stages {

stage('Test') {

steps {

sh 'echo "Fail!"; exit 1'

}

}

}

post {

always {

echo 'This will always run'

}

success {

echo 'This will run only if successful'

}

failure {

echo 'This will run only if failed'

}

unstable {

echo 'This will run only if the run was marked as unstable'

}

changed {

echo 'This will run only if the state of the Pipeline has changed'

echo 'For example, if the Pipeline was previously failing but is now successful'

}

}

}

Toggle Scripted Pipeline (Advanced)

完成定义多个步骤(step)的基本学习之后,我们 继续学习“定义执行环境”

定义执行环境

在 上一小节 您可能已经注意到每个示例中的 agent 指令。 agent 指令告诉Jenkins在哪里以及如何执行Pipeline或者Pipeline子集。 正如您所预料的,所有的Pipeline都需要 agent 指令。

在执行引擎中,agent 指令会引起以下操作的执行:

-

所有在块block中的步骤steps会被Jenkins保存在一个执行队列中。 一旦一个执行器 executor 是可以利用的,这些步骤将会开始执行。

-

一个工作空间 workspace 将会被分配, 工作空间中会包含来自远程仓库的文件和一些用于Pipeline的工作文件

在Pipeline中可以使用这几种 定义代理的方式 在本导读中,我们仅使用Docker容器的代理方式。

在Pipeline中可以很容易的运行 Docker 镜像和容器。 Pipeline可以定义命令或者应用运行需要的环境和工具, 不需要在执行代理中手动去配置各种各样的系统工具和依赖。 这种方式可以让你使用 Docker容器工具包 中的任何工具。

agent 指令更多选项和相关信息,可以查看 语法参考 。

Jenkinsfile (Declarative Pipeline)

pipeline {

agent {

docker { image 'node:7-alpine' }

}

stages {

stage('Test') {

steps {

sh 'node --version'

}

}

}

}

Toggle Scripted Pipeline (Advanced)

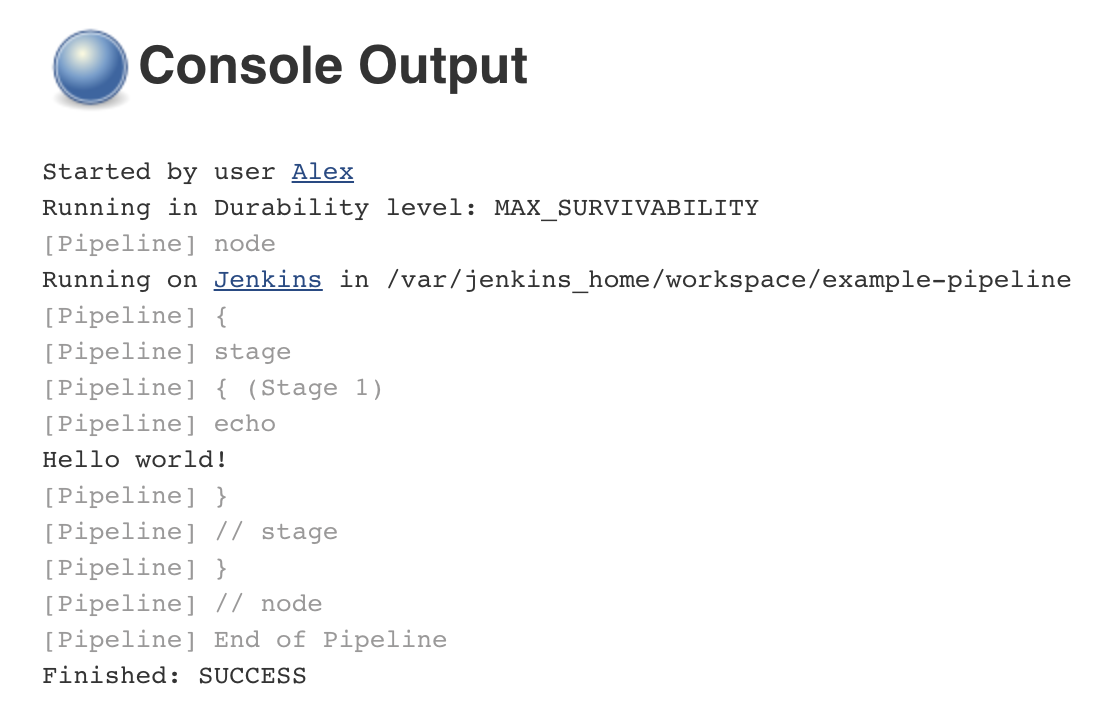

当执行Pipeline时,Jenkins将会自动运行指定的容器,并执行Pipeline中已经定义好的步骤steps:

[Pipeline] stage

[Pipeline] { (Test)

[Pipeline] sh

[guided-tour] Running shell script

+ node --version

v7.4.0

[Pipeline] }

[Pipeline] // stage

[Pipeline] }

在Pipeline中,混合和搭配不同的容器或者其他代理可以获得更大的灵活性。 更多配置选项和信息,可以参考 继续“使用环境变量” 。

使用环境变量

Table of Contents

环境变量可以像下面的示例设置为全局的,也可以是阶段(stage)级别的。 如你所想,阶段(stage)级别的环境变量只能在定义变量的阶段(stage)使用。

Jenkinsfile (Declarative Pipeline)

pipeline {

agent any

environment {

DISABLE_AUTH = 'true'

DB_ENGINE = 'sqlite'

}

stages {

stage('Build') {

steps {

sh 'printenv'

}

}

}

}

Toggle Scripted Pipeline (Advanced)

这种在 Jenkinsfile 中定义环境变量的方法对于指令性的脚本定义非常有用方便, 比如 Makefile 文件,可以在 Pipeline 中配置构建或者测试的环境,然后在 Jenkins 中运行。

环境变量的另一个常见用途是设置或者覆盖构建或测试脚本中的凭证。 因为把凭证信息直接写入 Jenkinsfile 很显然是一个坏主意, Jenkins Pipeline 允许用户快速安全地访问在 Jenkinsfile 中预定义的凭证信息,并且无需知道它们的值。

环境变量中的凭证信息

记录测试和构建结果

虽然测试是良好的持续交付过程中的关键部分,但大多数人并不希望筛选数千行控制台输出来查找有关失败测试的信息。 为了简化操作,只要您的测试运行时可以输出测试结果文件,Jenkins 就可以记录和汇总这些测试结果。 Jenkins 通常与 junit 步骤捆绑在一起,但如果您的测试运行结果无法输出 JUnit 样式的 XML 报告, 那么还有其他插件可以处理任何广泛使用的测试报告格式。

为了收集我们的测试结果,我们将使用 post 部分。

Jenkinsfile (Declarative Pipeline)

pipeline {

agent any

stages {

stage('Test') {

steps {

sh './gradlew check'

}

}

}

post {

always {

junit 'build/reports/**/*.xml'

}

}

}

Toggle Scripted Pipeline (Advanced)

这将会获得测试结果,Jenkins 会持续跟踪并计算测试的趋势和结果。 如果存在失败的测试用例,Pipeline 会被标记为 “UNSTABLE”,在网页上用黄色表示, 这不同于使用红色表示的 “FAILED” 失败状态。

当出现测试失败时,通常可以从 Jenkins 中获取构建结果报告进行本地分析和测试。 Jenkins 内置支持存储构建结果报告,在 Pipeline 执行期间生成记录文件。

通过 archiveArtifacts 步骤和文件匹配表达式可以很容易的完成构建结果记录和存储, 如下例所示:

Jenkinsfile (Declarative Pipeline)

pipeline {

agent any

stages {

stage('Build') {

steps {

sh './gradlew build'

}

}

stage('Test') {

steps {

sh './gradlew check'

}

}

}

post {

always {

archiveArtifacts artifacts: 'build/libs/**/*.jar', fingerprint: true

junit 'build/reports/**/*.xml'

}

}

}

Toggle Scripted Pipeline (Advanced)

如果在 archiveArtifacts 步骤中指定了多个参数, 那么每个参数的名称必须在步骤代码中明确指定, 即文件的路径、文件名和 fingerprint 三个参数。 如果您只需指定文件的路径和文件名, 那么你可以省略参数名称 artifacts ,例如: archiveArtifacts 'build/libs/**/*.jar'

在 Jenkins 中记录测试和构建结果非常有助于向团队成员快速提供相关信息。 在下一节,我们将会展示如何通知团队成员在我们的 Pipeline 中所发生的事情。

清理和通知

因为 post 部分保证在 Pipeline 结束的时候运行, 所以我们可以添加通知或者其他的步骤去完成清理、通知或者其他的 Pipeline 结束任务。

Jenkinsfile (Declarative Pipeline)

pipeline {

agent any

stages {

stage('No-op') {

steps {

sh 'ls'

}

}

}

post {

always {

echo 'One way or another, I have finished'

deleteDir() /* clean up our workspace */

}

success {

echo 'I succeeeded!'

}

unstable {

echo 'I am unstable :/'

}

failure {

echo 'I failed :('

}

changed {

echo 'Things were different before...'

}

}

}

Toggle Scripted Pipeline (Advanced)

有很多方法可以发送通知, 下面是一些示例展示了如何通过电子邮件、Hipchat room 或者 Slack channel 发送 Pipeline 的相关信息。

电子邮件

post {

failure {

mail to: 'team@example.com',

subject: "Failed Pipeline: ${currentBuild.fullDisplayName}",

body: "Something is wrong with ${env.BUILD_URL}"

}

}

Hipchat

post {

failure {

hipchatSend message: "Attention @here ${env.JOB_NAME} #${env.BUILD_NUMBER} has failed.",

color: 'RED'

}

}

Slack

post {

success {

slackSend channel: '#ops-room',

color: 'good',

message: "The pipeline ${currentBuild.fullDisplayName} completed successfully."

}

}

当 Pipeline 失败、不稳定甚至是成功时,团队都会收到通知, 现在我们可以继续完成我们的持续交付 Pipeline 激动人心的部分:部署!

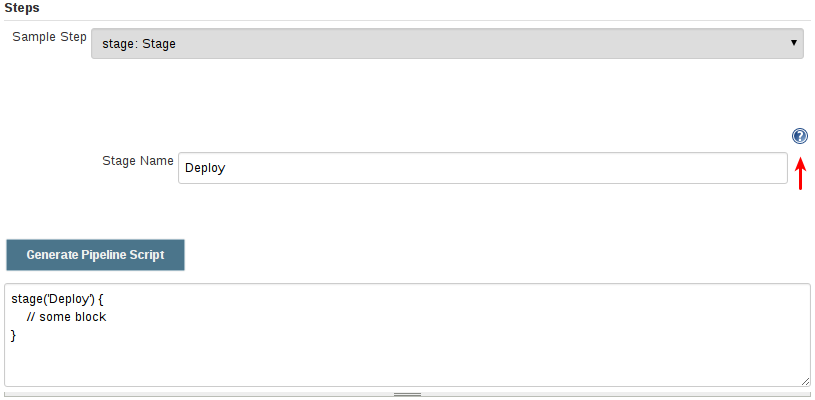

部署

Table of Contents

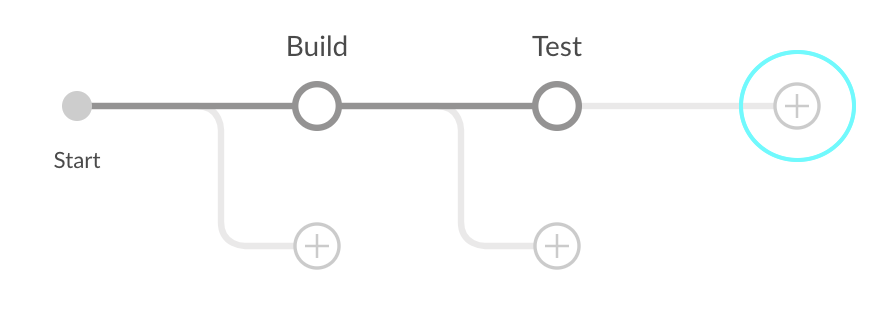

大多数最基本的持续交付 Pipeline 至少会有三个阶段:构建、测试和部署,这些阶段被定义在 Jenkinsfile 中。 这一小节我们将主要关注部署阶段,但应该指出稳定的构建和测试阶段是任何部署活动的重要前提。

Jenkinsfile (Declarative Pipeline)

pipeline {

agent any

stages {

stage('Build') {

steps {

echo 'Building'

}

}

stage('Test') {

steps {

echo 'Testing'

}

}

stage('Deploy') {

steps {

echo 'Deploying'

}

}

}

}

Toggle Scripted Pipeline (Advanced)

阶段即为部署环境

一个常见的模式是扩展阶段的数量以获取额外的部署环境信息, 如 “staging” 或者 “production”,如下例所示。

stage('Deploy - Staging') {

steps {

sh './deploy staging'

sh './run-smoke-tests'

}

}

stage('Deploy - Production') {

steps {

sh './deploy production'

}

}

在这个示例中,我们假定 ./run-smoke-tests 脚本所运行的冒烟测试足以保证或者验证可以发布到生产环境。 这种可以自动部署代码一直到生产环境的 Pipeline 可以认为是“持续部署”的一种实现。 虽然这是一个伟大的想法,但是有很多理由表明“持续部署”不是一种很好的实践, 即便如此,这种方式仍然可以享有“持续交付”带来的好处。 [1] Jenkins Pipeline可以很容易支持两者。

人工确认

通常在阶段之间,特别是不同环境阶段之间,您可能需要人工确认是否可以继续运行。 例如,判断应用程序是否在一个足够好的状态可以进入到生产环境阶段。 这可以使用 input 步骤完成。 在下面的例子中,“Sanity check” 阶段会等待人工确认,并且在没有人工确认的情况下不会继续执行。

Jenkinsfile (Declarative Pipeline)

pipeline {

agent any

stages {

/* "Build" and "Test" stages omitted */

stage('Deploy - Staging') {

steps {

sh './deploy staging'

sh './run-smoke-tests'

}

}

stage('Sanity check') {

steps {

input "Does the staging environment look ok?"

}

}

stage('Deploy - Production') {

steps {

sh './deploy production'

}

}

}

}

Toggle Scripted Pipeline (Advanced)

结论

本导读向您介绍了 Jenkins 和 Jenkins Pipeline 的基本使用。 由于 Jenkins 是非常容易扩展的,它可以被修改和配置去处理任何类型的自动化。 关于 Jenkins 可以做什么的更多相关信息,可以参考 用户手册, Jenkins 最新事件、教程和更新可以访问 Jenkins 博客

1. en.wikipedia.org/wiki/Continuous_delivery

本网站的内容基于 Creative Commons Attribution-ShareAlike 4.0 License 许可.

资源

解决方案

教程概览

Jenkins 用户文档的这一部分包含一系列的入门教程帮你使用 Jenkins 以自动化的方式开始构建你的应用程序。

如果你是一个想要提高对持续集成(CI) / 持续交付 (CD) 概念的理解的开发者, 或者你已经对这些概念很熟悉 但不知道如何使用Jenkins去实现, 那就从这些教程开始学习吧。

入门教程

本教程展示如何使用 Jenkins 涉及到基于特定的技术栈的CI/CD 概念的基础。

选择与你的技术栈有关或你最熟悉的一个教程:

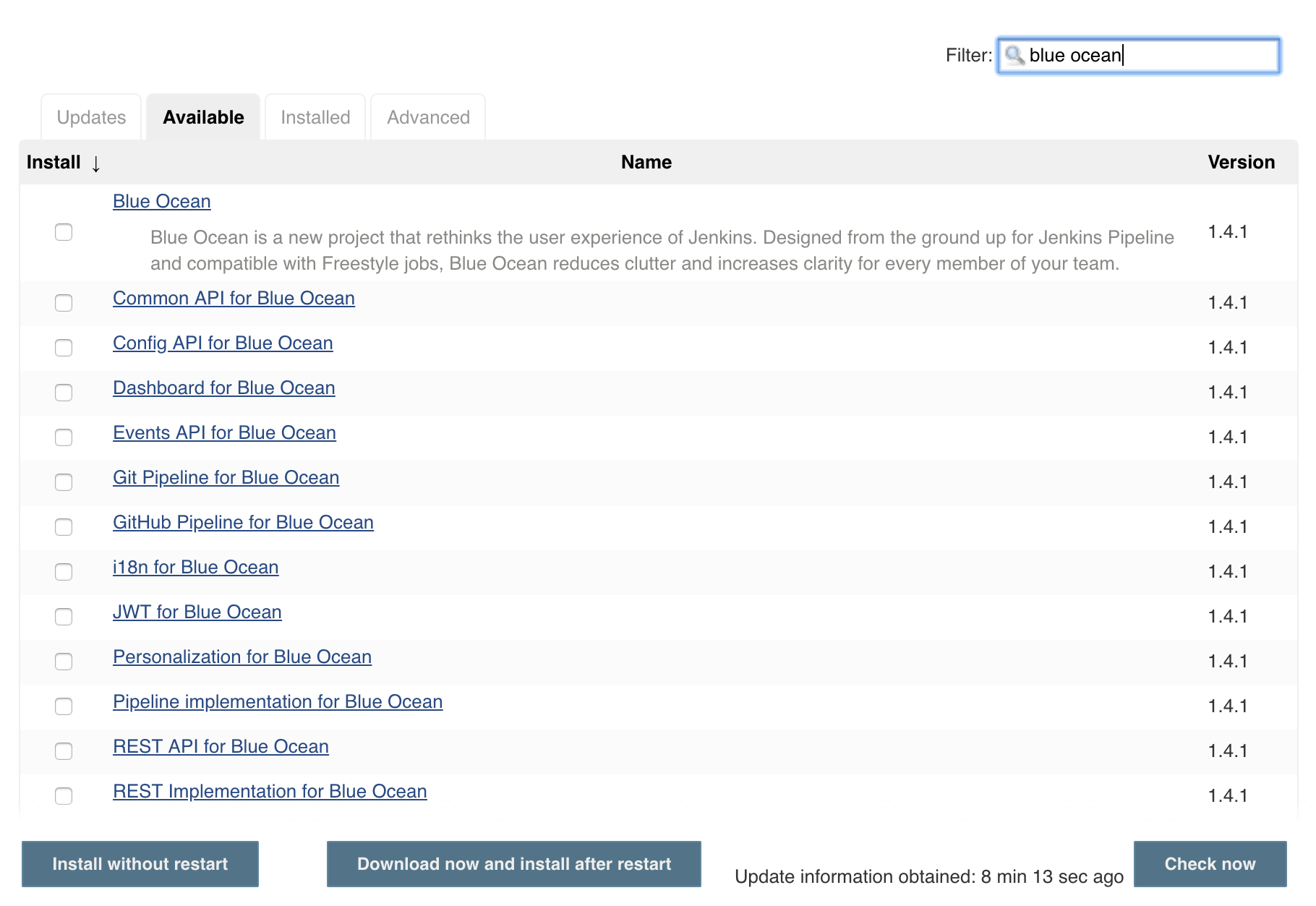

本教程展示 如何使用 Jenkins 的关键特性 (比如 Blue Ocean) 帮助实现 CI/CD 进程来构建你的应用:

高级教程

该教程展示 Jenkins 更高级的特性和如何管理你的更复杂更灵活的流水线项目。

-

使用Maven构建Java应用程序

Table of Contents

-

在 Docker中运行Jenkins

本教程将向你展示如何使用Jenkins编排并构建一个使用Maven管理的简单Java应用程序。

如果你是使用Maven的Java开发人员,并且对CI/CD概念不熟悉,或者你可能熟悉这些概念,但不知道如何使用Jenkins实现构建应用程序,那么本教程适合你。

你将在Github示例仓库中获取一个输出"Hello world!"字符串的简单Java应用,该应用还包含若干单元测试,用于检查main方法。 测试结果保存在JUnit XML报告中。

耗时: 假如你的机器符合配置要求,完成本教程需要20-40分钟。准确的耗时取决于你机器的性能, 以及你是否完成过在Docker中运行Jenkins教程,请参考另一个教程.

你可以在任何时候停止本教程,并从你离开的地方继续。

若你已经完成了另一个教程,可以跳过配置要求和在Docker中运行Jenkins章节, 继续阅读fork示例仓库(确保你本地安装了Git)。 如果你需要重启Jenkins,请参考停止和重启Jenkins.

配置要求

对于本教程,您将需要:

-

安装有macOS,Linux或Windows操作系统的机器,并拥有以下配置:

-

最小256MB内存, 推荐512MB以上。

-

10GB硬盘空间, 用于安装Jenkins,您的Docker镜像和容器。

-

-

安装有以下软件:

在 Docker中运行Jenkins

在本教程中, 将Jenkins作为 Docker 容器并从

jenkinsci/blueoceanDocker 镜像中运行。要在 Docker中运行Jenkins, 请遵循下面的macOS 和 Linux 或 Windows相关文档说明进行操作。 .

你可以在 Docker和 Installing Jenkins 页面的 Downloading and running Jenkins in Docker部分阅读更多有关Docker容器和镜像概念的信息。

在 macOS 和 Linux 系统上

-

打开终端窗口

-

使用下面的

docker run命令运行jenkinsci/blueocean镜像作为Docker中的一个容器(记住,如果本地没有镜像,这个命令会自动下载):docker run \ --rm \ -u root \ -p 8080:8080 \ -v jenkins-data:/var/jenkins_home \ -v /var/run/docker.sock:/var/run/docker.sock \ -v "$HOME":/home \ jenkinsci/blueocean

将容器中的 /var/jenkins_home目录映射到 Docker volume ,并将其命名为jenkins-data。如果该卷不存在, 那么docker run命令会自动为你创建卷。将主机上的 $HOME目录 (即你的本地)映射到 (通常是/Users/目录) 到容器的/home目录。Note: 如果复制或粘贴上面的命令片段不起作用, 尝试复制和粘贴这个没有注释的版本:

docker run \ --rm \ -u root \ -p 8080:8080 \ -v jenkins-data:/var/jenkins_home \ -v /var/run/docker.sock:/var/run/docker.sock \ -v "$HOME":/home \ jenkinsci/blueocean

-

继续 安装向导。

在 Windows 系统

-

打开命令提示窗口。

-

使用下面的

docker run命令运行jenkinsci/blueocean镜像作为Docker中的一个容器(记住,如果本地没有镜像,这个命令会自动下载):docker run ^ --rm ^ -u root ^ -p 8080:8080 ^ -v jenkins-data:/var/jenkins_home ^ -v /var/run/docker.sock:/var/run/docker.sock ^ -v "%HOMEPATH%":/home ^ jenkinsci/blueocean

对这些选项的解释, 请参考上面的 macOS 和 Linux 说明。

-

继续安装向导。

访问 Jenkins/Blue Ocean Docker 容器

如果你有一些使用 Docker 的经验,希望或需要使用

docker exec命令通过一个终端/命令提示符来访问 Jenkins/Blue Ocean Docker 容器, 你可以添加如--name jenkins-tutorials选项(与上面的docker run), 这将会给Jenkins/Blue Ocean Docker容器一个名字 "jenkins-tutorials"。这意味着你可以通过

docker exec命令访问Jenkins/Blue Ocean 容器(通过一个单独的终端 /命令提示窗口) ,例如:docker exec -it jenkins-tutorials bash

安装向导

在你访问 Jenkins之前, 你需要执行一些快速的 "一次性" 步骤。

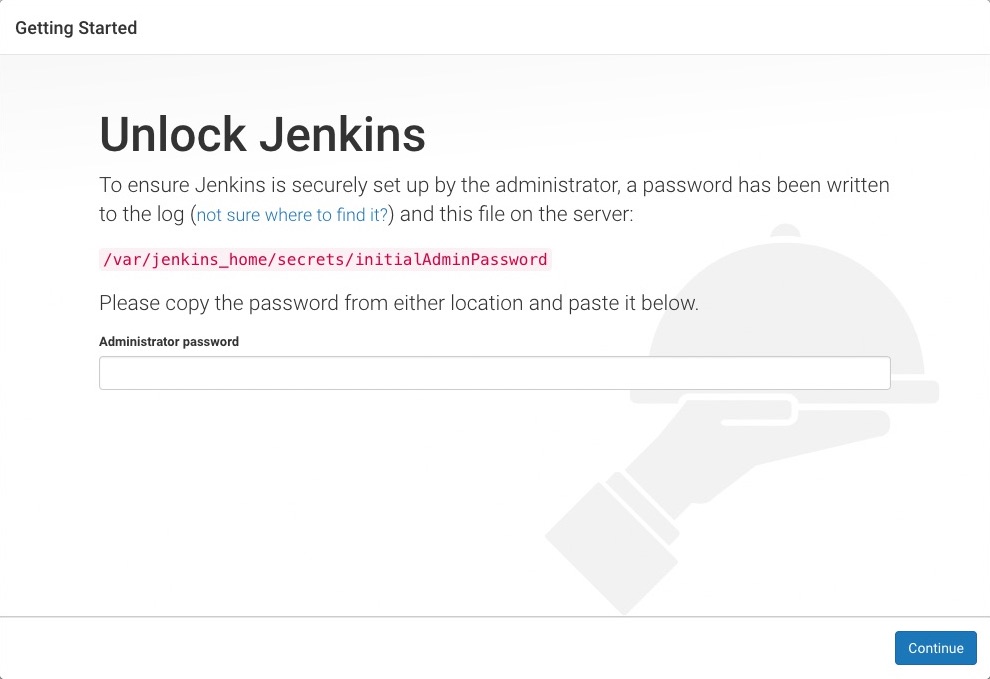

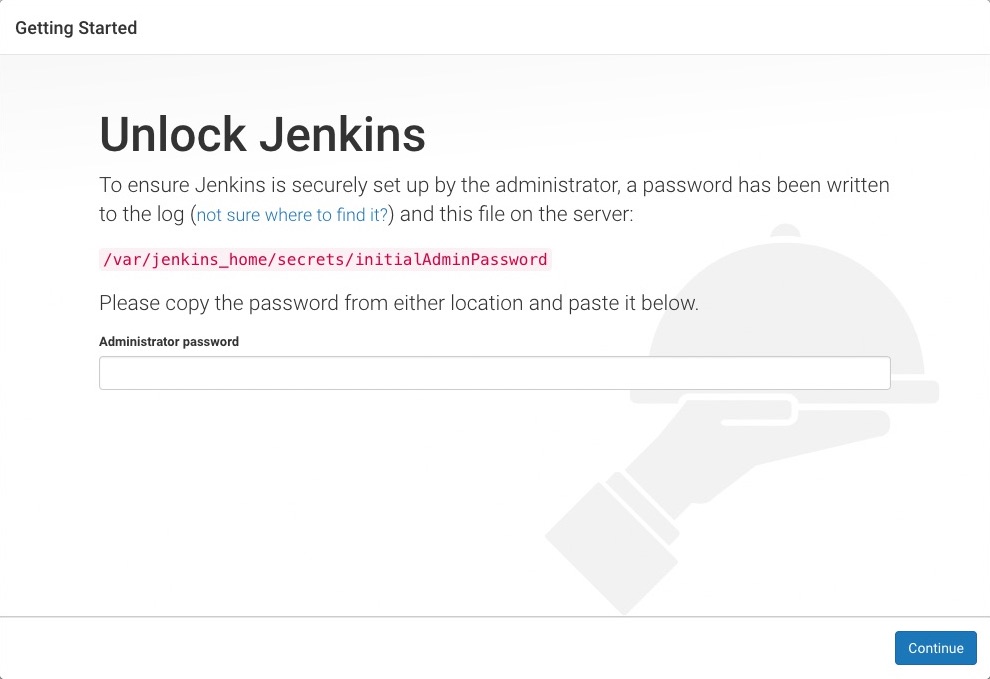

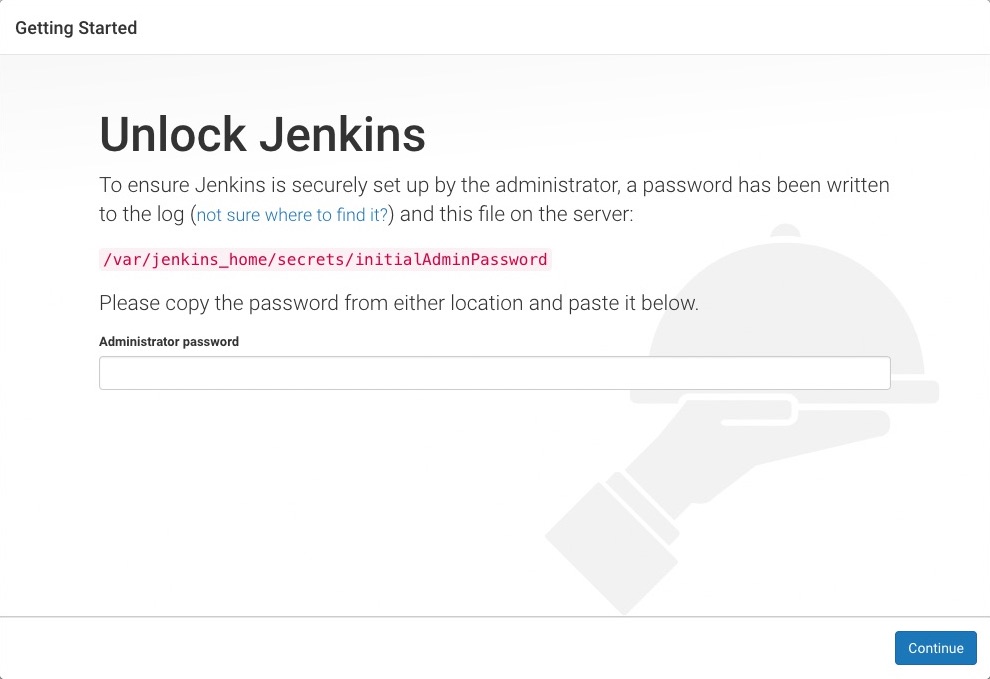

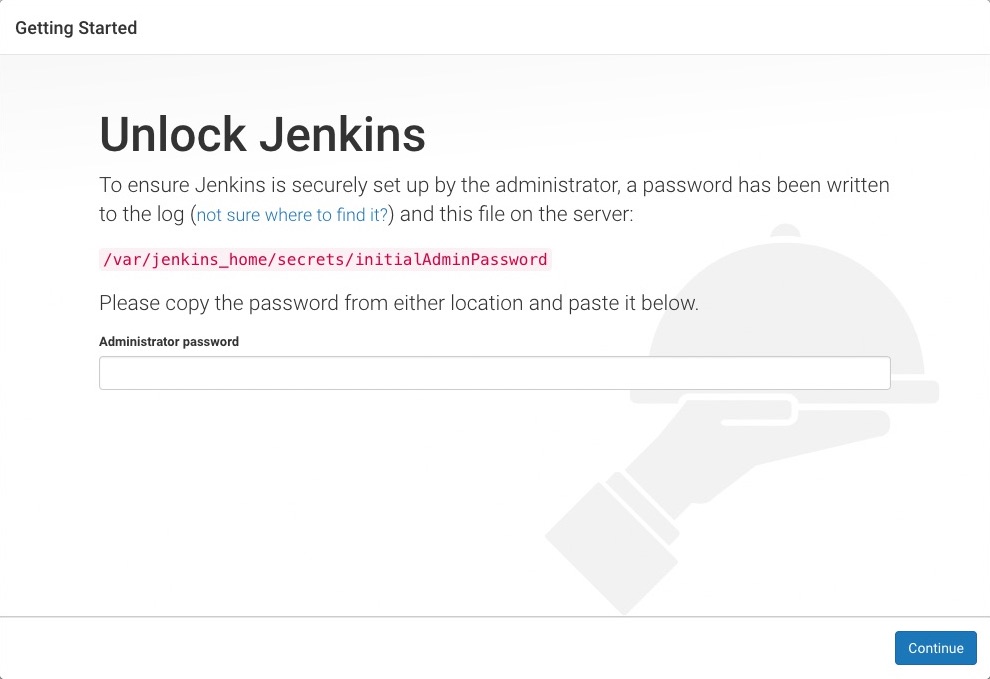

解锁 Jenkins

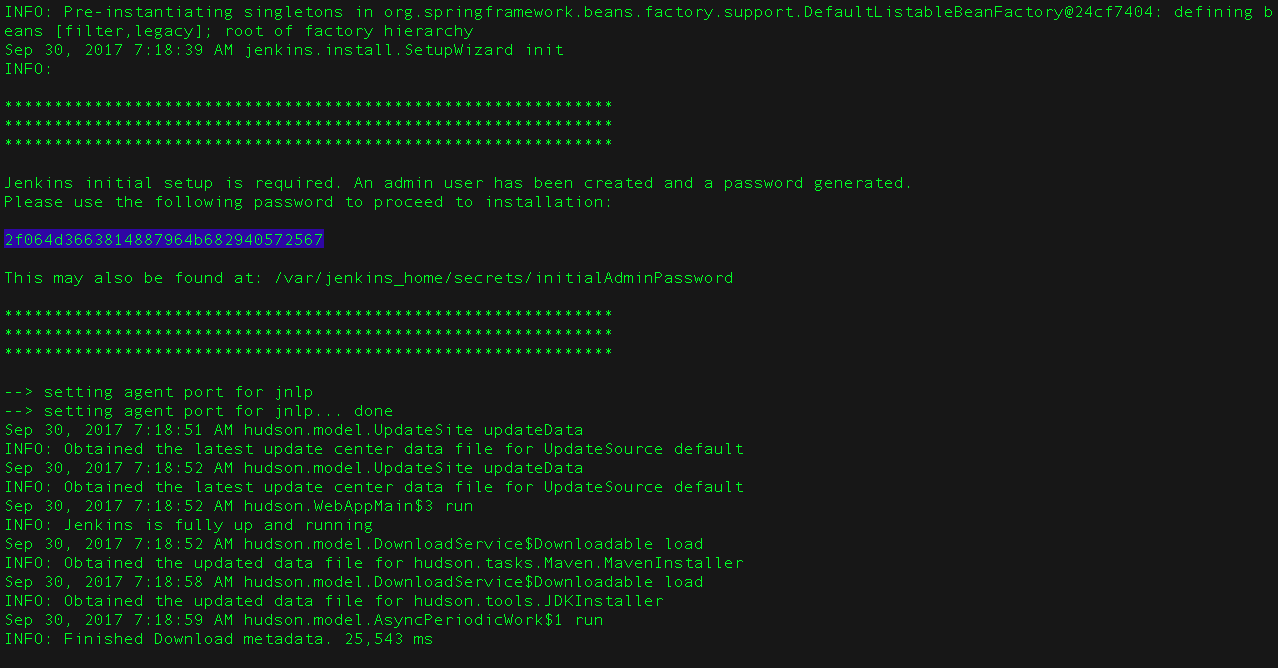

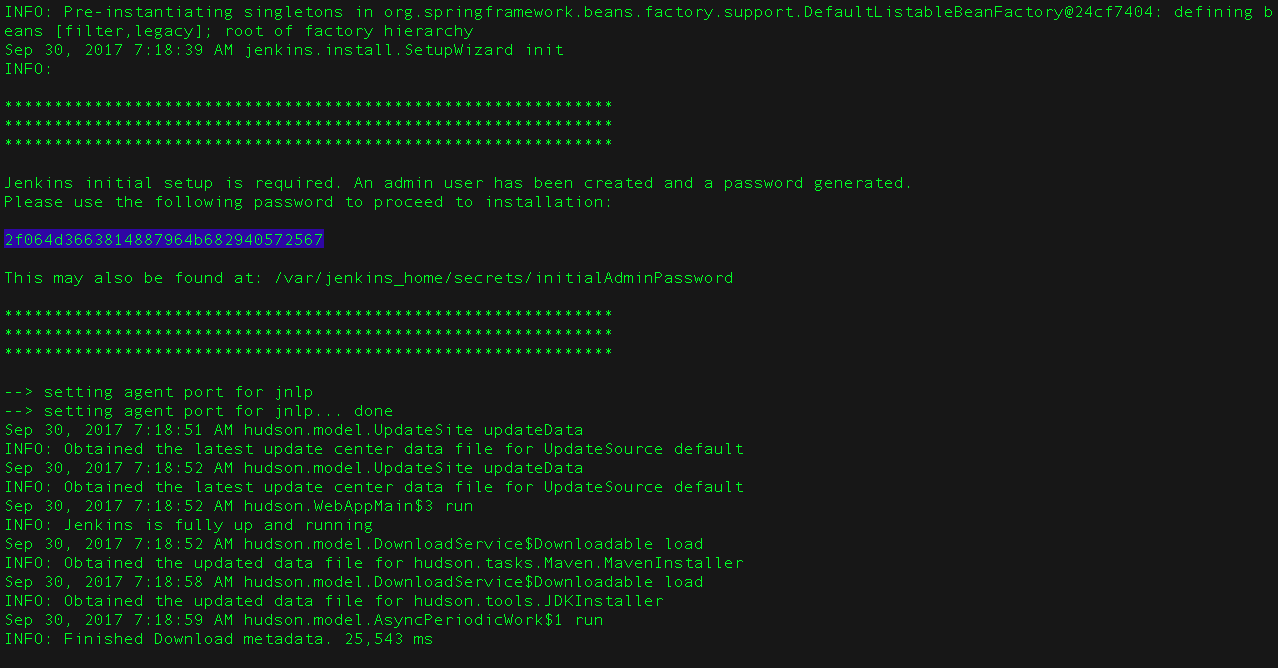

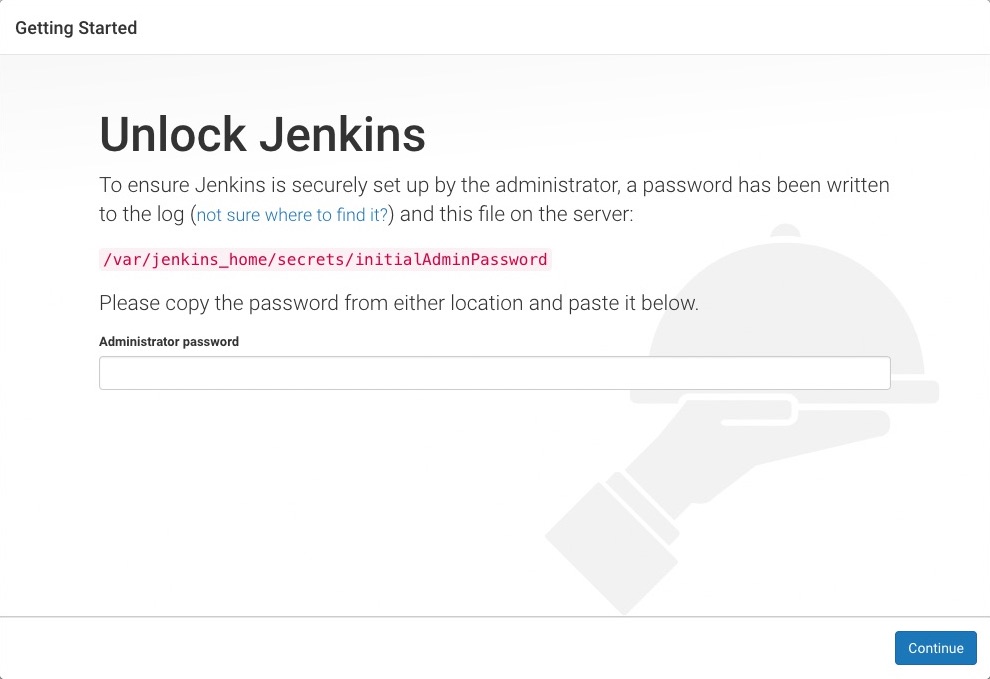

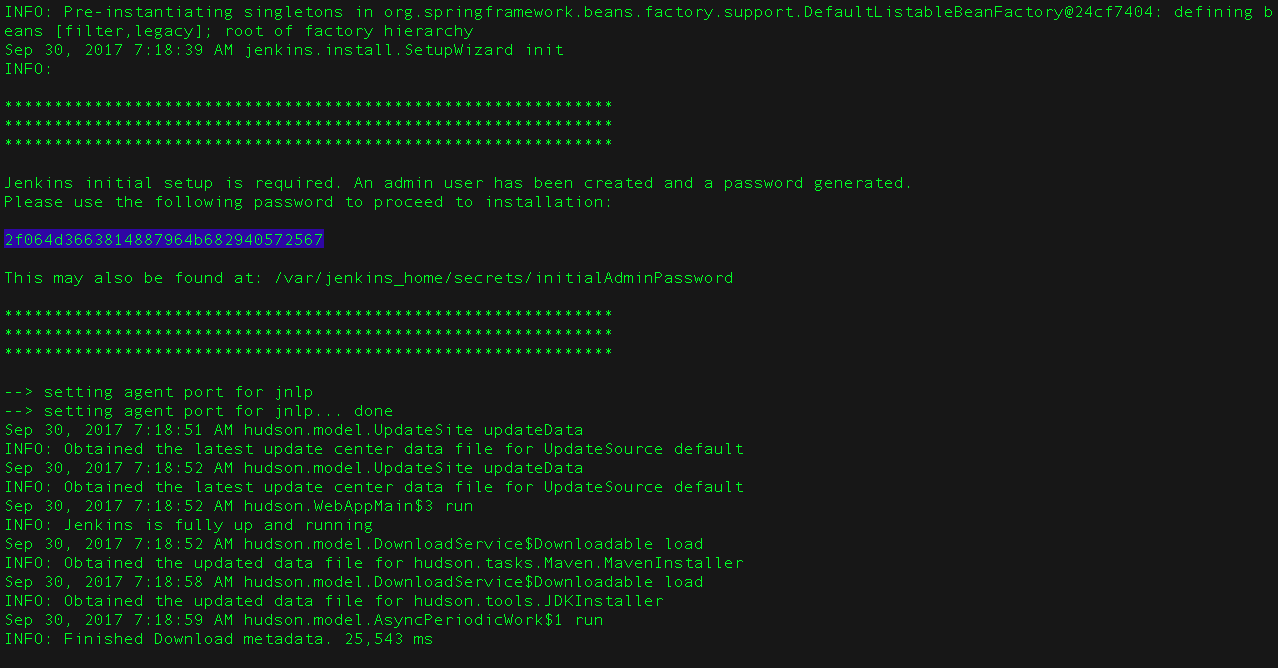

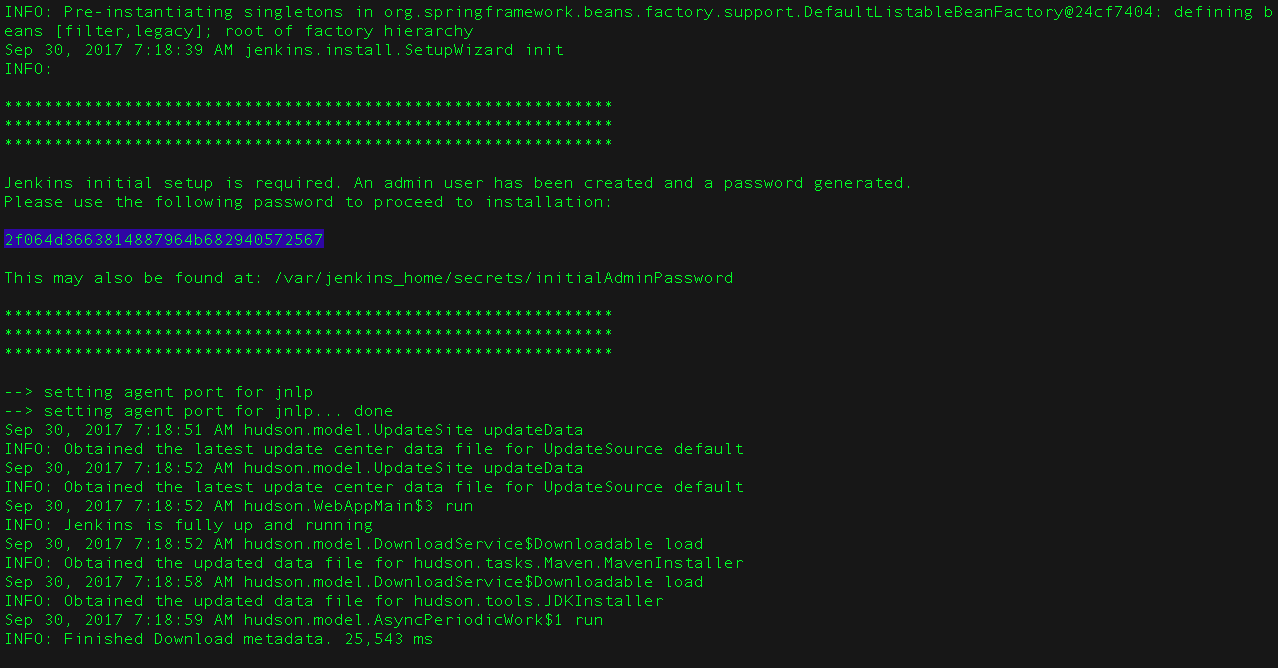

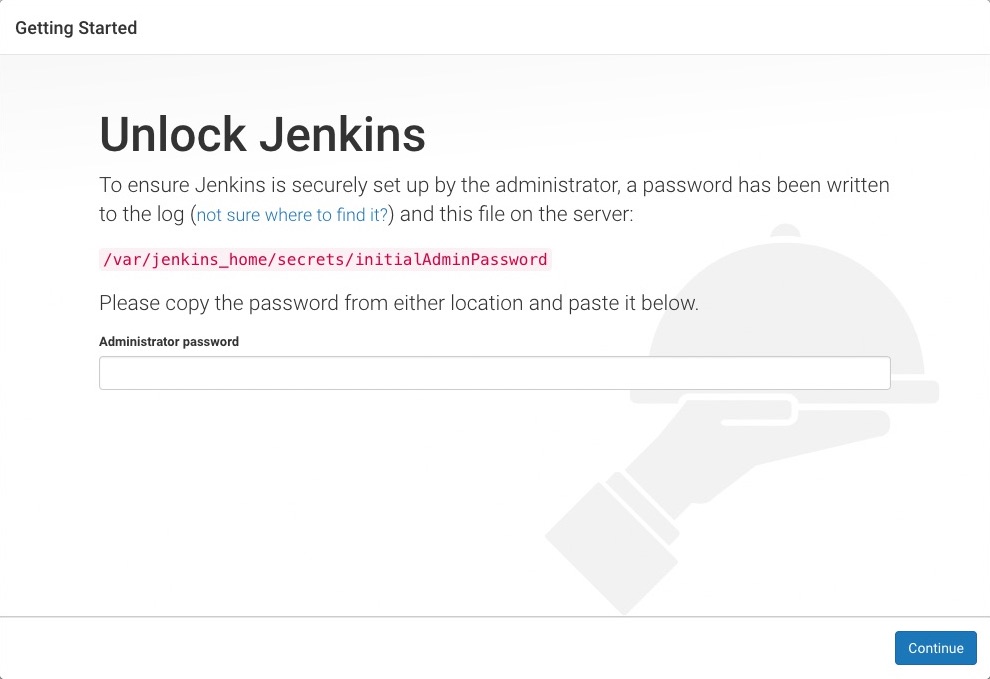

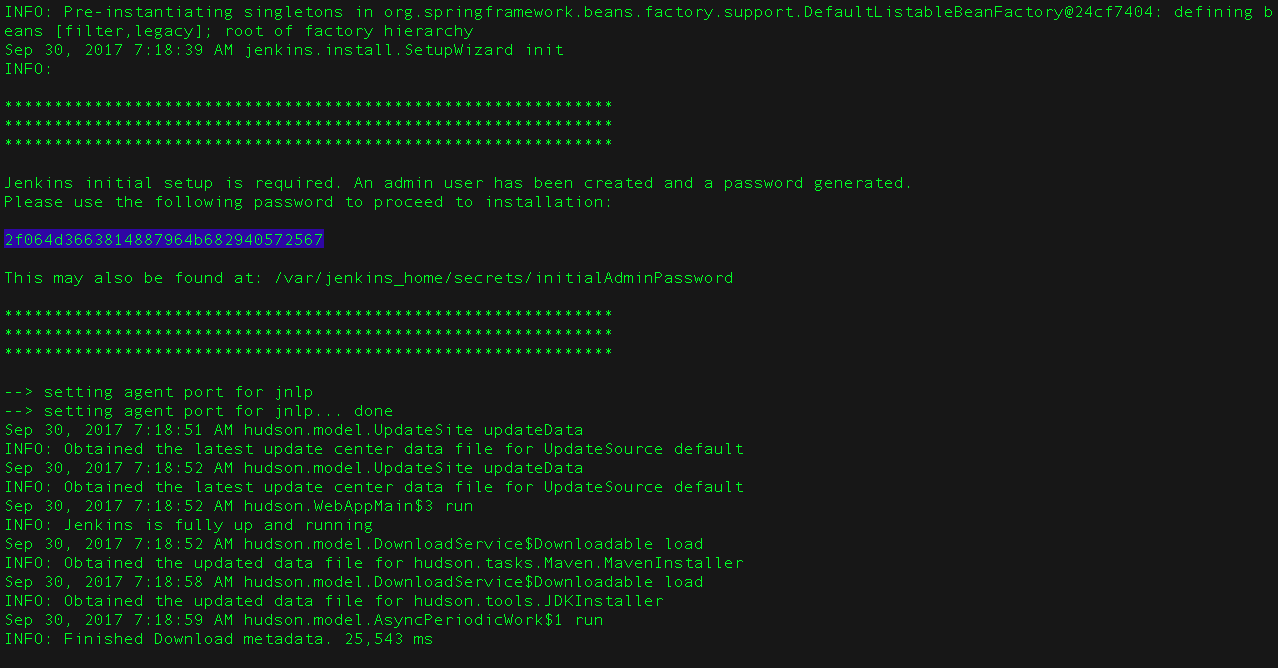

当你第一次访问一个新的 Jenkins 实例时, 要求你使用自动生成的密码对其进行解锁。

-

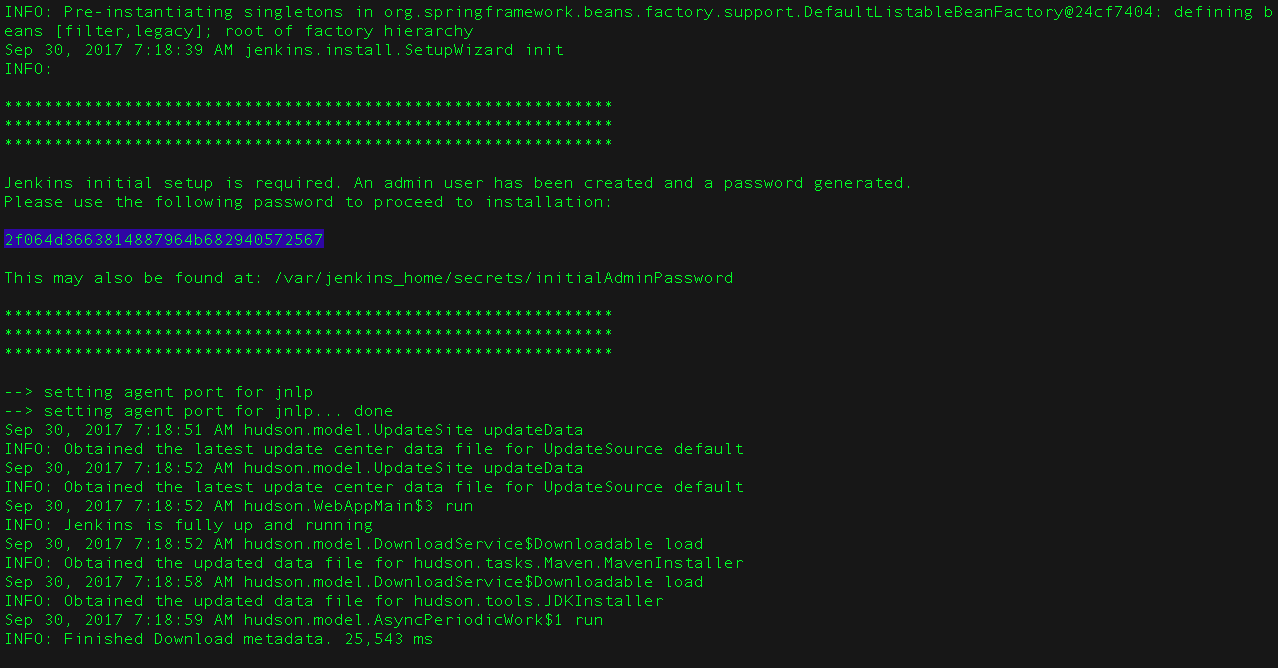

当在终端/命令提示窗口出现两组星号时, 浏览

http://localhost:8080并等待 Unlock Jenkins 页面出现。

-

再次从终端/命令提示窗口, 复制自动生成的字母数字密码(在两组星号之间)。

-

在 Unlock Jenkins 页面, 粘贴该密码到 Administrator password 字段并点击 Continue。

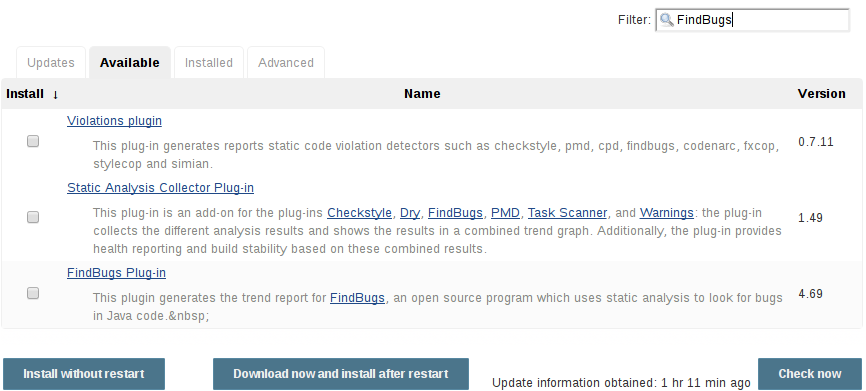

使用插件自定义 Jenkins

在 解锁 Jenkins后, Customize Jenkins 页面出现。

在该页面,点击 Install suggested plugins。

安装向导显示了正在配置的Jenkins的进程,以及建议安装的插件。这个过程肯需要几分钟。

创建第一个管理员用户

最后, Jenkins 要求创建你的第一个管理员用户。

-

当 Create First Admin User 页面出现, 在相应的字段中指定你的详细消息并点击 Save and Finish。

-

当 Jenkins is ready 页面出现, 点击 Start using Jenkins。 Notes:

-

该页面可能表明 Jenkins is almost ready! 如果相反, 点击 Restart.

-

如果该页面在一分钟后没有自动刷新, 使用你的web浏览器手动刷新。

-

-

如果需要,登录 Jenkins , 你就可以开始使用 Jenkins了!

停止和重启 Jenkins

在本教程的其余部分, 你可以通过在终端/命令提示窗口输入

Ctrl-C停止 Jenkins/Blue Ocean Docker 容器,你可以从中运行<>的docker run ...命令。要重启Jenkins/Blue Ocean Docker 容器:

-

在上面的 macOS,Linux 或 Windows上运行相同的

docker run ...命令 。 Note: 如果有更新的话,该进程会更新jenkinsci/blueoceanDocker 镜像。 -

浏览

http://localhost:8080。 -

等待直到登录页面出现并登陆。

Fork 和 clone GitHub示例仓库

通过将应用程序源代码所在的示例仓库fork到你自己的Github账号中, 并clone到本地,你就可以获取一个"Hello world!"简单Java应用程序。

-

请确保你登陆了你的GitHub账户。如果你还没有Github账户,你可以在 GitHub网站 免费注册一个账户。

-

将示例仓库

simple-java-maven-appfork到你的账户的Github仓库中。在此过程中,如果你需要帮助,请参考 Fork A Repo 文档。 -

将你的GitHub账户中的

simple-java-maven-app仓库clone到你的本地机器。 根据你的情况完成以下步骤之一(其中 `` 是你的操作系统用户账户名称):-

如果你的机器安装了Github Desktop:

-

在GitHub网站上,点击绿色的 Clone or download 按钮,再点击 Open in Desktop.

-

在Github桌面版中,在点击 Clone a Repository 对话框上的 Clone 按钮之前,确保 Local Path 的配置为:

-

macOS 系统配置为

/Users//Documents/GitHub/simple-java-maven-app -

Linux 系统配置为

/home//GitHub/simple-java-maven-app -

Windows 系统配置为

C:\Users\\Documents\GitHub\simple-java-maven-app

-

-

-

其他情况:

-

打开一个终端/命令提示符,并且

cd进入正确的目录路径:-

macOS 系统路径为

/Users//Documents/GitHub/ -

Linux 系统路径为

/home//GitHub/ -

Windows 系统路径为

C:\Users\\Documents\GitHub\(推荐使用Git bash命令行,而不是通常的Microsoft命令提示符)

-

-

运行以下命令完成仓库的clone:

git clone https://github.com/YOUR-GITHUB-ACCOUNT-NAME/simple-java-maven-app其中YOUR-GITHUB-ACCOUNT-NAME是你的Github账户的名称。

-

-

在Jenkins中创建你的流水线项目

-

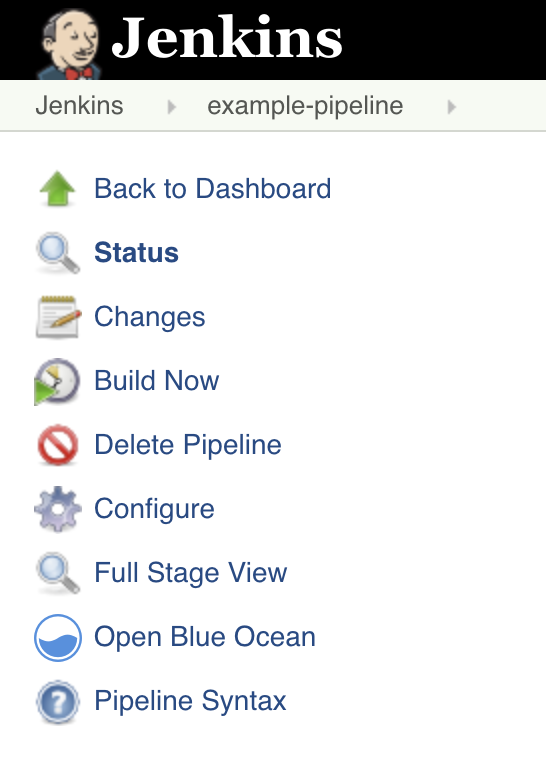

回到Jenkins,如果有必要的话重新登录,点击 Welcome to Jenkins! 下方的 create new jobs 注意: 如果你无法看见以上内容,点击左上方的 New Item 。

-

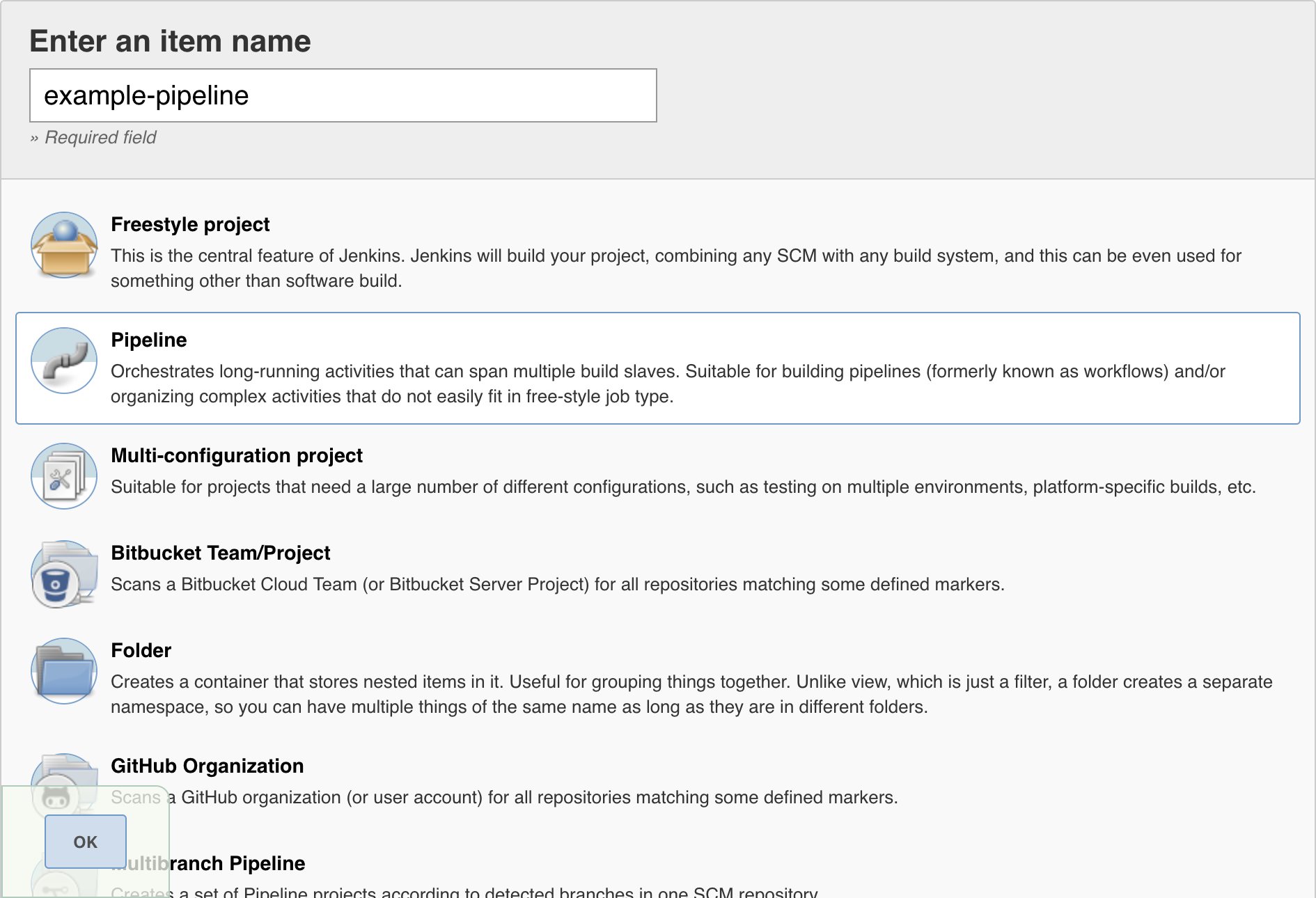

在 Enter an item name 域中,为新的流水线项目指定名称(例如

simple-java-maven-app)。 -

向下滚动并单击 Pipeline,然后单击页面末尾的 OK 。

-

( 可选 ) 在下一页中,在 Description 字段中填写流水线的简要描述 (例如

一个演示如何使用Jenkins构建Maven管理的简单Java应用程序的入门级流水线。) -

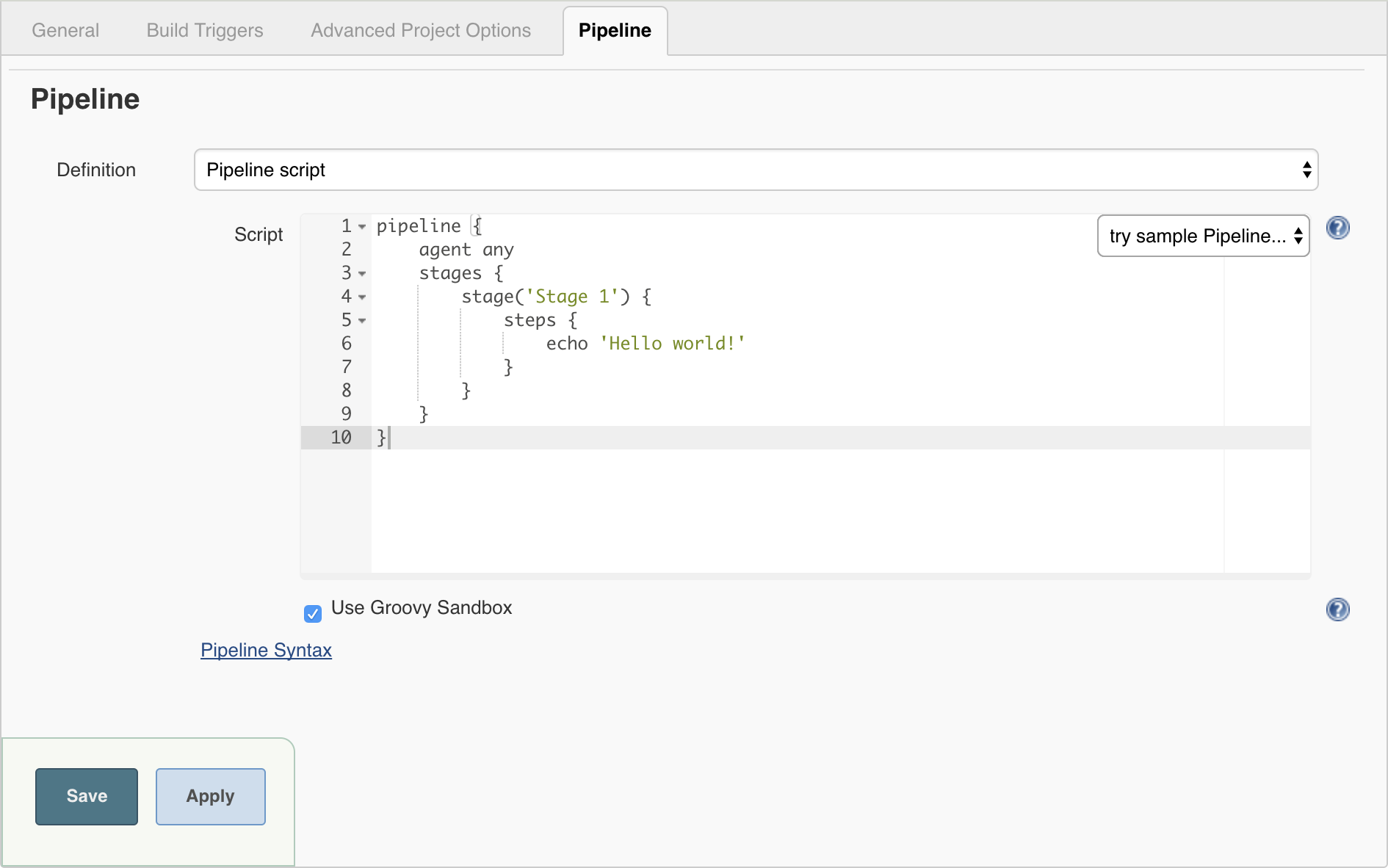

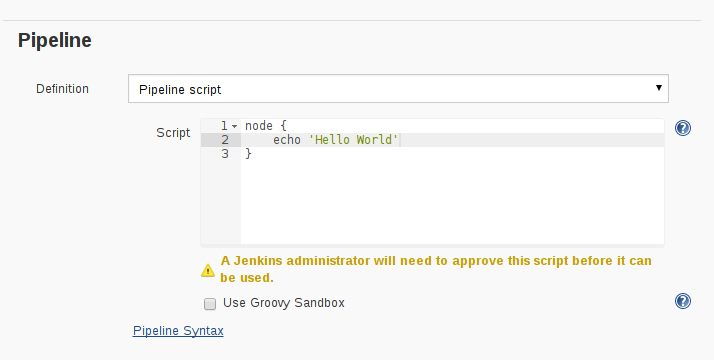

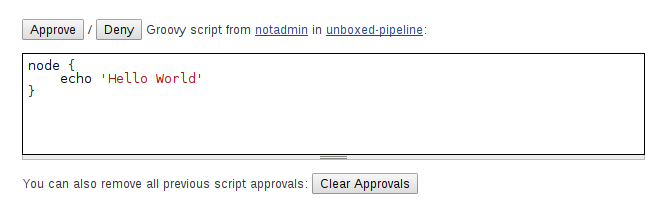

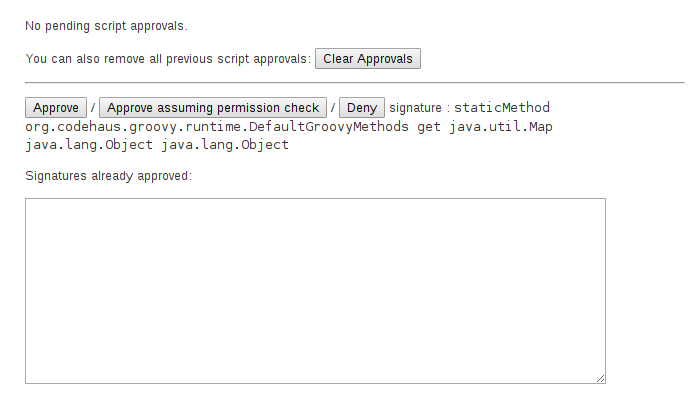

点击页面顶部的 Pipeline 选项卡,向下滚动到 Pipeline 部分。

-

在 Definition 域中,选择 Pipeline script from SCM 选项。此选项指示Jenkins从源代码管理(SCM)仓库获取你的流水线, 这里的仓库就是你clone到本地的Git仓库。

-

在 SCM 域中,选择 Git。

-

在 Repository URL 域中,填写你本地仓库的 目录路径, 这是从你主机上的用户账户home目录映射到Jenkins容器的

/home目录:-

MacOS系统 -

/home/Documents/GitHub/simple-java-maven-app -

Linux系统 -

/home/GitHub/simple-java-maven-app -

Windows系统 -

/home/Documents/GitHub/simple-java-maven-app

-

-

点击 Save 保存你的流水线项目。你现在可以开始创建你的

Jenkinsfile,这些文件会被添加到你的本地仓库。

将你的初始流水线创建为Jenkinsfile

现在你已准备好创建你的流水线,它将使用Jenkins中的Maven自动构建你的Java应用程序。 你的流水线将被创建为

Jenkinsfile,它将被提交到你本地的Git仓库(simple-java-maven-app)。这是 "Pipeline-as-Code" 的基础,它将持续交付流水线作为应用程序的一部分,与其他代码一样进行版本控制和审查。 阅读更多关于 流水线 的信息,以及用户手册中的 使用Jenkinsfile 章节。

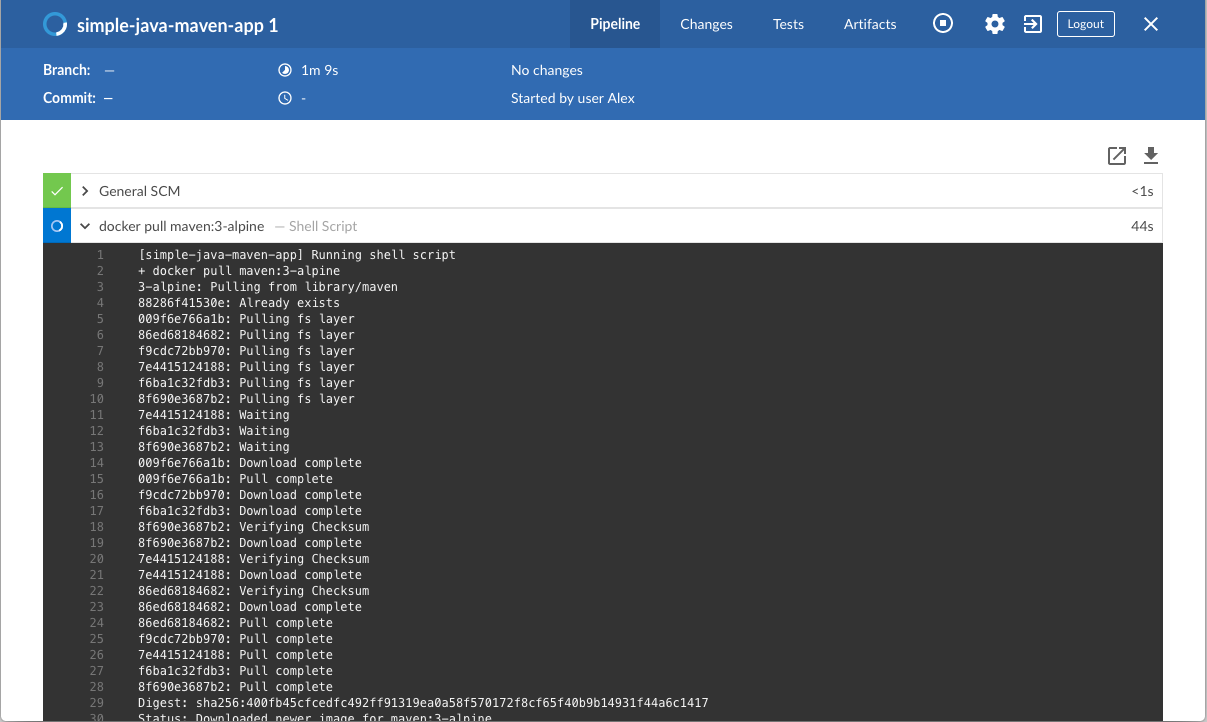

首先,创建一个初始流水线来下载Maven Docker镜像,并将其作为Docker容器运行(这将构建你的简单Java应用)。 同时添加一个“构建”阶段到流水线中,用于协调整个过程。

-

使用你最称手的文本编辑器或者IDE,在你本地的

simple-java-maven-appGit仓库的根目录创建并保存一个名为Jenkinsfile的文本文件。 -

复制以下声明式流水线代码并粘贴到

Jenkinsfile文件中:pipeline { agent { docker { image 'maven:3-alpine' args '-v /root/.m2:/root/.m2' } } stages { stage('Build') { steps { sh 'mvn -B -DskipTests clean package' } } } }这里的 image参数(参考agent章节的docker参数) 是用来下载maven:3-aplineDocker镜像 (如果你的机器还没下载过它)并将该镜像作为单独的容器运行。这意味着:你将在Docker中本地运行相互独立的Jenkins和Maven容器。Maven容器成为了Jenkins用来运行你的流水线项目的 agent。 这个容器寿命很短——它的寿命只是你的流水线的执行时间。这里的 args参数在暂时部署的Maven Docker容器的/root/.m2(即Maven仓库)目录 和Docker主机文件系统的对应目录之间创建了一个相互映射。这背后的实现细节超出了本教程的范围,在此不做解释。 但是,这样做的主要原因是,在Maven容器的生命周期结束后,构建Java应用程序所需的工件 (Maven在流水线执行时进行下载)能够保留在Maven存储库中。这避免了在后续的流水线执行过程中, Maven反复下载相同的工件。请注意,不同于你为jenkins-data创建的Docker数据卷,Docker主机的文件系统在每次重启Docker时都会被清除。 这意味着每次Docker重新启动时,都会丢失下载的Maven仓库工件。定义了一个名为 Build的stage,之后会出现在Jenkins UI上。这里的 shstep(参考steps章节)运行Maven命令干净地构建你的Java应用(不运行任何tests)。 -

保存对

Jenkinsfile的修改并且将其提交到你本地的simple-java-maven-appGit仓库。例如,在simple-java-maven-app目录下,运行以下命令:git add .继续运行git commit -m "Add initial Jenkinsfile" -

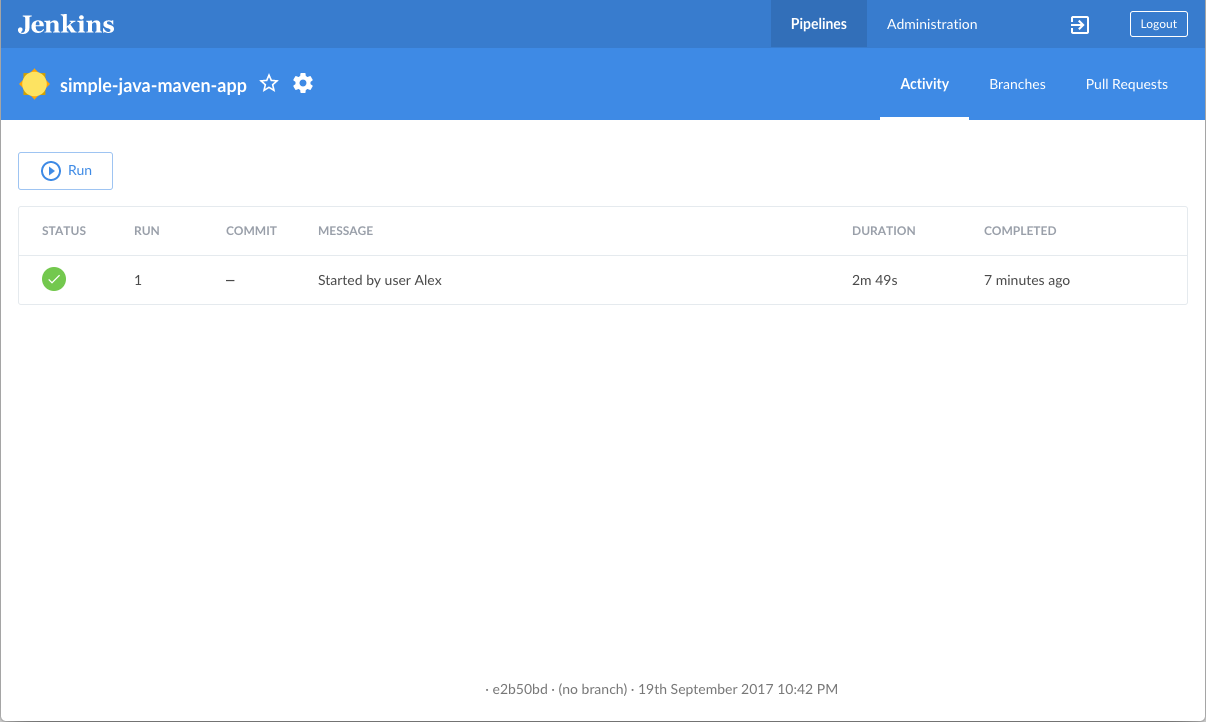

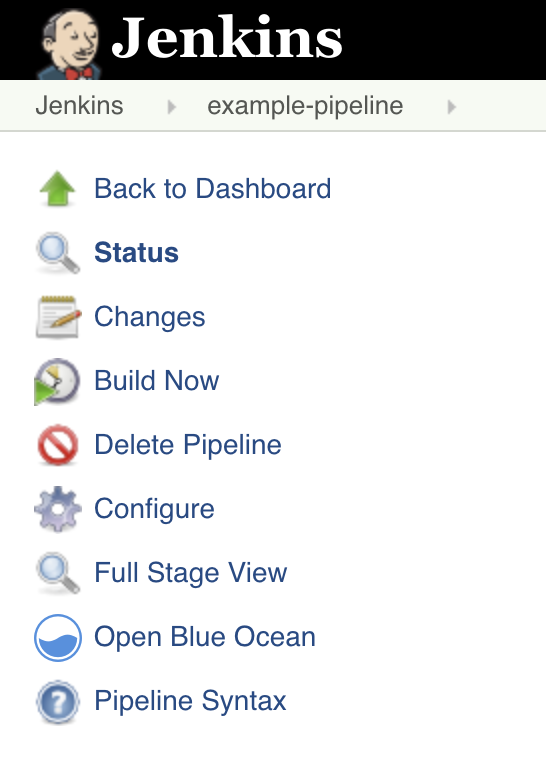

再次回到Jenkins,如果有必要的话重新登录,点击左侧的 Open Blue Ocean 进入Jenkins的Blue Ocean界面。

-

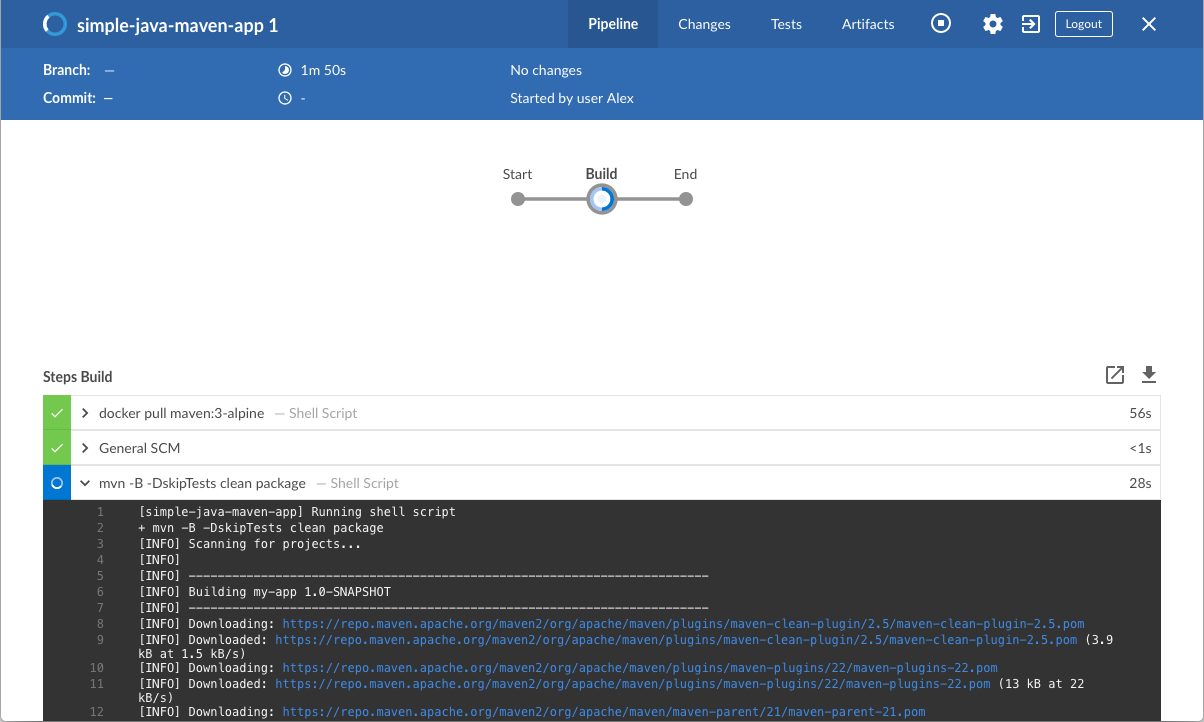

在 This job has not been run 消息框中,点击 Run,然后快速点击右下角出现的 OPEN 链接, 观察Jenkins运行你的流水线项目。如果你不能点击 OPEN 链接,点击Blue Ocean主界面的一行来使用这一特性。 注意: 你可能需要几分钟时间等待第一次运行完成。在clone了你的本地

simple-java-maven-appGit仓库后, Jenkins接下来做了以下动作:-

将项目排入队列等待在agent上运行。

-

下载Maven Docker镜像,并且将其运行在Docker中的一个容器中。

-

在Maven容器中运行

Build阶段 (Jenkinsfile中所定义的)。在这期间,Maven会下载构建你的Java应用所需的工件, 这些工件最终会被保存在Jenkins的本地Maven仓库中(Docker的主机文件系统)。

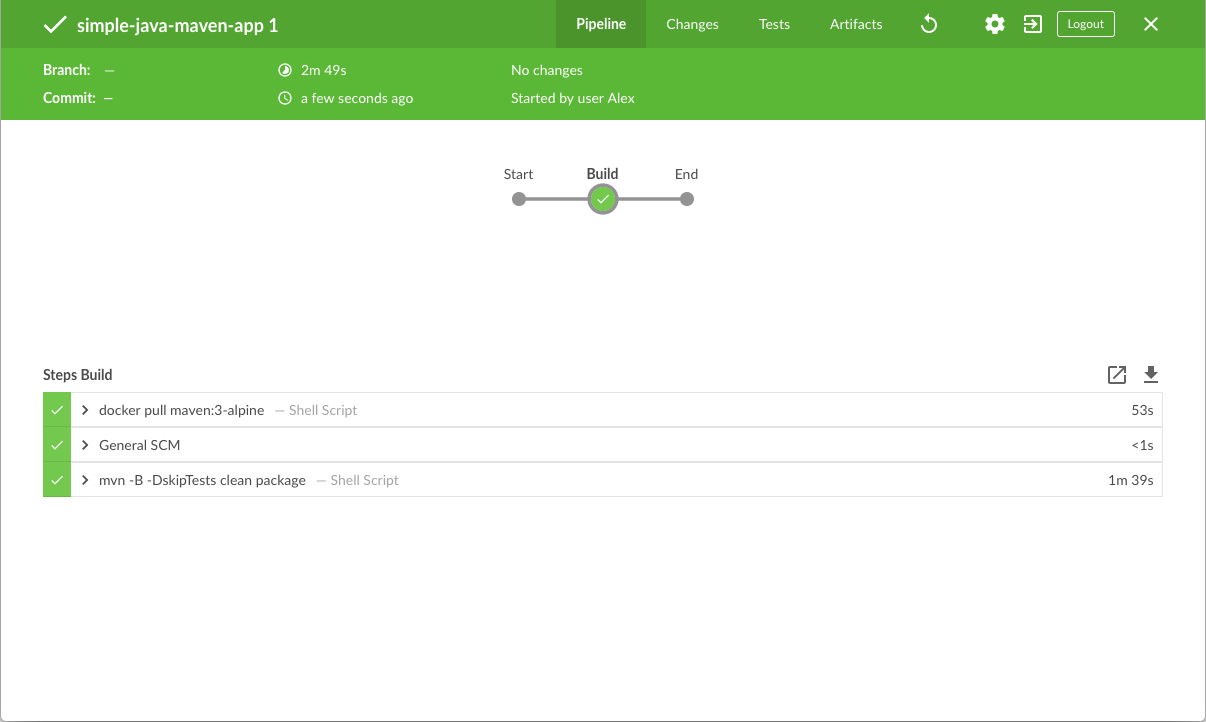

若Jenkins成功构建了你的Java应用,Blue Ocean界面会变为绿色。

-

-

点击右上方的 X 回到Blue Ocean主界面。

为你的流水线增加test阶段

-

回到你的文本编辑器/IDE,打开你的

Jenkinsfile。 -

复制以下声明式流水线代码,并粘贴到

Jenkinsfile中Build阶段的下方:stage('Test') { steps { sh 'mvn test' } post { always { junit 'target/surefire-reports/*.xml' } } }最终的代码为:

pipeline { agent { docker { image 'maven:3-alpine' args '-v /root/.m2:/root/.m2' } } stages { stage('Build') { steps { sh 'mvn -B -DskipTests clean package' } } stage('Test') { steps { sh 'mvn test' } post { always { junit 'target/surefire-reports/*.xml' } } } } }定义了一个名为 Test的stage,之后会出现在Jenkins UI上。这里的 shstep (参考steps章节)执行Maven命令来运行你的Java应用的单元测试。 这个命令还生成一个JUnit XML报告,保存在target/surefire-reports目录 (位于Jenkins容器中的/var/jenkins_home/workspace/simple-java-maven-app目录)。这里的 junitstep (由 JUnit Plugin 提供)用于归档JUnit XML报告(由上面的mvn test命令生成) 并通过Jenkins接口公开结果。在Blue Ocean中,可以在流水线运行的 Tests 页面获取结果。post章节的always条件包含了这个junitstep, 保证了这个step 总是 在Test阶段 结束后 执行,不论该阶段的运行结果如何。 -

保存对

Jenkinsfile的修改并将其提交到你的本地simple-java-maven-appGit仓库。例如,在simple-java-maven-app目录下,运行以下命令:git stage .继续运行git commit -m "Add 'Test' stage" -

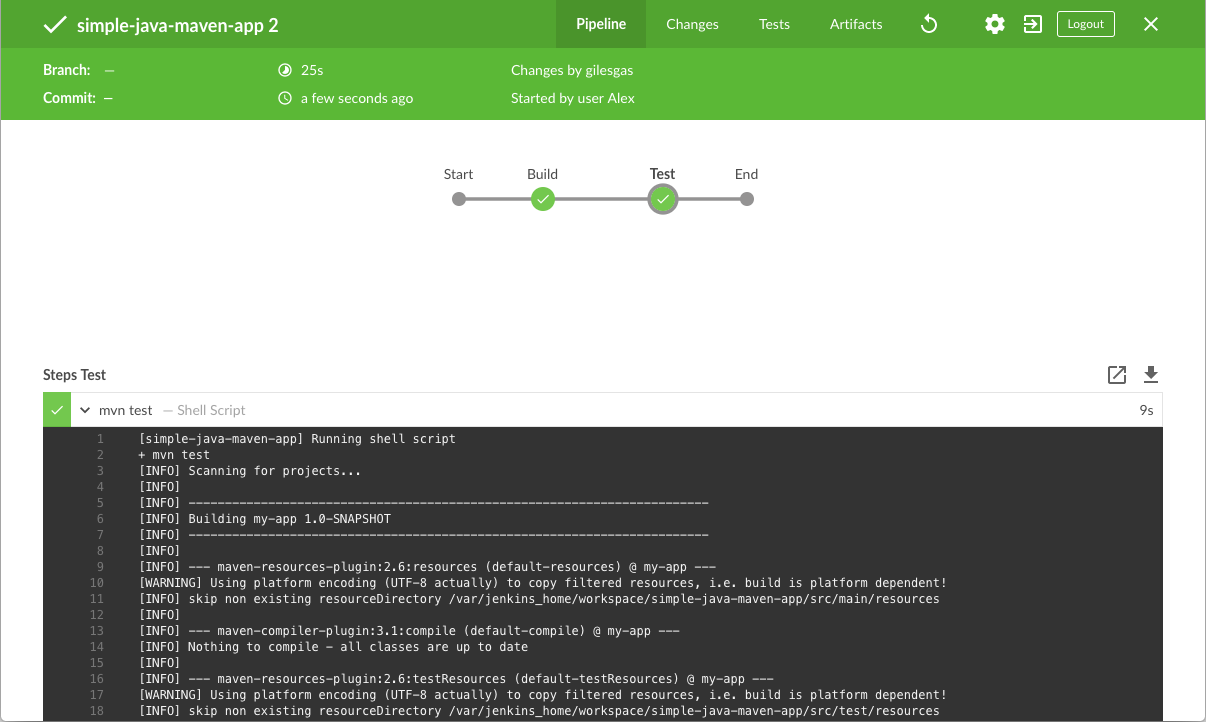

再次回到Jenkins,如果有必要的话重新登录,进入Jenkins的Blue Ocean界面。

-

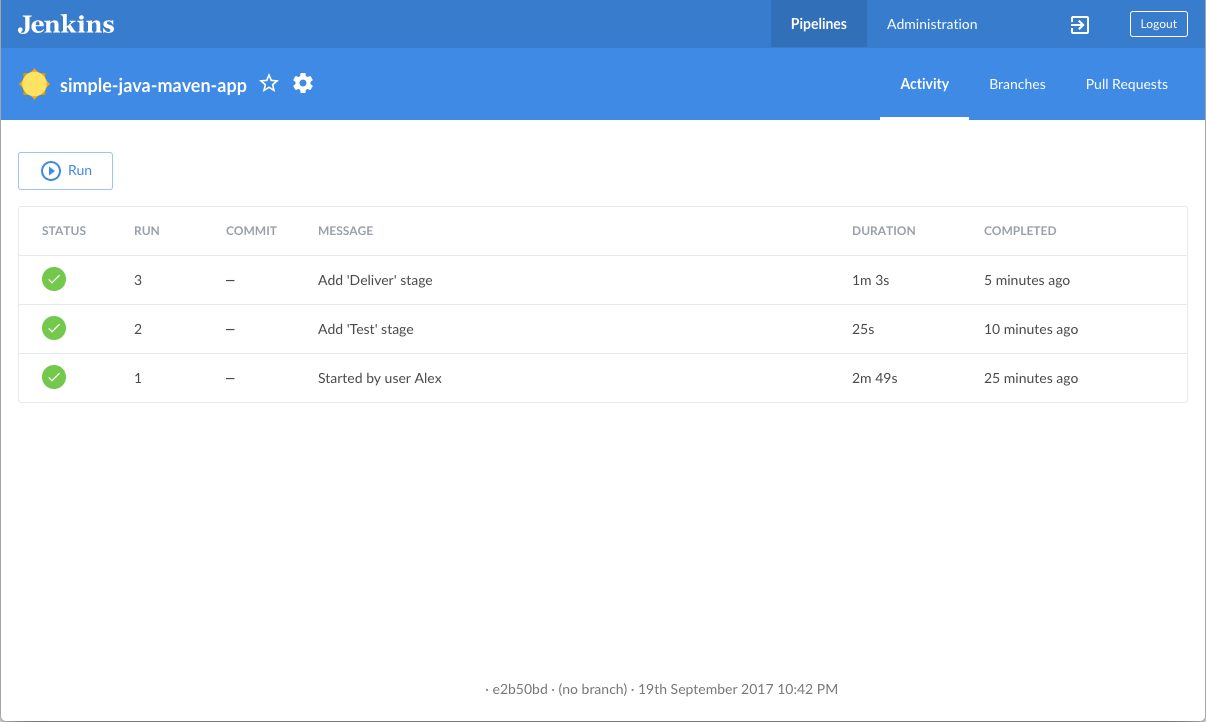

点击左上方的 Run 然后快速点击右下方出现的 OPEN 链接, 观察Jenkins运行你修改过的流水线项目。 如果你不能点击 OPEN 链接,点击Blue Ocean主界面的 top 行来使用这一特性。 注意: 你会发现本次运行Jenkins不再需要下载Maven Docker镜像。Jenkins只需要从之前下载的Maven镜像运行 一个新的容器。另外,如果最近一次运行 流水线 后,Docker没有重启, 那么在 "Build" 阶段无需下载Maven工件。因此,你的流水线再次运行时速度会更快。 如果你修改过的流水线运行成功,Blue Ocean界面看起来会像下面这样。注意增加的 "Test" 阶段。 你可以点击之前的 "Build" 阶段来获取阶段输出结果。

-

点击右上方的 X 回到Blue Ocean主界面。

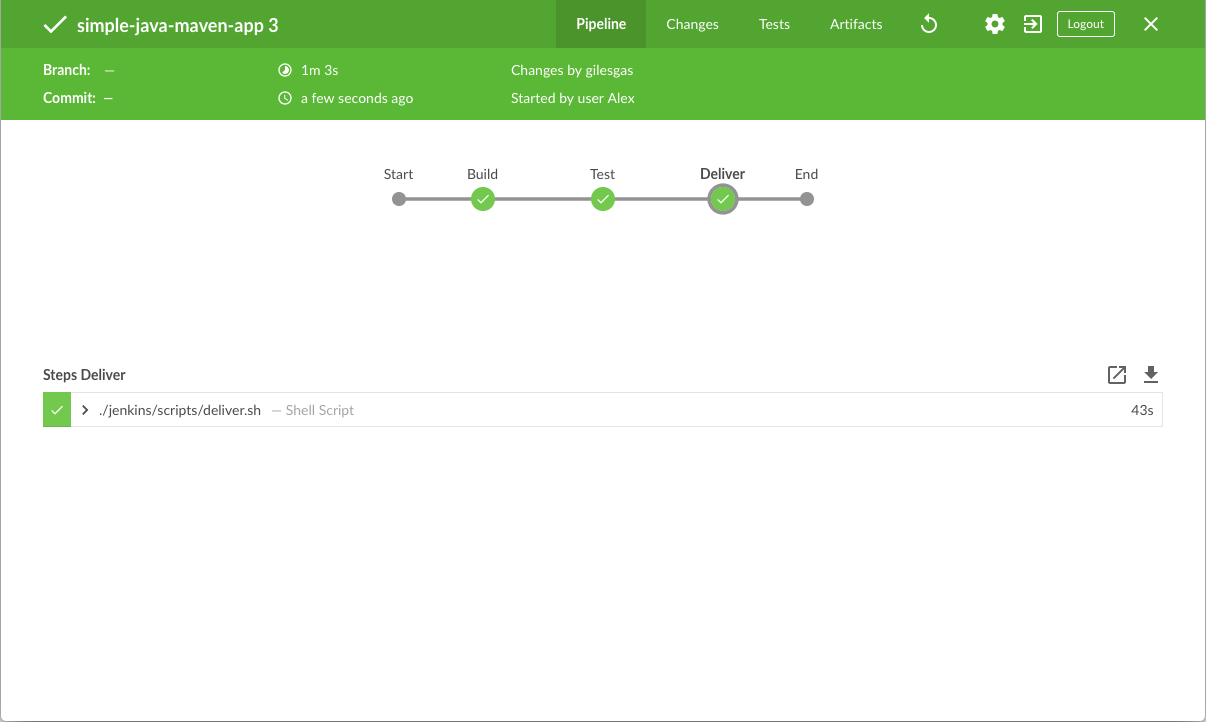

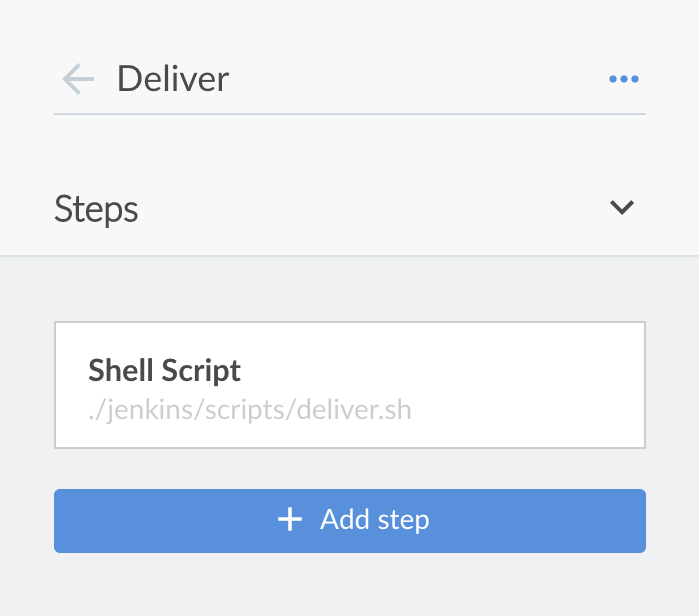

为你的流水线增加deliver阶段

-

回到你的文本编辑器/IDE,打开你的

Jenkinsfile。 -

复制以下声明式流水线代码,并粘贴到

Jenkinsfile中Test阶段的下方:stage('Deliver') { steps { sh './jenkins/scripts/deliver.sh' } }最终的代码为:

pipeline { agent { docker { image 'maven:3-alpine' args '-v /root/.m2:/root/.m2' } } stages { stage('Build') { steps { sh 'mvn -B -DskipTests clean package' } } stage('Test') { steps { sh 'mvn test' } post { always { junit 'target/surefire-reports/*.xml' } } } stage('Deliver') { steps { sh './jenkins/scripts/deliver.sh' } } } }定义了一个名为 Deliver的stage,之后会出现在Jenkins UI上。这里的 shstep (参考steps章节)执行位于jenkins/scripts目录下的shell脚本deliver.sh, 该目录位于simple-java-maven-app仓库根目录下。deliver.sh文件所做动作包含在其自身文本内容中。 一般的原则是,尽量保持你的流水线代码(即Jenkinsfile)越简洁越好,将更复杂的构建步骤放在多个独立的shell脚本中 (尤其对于那些包含2个以上steps的stage)。这最终会使得维护你的流水线代码变得更容易,特别是当你的流水线变得越来越复杂的时候。 -

保存对

Jenkinsfile的修改并将其提交到你的本地simple-java-maven-appGit仓库。例如,在simple-java-maven-app目录下,运行以下命令:git stage .继续运行git commit -m "Add 'Deliver' stage" -

再次回到Jenkins,如果有必要的话重新登录,进入Jenkins的Blue Ocean界面。

-

点击左上方的 Run 然后快速点击右下方出现的 OPEN 链接, 观察Jenkins运行你修改过的流水线项目。 如果你不能点击 OPEN 链接,点击Blue Ocean主界面的 top 行来使用这一特性。 如果你修改过的流水线运行成功,Blue Ocean界面看起来会像下面这样。注意增加的 "Deliver" 阶段。 你可以点击之前的 "Test" 和 "Build" 阶段来获取阶段输出结果。

以下是 "Deliver" 阶段的输出应该是什么样子,向你展示最终Java应用程序的执行结果。

-

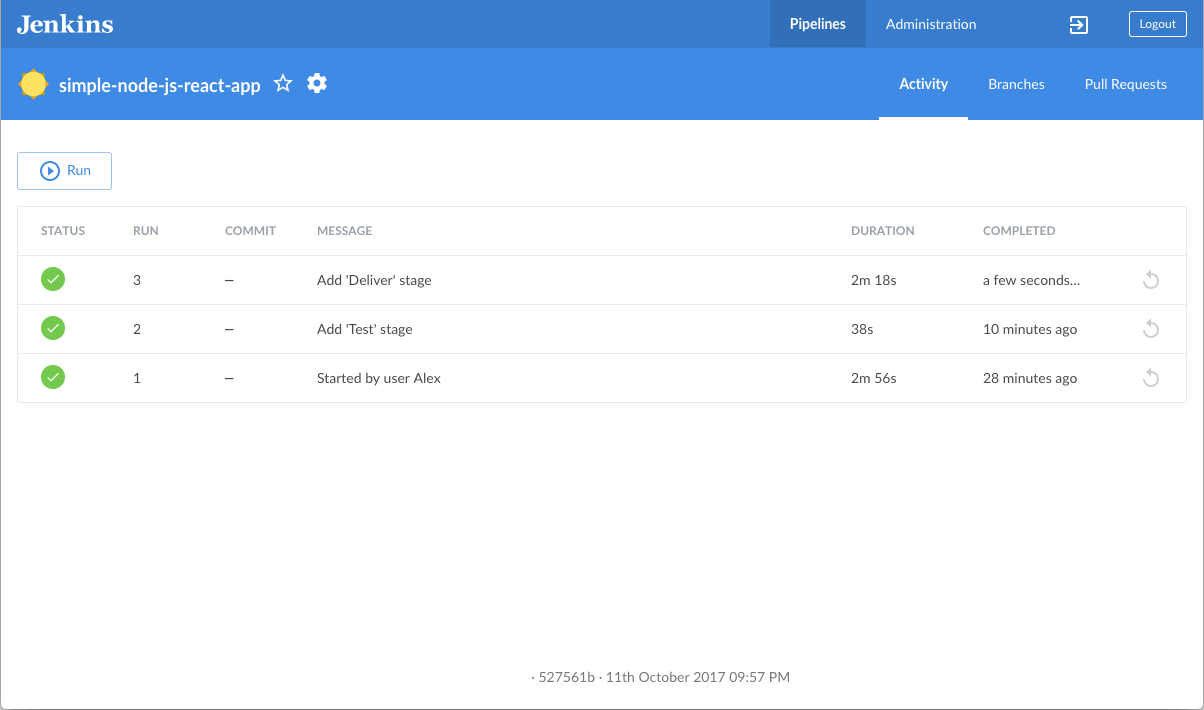

点击右上方的 X 回到Blue Ocean主界面,列表显示流水线历史运行记录,按时间顺序倒序排列。

总结

做得好!您刚刚使用Jenkins用Maven构建了一个简单的Java应用程序!

您在上面创建的 "Build", "Test" 和 "Deliver" 阶段是使用Jenkins中的Maven构建更复杂的Java应用程序的基础,以及与其他技术栈集成的Java和Maven应用程序。

由于Jenkins具有极高的可扩展性,因此可以对其进行修改和配置,以处理构建协调和自动化的几乎任何方面。

要详细了解Jenkins可以做什么,请查看:

-

教程概览 页面中的其他介绍教程。

-

用户手册 使用Jenkins的更多细节,例如 Pipelines (尤其是 Pipeline syntax) 和 Blue Ocean 界面。

-

Jenkins blog 资讯,其他教程和更新。

使用npm构建Node.js和React应用

Table of Contents

-

在 Docker中运行Jenkins

本教程将展示Jenkins如何使用 Node Package Manager (npm)去组合构建简单的 Node.js 和 React 应用 .

如果你是一个对CI/CD概念不了解的 Node.js 和 React 开发者, 或者你熟悉这些概念却不知道如何使用Jenkins完成构建,那么本教程很适合你。 示例Node.js和React(你可以从示例仓库中获取)生成一个网页,该网页含有 "Welcome to React" 内容且伴随有一个检查应用程序满意度的测试。

耗时: 本教程需要 20-40 分钟来完成 (假设你的机器已经满足 配置要求 ). 确切的耗时取决于你机器的性能, 以及你是否完成过在Docker中运行Jenkins 请参考:..[另一个教程]。

你可以在任何时候停止本教程,并从你离开的地方继续。

若你已经完成了另一个教程,可以跳过配置要求和在Docker中运行Jenkins章节, 继续阅读fork示例仓库(确保你本地安装了Git)。 如果你需要重启Jenkins,请参考停止和重启Jenkins.

配置要求

对于本教程,您将需要:

-

安装有macOS,Linux或Windows操作系统的机器,并拥有以下配置:

-

最小256MB内存, 推荐512MB以上。

-

10GB硬盘空间, 用于安装Jenkins,您的Docker镜像和容器。

-

-

安装有以下软件:

-

Docker - 在安装Jenkins页面的安装Docker章节阅读更多信息。 注意: 如果您使用Linux,本教程假定您没有以root用户的身份运行Docker命令,而是使用单个用户帐户访问本教程中使用的其他工具。

-

Git 和 optionally GitHub Desktop.

-

在 Docker中运行Jenkins

在本教程中, 将Jenkins作为 Docker 容器并从

jenkinsci/blueoceanDocker 镜像中运行。要在 Docker中运行Jenkins, 请遵循下面的macOS 和 Linux 或 Windows相关文档说明进行操作。 .

你可以在 Docker和 Installing Jenkins 页面的 Downloading and running Jenkins in Docker部分阅读更多有关Docker容器和镜像概念的信息。

在 macOS 和 Linux 系统上

-

打开终端窗口

-

使用下面的

docker run命令运行jenkinsci/blueocean镜像作为Docker中的一个容器(记住,如果本地没有镜像,这个命令会自动下载):docker run \ --rm \ -u root \ -p 8080:8080 \ -v jenkins-data:/var/jenkins_home \ -v /var/run/docker.sock:/var/run/docker.sock \ -v "$HOME":/home \ jenkinsci/blueocean

将容器中的 /var/jenkins_home目录映射到 Docker volume ,并将其命名为jenkins-data。如果该卷不存在, 那么docker run命令会自动为你创建卷。将主机上的 $HOME目录 (即你的本地)映射到 (通常是/Users/目录) 到容器的/home目录。Note: 如果复制或粘贴上面的命令片段不起作用, 尝试复制和粘贴这个没有注释的版本:

docker run \ --rm \ -u root \ -p 8080:8080 \ -v jenkins-data:/var/jenkins_home \ -v /var/run/docker.sock:/var/run/docker.sock \ -v "$HOME":/home \ jenkinsci/blueocean

-

继续 安装向导。

在 Windows 系统

-

打开命令提示窗口。

-

使用下面的

docker run命令运行jenkinsci/blueocean镜像作为Docker中的一个容器(记住,如果本地没有镜像,这个命令会自动下载):docker run ^ --rm ^ -u root ^ -p 8080:8080 ^ -v jenkins-data:/var/jenkins_home ^ -v /var/run/docker.sock:/var/run/docker.sock ^ -v "%HOMEPATH%":/home ^ jenkinsci/blueocean

对这些选项的解释, 请参考上面的 macOS 和 Linux 说明。

-

继续安装向导。

访问 Jenkins/Blue Ocean Docker 容器

如果你有一些使用 Docker 的经验,希望或需要使用

docker exec命令通过一个终端/命令提示符来访问 Jenkins/Blue Ocean Docker 容器, 你可以添加如--name jenkins-tutorials选项(与上面的docker run), 这将会给Jenkins/Blue Ocean Docker容器一个名字 "jenkins-tutorials"。这意味着你可以通过

docker exec命令访问Jenkins/Blue Ocean 容器(通过一个单独的终端 /命令提示窗口) ,例如:docker exec -it jenkins-tutorials bash

安装向导

在你访问 Jenkins之前, 你需要执行一些快速的 "一次性" 步骤。

解锁 Jenkins

当你第一次访问一个新的 Jenkins 实例时, 要求你使用自动生成的密码对其进行解锁。

-

当在终端/命令提示窗口出现两组星号时, 浏览

http://localhost:8080并等待 Unlock Jenkins 页面出现。

-

再次从终端/命令提示窗口, 复制自动生成的字母数字密码(在两组星号之间)。

-

在 Unlock Jenkins 页面, 粘贴该密码到 Administrator password 字段并点击 Continue。

使用插件自定义 Jenkins

在 解锁 Jenkins后, Customize Jenkins 页面出现。

在该页面,点击 Install suggested plugins。

安装向导显示了正在配置的Jenkins的进程,以及建议安装的插件。这个过程肯需要几分钟。

创建第一个管理员用户

最后, Jenkins 要求创建你的第一个管理员用户。

-

当 Create First Admin User 页面出现, 在相应的字段中指定你的详细消息并点击 Save and Finish。

-

当 Jenkins is ready 页面出现, 点击 Start using Jenkins。 Notes:

-

该页面可能表明 Jenkins is almost ready! 如果相反, 点击 Restart.

-

如果该页面在一分钟后没有自动刷新, 使用你的web浏览器手动刷新。

-

-

如果需要,登录 Jenkins , 你就可以开始使用 Jenkins了!

停止和重启 Jenkins

在本教程的其余部分, 你可以通过在终端/命令提示窗口输入

Ctrl-C停止 Jenkins/Blue Ocean Docker 容器,你可以从中运行<>的docker run ...命令。要重启Jenkins/Blue Ocean Docker 容器:

-

在上面的 macOS,Linux 或 Windows上运行相同的

docker run ...命令 。 Note: 如果有更新的话,该进程会更新jenkinsci/blueoceanDocker 镜像。 -

浏览

http://localhost:8080。 -

等待直到登录页面出现并登陆。

Fork 和 clone GitHub 示例仓库

通过将应用程序源代码所在的示例仓库fork到你自己的Github账号中, 并clone到本地, 你就可以获取一个"Welcome to React"简单Node.js和React应用程序。

-

请确保你登陆了你的GitHub账户。如果你还没有Github账户,你可以在 GitHub网站 免费注册一个账户。.

-

将示例仓库

simple-node-js-react-npm-appfork到你的账户的Github仓库中。在此过程中,如果你需要帮助, 请参考 Fork A Repo 文档。 -

将你的GitHub账户中的

simple-node-js-react-npm-app仓库clone到你的本地机器。 根据你的情况完成以下步骤之一(其中 `` 是你的操作系统用户账户名称):-

在GitHub网站上,点击绿色的 Clone or download 按钮,再点击 Open in Desktop.

-

在Github桌面版中,在点击 Clone a Repository 对话框上的 Clone 按钮之前,确保 Local Path 的配置为:

-

macOS 系统配置为

/Users//Documents/GitHub/simple-node-js-react-npm-app -

Linux 系统配置为

/home//GitHub/simple-node-js-react-npm-app -

Windows 配置为

C:\Users\\Documents\GitHub\simple-node-js-react-npm-app

-

-

-

其他情况:

-

打开一个终端/命令提示行,并且

cd进入正确的目录:-

macOS 系统路径为

/Users//Documents/GitHub/ -

Linux 系统路径为

/home//GitHub/ -

Windows 系统路径为

C:\Users\\Documents\GitHub\(建议使用 Git bash 命令而不是通常的 Microsoft 命令提示符)

-

-

运行以下的命令完成仓库的clone:

git clone https://github.com/YOUR-GITHUB-ACCOUNT-NAME/simple-node-js-react-npm-app其中YOUR-GITHUB-ACCOUNT-NAME是你的GitHub账户用户。

-

-

在Jenkins中创建流水线项目

-

回到Jenkin,再次登录并点击 Welcome to Jenkins! 下的 create new jobs + Note: 如果没有看到上述内容,请点击左上角的 New Item 。

-

在 Enter an item name 域, 填写你的新的流水线项目的名称 (比如

simple-node-js-react-npm-app)。 -

向下滚动并单击 Pipeline, 然后点击页面末尾的 OK。

-

( Optional )在下一页中,在 Description 字域为你的流水线项目做一个简短的描述(比如.

An entry-level Pipeline demonstrating how to use Jenkins to build a simple Node.js and React application with npm.) -

点击页面顶部的 Pipeline 选项,向下滚动到 Pipeline 部分.

-

在Definition 域,选择 Pipeline script from SCM 选项。此选项指示Jenkins从源代码管理(SCM)仓库获取你的流水线, 这里的仓库就是你clone到本地的Git仓库。

-

在 SCM 域中,选择 Git。

-

在 Repository URL 域中,填写你本地仓库的 目录路径, 这是从你主机上的用户账户home目录映射到Jenkins容器的

/home目录:-

macOS系统 -

/home/Documents/GitHub/simple-node-js-react-npm-app -

Linux系统 -

/home/GitHub/simple-node-js-react-npm-app -

Windows系统 -

/home/Documents/GitHub/simple-node-js-react-npm-app

-

-

点击 Save 保存你的流水线项目。你现在可以开始创建你的

Jenkinsfile,这些文件会被添加到你的本地仓库。

将你的初始流水线创建为Jenkinsfile

现在你已准备好创建你的流水线,它将使用Jenkins中的Maven自动构建你的Node.js 和 React 应用。 你的流水线将被创建为

Jenkinsfile,它将被提交到你本地的Git仓库(simple-java-maven-app)。这是 "Pipeline-as-Code" 的基础,它将持续交付流水线作为应用程序的一部分,与其他代码一样进行版本控制和审查。 了解更多信息请阅读 流水线以及用户手册中的 使用Jenkinsfile 章节。

首先,创建一个初始流水线来下载 Docker镜像,并将其作为Docker容器运行(这将构建你的简单Java应用)。 同时添加一个“构建”阶段到流水线中,用于协调整个过程。

-

使用你最常用的文本编辑器或者IDE,在你本地的

simple-java-maven-appGit仓库的根目录创建并保存一个名为Jenkinsfile的文本文件。 -

复制以下声明式流水线代码并粘贴到

Jenkinsfile文件中:pipeline { agent { docker { image 'node:6-alpine' args '-p 3000:3000' } } stages { stage('Build') { steps { sh 'npm install' } } } }这里的 image参数(参考agent章节的docker参数) 是用来下载maven:3-aplineDocker镜像 (如果你的机器还没下载过它)并将该镜像作为单独的容器运行。这意味着:你将在Docker中本地运行相互独立的Jenkins和Node容器。Node容器成为了Jenkins用来运行你的流水线项目的 agent 。然而, 这个容器寿命较短 - 它的寿命周期只是你的流水线执行的持续时间 。这里的 args参数使Node容器(暂时的) 可通过端口3000进行访问。它的意义在于解释你clone的仓库的jenkins/scripts/deliver.sh域, 在本教程的后续部分将介绍这一内容。定义出现在Jenkins UI中名为 Build的stage(指令)这里的 sh步骤 (参考steps章节) 执行npm命令确保运行你的应用程序的所需的所有依赖被下载到node_modules工作区目录 (在Jenkins容器的/var/jenkins_home/workspace/simple-node-js-react-npm-app目录中). -

保存并提交你编辑的

Jenkinsfile到你本地的simple-node-js-react-npm-appGit 仓库。 比如.在simple-node-js-react-npm-app目录中,运行命令:git add .然后git commit -m "Add initial Jenkinsfile" -

再次回到Jenkins, 如果有必要的话再次登录,点击左边的 Open Blue Ocean 进入 Jenkins的Blue Ocean 界面.

-

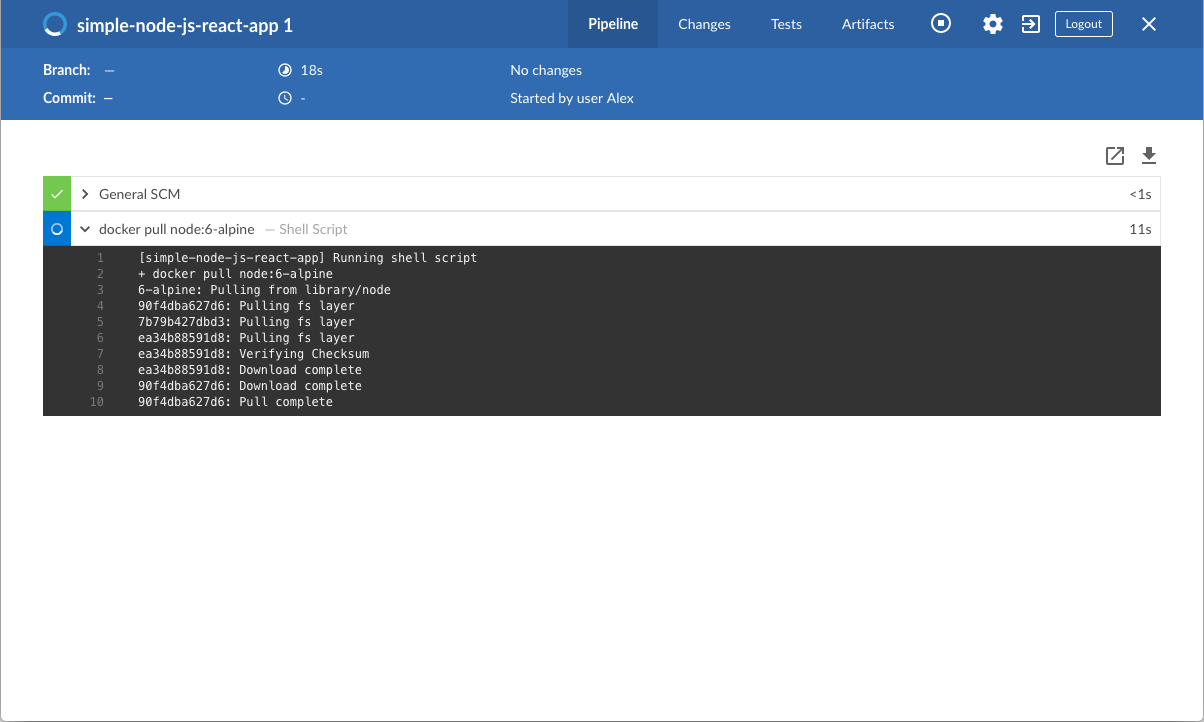

在 This job has not been run 消息框, 点击 Run, 然后快速的点击在右下的 OPEN 链接,查看Jenkins构建你的流水线项目. 如果你点击不了 OPEN 链接, 点击Blue Ocean的主界面的一行来使用这一特性。+ Note: 你可能需要几分钟完成第一次的运行。 在clone你本地的

simple-node-js-react-npm-appGit 仓库后, Jenkins进行了以下动作:-

将项目加入队列等待在agent上的运行。 ..下载 Node容器镜像并将它运行在Docker的一个容器中.

-

在Node容器中运行

Build阶段 (在Jenkinsfile中定义) 。 在这期间,npm会下载运行你的Nod.js和React应用所需的一些依赖,这些依赖最终会被保存在node_modules工作区目录 (在Jenkins的主目录中).

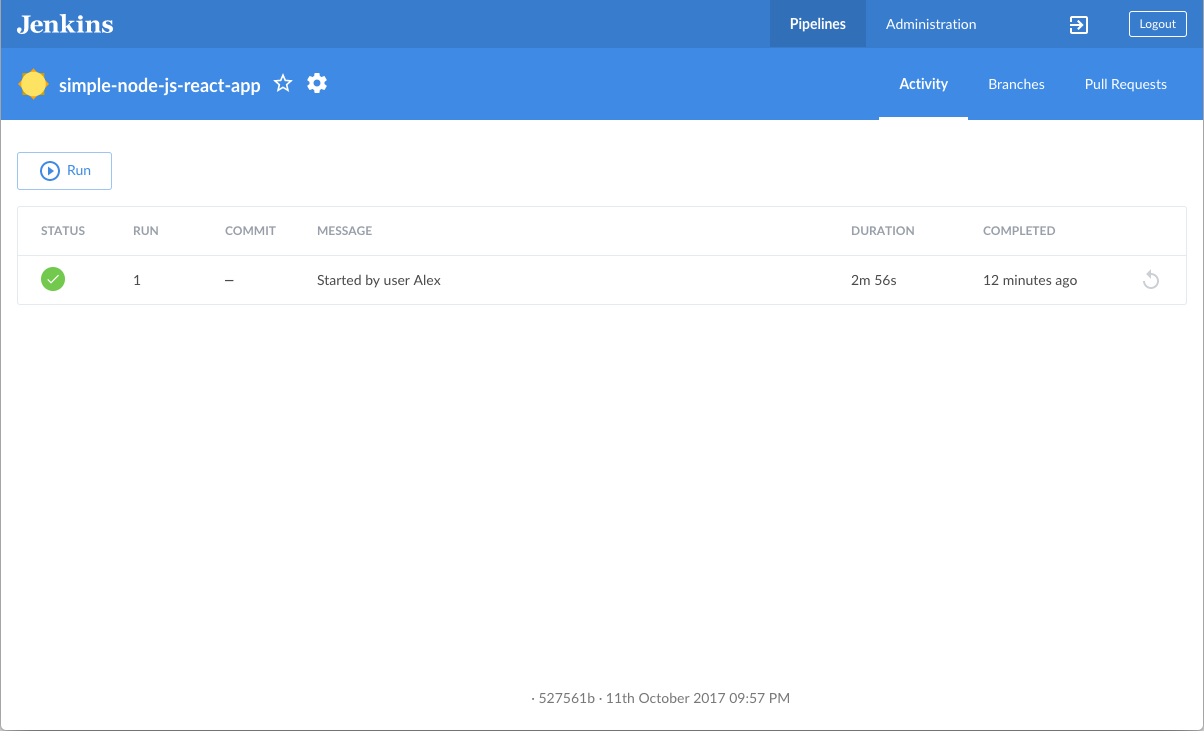

如果Jenkins成功构建了你的应用,Blue Ocean的界面就会变绿。

-

-

点击右上角的 X 返回到Blue Ocean的主界面.

向流水线添加Test阶段

-

回到文本编辑器/IDE,打开

Jenkinsfile。 -

在

Jenkinsfile的agent部分复制并粘贴下面的声明式语法:environment { CI = 'true' }以及在

Build阶段复制并粘贴以下内容 :stage('Test') { steps { sh './jenkins/scripts/test.sh' } }最终的代码为:

pipeline { agent { docker { image 'node:6-alpine' args '-p 3000:3000' } } environment { CI = 'true' } stages { stage('Build') { steps { sh 'npm install' } } stage('Test') { steps { sh './jenkins/scripts/test.sh' } } } }这里的 environment指令 设置环境变量CI为布尔值true, 它对管道中的所有步骤都是有用的。 当test.sh的npm test命令 (在定义在流水线的下一步的Test阶段运行) 检测到环境变量CI值为true时, 该命令在 "non-watch" (i.e. non-interactive) 模式下运行。在"watch" 模式下,npm test期望用户的输入,它能够无限期地停止 CI/CD 应用的运行。 作为在Jenkins的流水线中指定environment指令的替代选择, 你也可以在package.json域中指定该环境变量的值(通过npm test命令) 通过以下方式:在jenkins/scripts/test.sh取消npm install --save-dev cross-env命令 ( 在Test阶段安装cross-env依赖)。了解更多请参考test.sh文件.在package.json文件中修改以下行 (在simple-node-js-react-npm-app仓库的根目录下) 从"test": "react-scripts test --env=jsdom",到"test": "cross-env CI=true react-scripts test --env=jsdom",定义名为 Test的stage(指令), 它出现在Jenkins UI中. <3>sh步骤 (参考steps章节) 运行 shell 脚本test.sh,该脚本位于simple-node-js-react-npm-app仓库的jenkins/scripts目录。test.sh文件本身对其进行了解释. 在通用原则下, 最好让你的流水线代码 (也就是Jenkinsfile) 尽可能的整洁,并且将更复杂的构建脚本放在一个独立的像test.sh文件一样的shell脚本文件里。这最终会促进你的流水线的维护,尤其是在它更复杂的情况下。 -

保存并提交你编辑的

Jenkinsfile到你本地的simple-node-js-react-npm-appGit 仓库。比如在simple-node-js-react-npm-app仓库, 运行命令:git stage .然后git commit -m "Add 'Test' stage" -

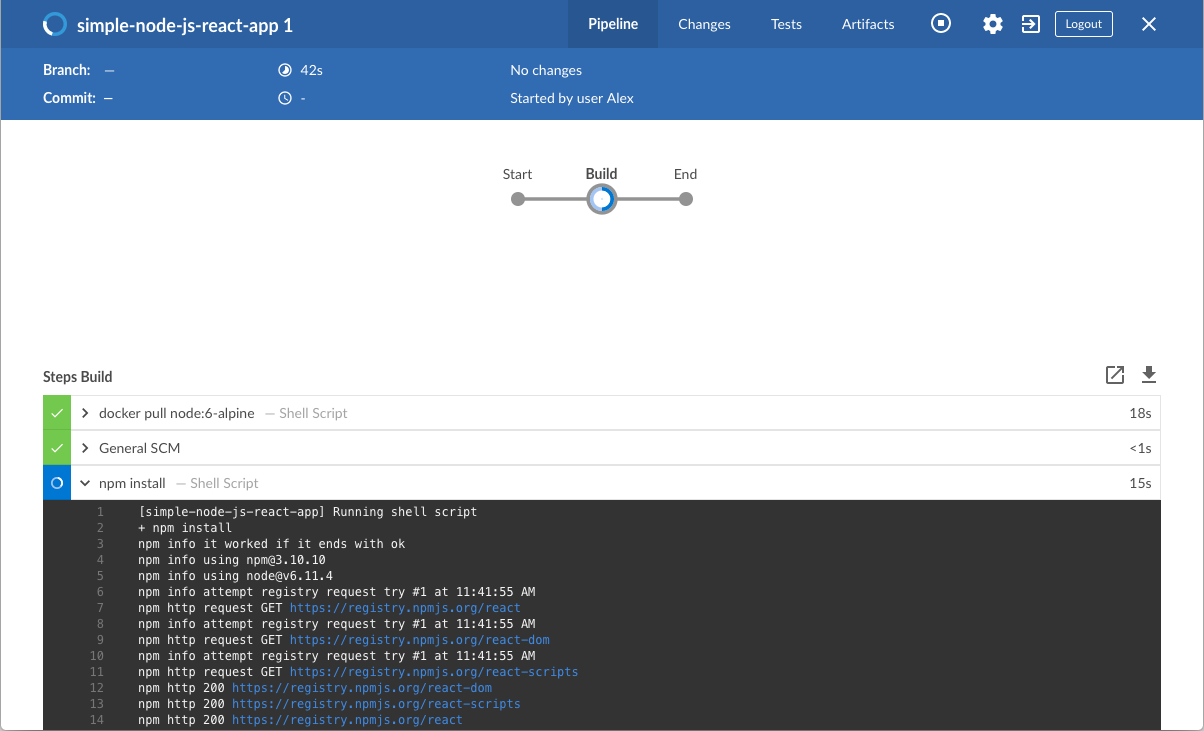

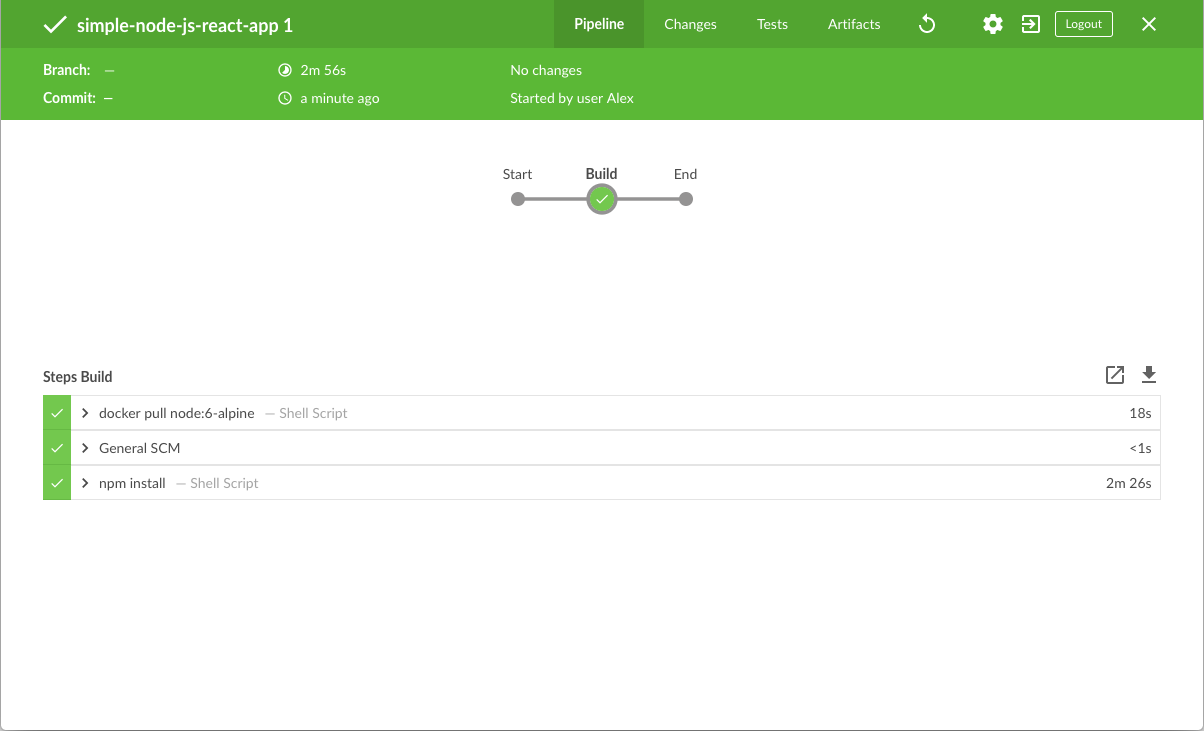

再次回到Jenkins , 如果必要的话再次登录并进入 Jenkins的 Blue Ocean 界面。

-

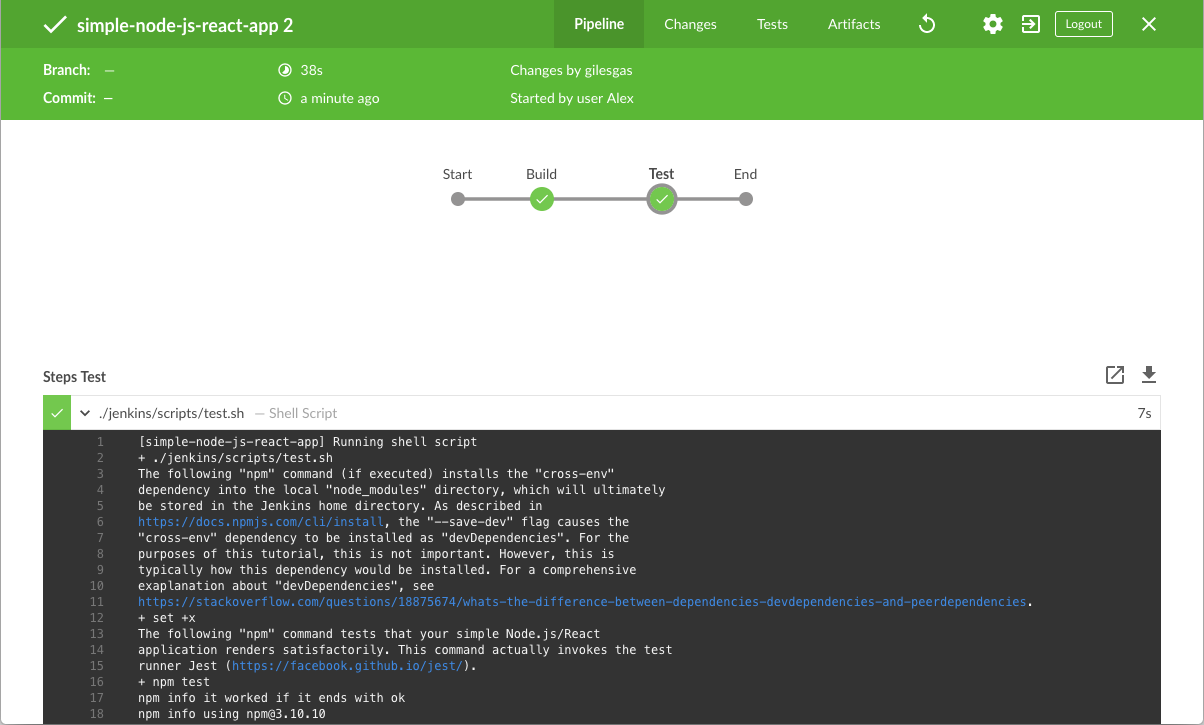

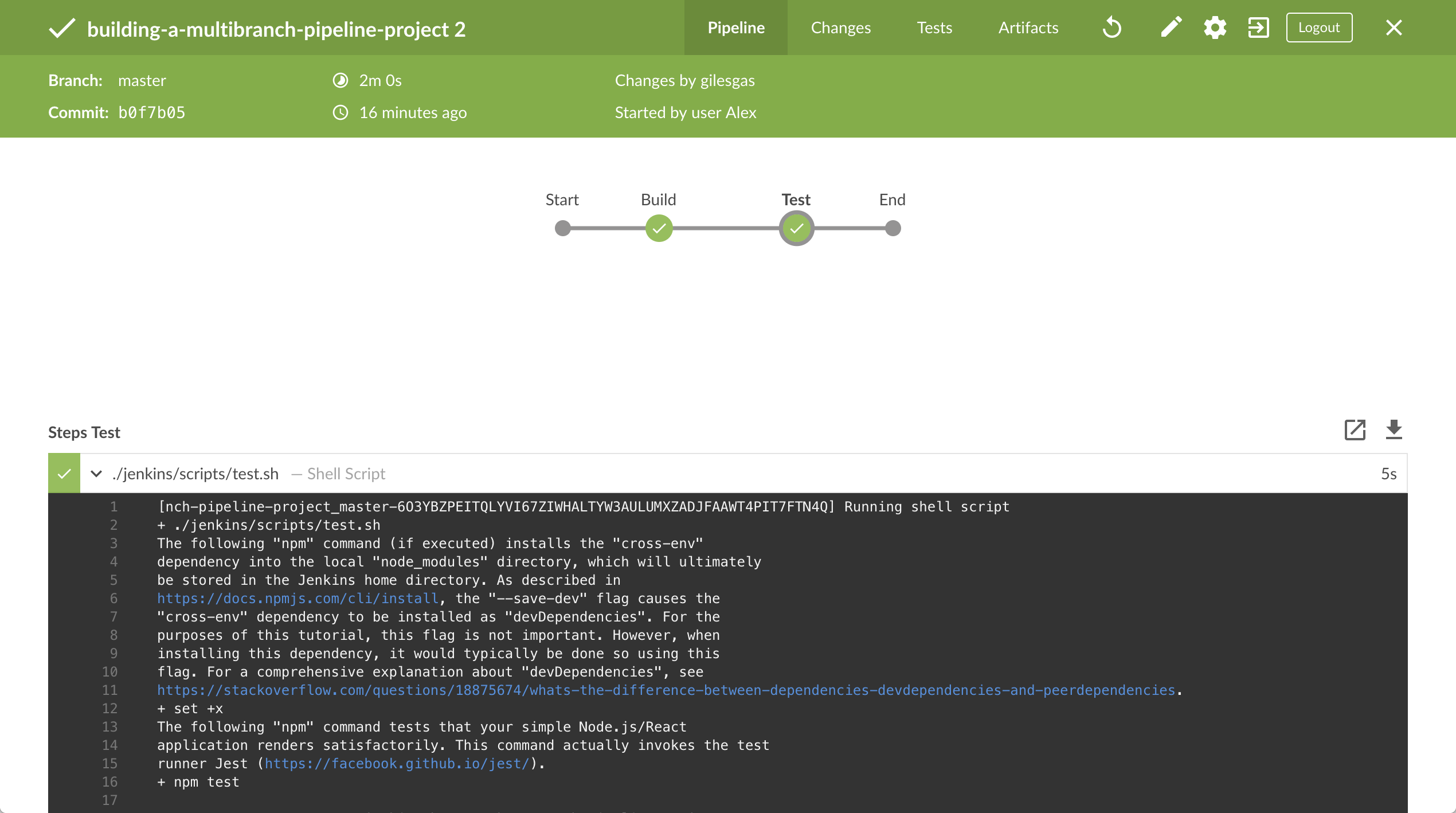

点击左上方的 Run , 然后快速的点击出现在右下方的 OPEN 链接 观察 Jenkins 运行你改进之后的流水线项目。如果点击不了 OPEN 链接, 点击Blue Ocean 界面的top 行使用这一特性。 Note: 你在这次运行中会注意到 Jenkins 不再需要下载 Node Docker 镜像。 而是, Jenkins 只需要从之前下载的Node镜像中运行一个新的容器 。 并且, 从现在开始, 在"Build"阶段不再需要下载 (新的)

npm依赖。 因此, 在接下来的时间运行流水线会更快些。 如果改进后的流水线运行成功, Blue Ocean 界面应该是这样的。另外要注意 "Test" 阶段。你可以点击之前的 "Build" 阶段来循环的 访问该阶段的输出。

-

点击右上方的 X 回到 Blue Ocean 主界面。

给流水线添加最终交付阶段

-

回到文本编辑器/IDE,打开

Jenkinsfile。 -

在

Jenkinsfile的Test阶段下方复制并粘贴以下的声明式流水线语法:stage('Deliver') { steps { sh './jenkins/scripts/deliver.sh' input message: 'Finished using the web site? (Click "Proceed" to continue)' sh './jenkins/scripts/kill.sh' } }最终的代码如下:

pipeline { agent { docker { image 'node:6-alpine' args '-p 3000:3000' } } environment { CI = 'true' } stages { stage('Build') { steps { sh 'npm install' } } stage('Test') { steps { sh './jenkins/scripts/test.sh' } } stage('Deliver') { steps { sh './jenkins/scripts/deliver.sh' input message: 'Finished using the web site? (Click "Proceed" to continue)' sh './jenkins/scripts/kill.sh' } } } }environment指令 不会出现在你的流水线中,如果你在package.jsonabove 指定CI环境变量。定义一个新的 Deliver阶段,它出现在 Jenkins UI中。sh步骤 (参考steps章节) 运行 shell 脚本deliver.sh,该脚本位于simple-node-js-react-npm-app仓库的jenkins/scripts目录。deliver.sh文件对它进行了解释。input步骤 (由 Pipeline: Input Step 插件提供) 中止运行构建并提示用户(带有自定义消息) 进行或中止。sh步骤运行 shell 脚本kill.sh, 该脚本也位于jenkins/scripts目录。kill.sh文件进行了解释。 -

保存并提交你编辑的

Jenkinsfile到你的本地simple-node-js-react-npm-appGit 仓库. 比如在simple-node-js-react-npm-app仓库, 运行命令:git stage .然后git commit -m "Add 'Deliver' stage" -

再次回到 Jenkins , 如果有必要的话再次登录并进入 Jenkins的 Blue Ocean 主界面。

-

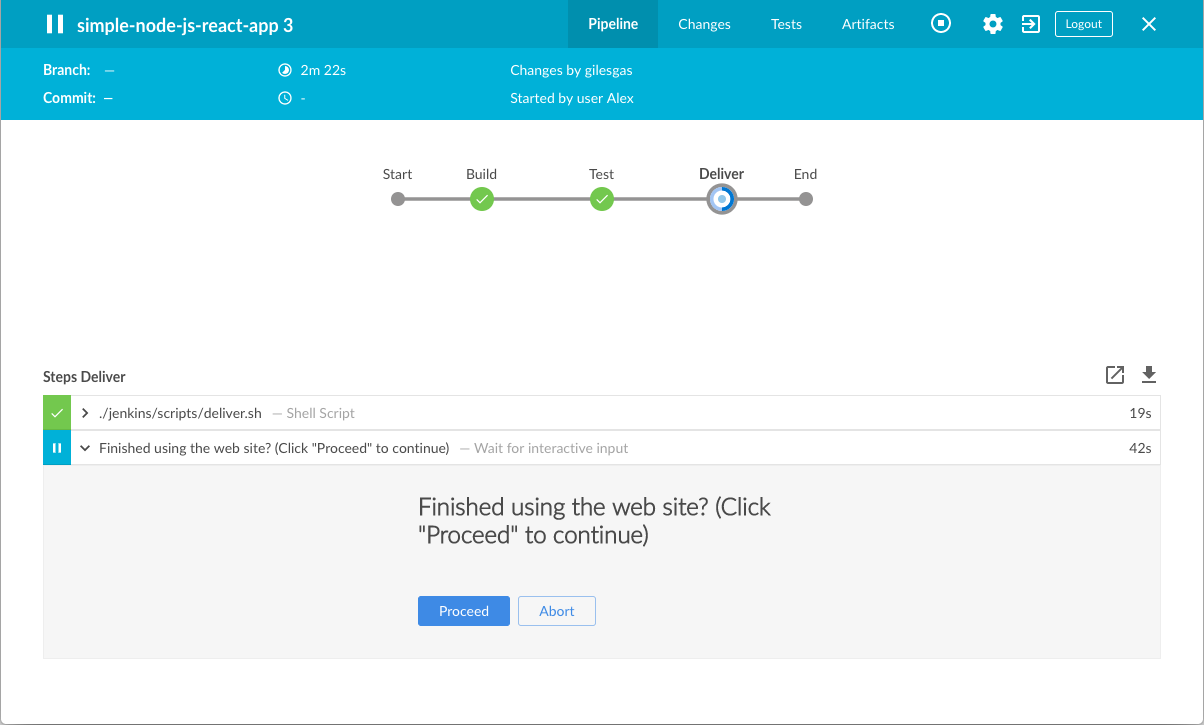

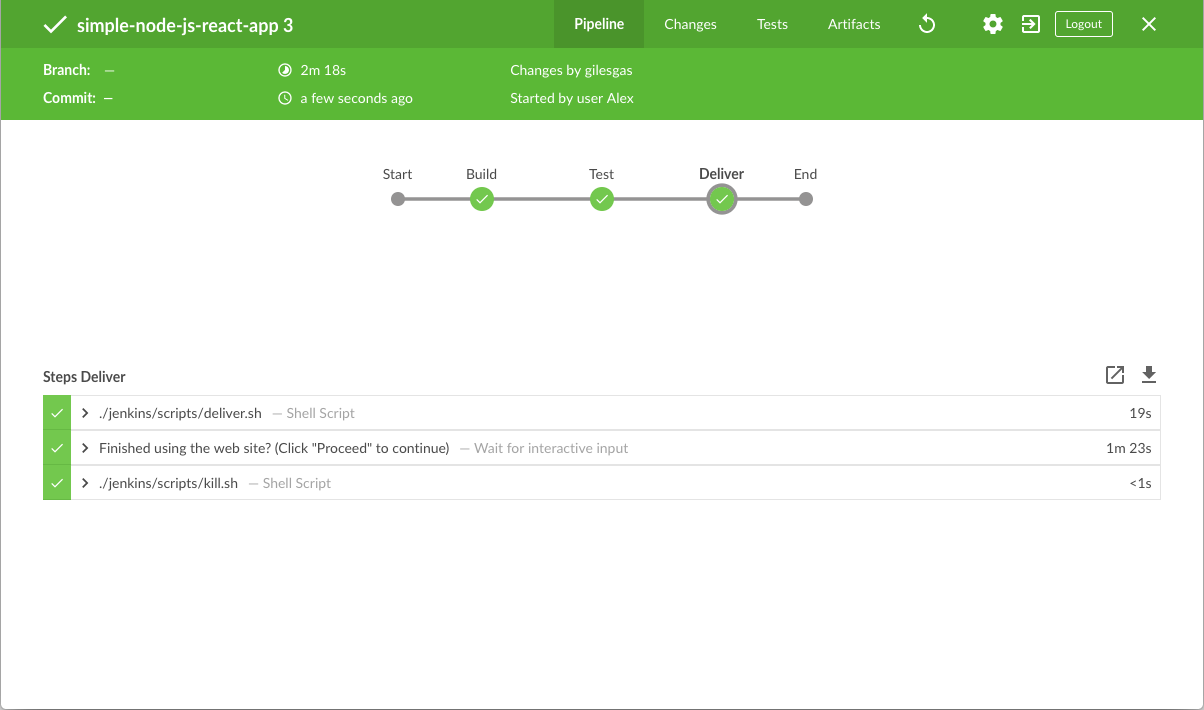

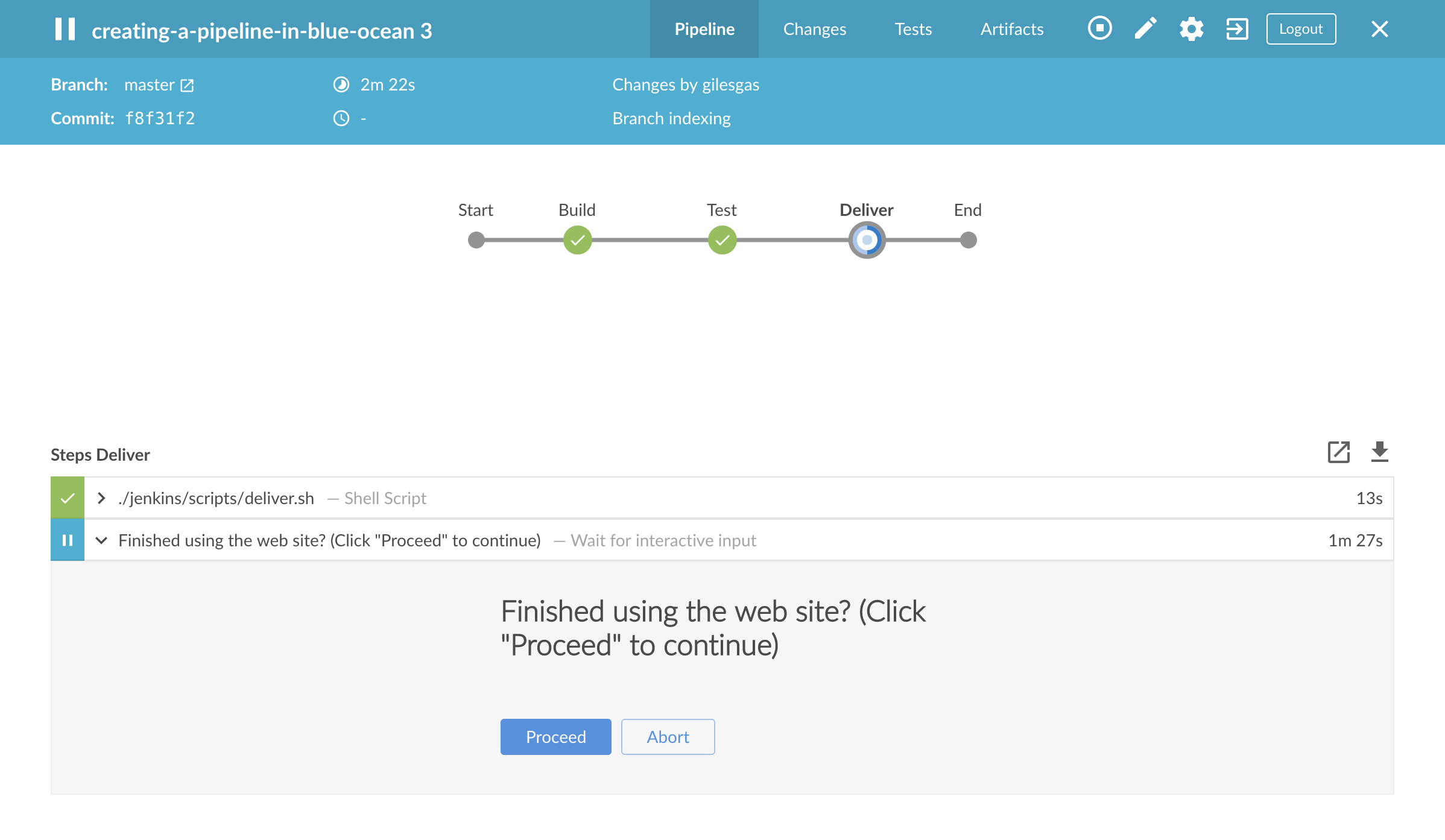

点击左上方的 Run t, 然后快速的点击出现在右下方的 OPEN ,查看 Jenkins 运行你改进后的流水线项目。 如果你点击不了 OPEN 链接, 点击Blue Ocean界面的 top 行 来使用.这一特性。 如果你成功运行了流水线, Blue Ocean 界面应该是这样的. 另外注意 "Deliver" 阶段。 点击之前的 "Test" 和 "Build" 阶段循环的访问这些阶段的输出。

-

观察 "Deliver" 阶段 (必要的时候点击它), 然后点击 绿色的

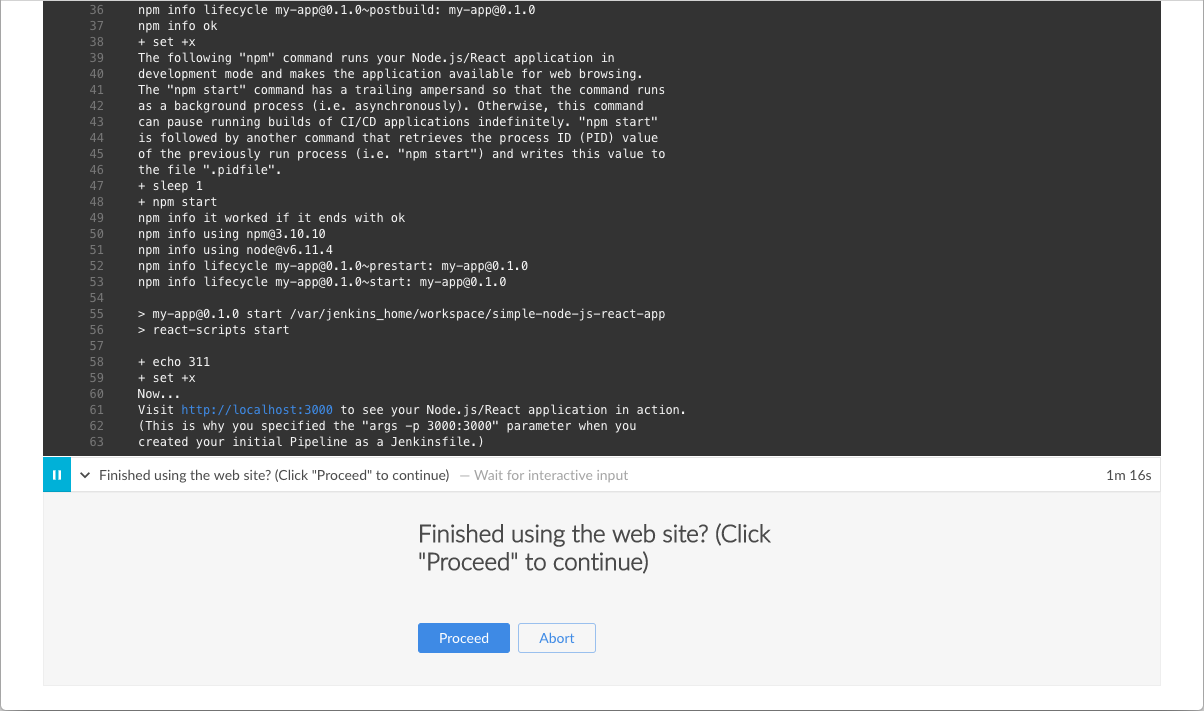

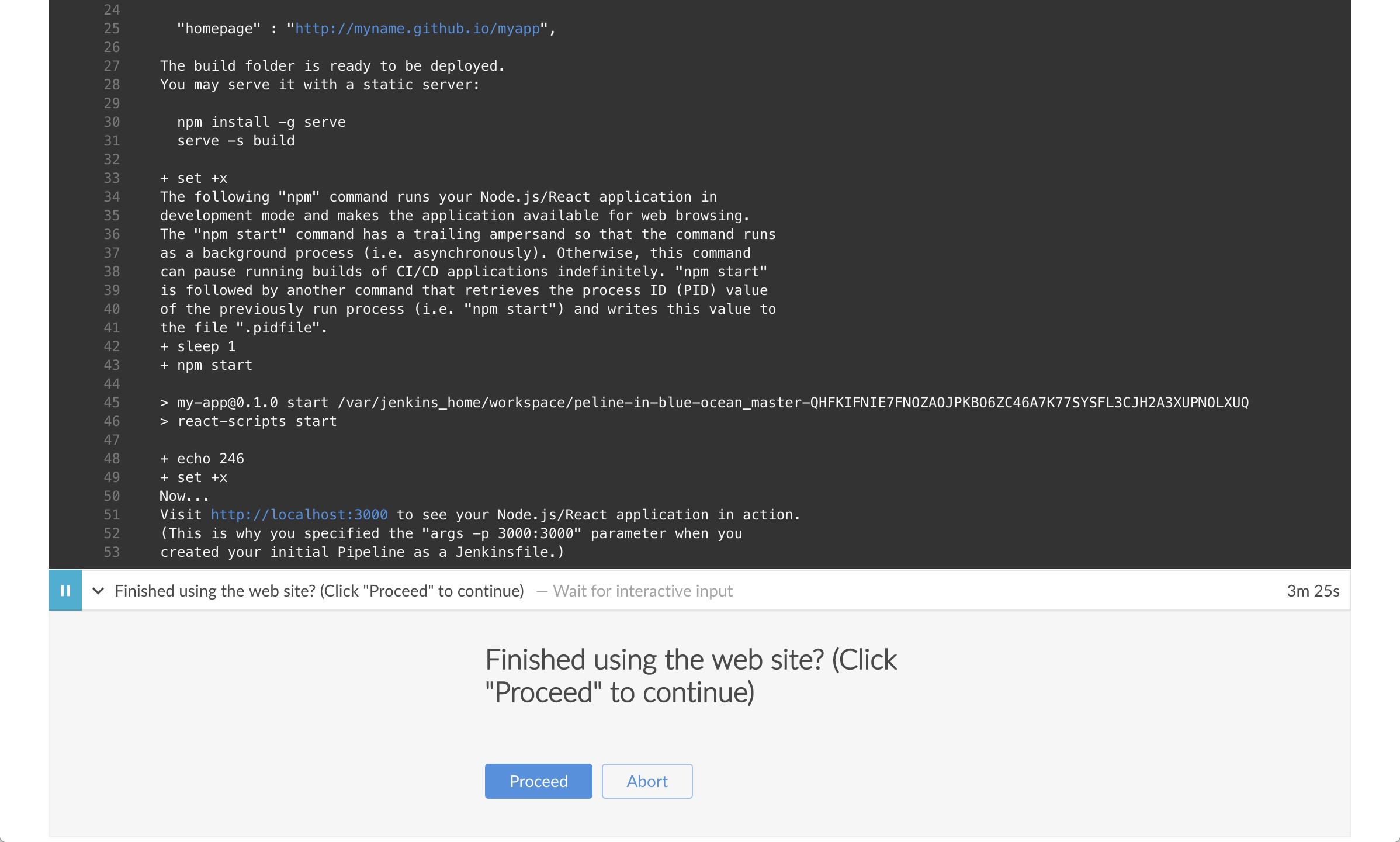

./jenkins/scripts/deliver.sh步骤扩展它的内容并向下滚动直到看见http://localhost:3000链接。

-

点击

http://localhost:3000链接在一个新的浏览器选项卡查看你的 Node.js 和 React 应用的运行(在开发模式下) 。 你会 看到一个标题为 Welcome to React 的网页/站点。 Tip: 如果你觉得有些冒险, 你可以尝试访问你的Jenkins Docker 终端/命令提示符 , 然后使用 vi 编辑器, 调整并保存App.js源文件,查看出现在 the Welcome to React 页面上的结果。 为此, 运行下面的命令:docker exec -it <docker-container-name> bash cd /var/jenkins_home/workspace/simple-node-js-react-npm-app/src vi App.js

这个命令可以访问到你的Jenkins Docker容器的终端/命令提示符 。 使用命令 docker ps可以获得` 。 另外, 他就是jenkins-tutorials(如果你在之前运行容器 [above](https://www.jenkins.io/zh/doc/tutorials/build-a-node-js-and-react-app-with-npm/#run-jenkins-in-docker) 的时候在命令中指定了它 - 比如--name jenkins-tutorials`).在容器中, 更该目录为 Node.js 和 React 源目录 (在 Jenkins 工作区目录). 使用vi编辑器访问, 编辑和保存改变你的应用的 App.js文件 。 -

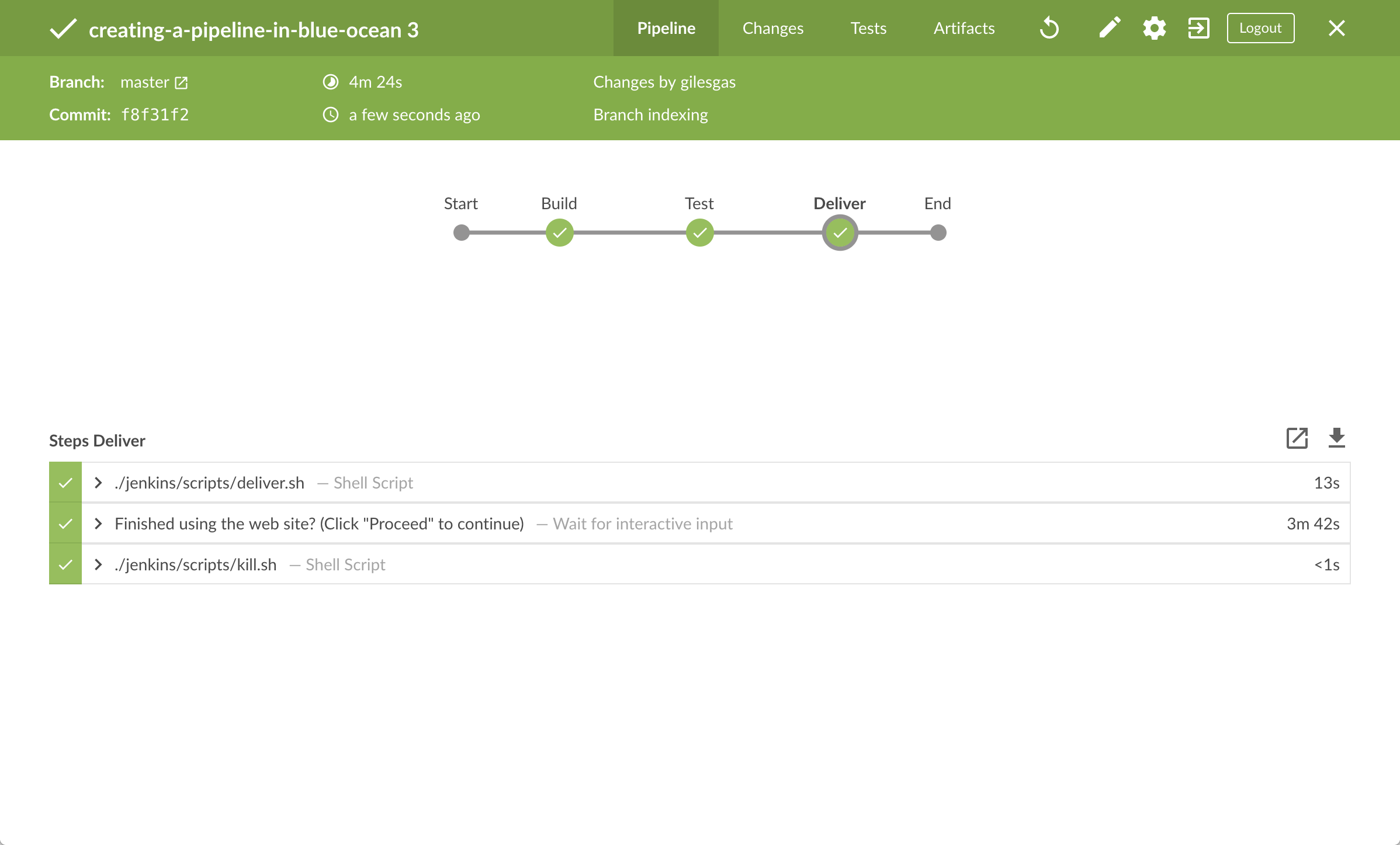

当你查看完页面/站点, 点击 Proceed 按钮以完成 流水线的执行。

-

点击右上方的 X 返回 Blue Ocean 的主界面, 它按时间顺序的反序的方式列出了流水线的历史运行记录。

总结

做得好!您刚刚使用Jenkins通过npm构建了一个简单的Node.js 和 React 应用程序!

您在上面创建的 "Build", "Test" 和 "Deliver" 阶段是使用Jenkins中的Maven构建更复杂的 Node.js 和 React应用程序以及与其他技术栈集成的Node.js 和React应用程序的基础。

由于Jenkins具有极高的可扩展性,因此可以对其进行修改和配置,以处理构建协调和自动化的几乎任何方面。

要详细了解Jenkins可以做什么,请查看:

-

教程概览 页面中的其他介绍教程。

-

用户手册 使用Jenkins的更多细节,例如 Pipelines (尤其是 Pipeline 语法) 和 Blue Ocean 界面。

-

Jenkins blog 资讯,其他教程和更新。

使用PyInstaller构建Python应用

Table of Contents

-

在 Docker中运行Jenkins

本教程将向你展示如何使用Jenkins编排构建一个使用 PyInstaller管理的简单Python应用程序。

如果你是一个 Python 开发者,对CI/CD概念不了解 或者你熟悉这些概念却不知道如何使用Jenkins完成构建,那么本教程很适合你。

示例Python应用(你可以从GitHub的示例仓库中获取)是一个输出两个值的和的命令行工具“add2vals”。如果至少有一个值是字符串,那么“add2vals”就会将这两个值都当做字符串并将其连接起来。 “cal”库“add2”函数(“add2vals”导入)伴随着一组单元测试。 这些测试是用pytest测试,以检查这个函数是否像预期那样工作并将测试结果保存到Junit XML报告中。

"add2vals"工具通过PyInstaller进行交付,PyInstaller将该工具转换成一个Linux的独立的可执行的文件, 你可以在没有Python的情况下通过Jenkins下载并执行该命令行。

Note: 与本文档的其他教程不同, 本教程需要下载大约500MB的Docker镜像数据。

Duration: 本教程需要花费20-40分钟的时间完成 (假设你已满足下文的 配置要求 )。 确切的耗时取决于你机器的性能, 以及你是否完成过在Docker中运行Jenkins 请参考另一个教程。

你可以在任何时间停止该教程,并从你离开的地方继续。

如果你已经运行了 其他教程, 你可以跳过下面的 配置要求 和 在Docker中运行 Jenkins 章节继续 fork示例仓库. (确保你已在本地安装了 Git 。) 如果你要重启 Jenkins, 只需遵照下面的重启指令 停止和重启 Jenkins 然后继续.。

配置要求

对于本教程,您将需要:

-

安装有macOS,Linux或Windows操作系统的机器,并拥有以下配置:

-

最小256MB内存, 推荐512MB以上。

-

10GB硬盘空间, 用于安装Jenkins,您的Docker镜像和容器。

-

-

安装有以下软件:

-

Docker - 在安装Jenkins页面的安装Docker章节阅读更多信息。 注意: 如果您使用Linux,本教程假定您没有以root用户的身份运行Docker命令,而是使用单个用户帐户访问本教程中使用的其他工具。

-

Git and optionally GitHub Desktop

-

在 Docker中运行Jenkins

在本教程中, 将Jenkins作为 Docker 容器并从 jenkinsci/blueocean Docker 镜像中运行。

要在 Docker中运行Jenkins, 请遵循下面的macOS 和 Linux 或 Windows相关文档说明进行操作。 .

你可以在 Docker和 Installing Jenkins 页面的 Downloading and running Jenkins in Docker部分阅读更多有关Docker容器和镜像概念的信息。

在 macOS 和 Linux 系统上

-

打开终端窗口

-

使用下面的

docker run命令运行jenkinsci/blueocean镜像作为Docker中的一个容器(记住,如果本地没有镜像,这个命令会自动下载):docker run \ --rm \ -u root \ -p 8080:8080 \ -v jenkins-data:/var/jenkins_home \ -v /var/run/docker.sock:/var/run/docker.sock \ -v "$HOME":/home \ jenkinsci/blueocean

将容器中的 /var/jenkins_home目录映射到 Docker volume ,并将其命名为jenkins-data。如果该卷不存在, 那么docker run命令会自动为你创建卷。将主机上的 $HOME目录 (即你的本地)映射到 (通常是/Users/目录) 到容器的/home目录。Note: 如果复制或粘贴上面的命令片段不起作用, 尝试复制和粘贴这个没有注释的版本:

docker run \ --rm \ -u root \ -p 8080:8080 \ -v jenkins-data:/var/jenkins_home \ -v /var/run/docker.sock:/var/run/docker.sock \ -v "$HOME":/home \ jenkinsci/blueocean

-

继续 安装向导。

在 Windows 系统

-

打开命令提示窗口。

-

使用下面的

docker run命令运行jenkinsci/blueocean镜像作为Docker中的一个容器(记住,如果本地没有镜像,这个命令会自动下载):docker run ^ --rm ^ -u root ^ -p 8080:8080 ^ -v jenkins-data:/var/jenkins_home ^ -v /var/run/docker.sock:/var/run/docker.sock ^ -v "%HOMEPATH%":/home ^ jenkinsci/blueocean

对这些选项的解释, 请参考上面的 macOS 和 Linux 说明。

-

继续安装向导。

访问 Jenkins/Blue Ocean Docker 容器

如果你有一些使用 Docker 的经验,希望或需要使用 docker exec 命令通过一个终端/命令提示符来访问 Jenkins/Blue Ocean Docker 容器, 你可以添加如 --name jenkins-tutorials 选项(与上面的 docker run ), 这将会给Jenkins/Blue Ocean Docker容器一个名字 "jenkins-tutorials"。

这意味着你可以通过 docker exec 命令访问Jenkins/Blue Ocean 容器(通过一个单独的终端 /命令提示窗口) ,例如:

docker exec -it jenkins-tutorials bash

安装向导

在你访问 Jenkins之前, 你需要执行一些快速的 "一次性" 步骤。

解锁 Jenkins

当你第一次访问一个新的 Jenkins 实例时, 要求你使用自动生成的密码对其进行解锁。

-

当在终端/命令提示窗口出现两组星号时, 浏览

http://localhost:8080并等待 Unlock Jenkins 页面出现。

-

再次从终端/命令提示窗口, 复制自动生成的字母数字密码(在两组星号之间)。

-

在 Unlock Jenkins 页面, 粘贴该密码到 Administrator password 字段并点击 Continue。

使用插件自定义 Jenkins

在 解锁 Jenkins后, Customize Jenkins 页面出现。

在该页面,点击 Install suggested plugins。

安装向导显示了正在配置的Jenkins的进程,以及建议安装的插件。这个过程肯需要几分钟。

创建第一个管理员用户

最后, Jenkins 要求创建你的第一个管理员用户。

-

当 Create First Admin User 页面出现, 在相应的字段中指定你的详细消息并点击 Save and Finish。

-

当 Jenkins is ready 页面出现, 点击 Start using Jenkins。 Notes:

-

该页面可能表明 Jenkins is almost ready! 如果相反, 点击 Restart.

-

如果该页面在一分钟后没有自动刷新, 使用你的web浏览器手动刷新。

-

-

如果需要,登录 Jenkins , 你就可以开始使用 Jenkins了!

停止和重启 Jenkins

在本教程的其余部分, 你可以通过在终端/命令提示窗口输入 Ctrl-C停止 Jenkins/Blue Ocean Docker 容器,你可以从中运行<>的 docker run ... 命令。

要重启Jenkins/Blue Ocean Docker 容器:

-

在上面的 macOS,Linux 或 Windows上运行相同的

docker run ...命令 。 Note: 如果有更新的话,该进程会更新jenkinsci/blueoceanDocker 镜像。 -

浏览

http://localhost:8080。 -

等待直到登录页面出现并登陆。

Fork 和 clone GitHub上的示例仓库

通过应用的源代码的示例仓库 fork 到你自己的GitHub账号中,然后在本地clone这个fork的方式,从GitHub上获取 "add" Python 应用。

-

确保你拥有 GitHub 账号。 如果没有GitHub账号, 在 GitHub 网站注册一个免费的账号。

-

在 GitHub上Fork

simple-python-pyinstaller-app到你本地的 GitHub 账号。在这个过程中如果你需要帮助, 请参考GitHub网站的 Fork A Repo 文档了解更多信息。 -

Clone 你 fork的

simple-python-pyinstaller-app仓库 (在 GitHub 上) 到你本地的机器。要开始这个过程, 请执行以下操作 (你的操作系统的用户账号为 `` ):-

如果你的机器上安装了 GitHub 桌面应用程序:

-

在 GitHub上, 点击你fork的仓库的 Clone or download 按钮, 然后 Open in Desktop.

-

再 GitHub 桌面, 在点击 Clone a Repository 对话框的击 Clone 之前, 确保 Local Path 是:

-

macOS操作系统

/Users//Documents/GitHub/simple-python-pyinstaller-app -

Linux操作系统

/home//GitHub/simple-python-pyinstaller-app -

Windows操作系统

C:\Users\\Documents\GitHub\simple-python-pyinstaller-app

-

-

-

另外:

-

打开一个终端/命令行提示符 ,

cd到对应的目录 :-

macOS操作系统 -

/Users//Documents/GitHub/ -

Linux操作系统 -

/home//GitHub/ -

Windows操作系统 -

C:\Users\\Documents\GitHub\(通过使用 Git bash 命令行窗口,而不是通用的 Microsoft 命令提示符)

-

-

运行一下命令来继续/完成 clone 你 fork 到的仓库

git clone https://github.com/YOUR-GITHUB-ACCOUNT-NAME/simple-python-pyinstaller-app你的GitHub账号的名称是YOUR-GITHUB-ACCOUNT-NAME。

-

-

使用Jenkins构建你的流水线项目

-

回到 Jenkins, 如果需要的话再次登录并点击 Welcome to Jenkins! 下的 create new jobs + Note: 如果你没有看到上述按钮, 点击左上的 New Item 。

-

在 Enter an item name 域中, 指定你新的 Pipeline 项目的名称 (比如

simple-python-pyinstaller-app)。 -

向下滚动并点击 Pipeline, 点击页面底部的 OK 。

-

( Optional ) 在下一页的 Description 域中填写你的 Pipeline 的描述 (比如

An entry-level Pipeline demonstrating how to use Jenkins to build a simple Python application with PyInstaller.) -

点击页面顶部的 Pipeline 选项卡 向下滚动到 Pipeline 部分。

-

从 Definition 域中, 选择 Pipeline script from SCM 选项。 该选项命令 Jenkins 从源控制管理(SCM)获取你的流水线, 这会是你clone到本地的 Git 仓库。

-

从 the SCM 域中, 选择 Git。

-

在 Repository URL 域中, 填写你本地clone的仓库 above的目录路径, 从你的主机的用户账户/主目录, 映射到Jenkins容器的

/home目录 - 即-

macOS -

/home/Documents/GitHub/simple-python-pyinstaller-app -

Linux -

/home/GitHub/simple-python-pyinstaller-app -

Windows -

/home/Documents/GitHub/simple-python-pyinstaller-app

-

-

点击 Save 保存你的新的流水线项目。你现在准备生成你的

Jenkinsfile,检查你clone到本地 的Git 仓库。

将初始流水线创建为 Jenkinsfile

你现在准备构建你的流水,它将在Jenkins中使用PyInstaller自动构建你的 Python 应用。你的流水线将会被创建作为 Jenkinsfile, 它将会被提交到你clone到本地的 Git 仓库 (simple-python-pyinstaller-app)。

这是 "流水线即代码"的基础, 他将连续支付流水线作为应用程序的一部,像其他代码一样进行版本化和审查。 了解更多在 用户手册的Pipeline 和 Using a Jenkinsfile 章节。

首先, 创建一个带有 "Build" 阶段的初始流水线, 该阶段为你的应用执行整个生产过程的第一部分。 "Build" 部分 下载一个 Python Docker 镜像并将它作为 Docker 容器运行, 它将 你的简单的 Python 应用编译成字节码。

-

使用你最称手的文本编辑器或 IDE, 在你的本地

simple-python-pyinstaller-appGit仓库的根目录下生成并保存一个新的名为Jenkinsfile的文本文件。 -

复制并粘贴下面的声明式流水线代码到你空的

Jenkinsfile文件中:pipeline { agent none stages { stage('Build') { agent { docker { image 'python:2-alpine' } } steps { sh 'python -m py_compile sources/add2vals.py sources/calc.py' } } } }流水线代码块顶部的 agent部分指定的的none参数意味着不会为 整个流水线的执行分配全局代理 ,并且每个stage指令必须制定自己的agent部分。定义名为 Build的stage(指令) ,它出现在 Jenkins UI中。image参数 (参考agent部分的docker参数) 下载python:2-alpineDocker image (如果他在你的主机上不可用) 并将它作为一个独立的容器运行。 这意味着:你将拥有独立的运行在Docker的Jenkins 和 Python 容器。Python 容器成为 Jenkins 用来运行你流水线项目的Build阶段的 agent 。 然而, 这个容器寿命较短 - 他的生命周期只是 你的Build阶段的执行的时间. <4>sh步骤 (参考steps章节) 运行 Python 命令将你的应用和它的calc库 转换成字节码文件 (每个都有.pyc扩展), 被放在sources工作区目录 (在Jenkins容器的/var/jenkins_home/workspace/simple-python-pyinstaller-app目录下)。 -

保存并提交你编辑的

Jenkinsfile到本地simple-python-pyinstaller-appGit 仓库。 比如在simple-python-pyinstaller-app仓库, 运行命令:git add .然后git commit -m "Add initial Jenkinsfile" -

再次回到 Jenkins , 如果需要的话再次登录并点击左边的 Open Blue Ocean 来访问 Jenkins的 Blue Ocean 界面。

-

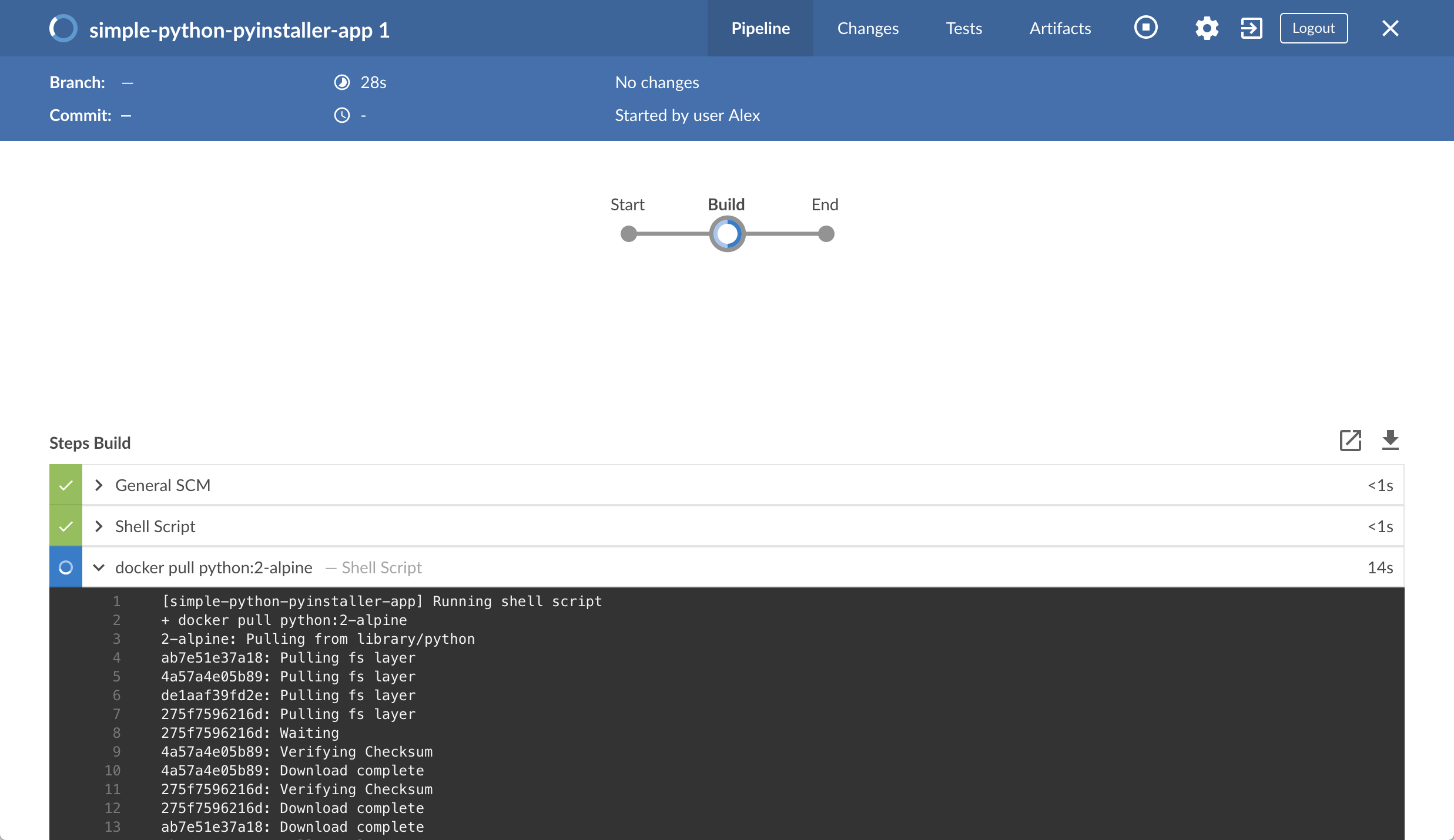

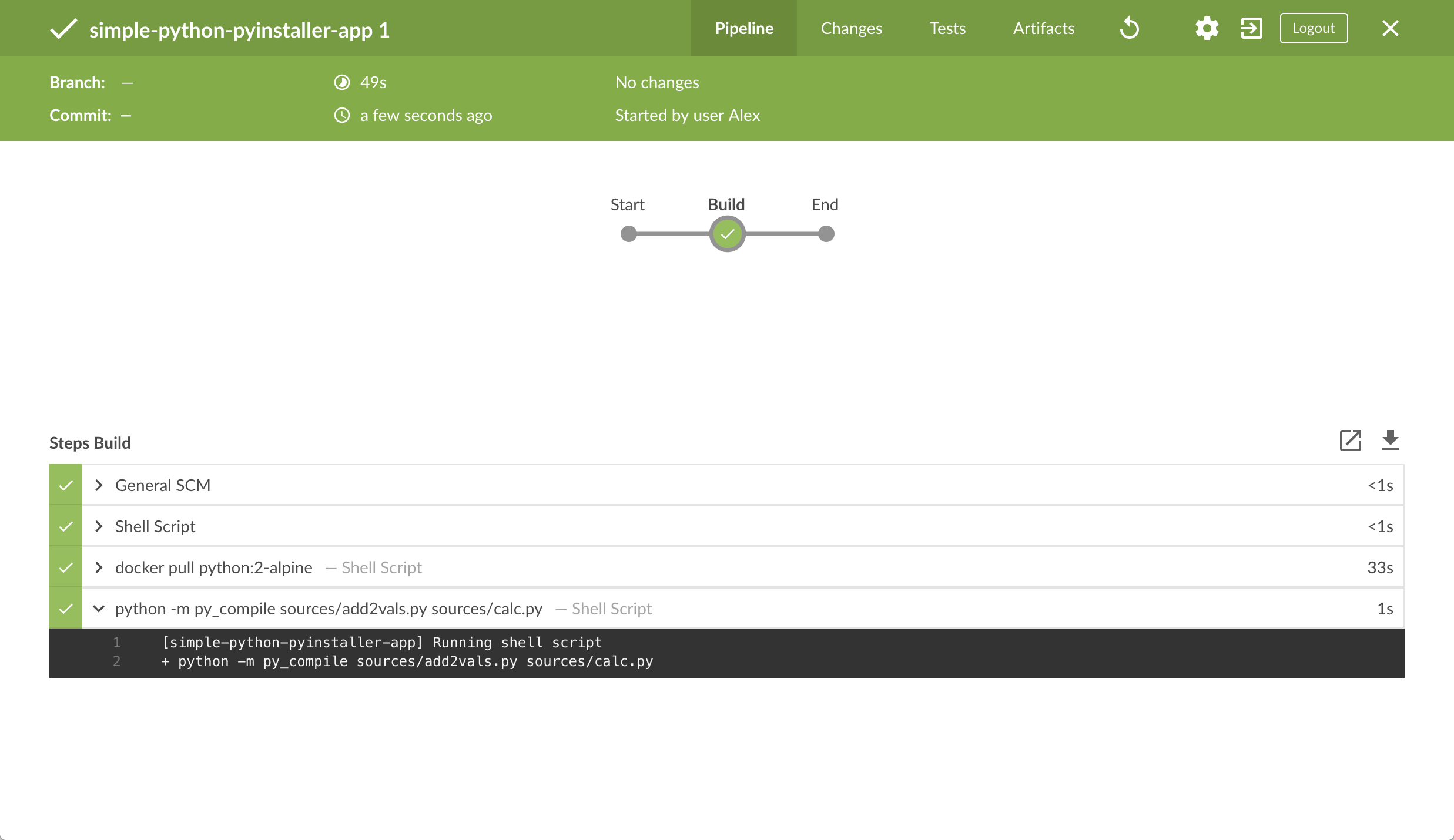

在 This job has not been run 消息框, 点击 Run, 然后快速的点击出现在右下方的 OPEN 链接观察Jenkins 运行你的流水线项目. 如果你不能点击 OPEN 链接, 点击 Blue Ocean 主界面的行来使用这一特性。 Note: 完成第一次的运行你需要等几分钟。 在对你本地的

simple-python-pyinstaller-appGit 仓库进行clone后, Jenkins:-

最初将这个项目在代理上排队运行。

-

下载 Python Docker 镜像并在 Docker上的容器中运行它.

-

在 Python 容器运行

Build阶段 (定义在Jenkinsfile文件中)。 在这期间, Python使用py_compile组件将你的Python应用的代码和它的calc库编译成字节码, 它被保存在sources工作区目录(在 Jenkins 的主目录里)。

如果Jenkins编译Python应用成功,Blue Ocean界面会变成绿色 。

-

-

点击右上方的 X 回到 Blue Ocean 主界面。

为你的流水线添加测试阶段

-

回到你的文本编辑器/IDE ,打开

Jenkinsfile文件。 -

复制并粘贴下面的声明式流水线语法到

Jenkinsfile的Build阶段下面:stage('Test') { agent { docker { image 'qnib/pytest' } } steps { sh 'py.test --verbose --junit-xml test-reports/results.xml sources/test_calc.py' } post { always { junit 'test-reports/results.xml' } } }结果是:

pipeline { agent none stages { stage('Build') { agent { docker { image 'python:2-alpine' } } steps { sh 'python -m py_compile sources/add2vals.py sources/calc.py' } } stage('Test') { agent { docker { image 'qnib/pytest' } } steps { sh 'py.test --verbose --junit-xml test-reports/results.xml sources/test_calc.py' } post { always { junit 'test-reports/results.xml' } } } } }定义名为 Test的stage(指令) ,它出现在Jenkins UI中。This image参数 (参考agent部分的docker参数) 下载qnib:pytestDocker image (如果它在你的机器上不可用)并将它作为一个独立的容器运行。 这意味着:你将拥有独立的运行在Docker的Jenkins 和 Pytest 容器。pytest 容器成为Jenkins 用来运行你流水线项目的Test阶段的 agent。这个容器的生命周期可以持续你的Test阶段的执行过程。这里的 sh步骤 (参考steps章节) 在sources/test_calc.py执行 pytest的py.test命令 , 它在"calc" 库的add2函数 (被 简单的 Python 应用的add2vals使用)运行了一系列的单元测试 (定义在test_calc.py) 。The:--verbose选项使py.test在Jenkinds/Blue Ocean界面生成详细输出。--junit-xml test-reports/results.xml选项使py.test生成 JUnit XML 报告,它被保存到test-reports/results.xml(在Jenkins容器的/var/jenkins_home/workspace/simple-python-pyinstaller-app目录下 )。这里的 junit步骤 (由 JUnit Plugin提供) 归档了 JUnit XML 报告 (由py.test命令生成) 并通过Jenkins界面公开结果。在 Blue Ocean, 可以通过流水线运行的 Tests 页面访问该结果。post部分的always条件包含junit阶段, 确保不论阶段的输出是什么,步骤 always 在Test阶段的at the completion 被执行。 -

保存并提交你编辑的

Jenkinsfile到本地的simple-python-pyinstaller-appGit 仓库。比如在simple-python-pyinstaller-app目录下, 运行这些命令:git stage .然后git commit -m "Add 'Test' stage" -

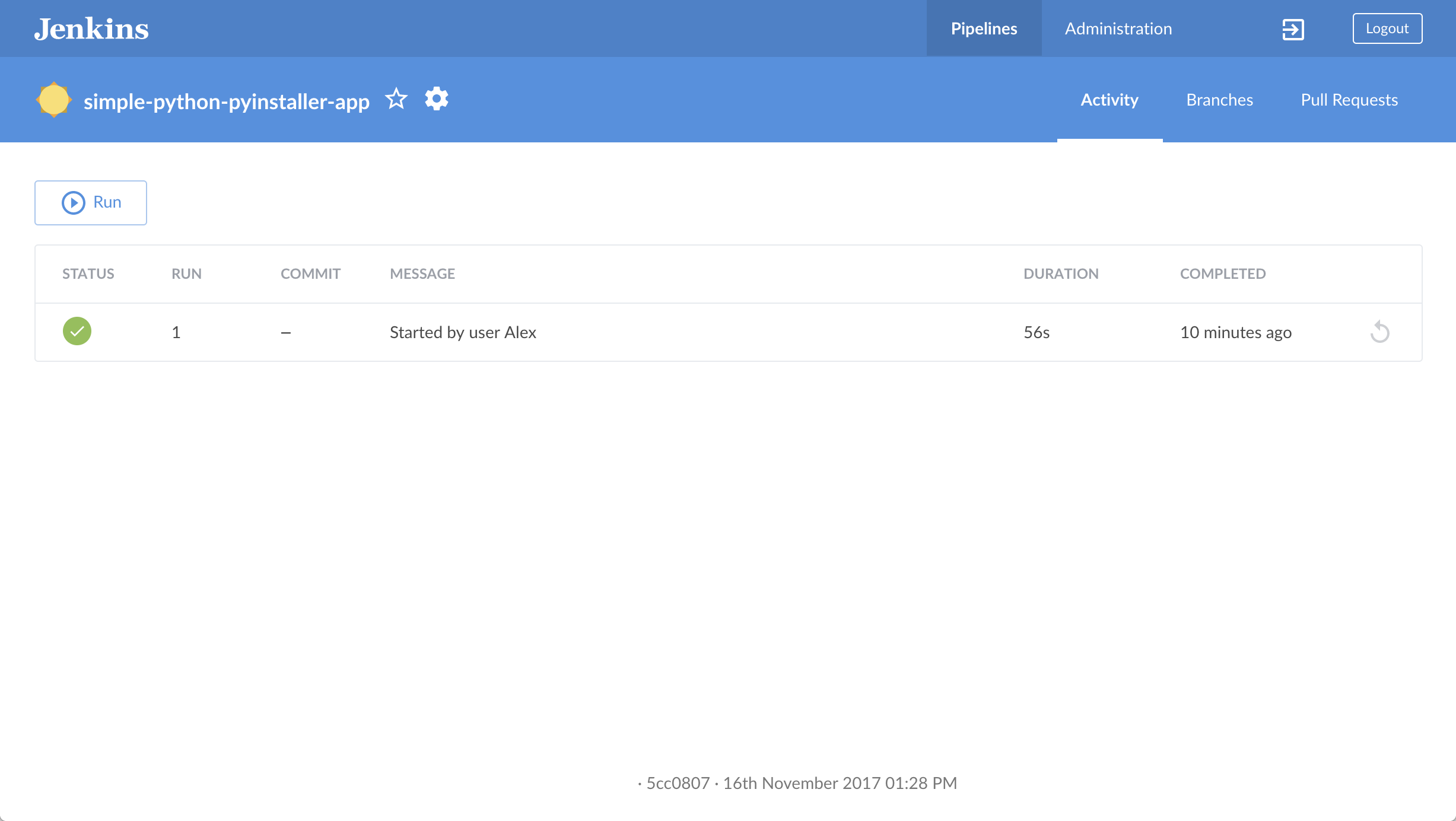

再次回到 Jenkins , 如果必要再次登录并进入 Jenkins的Blue Ocean 界面。

-

点击左上方的 Run , 然后快速的点击出现在右下方的 OPEN 链接来查看 Jenkins 运行你改进后的流水线项目。如果你不能点击 OPEN 链接, 点击Blue Ocean主界面的 top 行 来访问这一特性。 Note: 可能需要几分钟来下载

qnib:pytestDocker 镜像 (如果之前没做过)。 如果你改进后的流水线项目运行成功, Blue Ocean 界面将会是这样的. 另外注意 "Test" 阶段。 你可以点击之前的 "Build" 阶段循环的访问该阶段的输出。

-

点击右上方的 X 返回到 Blue Ocean 主界面。

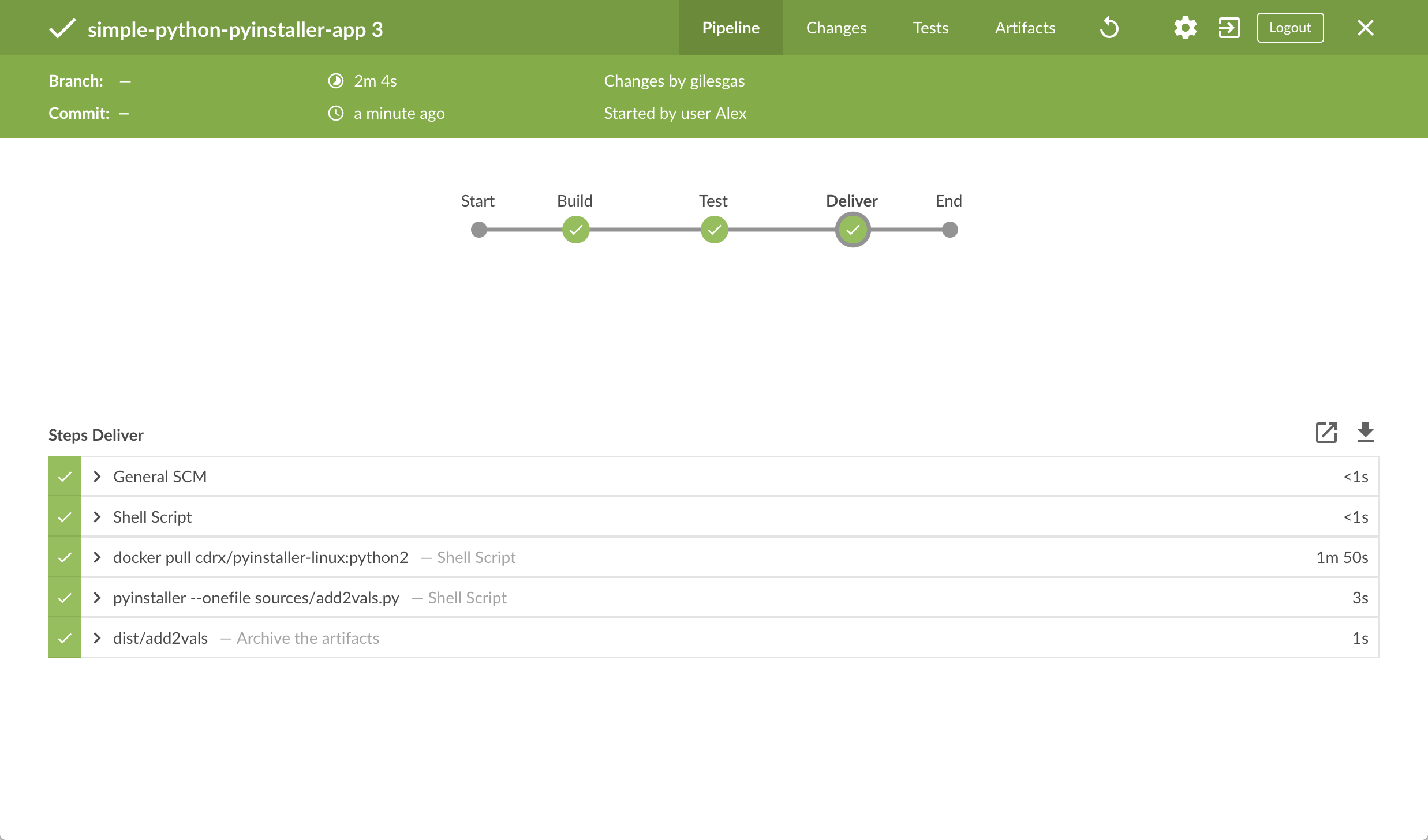

给你的流水线添加最终交付阶段

-

回到你的文本编辑器/IDE 并打开

Jenkinsfile文件。 -

复制并粘贴下面的声明式流水线语法到

Jenkinsfile的Test阶段下方:stage('Deliver') { agent { docker { image 'cdrx/pyinstaller-linux:python2' } } steps { sh 'pyinstaller --onefile sources/add2vals.py' } post { success { archiveArtifacts 'dist/add2vals' } } }结果是:

pipeline { agent none stages { stage('Build') { agent { docker { image 'python:2-alpine' } } steps { sh 'python -m py_compile sources/add2vals.py sources/calc.py' } } stage('Test') { agent { docker { image 'qnib/pytest' } } steps { sh 'py.test --verbose --junit-xml test-reports/results.xml sources/test_calc.py' } post { always { junit 'test-reports/results.xml' } } } stage('Deliver') { agent { docker { image 'cdrx/pyinstaller-linux:python2' } } steps { sh 'pyinstaller --onefile sources/add2vals.py' } post { success { archiveArtifacts 'dist/add2vals' } } } } }定义名为 Deliver的stage(指令) 它出现在Jenkins UI中。这里的 image参数 (参考agent章节的docker参数) 下载cdrx/pyinstaller-linuxDocker image (如果它在你的机器上不可用) 并且将它作为一个独立的容器运行。这意味着:你有一个独立的在Docker中运行的 Jenkins 和 PyInstaller (for Linux) 容器。PyInstaller 容器成为Jenkins用来运行流水线项目的Deliver阶段的 agent。该容器的周期持续Deliver阶段的执行过程。 <3>sh步骤 (参考steps部分) 在你的简单的Python应用中执行pyinstaller命令 (在 PyInstaller 容器中)。将你的add2vals.pyPython 应用程序打包成一个 独立的可执行的文件 (via the--onefileoption) 并且输出该文件到dist工作区目录 (在 Jenkins 主目录。 虽然这一步骤有一个单一的命令组成, 在通用原则下, 你最好保持你的流水线代码 (也就是Jenkinsfile) 尽可能的整洁并将更复杂的构建步骤 (特别是包含两个及以上步骤的阶段) 放在单独的像deliver.sh文件一样的shell脚本文件中。 这最终会让你的流水线代码的维护变得简单,尤其是在你的流水线更复杂的情况下。 <4>archiveArtifacts步骤 (作为 Jenkins 核心的一部分被提供) 对独立可执行文件进行归档 (由 Jenkins 主工作目录下的dist/add2vals的pyinstaller命令生成) 并通过aJenkins界面公开该文件。 在Blue Ocean, 像这样的存档组件可以通过流水线运行 Artifacts 页面进行访问。post部分的success条件 c包含archiveArtifacts步骤, 确保步骤被执行 at the completion of theDeliverstage only if this stage completed successfully. -

保存并提交你编辑的

Jenkinsfile到本地的simple-python-pyinstaller-appGit 仓库。 比如在simple-python-pyinstaller-app仓库里, 运行这些命令:git stage .然后git commit -m "Add 'Deliver' stage" -

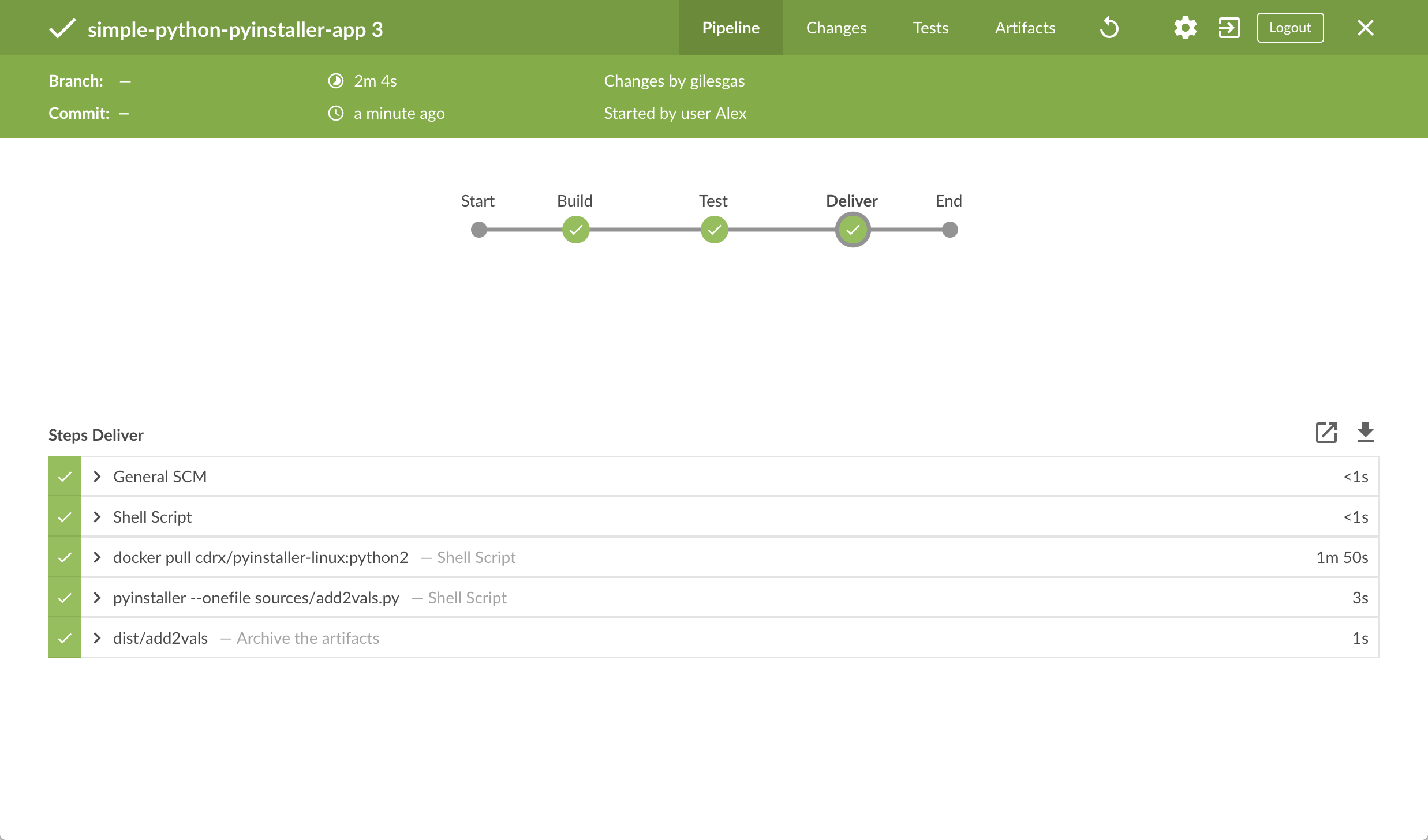

再次回到 Jenkins, 如果必要的话再次登录并进入 Jenkins的 Blue Ocean 界面。

-

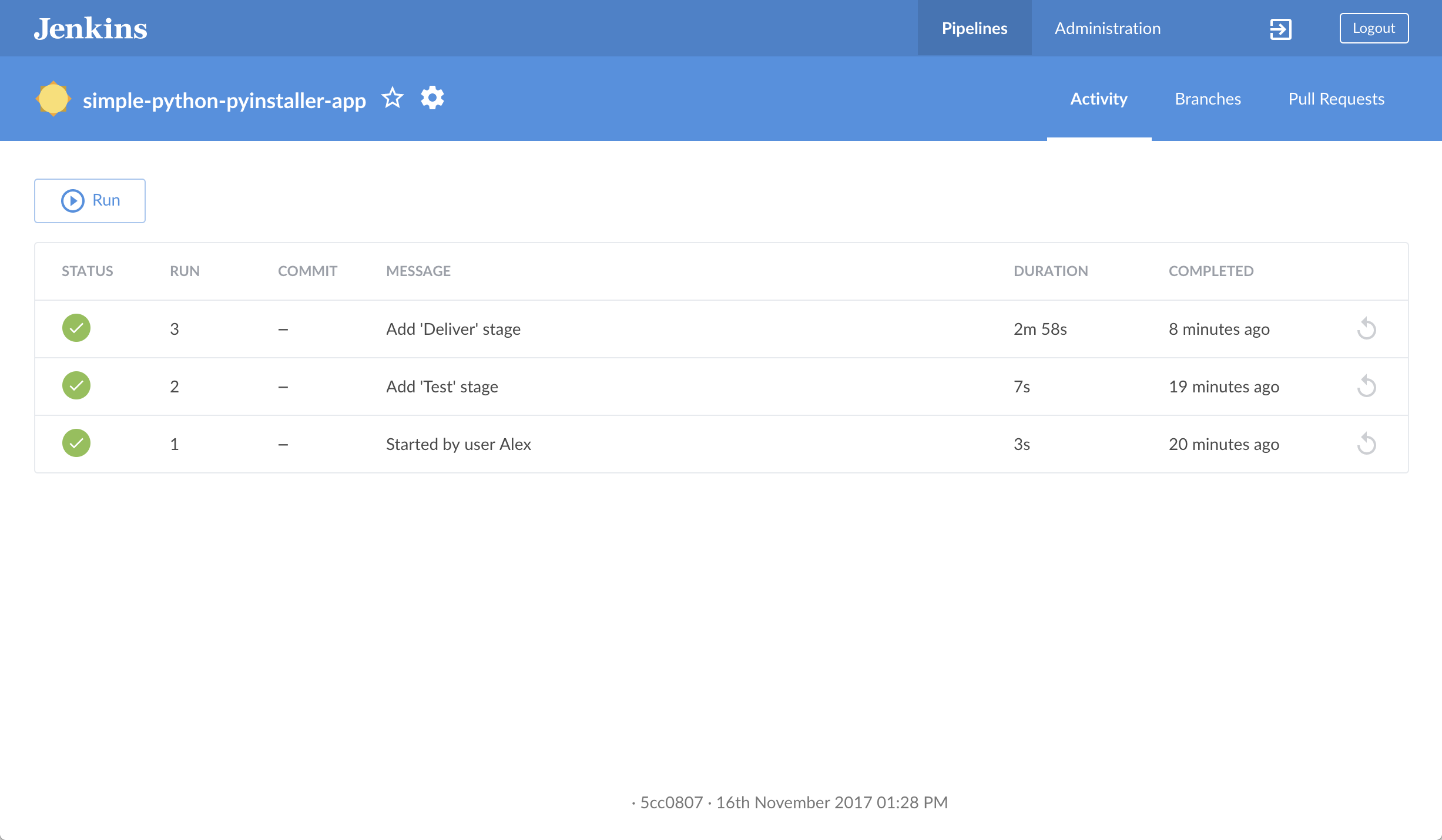

点击左上方的 Run, 然后快速的点击出现在右下方的 OPEN 链接来查看 Jenkins 运行你改进后的流水线项目。 如果你点击不了 OPEN 链接, 点击Blue Ocean 界面 top 行 来使用这一特性。 Note: 可能需要几分钟来下载

cdrx/pyinstaller-linuxDocker 镜像 (如果之前没有下载过)。+ 如果你改进后的流水线项目运行成功, Blue Ocean 界面应该是这样的。 另外注意 "Deliver" 阶段。 点击之前的 "Test" 和 "Build" 阶段循环的去访问这些阶段的输出。

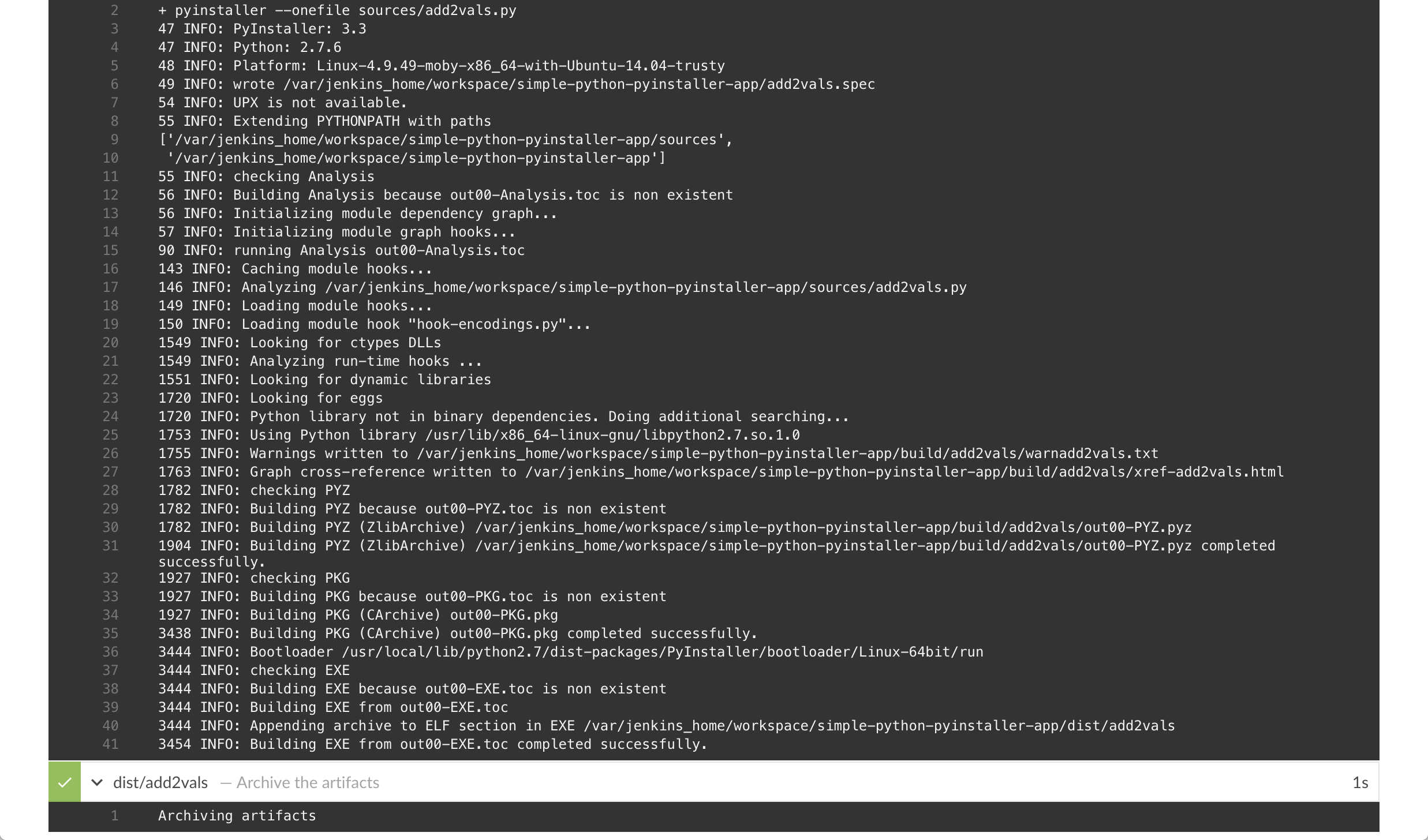

"Deliver" 阶段的输出结果应该如下所示, 向你展示了 PyInstaller 将 Python 应用打包成一个简单的独立可执行文件的结果。

-

点击右上方的 X 返回到Blue Ocean 的主界面, 他按照时间顺序的反序的方式列出了你的流水线运行的历史记录。

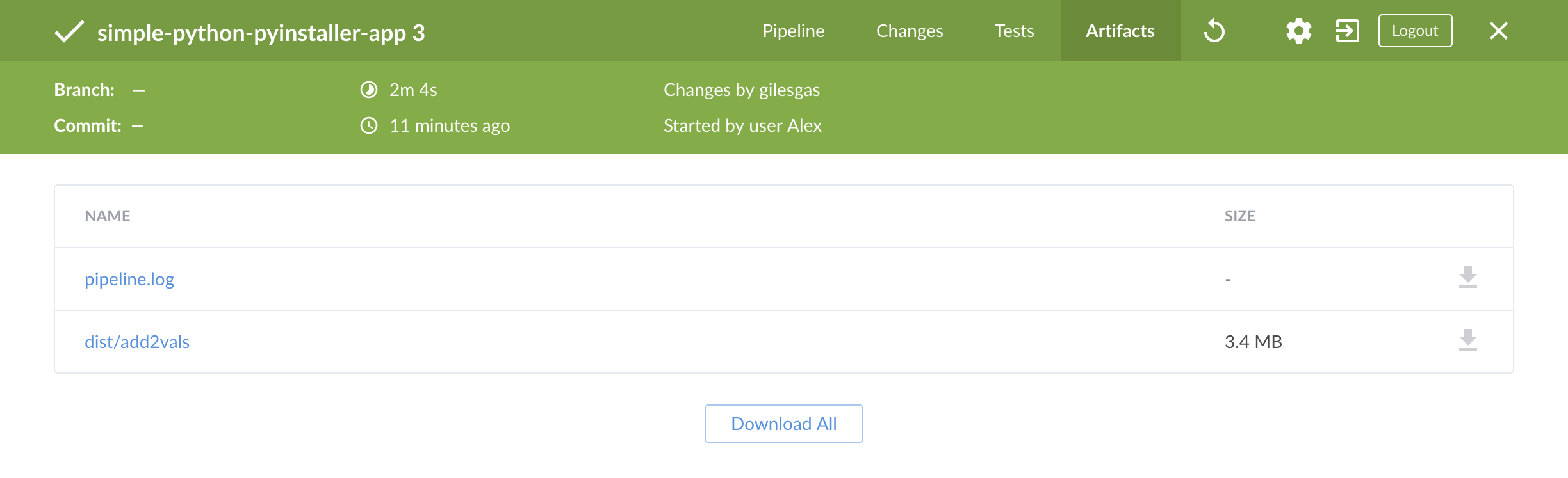

跟踪 (可选)

如果你是用的是 Linux系统, 你可以尝试着运行在你本地机器上生成的带有PyInstaller的 add2vals 应用 。 要做到这一点:

-

从 Blue Ocean 的主界面, 访问你above的最后一次的运行的流水线 。 要做到这一点, 点击Blue Ocean的 Activity页面上的顶部行(表示最近一次的流水线运行) 。

-

在流水线运行的结果页面, 点击右上方的 Artifacts 访问 Artifacts 页面。

-

在工件列表中, 点击dist/add2vals 工件项最右边的向下箭头图标下载独立可执行文件到 浏览器的 "下载" 目录中。

-

回到操作系统的终端,

cd到浏览器的 "Downloads" 目录。 -

使

add2vals文件可执行 - 也就是chmod a+x add2vals -

运行命令

./add2vals并且追踪你的应用发出的指示。

总结

做得好!您刚刚使用Jenkins构建了一个简单的Python 应用程序!

您在上面创建的 "Build", "Test" 和 "Deliver" 阶段是在Jenkins中构建更复杂的 Python应用程序以及与其他技术栈集成的Python应用程序的基础。

由于Jenkins具有极高的可扩展性,因此可以对其进行修改和配置,以处理构建协调和自动化的几乎任何方面。

要详细了解Jenkins可以做什么,请查看:

-

教程概览 页面中的其他介绍教程。

-

用户手册 使用Jenkins的更多细节,例如 Pipelines (尤其是 Pipeline 语法) 和 Blue Ocean 界面。

-

Jenkins blog 资讯,其他教程和更新。

使用Blue Ocean生成Pipeline

Table of Contents

-

在 Docker中运行Jenkins

该教程展示如何使用Jenkins的 Blue Ocean 特性生成一个流水线,该流水线将协调构建一个简单的应用程序。

在学习本教程前, 建议您先从Tutorials overview 页面至少浏览一组入门教程来熟悉CI/CD 概念 (与你 最熟悉的技术栈有) 以及这些概念是如何在Jenkins中实现的。 Jenkins.

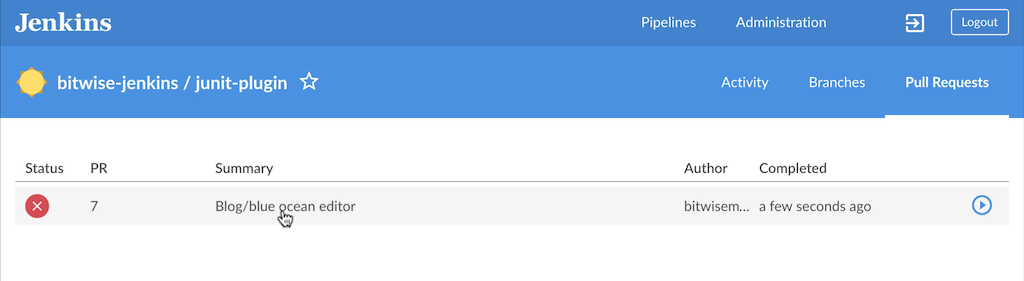

本教程使用与Build a Node.js and React app with npm 教程相同的应用程序 . 因此, 你这次将完全通过Blue Ocean构建相同的应用程序。 自从 Blue Ocean 提供了简化的 Git处理经验, 你将直接与 GitHub上的仓库进行交互 (相对于该存储库的本地clone)。

Duration: 本教程需花费 20-40 分钟 (假设你已经 完成下述的 配置要求 )。 确切的时间取决于你的机器的运行速度 和是否你已经在另一个教程中 run Jenkins in Docker。

你可以随时停止本教程,并且从你离开的地方继续 。

如果你已经完成 另一个教程, 你可以跳过下面的 配置要求 和 Run Jenkins in Docker部分并继续 fork示例仓库。如果你需要重启Jenkins,只需遵循停止和重启 Jenkins中的重启指示然后继续。

配置要求

对于本教程,您将需要:

-

安装有macOS,Linux或Windows操作系统的机器,并拥有以下配置:

-

最小256MB内存, 推荐512MB以上。

-

10GB硬盘空间, 用于安装Jenkins,您的Docker镜像和容器。

-

-

安装有以下软件:

在 Docker中运行Jenkins

在本教程中, 将Jenkins作为 Docker 容器并从 jenkinsci/blueocean Docker 镜像中运行。

要在 Docker中运行Jenkins, 请遵循下面的macOS 和 Linux 或 Windows相关文档说明进行操作。 .

你可以在 Docker和 Installing Jenkins 页面的 Downloading and running Jenkins in Docker部分阅读更多有关Docker容器和镜像概念的信息。

在 macOS 和 Linux 系统上

-

打开终端窗口

-

使用下面的

docker run命令运行jenkinsci/blueocean镜像作为Docker中的一个容器(记住,如果本地没有镜像,这个命令会自动下载):docker run \ --rm \ -u root \ -p 8080:8080 \ -v jenkins-data:/var/jenkins_home \ -v /var/run/docker.sock:/var/run/docker.sock \ -v "$HOME":/home \ jenkinsci/blueocean

将容器中的 /var/jenkins_home目录映射到 Docker volume ,并将其命名为jenkins-data。如果该卷不存在, 那么docker run命令会自动为你创建卷。将主机上的 $HOME目录 (即你的本地)映射到 (通常是/Users/目录) 到容器的/home目录。Note: 如果复制或粘贴上面的命令片段不起作用, 尝试复制和粘贴这个没有注释的版本:

docker run \ --rm \ -u root \ -p 8080:8080 \ -v jenkins-data:/var/jenkins_home \ -v /var/run/docker.sock:/var/run/docker.sock \ -v "$HOME":/home \ jenkinsci/blueocean

-

继续 安装向导。

在 Windows 系统

-

打开命令提示窗口。

-

使用下面的

docker run命令运行jenkinsci/blueocean镜像作为Docker中的一个容器(记住,如果本地没有镜像,这个命令会自动下载):docker run ^ --rm ^ -u root ^ -p 8080:8080 ^ -v jenkins-data:/var/jenkins_home ^ -v /var/run/docker.sock:/var/run/docker.sock ^ -v "%HOMEPATH%":/home ^ jenkinsci/blueocean

对这些选项的解释, 请参考上面的 macOS 和 Linux 说明。

-

继续安装向导。

访问 Jenkins/Blue Ocean Docker 容器

如果你有一些使用 Docker 的经验,希望或需要使用 docker exec 命令通过一个终端/命令提示符来访问 Jenkins/Blue Ocean Docker 容器, 你可以添加如 --name jenkins-tutorials 选项(与上面的 docker run ), 这将会给Jenkins/Blue Ocean Docker容器一个名字 "jenkins-tutorials"。

这意味着你可以通过 docker exec 命令访问Jenkins/Blue Ocean 容器(通过一个单独的终端 /命令提示窗口) ,例如:

docker exec -it jenkins-tutorials bash

安装向导

在你访问 Jenkins之前, 你需要执行一些快速的 "一次性" 步骤。

解锁 Jenkins

当你第一次访问一个新的 Jenkins 实例时, 要求你使用自动生成的密码对其进行解锁。

-

当在终端/命令提示窗口出现两组星号时, 浏览

http://localhost:8080并等待 Unlock Jenkins 页面出现。

-

再次从终端/命令提示窗口, 复制自动生成的字母数字密码(在两组星号之间)。

-

在 Unlock Jenkins 页面, 粘贴该密码到 Administrator password 字段并点击 Continue。

使用插件自定义 Jenkins

在 解锁 Jenkins后, Customize Jenkins 页面出现。

在该页面,点击 Install suggested plugins。

安装向导显示了正在配置的Jenkins的进程,以及建议安装的插件。这个过程肯需要几分钟。

创建第一个管理员用户

最后, Jenkins 要求创建你的第一个管理员用户。

-

当 Create First Admin User 页面出现, 在相应的字段中指定你的详细消息并点击 Save and Finish。

-

当 Jenkins is ready 页面出现, 点击 Start using Jenkins。 Notes:

-

该页面可能表明 Jenkins is almost ready! 如果相反, 点击 Restart.

-

如果该页面在一分钟后没有自动刷新, 使用你的web浏览器手动刷新。

-

-

如果需要,登录 Jenkins , 你就可以开始使用 Jenkins了!

停止和重启 Jenkins

在本教程的其余部分, 你可以通过在终端/命令提示窗口输入 Ctrl-C停止 Jenkins/Blue Ocean Docker 容器,你可以从中运行<>的 docker run ... 命令。

要重启Jenkins/Blue Ocean Docker 容器:

-

在上面的 macOS,Linux 或 Windows上运行相同的

docker run ...命令 。 Note: 如果有更新的话,该进程会更新jenkinsci/blueoceanDocker 镜像。 -

浏览

http://localhost:8080。 -

等待直到登录页面出现并登陆。

Fork GitHub上的示例仓库

Fork GitHub上的示例 "Welcome to React" Node.js 和 React 应用到你自己的 GitHub 账户 。

-

确保你有 GitHub 账户。 如果没有, 在 GitHub 网站注册一个免费账号。

-

在GitHub Fork

creating-a-pipeline-in-blue-ocean到本地的 GitHub 账号。 在这个过程中如果需要帮助, 请参考GitHub网站的 Fork A Repo 文档 了解更多信息。 Note: 这是不同于使用npm构建 Node.js 和 React 应用程序 教程的另一个仓库。 尽管这些仓库包含相同的应用程序代码, 但请确保在继续之前正确的fork 和使用 。

在Blue Ocean创建你的流水线项目

-

回到Jenkins并进入Blue Ocean 界面。要做到这一点, 你应该:

-

浏览

http://localhost:8080/blue并登陆 或 -

已浏览

http://localhost:8080/且登录后在左侧点击 Open Blue Ocean 。

-

-

在Blue Ocean界面中心的 Welcome to Jenkins , 点击 Create a new Pipeline 来启动流水线创建向导。 Note: 如果你没有看到这个框, 点击右上方的 New Pipeline 。

-

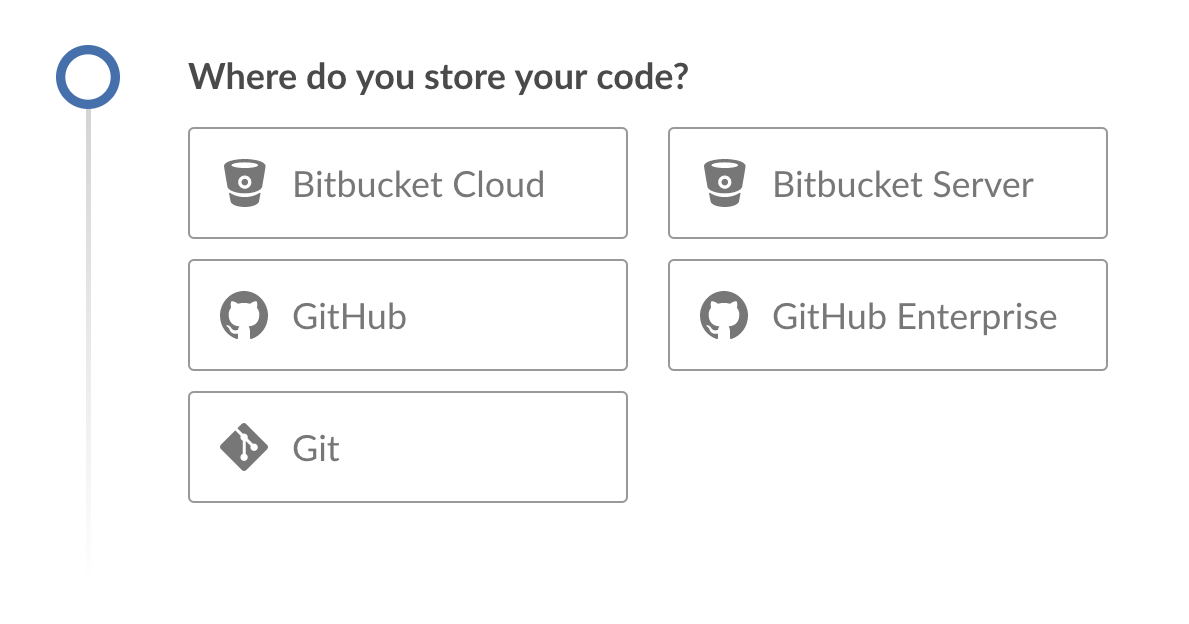

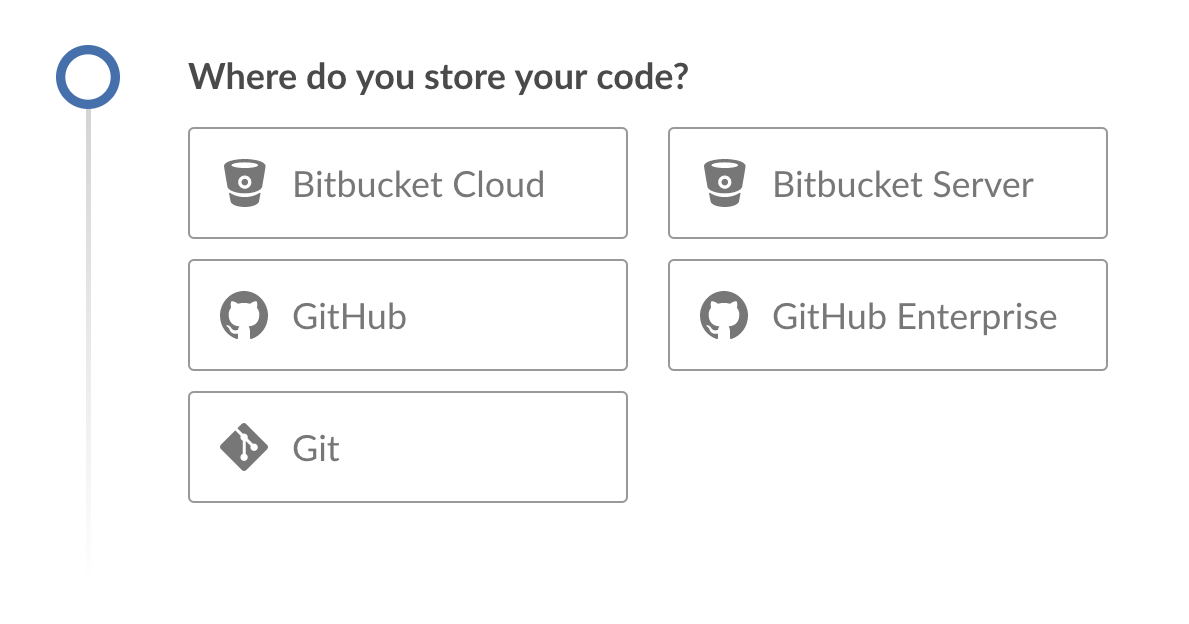

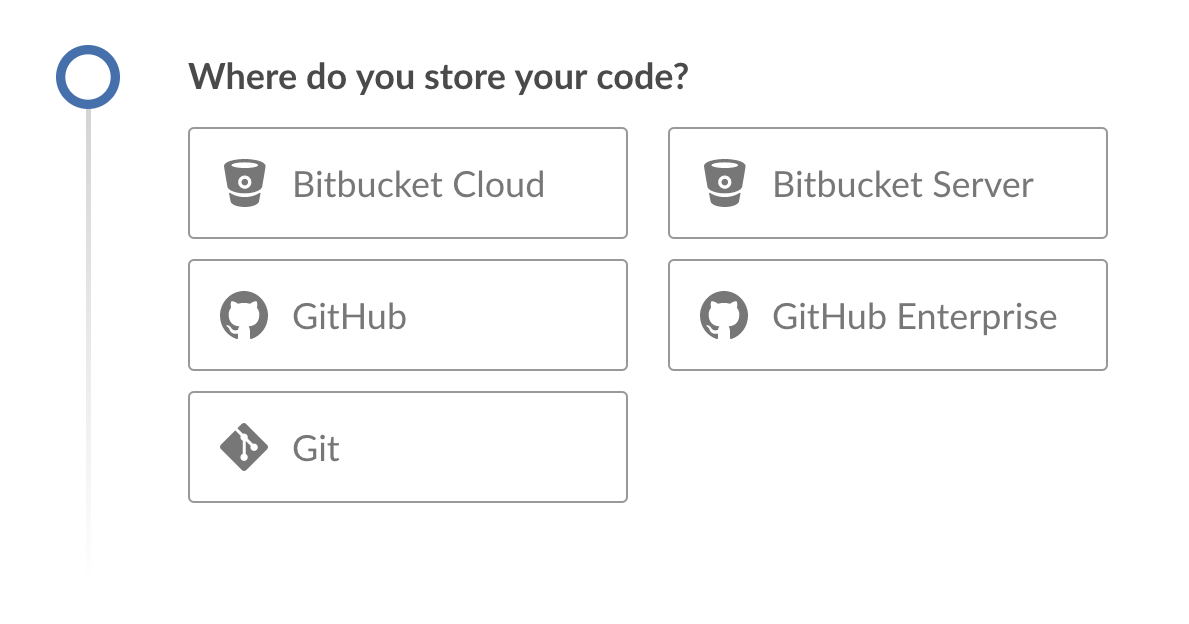

在 Where do you store your code?, 点击 GitHub。

-

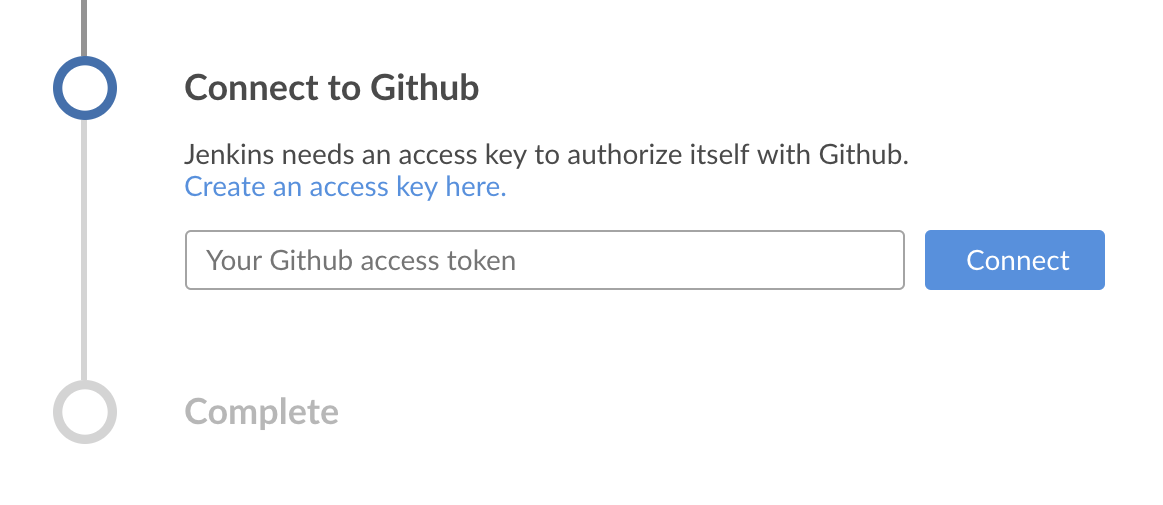

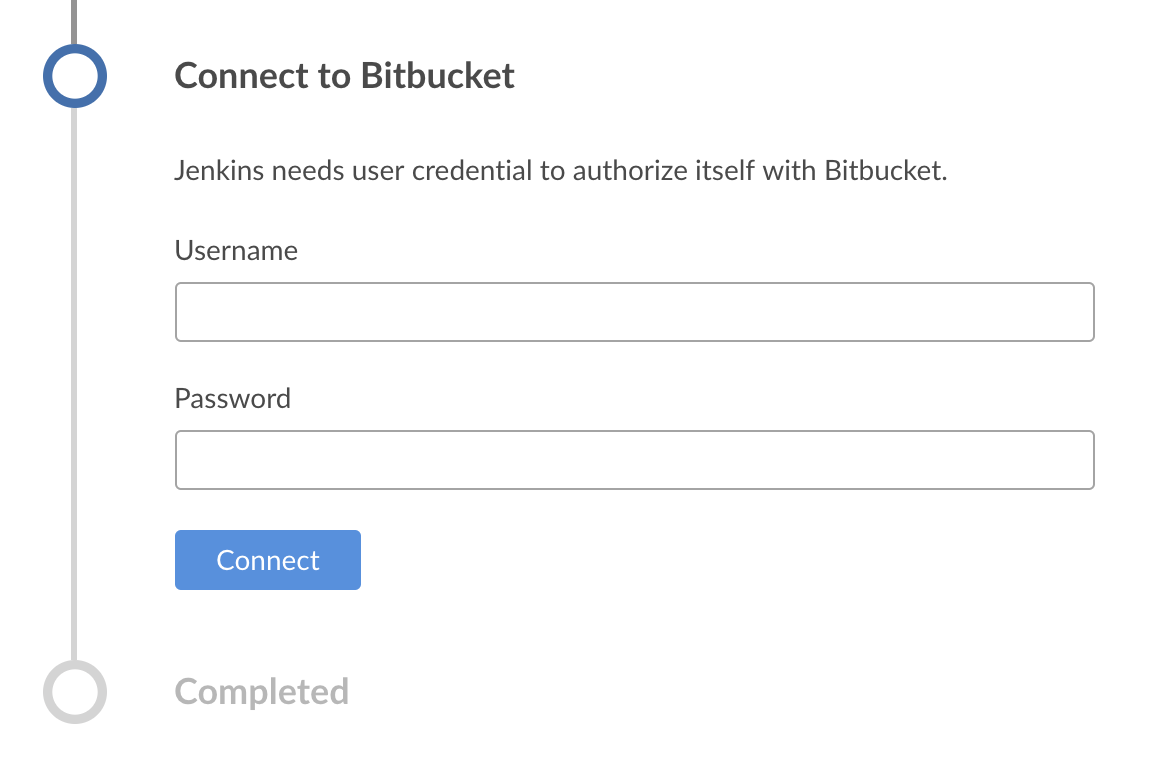

在 Connect to GitHub, 点击 Create an access key here。这将在一个新的浏览器选项卡中打开 GitHub。 Note: 如果你之前配置了 Blue Ocean,使用个人的访问令牌连接到GitHub, then Blue Ocean 将直接带你到 below的第9步。

-

在新的选项卡中, 登录到 GitHub 账户 (如果需要) 并进入 GitHub的 New Personal Access Token 页面, 为你的 GitHub 访问令牌 (e.g.

Blue Ocean)指定一个简短的 Token description 。 Note: 访问令牌通常是一个字母数字的字符串 ,它代表你的 GitHub 账户具有访问各种 GitHub 特性 和区域的特权。该访问令牌将具有预选的适当权限, 该权限为Blue Ocean 需要访问你的GitHub账号并与其交互。 -

向下滚动到页面的底部 (保留所有的 Select scopes 选项 的默认设置) 并点击 Generate token。

-

在生成的Personal access tokens 页面上, 复制新生成的访问令牌。

-

回到Blue Ocean, 粘贴访问令牌到 Your GitHub access token 域并点击 Connect。 +

Jenkins现在在访问你的 GitHub 账户 (由你的访问令牌提供).

Jenkins现在在访问你的 GitHub 账户 (由你的访问令牌提供). -

在 Which organization does the repository belong to?, 点击你的 GitHub 账号 (你abovefork仓库的地方 ).

-

在 Choose a repository, 点击fork的仓库的 creating-a-pipeline-in-blue-ocean。

-

点击 Create Pipeline. Blue Ocean 检测到在存储库的

master主分支的根级别上没有 Jenkinsfile 文件 然后就帮你创建一个。 (因此, 你要点击在页面的尾部另一个 Create Pipeline 来继续。) Note: 在, 通过Blue Ocean创建的流水线项目实际上是 "多分支流水线"。 因此, Jenkins 在你的存储库的任何分支上至少找到一个Jenkinsfile文件。

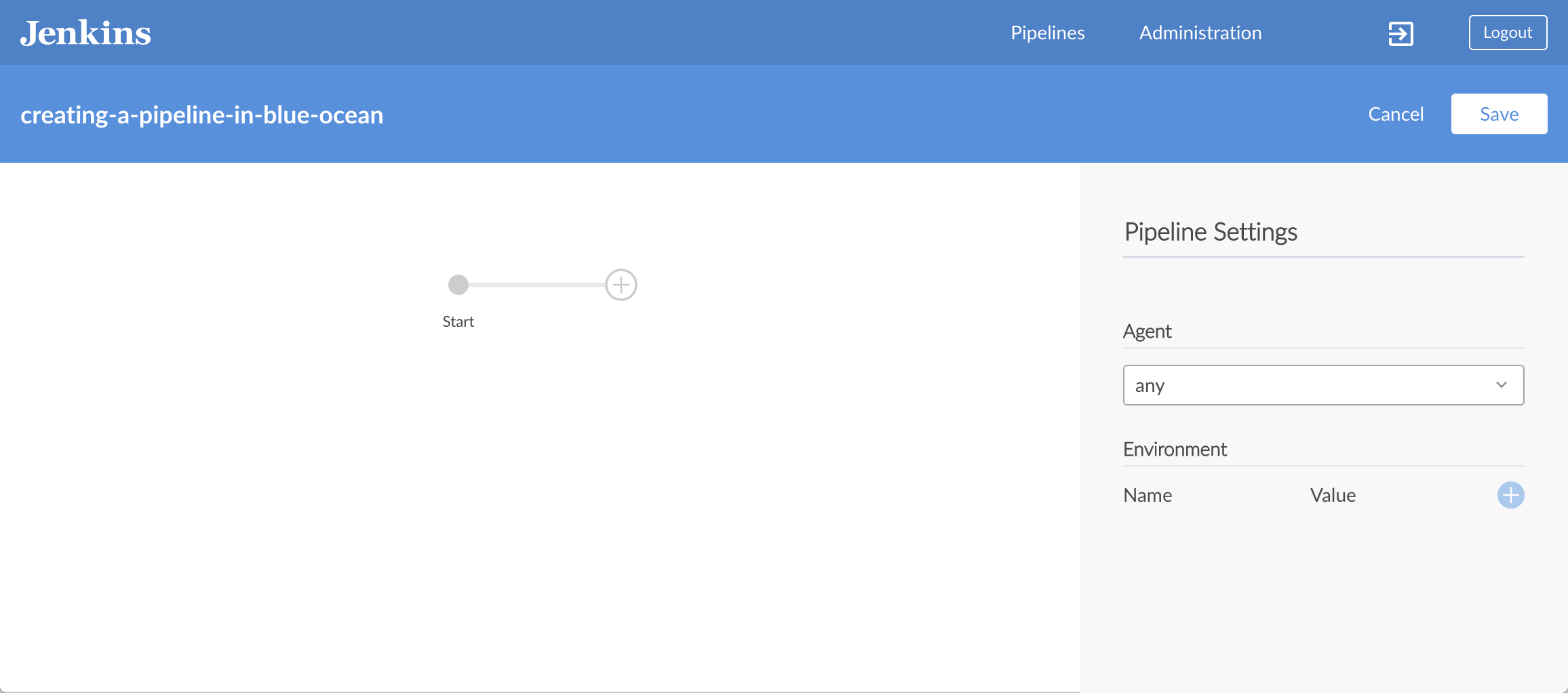

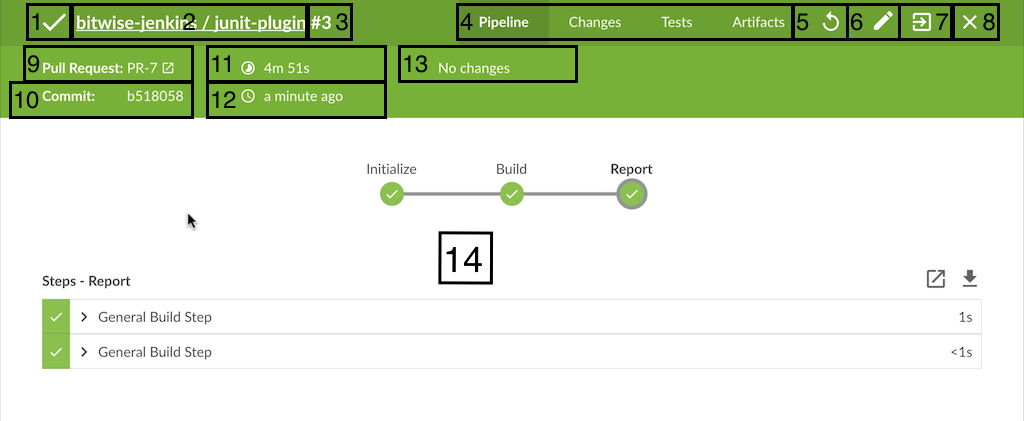

创建你的初始流水线

-

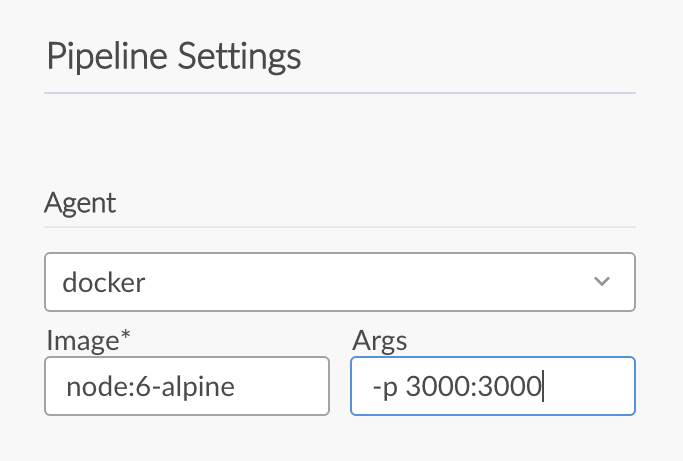

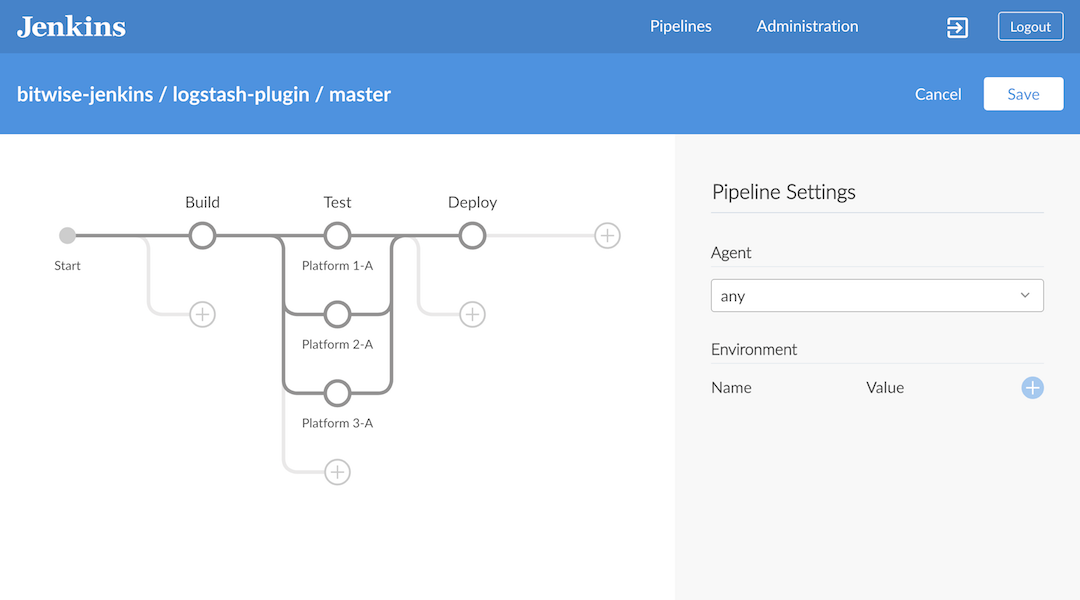

在创建流水线项目之后 (above), 在流水线编辑器中, 从右边的 Pipeline Settings*面板中的*Agent*下拉框中选择 *docker。 +

-

在出现的 Image 和 Args 域中, 分别指定

node:6-alpine和-p 3000:3000。 Note: 对这些值的解释, 请参考“Create your initial Pipeline…” section of the Build a Node.js and React app 教程的声明式流水线的注释 1 和 2。

Note: 对这些值的解释, 请参考“Create your initial Pipeline…” section of the Build a Node.js and React app 教程的声明式流水线的注释 1 和 2。 -

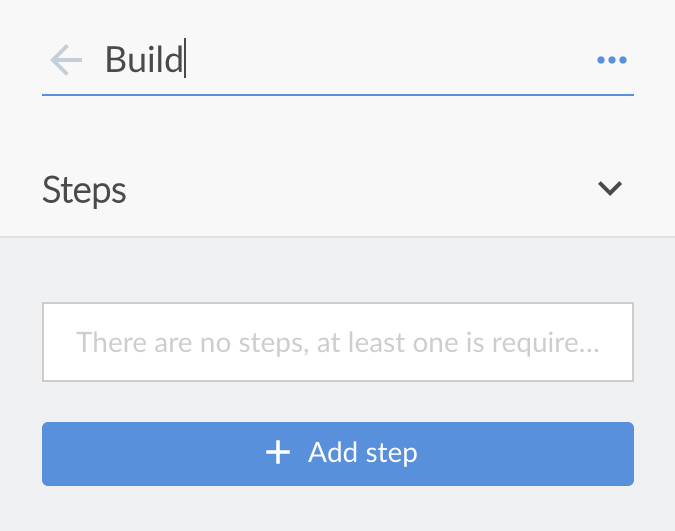

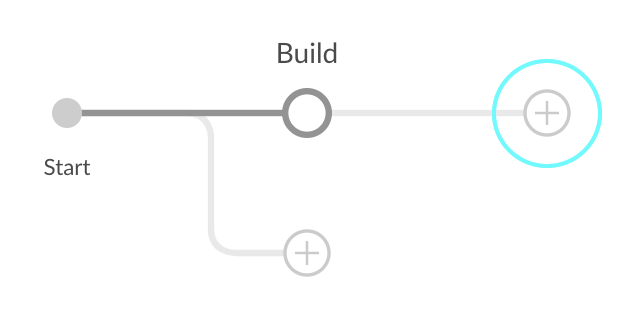

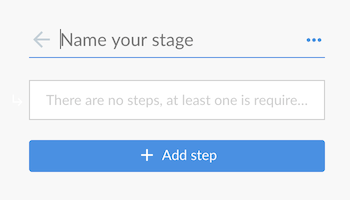

在主流水线编辑器中, 点击 + 图标, 它会打开右侧的新阶段面板。

-

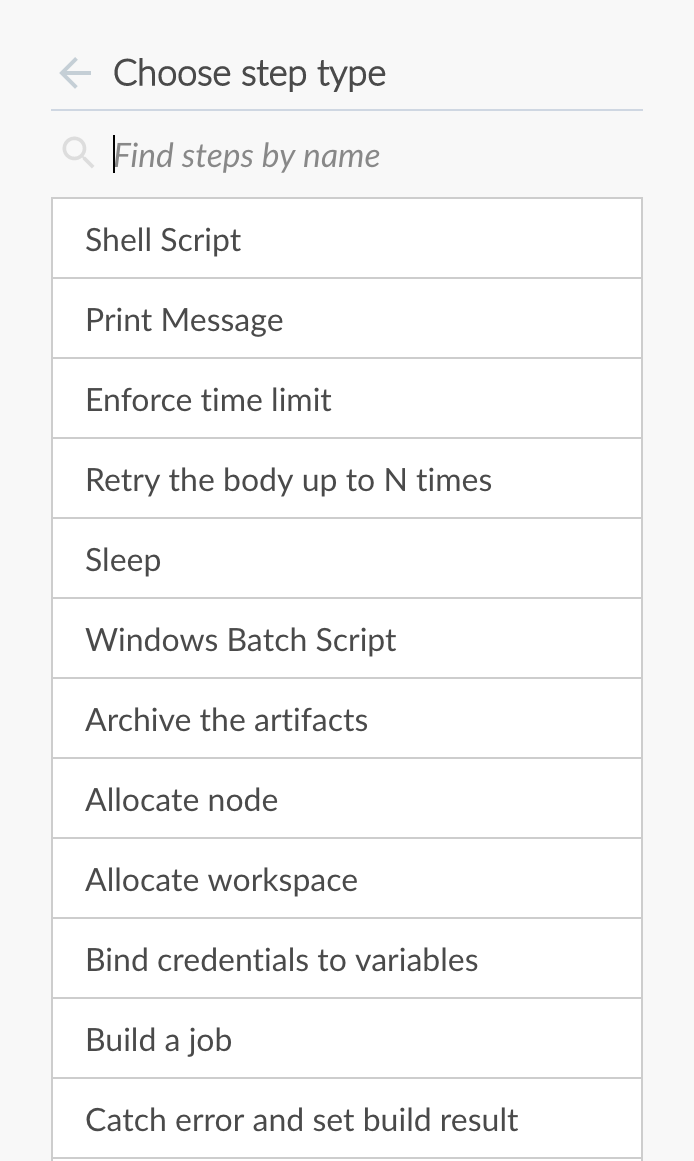

在该面板中, 在 Name your stage*域中输入

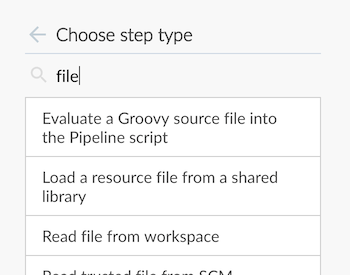

Build,然后点击下面的 *Add Step 按钮, 它会打开 Choose step type 面板。

-

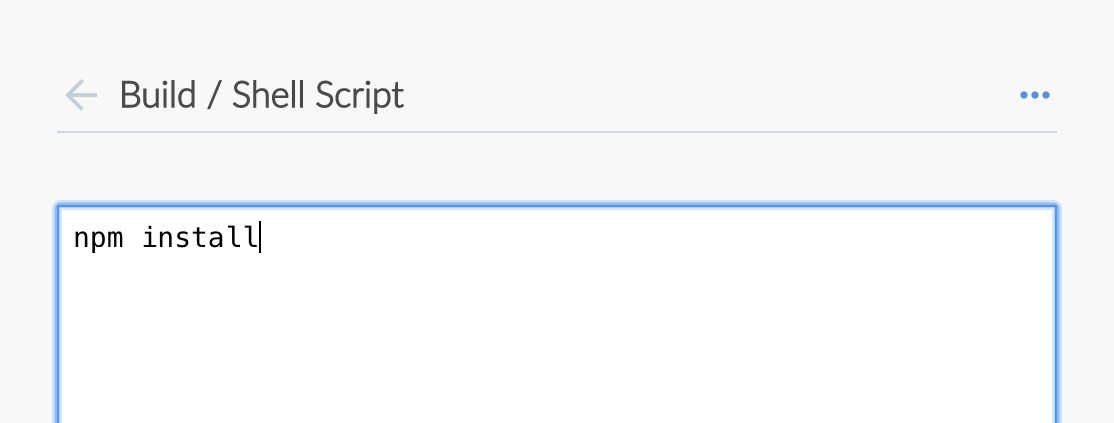

在这个面板中,点击列表顶部附近的 Shell Script (选择该步骤类型), 它打开 Build / Shell Script 面板, 在这儿你可以输入该步骤的值。

Tip: 最常用的步骤类型出现在最靠近列表顶部的地方。要想在这个列表中找到其他的步骤, 你可以使用 Find steps by name 选项筛选这个列表。

Tip: 最常用的步骤类型出现在最靠近列表顶部的地方。要想在这个列表中找到其他的步骤, 你可以使用 Find steps by name 选项筛选这个列表。 -

在 Build / Shell Script 面板, 指定

npm install。 Note: 对该步骤的解释, 请参考 “Create your initial Pipeline…” section of the Build a Node.js and React app 教程的声明式流水线的注解 4 。

Note: 对该步骤的解释, 请参考 “Create your initial Pipeline…” section of the Build a Node.js and React app 教程的声明式流水线的注解 4 。 -

( Optional ) 点击左上的箭头图标

回到主流水线编辑器。

回到主流水线编辑器。 -

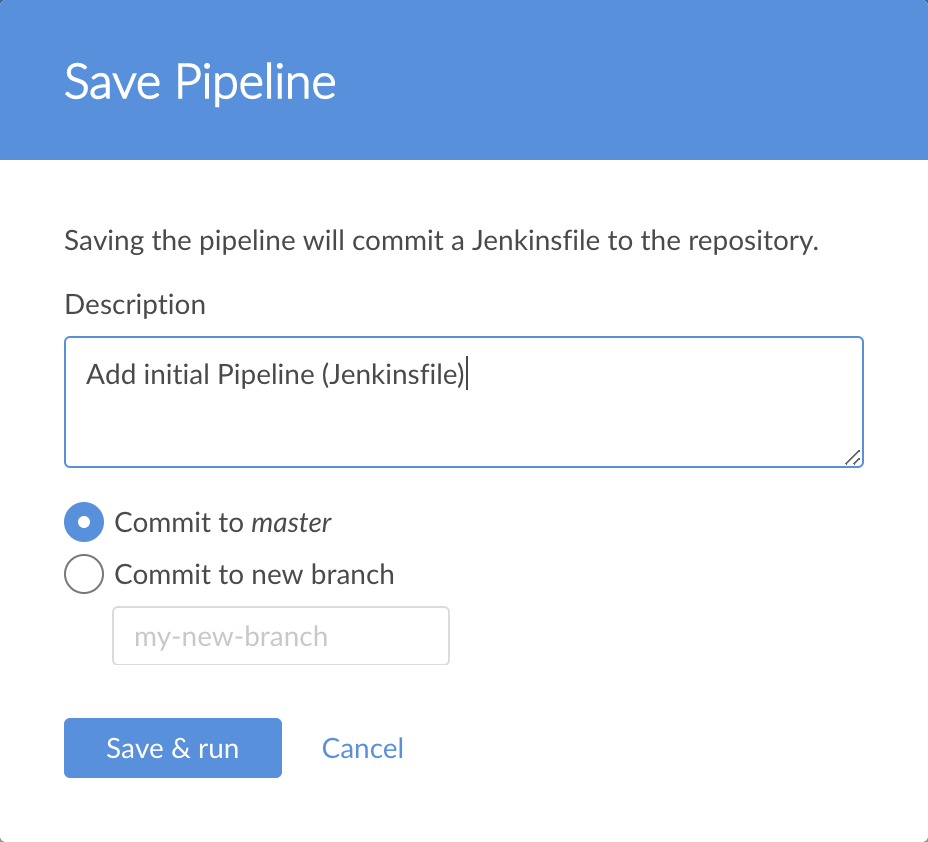

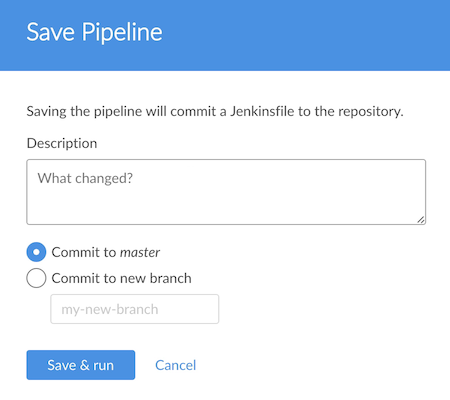

点击右上方的 Save 按钮 开始保存你的带有"Build" 阶段的新流水线 。

-

在 Save Pipeline 对话框, 在 Description 域输入命令信息 (比如

Add initial Pipeline (Jenkinsfile))。

-

保留所有其他选项, 点击 Save & run ,Jenkins 就会继续构建你的流水线。

-

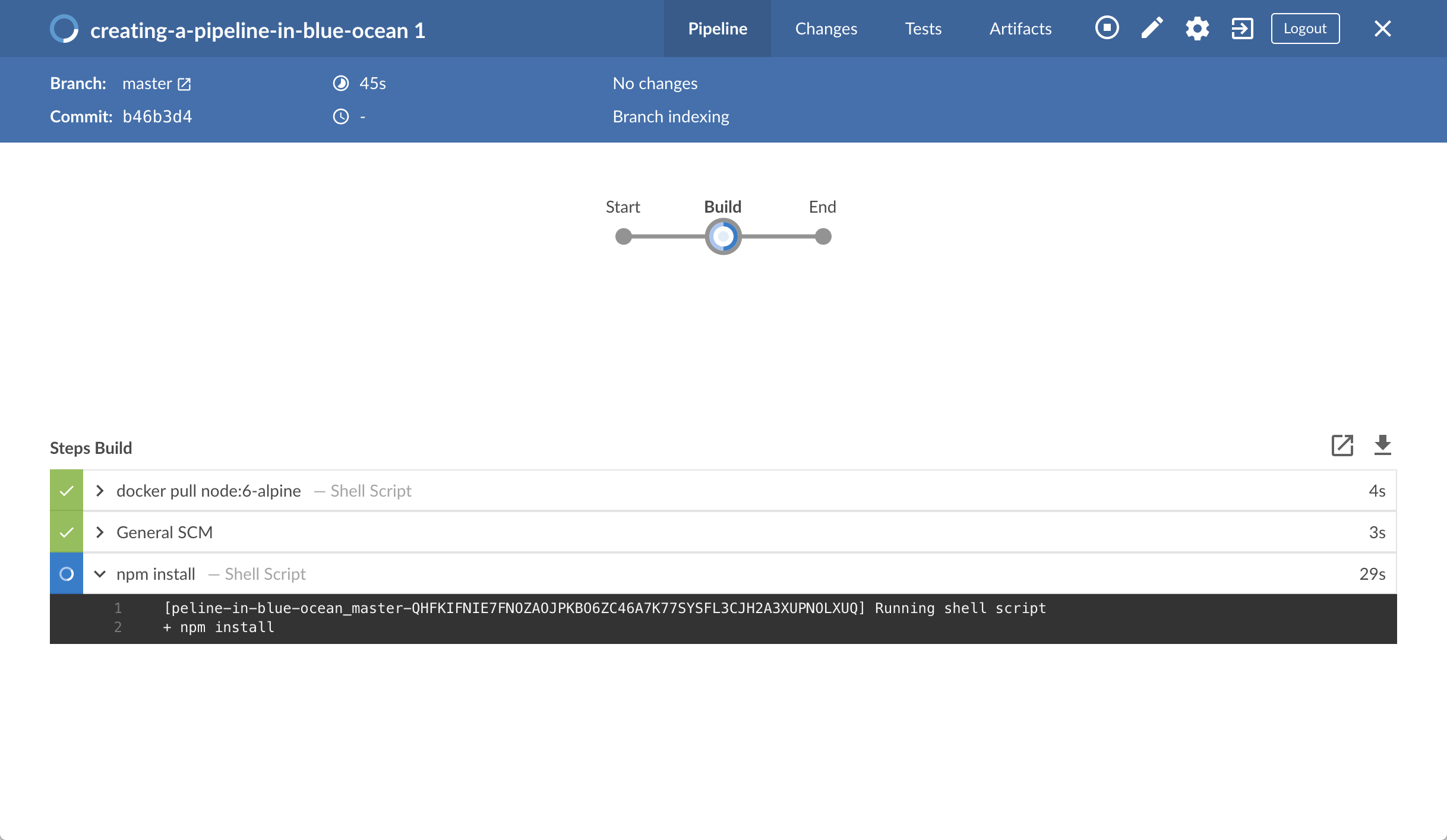

当出现Blue Ocean 的主界面时, 点击该行来查看 Jenkins 构建你的流水线项目。+ Note: 你可能需要几分钟来完成第一次的运行。 在此期间, Jenkins 进行了如下动作:

-

将你的流水线作为

Jenkinsfile提交到仓库的唯一分支 (也就是master)。 -

最初让项目在代理上排队构建。

-

下载 Node Docker 镜像并在Docker的一个容器上运行。

-

在Node容器中执行

Build阶段 (定义在Jenkinsfile)。(在此期间,npm下载了一些需要的依赖来运行你的Node.js 和 React 应用程序, 他最终被保存在 本地的Jenkins主目录的node_modules目录中).

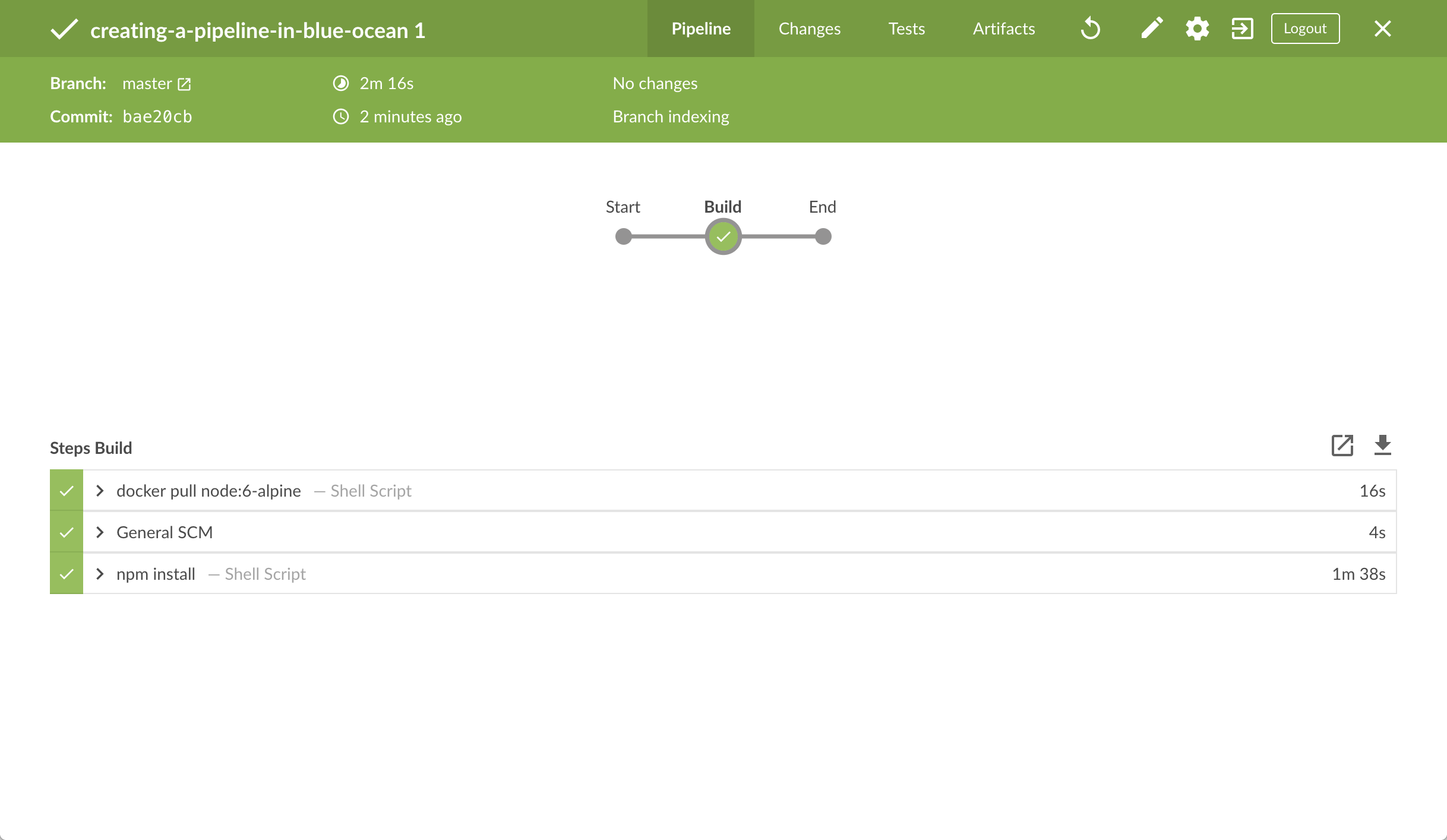

如果Jenkins成功构建了你的应用程序,Blue Ocean 界面会变成绿色。

-

-

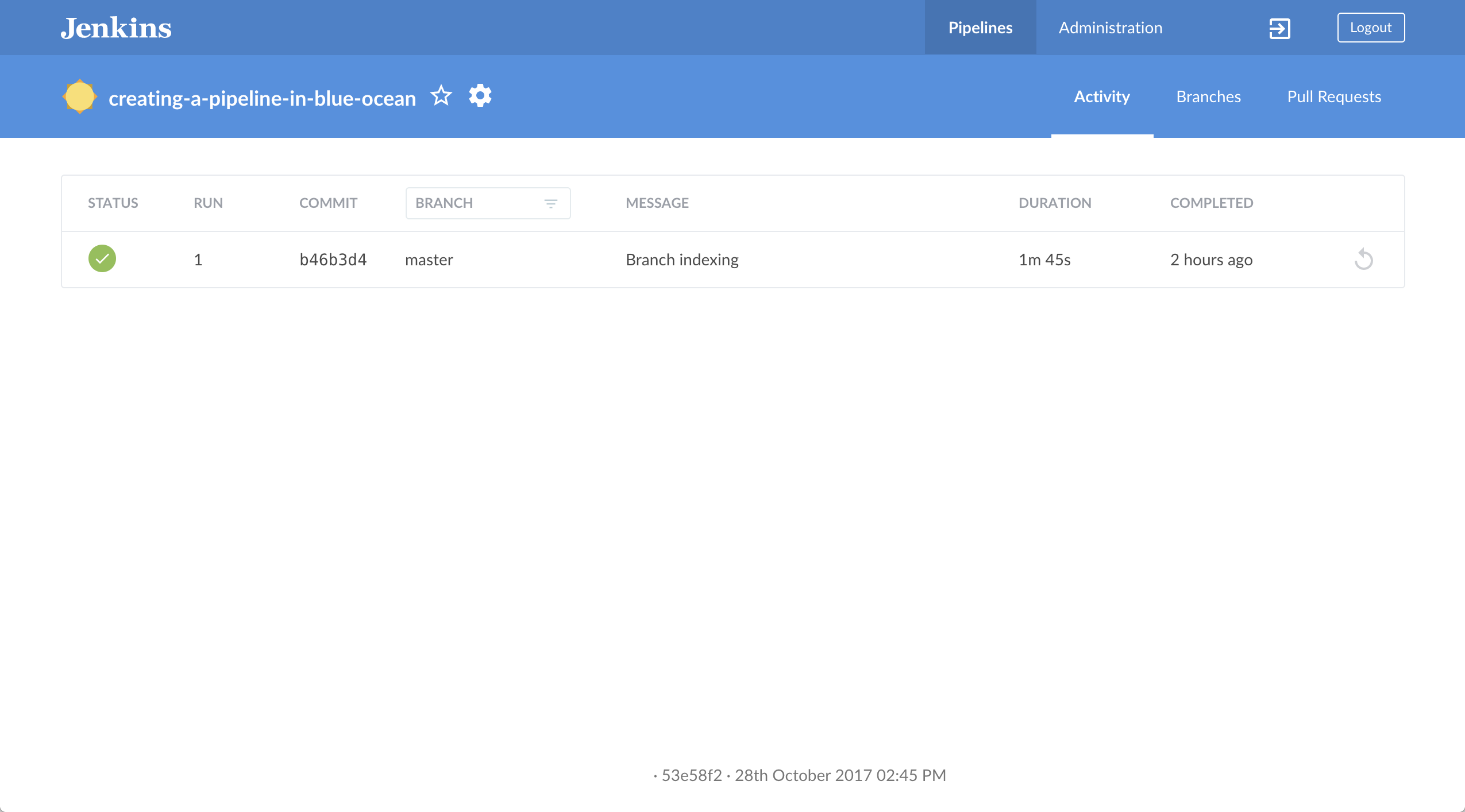

点击右上方的 X 回到 Blue Ocean 的主界面。

Note: 再继续之前, 你可以检查到Jenkins已为你在你fork的GitHub仓库创建了

Note: 再继续之前, 你可以检查到Jenkins已为你在你fork的GitHub仓库创建了 Jenkinsfile(在仓库的唯一的master分支)。

给你的流水线添加测试阶段

-

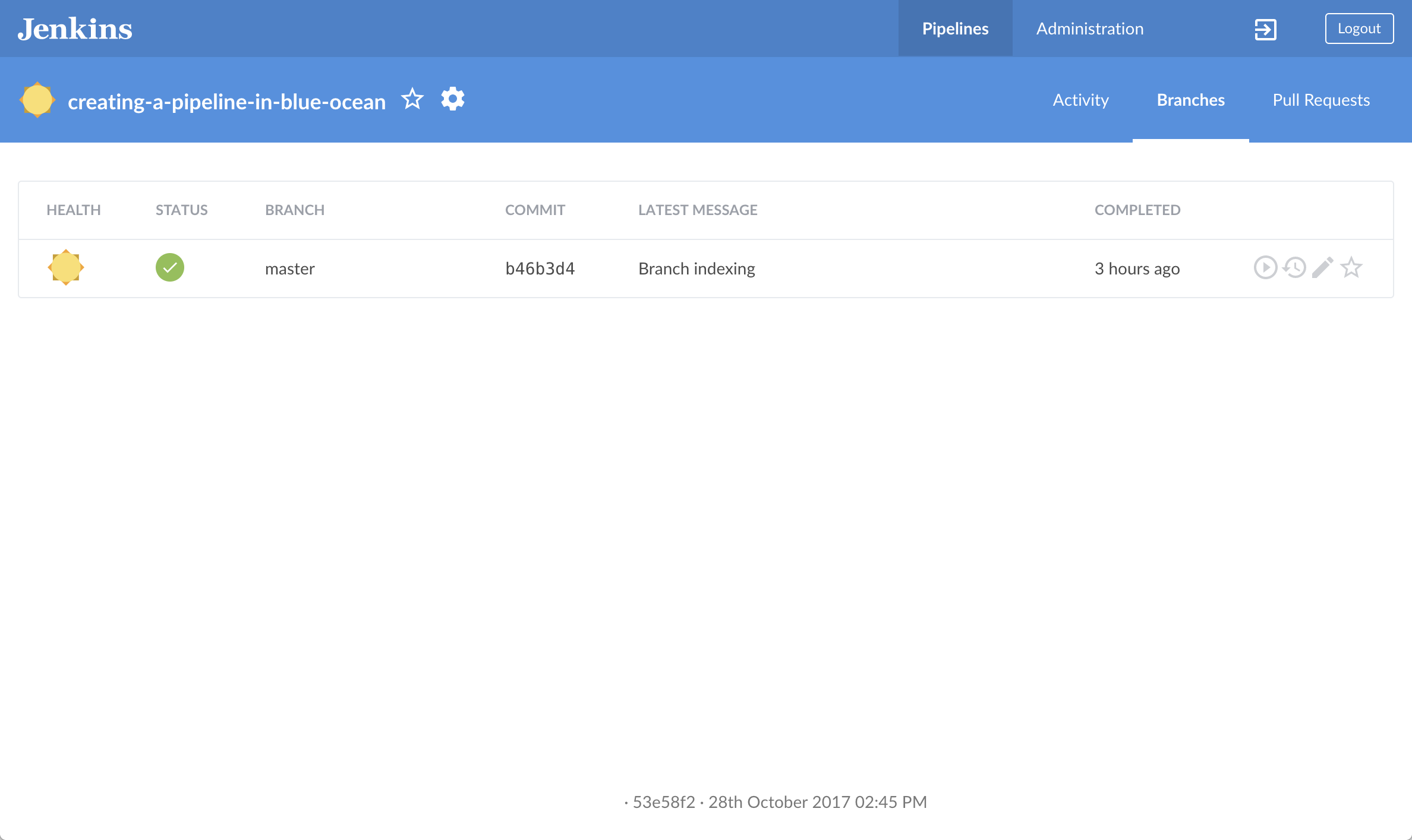

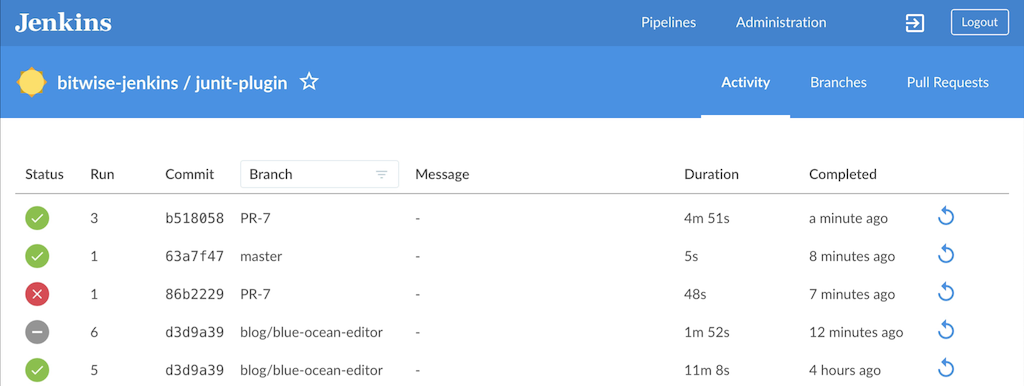

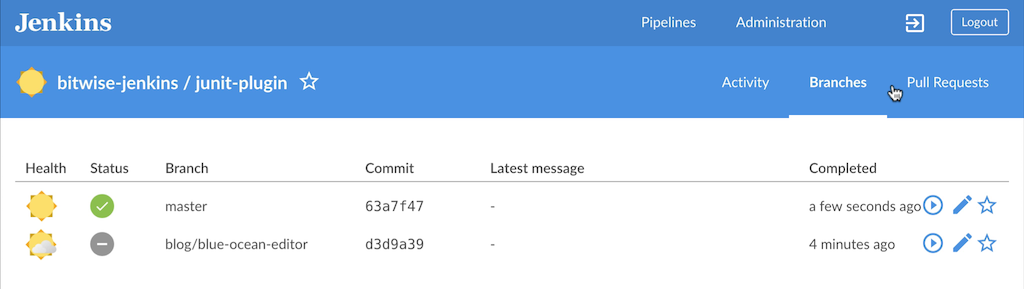

在Blue Ocean 界面, 点击右上方的 Branches 访问你的仓库的分支页面, 在这儿你可以访问

master分支。+

-

点击

master分支的 "Edit Pipeline" 图标 打开该分支的流水线编辑器。

打开该分支的流水线编辑器。 -

在主流水线编辑器中, 点击在above创建的Build阶段的右侧的 + 图标,打开右侧的新阶段面板。

-

在这个面板中, 在 Name your stage*域输入

Test,点击下面的 *Add Step 按钮来打开 Choose step type 面板。 -

在这个面板中, 点击列表顶部附近的 Shell Script。

-

在生成的 Test / Shell Script 面板, 指定

./jenkins/scripts/test.sh,然后点击左上方的箭头图标 返回到流水线阶段编辑器。

返回到流水线阶段编辑器。 -

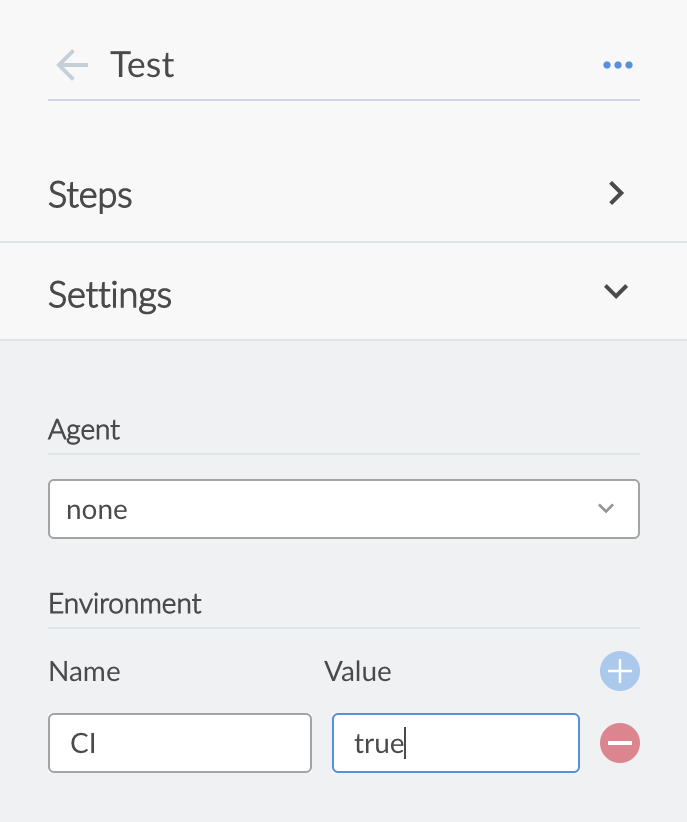

在面板的右下方, 点击 Settings 以显示面板的这一部分。

-

点击Environment 标题右边的 + 图标 (你将配置一个环境变量)。

-

在出现的 Name 和 Value 域中, 分别指定

CIandtrue。+ Note: 对该指令以及它的步骤的解释, 请参考“Add a test stage…” section of the Build a Node.js and React app 教程的生命是流水线的注解 1 和 3。

Note: 对该指令以及它的步骤的解释, 请参考“Add a test stage…” section of the Build a Node.js and React app 教程的生命是流水线的注解 1 和 3。 -

( Optional ) 点击左上方的箭头图标

回到主流水线编辑器 。

回到主流水线编辑器 。 -

点击右上方的 Save 按钮开始保存你的带有新得"Test"阶段的流水线。

-

在 Save Pipeline 对话框的Description域, 输入提交信息(比如

Add 'Test' stage)。 -

保留所有其它选项, 点击 Save & run , Jenkins 就会构建你改进后的流水线。

-

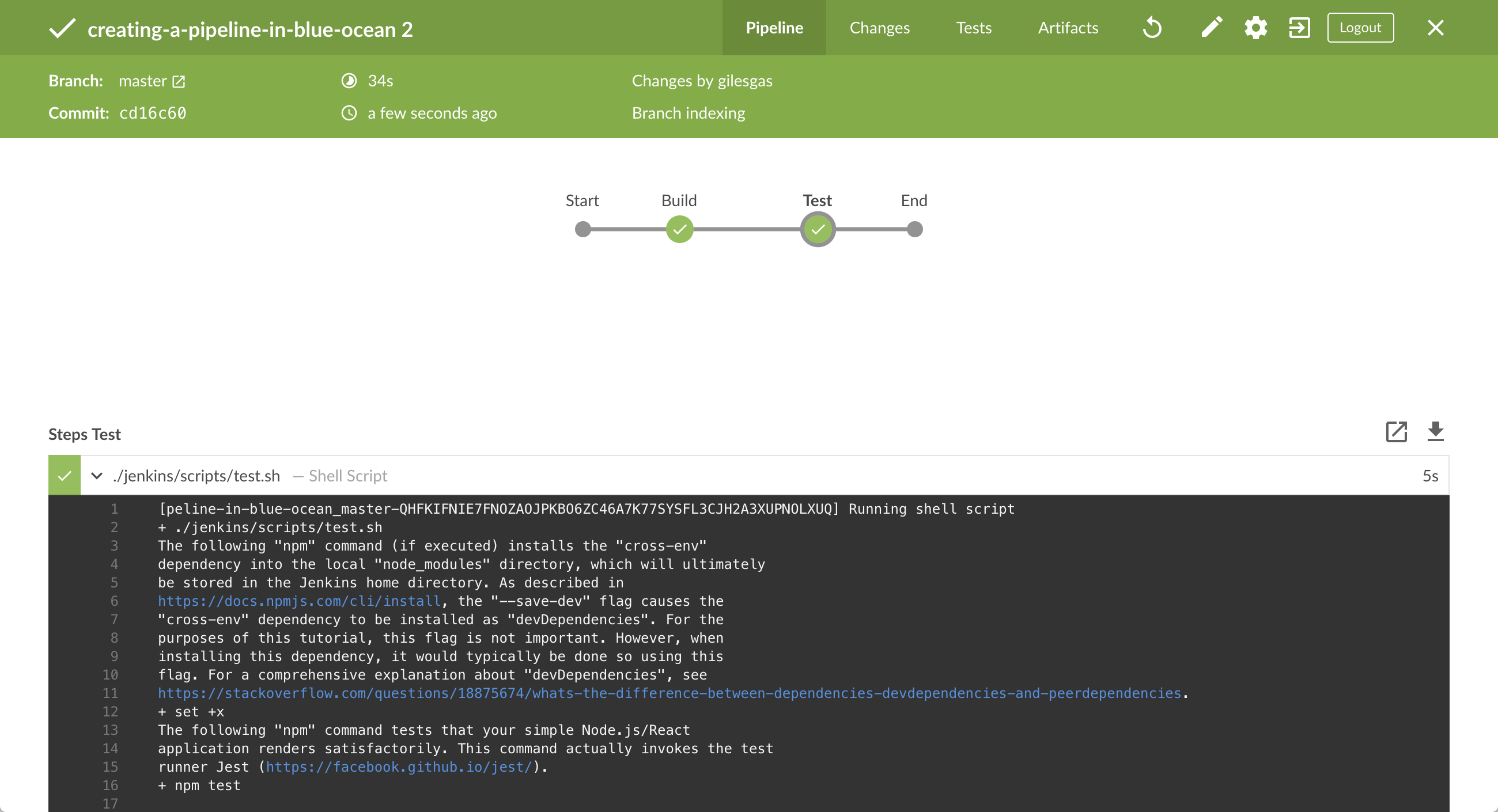

当Blue Ocean的主界面出现时, 点击 top 行来查看Jenkins 构建你的流水线项目。 Note: 你会注意到在这次运行中Jenkins 不再需要下载 Node Docker 镜像。 Jenkins 只是需要从之前下载过的Node镜像中运行一个新的容器。因此, 在接下来的时间运行你的流水线会更快些。 如果你改进后的流水巷运行成功, Blue Ocean界面应如下图所示。注意另外的"Test" 阶段。你可以点击之前的 "Build" 阶段来循环的访问这些阶段的输出。

-

点击右上方的 X 回到 Blue Ocean 的主界面。

给你的流水线添加最终交付阶段

-

在 Blue Ocean 的主界面, 点击右上方的 Branches 以访问你仓库的

master分支。 -

点击

master分支的 "编辑流水线" 图标 为该分支打开流水线编辑器。

为该分支打开流水线编辑器。 -

在主流水线编辑器中, 点击在above创建的Test阶段右侧的 + 图标来打开新阶段面板。

-

在这个面板中的 Name your stage 域, 输入

Deliver并点击下面的 Add Step 按钮打开 Choose step type 面板。 -

在该面板中, 点击列表顶部附近的 Shell Script 。

-

在生成的 Deliver / Shell Script 面板, 指定

./jenkins/scripts/deliver.sh,然后点击左上的箭头图标 回到流水线阶段编辑器。

回到流水线阶段编辑器。 Note: 对该步骤的解释, 请参考

Note: 对该步骤的解释, 请参考deliver.sh文件,它位于你在GitHub fork的仓库的jenkins/scripts中。 -

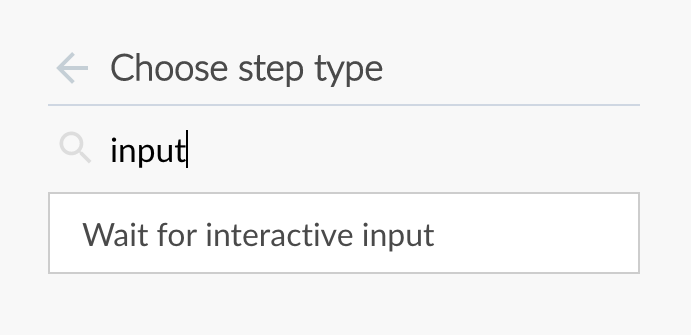

再次点击 Add Step 按钮。

-

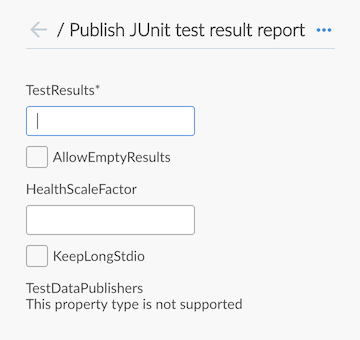

在 Choose step type 面板的 Find steps by name 域输入

input。

-

点击过滤后的 Wait for interactive input 步骤类型。

-

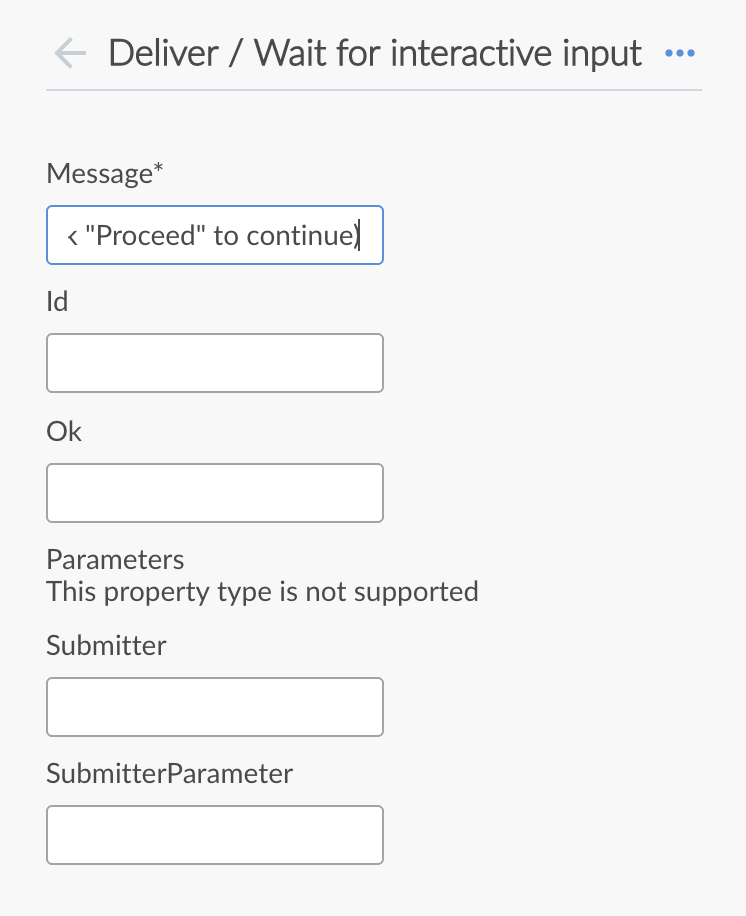

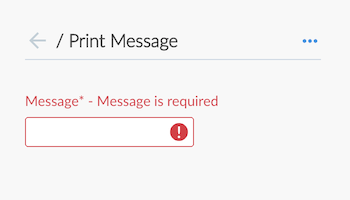

在生成的 Deliver / Wait for interactive input 面板,在 Message 域指定

Finished using the web site? (Click "Proceed" to continue),然后点击左上方的箭头图标 回到流水线阶段编辑器。

回到流水线阶段编辑器。 Note: 对该步骤的解释, 请参考“Add a final deliver stage…” section of the Build a Node.js and React app 教程的声明式流水线的注释 4。

Note: 对该步骤的解释, 请参考“Add a final deliver stage…” section of the Build a Node.js and React app 教程的声明式流水线的注释 4。 -

点击 Add Step 按钮 (最后一次)。

-

点击列表顶部附近的 Shell Script。

-

在生成的 Deliver / Shell Script 面板, 指定

./jenkins/scripts/kill.sh. Note: 对该步骤的解释,请参考kill.sh文件,它 位于你在GitHub上fork的仓库的jenkins/scripts中。 -

( Optional ) 点击左上方的图标按钮

回到主流水线编辑器。

回到主流水线编辑器。 -

点击右上方的 Save 按钮开始保存你的带有新"Deliver" 阶段的流水线。

-

在 Save Pipeline 对话框的 Description 域填写提交信息 (比如

Add 'Deliver' stage)。 -

保留所有其它选项, 点击 Save & run ,Jenkins 就会对你改进后的流水线进行构建。

-

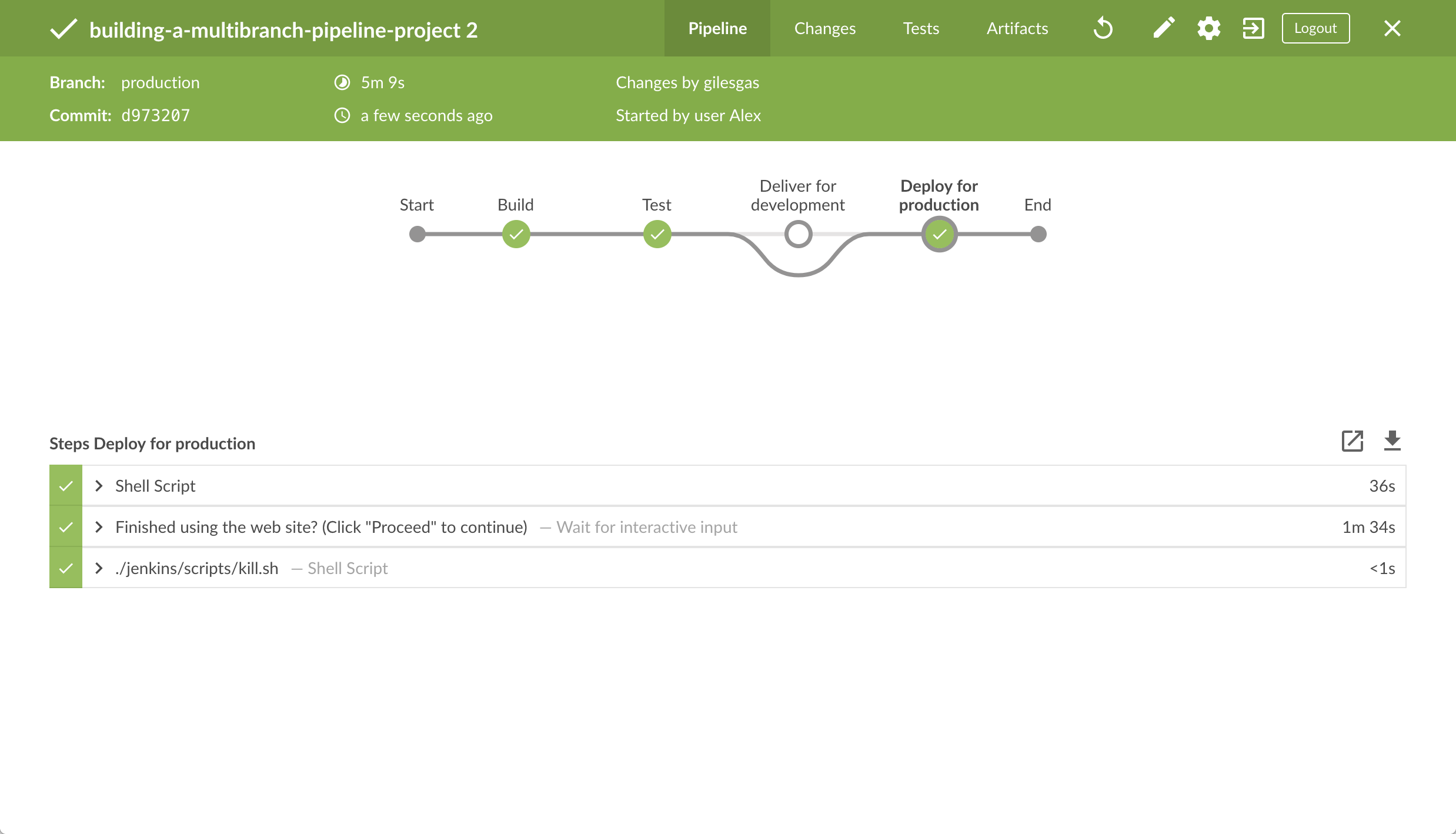

当Blue Ocean主界面出现时, 点击 top行来查看Jenkins 构建你的流水线项目。+ 如果你改进后的流水巷线运行成功, Blue Ocean 界面应如下图所示。注意另外的 "Deliver" 阶段。 点击之前的"Test" 和 "Build" 阶段循环的访问这些阶段的输出。

-

确保你正在查看 "Deliver" 阶段 (如果必要的话点击它), 探后点击绿色的

./jenkins/scripts/deliver.sh步骤来扩展它的内容并向下滚动直到你看到http://localhost:3000链接。

-

点击

http://localhost:3000链接查看你的 Node.js 和 React 应用程序在一个新的web浏览器选项卡中运行 (在开发模式下)。 你将会看到一个标题为Welcome to React的网页/站点。 -

当你查看完该网页/站点时, 点击 Proceed 按钮以完成流水线的执行。

-

点击右上方的 X 回到Blue Ocean 的主界面, 它以时间顺序的反序的方式列出了你的流水线运行的历史记录。

跟踪 (可选)

如果你检查在你fork的creating-a-pipeline-in-blue-ocean 仓库的根目录下的Blue Ocean生成的 Jenkinsfile 的内容 , 注意 environment 指令的位置。 该指令在"Test" 阶段的位置意味着环境变量 CI (它的值为true) 只是在"Test"阶段的范围内可用的变量。

你可以在Blue Ocean中设置该指令以便于它的环境变量在整个流水线中都是可用的(和 使用npm构建Node.js 和 React 应用程序 教程中一样)。要做到这一点:

-

从Blue Ocean的主界面, 点击右上方的 Branches来访问仓库的

master分支。 -

点击

master分支的"编辑流水线" 图标 为该分支打开流水线编辑器。

为该分支打开流水线编辑器。 -

在主流水线编辑器中, 点击 你在 above创建的Test 阶段 开始编辑它。

-

在右侧的阶段面板中, 点击 Settings 来显示面板的这一部分。

-

点击

CI环境变量(你之前创建的)右边的减 (-) 图标来删除它。 -

点击左上的箭头图标

返回主流水线编辑器。

返回主流水线编辑器。 -

在 Pipeline Settings 面板,点击Environment标题右边的 + 图标 (你将为此配置一个 global 环境指令)。

-

在出现的 Name 和 Value 域中, 分别指定

CI和true。 -

点击右上的Save 按钮开始保存你的迁移了环境指令的流水线。

-

在Save Pipeline 对话框的Description域指定提交消息(比如

Make environment directive global)。 -

保留所有的其他设置, 点击 Save & run ,Jenkins 继续去构建你的改进后的流水线。

-

当出现Blue Ocean 的主界面时, 点击 top 行来查看Jenkins 构建你的流水线项目。 你应该看到与当你添加最终交付阶段(above)完成后相同的构建工程。 然而, 当你再次检查

Jenkinsfile, 你会注意到environment指令是agent部分的兄弟。

结束语

做得好!您刚刚使用Jenkins的Blue Ocean特性以及npm构建了一个简单的Node.js 和React应用程序!

您在上面创建的 "Build", "Test" 和 "Deliver" 阶段是在Jenkins中使用技术栈构建其他应用程序的基础,包括更复杂的应用程序以及将多个技术栈组合在一起的应用程序。

由于Jenkins具有极高的可扩展性,因此可以对其进行修改和配置,以处理构建协调和自动化的几乎任何方面。

要详细了解Jenkins可以做什么,请查看:

-

教程概览 页面中的其他介绍教程。

-

用户手册 使用Jenkins的更多细节,例如 Pipelines (尤其是 Pipeline 语法) 和 Blue Ocean 界面。

-

Jenkins blog 资讯,其他教程和更新。

构建多分支流水线项目

Table of Contents

-

在 Docker中运行Jenkins

-

从你的浏览器中清除应用程序

本教程向你展示如何使用Jenkins协调一个用 Node Package Manager (npm) 管理的简单 Node.js 和 React 项目, 并同时 为开发和产品环境交付不同的结果。

在开始本教程之前,建议你前往 教程概览 页面,并至少完成一个 介绍教程, 从而让你熟悉持续集成/持续交付概念(不同于你以往熟悉的技术栈)和这些概念在Jenkins中实现方式, 以及Jenkins流水线的基本知识。

本教程你将使用与 构建npm管理的Node.js和React应用 教程相同的应用。然而这一次,项目的交付会根据Jenkins构建不同的Git分支而有所区别。 也就是说,所构建的分支决定你的流水线会执行哪一个交付阶段。

耗时: 假如你的机器符合配置要求,完成本教程需要30-50分钟。 准确的耗时取决于你机器的性能, 以及你是否完成过在Docker中运行Jenkins教程,请参考另一个教程.

你可以在任何时候停止本教程,并从你离开的地方继续。

若你已经完成了另一个教程,可以跳过配置要求和在Docker中运行Jenkins章节, 继续阅读fork示例仓库(确保你本地安装了Git)。 如果你需要重启Jenkins,请参考停止和重启Jenkins.

配置要求

对于本教程,您将需要:

-

安装有macOS,Linux或Windows操作系统的机器,并拥有以下配置:

-

最小256MB内存, 推荐512MB以上。

-

10GB硬盘空间, 用于安装Jenkins,您的Docker镜像和容器。

-

-

安装有以下软件:

在 Docker中运行Jenkins

在本教程中, 将Jenkins作为 Docker 容器并从 jenkinsci/blueocean Docker 镜像中运行。

要在 Docker中运行Jenkins, 请遵循下面的macOS 和 Linux 或 Windows相关文档说明进行操作。 .

你可以在 Docker和 Installing Jenkins 页面的 Downloading and running Jenkins in Docker部分阅读更多有关Docker容器和镜像概念的信息。

在 macOS 和 Linux 系统上

-

打开终端窗口

-

使用下面的

docker run命令运行jenkinsci/blueocean镜像作为Docker中的一个容器(记住,如果本地没有镜像,这个命令会自动下载):docker run \ --rm \ -u root \ -p 8080:8080 \ -v jenkins-data:/var/jenkins_home \ -v /var/run/docker.sock:/var/run/docker.sock \ -v "$HOME":/home \ jenkinsci/blueocean

将容器中的 /var/jenkins_home目录映射到 Docker volume ,并将其命名为jenkins-data。如果该卷不存在, 那么docker run命令会自动为你创建卷。将主机上的 $HOME目录 (即你的本地)映射到 (通常是/Users/目录) 到容器的/home目录。Note: 如果复制或粘贴上面的命令片段不起作用, 尝试复制和粘贴这个没有注释的版本:

docker run \ --rm \ -u root \ -p 8080:8080 \ -v jenkins-data:/var/jenkins_home \ -v /var/run/docker.sock:/var/run/docker.sock \ -v "$HOME":/home \ jenkinsci/blueocean

-

继续 安装向导。

在 Windows 系统

-

打开命令提示窗口。

-

使用下面的

docker run命令运行jenkinsci/blueocean镜像作为Docker中的一个容器(记住,如果本地没有镜像,这个命令会自动下载):docker run ^ --rm ^ -u root ^ -p 8080:8080 ^ -v jenkins-data:/var/jenkins_home ^ -v /var/run/docker.sock:/var/run/docker.sock ^ -v "%HOMEPATH%":/home ^ jenkinsci/blueocean

对这些选项的解释, 请参考上面的 macOS 和 Linux 说明。

-

继续安装向导。

访问 Jenkins/Blue Ocean Docker 容器

如果你有一些使用 Docker 的经验,希望或需要使用 docker exec 命令通过一个终端/命令提示符来访问 Jenkins/Blue Ocean Docker 容器, 你可以添加如 --name jenkins-tutorials 选项(与上面的 docker run ), 这将会给Jenkins/Blue Ocean Docker容器一个名字 "jenkins-tutorials"。

这意味着你可以通过 docker exec 命令访问Jenkins/Blue Ocean 容器(通过一个单独的终端 /命令提示窗口) ,例如:

docker exec -it jenkins-tutorials bash

安装向导

在你访问 Jenkins之前, 你需要执行一些快速的 "一次性" 步骤。

解锁 Jenkins

当你第一次访问一个新的 Jenkins 实例时, 要求你使用自动生成的密码对其进行解锁。

-

当在终端/命令提示窗口出现两组星号时, 浏览

http://localhost:8080并等待 Unlock Jenkins 页面出现。

-

再次从终端/命令提示窗口, 复制自动生成的字母数字密码(在两组星号之间)。

-

在 Unlock Jenkins 页面, 粘贴该密码到 Administrator password 字段并点击 Continue。

使用插件自定义 Jenkins

在 解锁 Jenkins后, Customize Jenkins 页面出现。

在该页面,点击 Install suggested plugins。

安装向导显示了正在配置的Jenkins的进程,以及建议安装的插件。这个过程肯需要几分钟。

创建第一个管理员用户

最后, Jenkins 要求创建你的第一个管理员用户。

-

当 Create First Admin User 页面出现, 在相应的字段中指定你的详细消息并点击 Save and Finish。

-

当 Jenkins is ready 页面出现, 点击 Start using Jenkins。 Notes:

-

该页面可能表明 Jenkins is almost ready! 如果相反, 点击 Restart.

-

如果该页面在一分钟后没有自动刷新, 使用你的web浏览器手动刷新。

-

-

如果需要,登录 Jenkins , 你就可以开始使用 Jenkins了!

停止和重启 Jenkins

在本教程的其余部分, 你可以通过在终端/命令提示窗口输入 Ctrl-C停止 Jenkins/Blue Ocean Docker 容器,你可以从中运行<>的 docker run ... 命令。

要重启Jenkins/Blue Ocean Docker 容器:

-

在上面的 macOS,Linux 或 Windows上运行相同的

docker run ...命令 。 Note: 如果有更新的话,该进程会更新jenkinsci/blueoceanDocker 镜像。 -

浏览

http://localhost:8080。 -

等待直到登录页面出现并登陆。

Fork 和 clone GitHub示例仓库

通过将应用程序源代码所在的示例仓库fork到你自己的Github账号中, 并clone到本地, 你就可以获取一个"Welcome to React"简单Node.js和React应用程序。

-

请确保你登陆了你的GitHub账户。如果你还没有Github账户,你可以在 GitHub网站 免费注册一个账户。

-

将示例仓库

building-a-multibranch-pipeline-projectfork到你的账户的Github仓库中。在此过程中,如果你需要帮助, 请参考 Fork A Repo 文档。 -

将你的GitHub账户中的

simple-java-maven-app仓库clone到你的本地机器。 根据你的情况完成以下步骤之一(其中 `` 是你的操作系统用户账户名称):-

如果你的机器安装了Github Desktop:

-

在GitHub网站上,点击绿色的 Clone or download 按钮,再点击 Open in Desktop.

-

在Github桌面版中,在点击 Clone a Repository 对话框上的 Clone 按钮之前,确保 Local Path 的配置为:

-

macOS 系统配置为

/Users//Documents/GitHub/building-a-multibranch-pipeline-project -

Linux 系统配置为

/home//GitHub/building-a-multibranch-pipeline-project -

Windows 系统配置为

C:\Users\\Documents\GitHub\building-a-multibranch-pipeline-project

-

-

-

其他情况:

-

打开一个终端/命令提示符,并且

cd进入正确的目录路径:-

macOS 系统路径为

/Users//Documents/GitHub/ -

Linux 系统路径为

/home//GitHub/ -

Windows 系统路径为

C:\Users\\Documents\GitHub\(推荐使用Git bash命令行,而不是通常的Microsoft命令提示符)

-

-

运行以下命令完成仓库的clone:

git clone https://github.com/YOUR-GITHUB-ACCOUNT-NAME/building-a-multibranch-pipeline-project其中YOUR-GITHUB-ACCOUNT-NAME是你的Github账户的名称。

-

-

在你的仓库中创建开发和生产分支

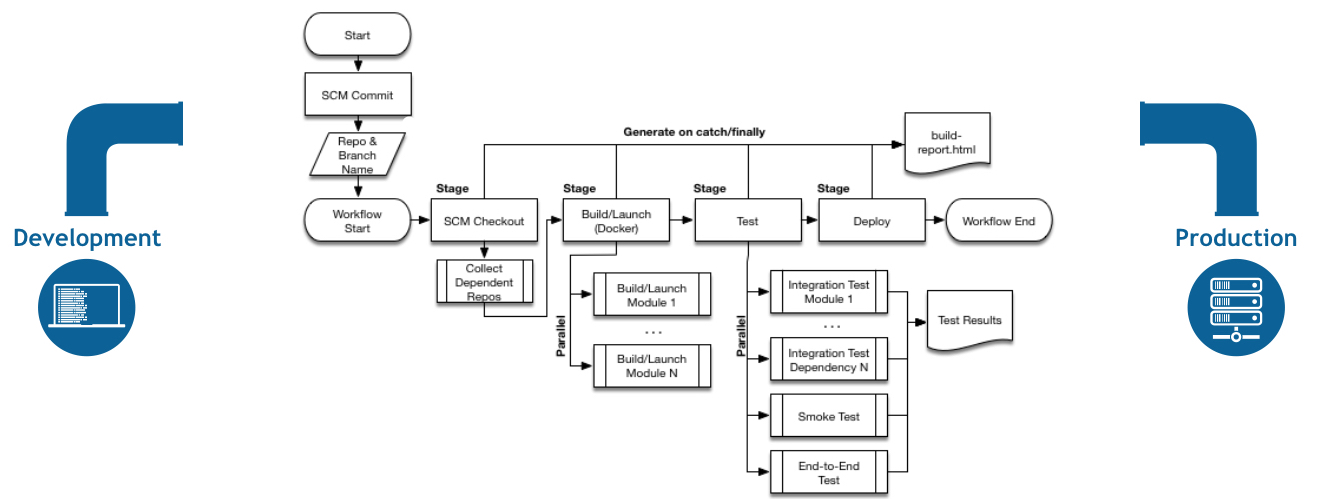

在Jenkins中创建流水线项目之前,在你的本地Git仓库中创建"development"和 "production"分支。 你将创建一个单独的Jenkinsfile(最初是在 master 分支,但最终其上的代码会复制到其他分支), 该Jenkinsfile的各个阶段会根据Jenkins所构建的分支不同而被选择性的执行。

在 building-a-multibranch-pipeline-project 目录路径下(即你的本地clone仓库)

-

运行以下命令来创建以上分支(从

master分支的内容复制):-

git branch development以及 -

git branch production

-

-

检查这些分支被成功创建,运行命令

git branch,结果为:development * master production

-

如果符号*(标识当前分支)未处于

master的位置,运行命令git checkout master以确保master是当前分支。

在Blue Ocean中创建你的流水线项目

当你在Blue Ocean中创建 any 流水线项目是 , Jenkins 实际上在后台创建了一个多分支管道项目 。 如果你在Blue Ocean创建了一个流水线项目后,访问 Jenkins的经典界面; 你会看到Jenkins 将你的项目创建为一个 "多分支流水线" 项目。

-

回到Jenkins并进入 Blue Ocean 界面。 要做到这点, 确保:

-

浏览

http://localhost:8080/blue并登陆+ 或 -

浏览

http://localhost:8080/, 登录后点击右侧的 Open Blue Ocean 。

-

-

在Blue Ocean界面中心的 Welcome to Jenkins 框, 点击 Create a new Pipeline 开始流水线构建向导。 Note: 如果你没有看到这个框, 点击右上方的 New Pipeline。

-

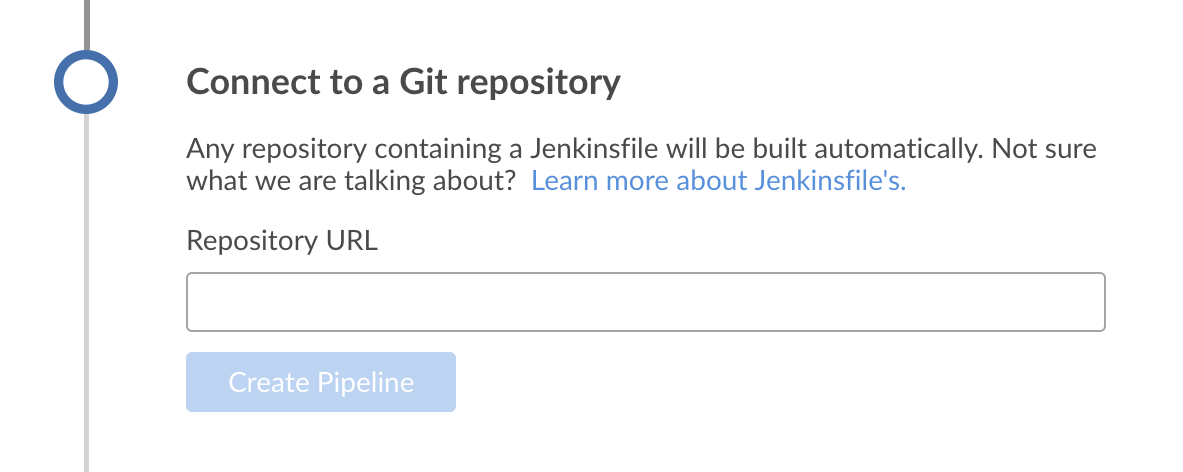

在 Where do you store your code?,点击 Git (not GitHub).

-

在Repository URL 域 (在 Connect to a Git repository里), 指定你aboveclone到本地的仓库的目录路径, 他来自你主机上的 用户账号/主目录 , 映射到Jenkins容器的

/homed目录 - 即-

macOS -

/home/Documents/GitHub/building-a-multibranch-pipeline-project -

Linux -

/home/GitHub/building-a-multibranch-pipeline-project -

Windows -

/home/Documents/GitHub/building-a-multibranch-pipeline-project

-

-

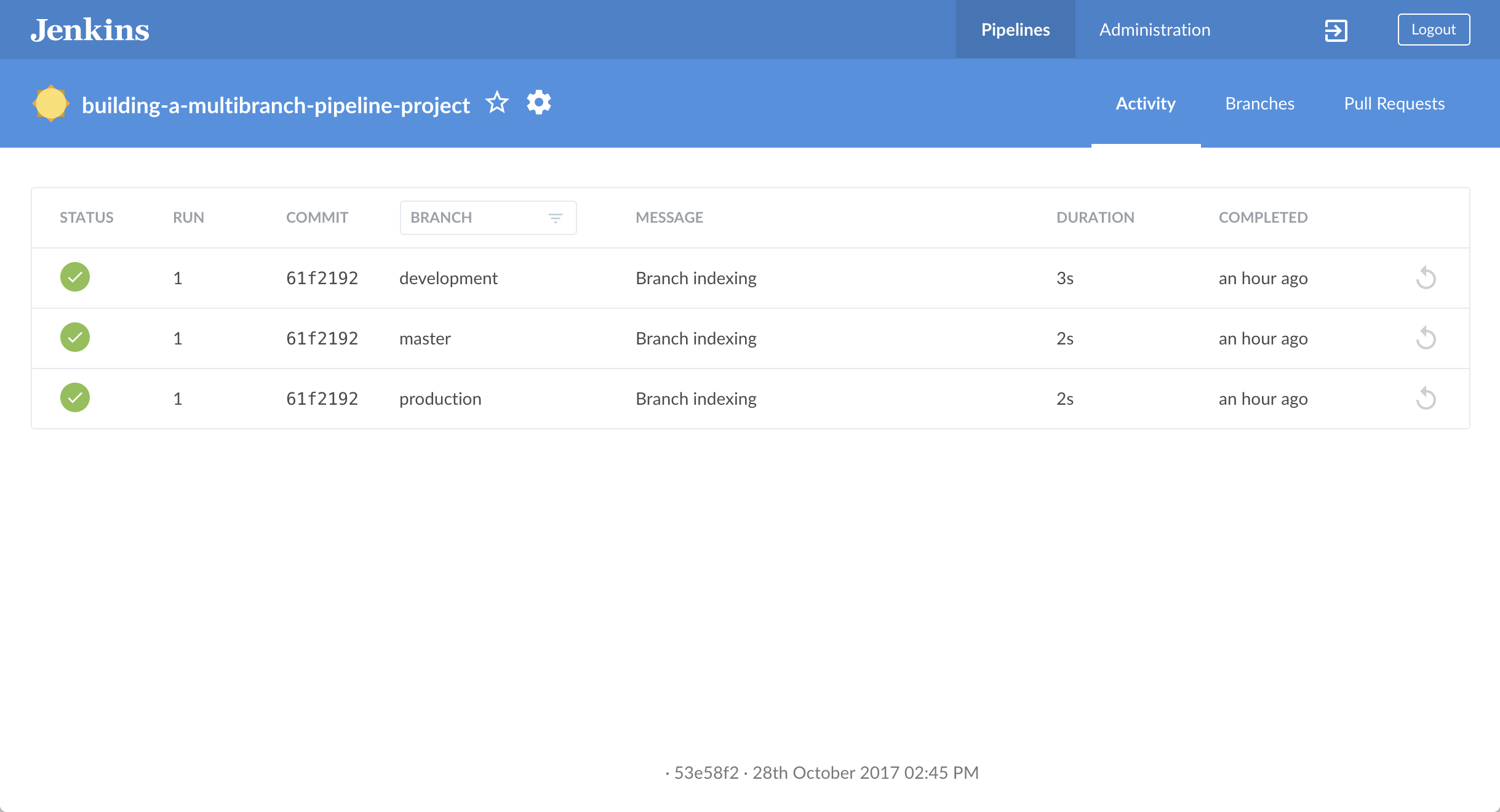

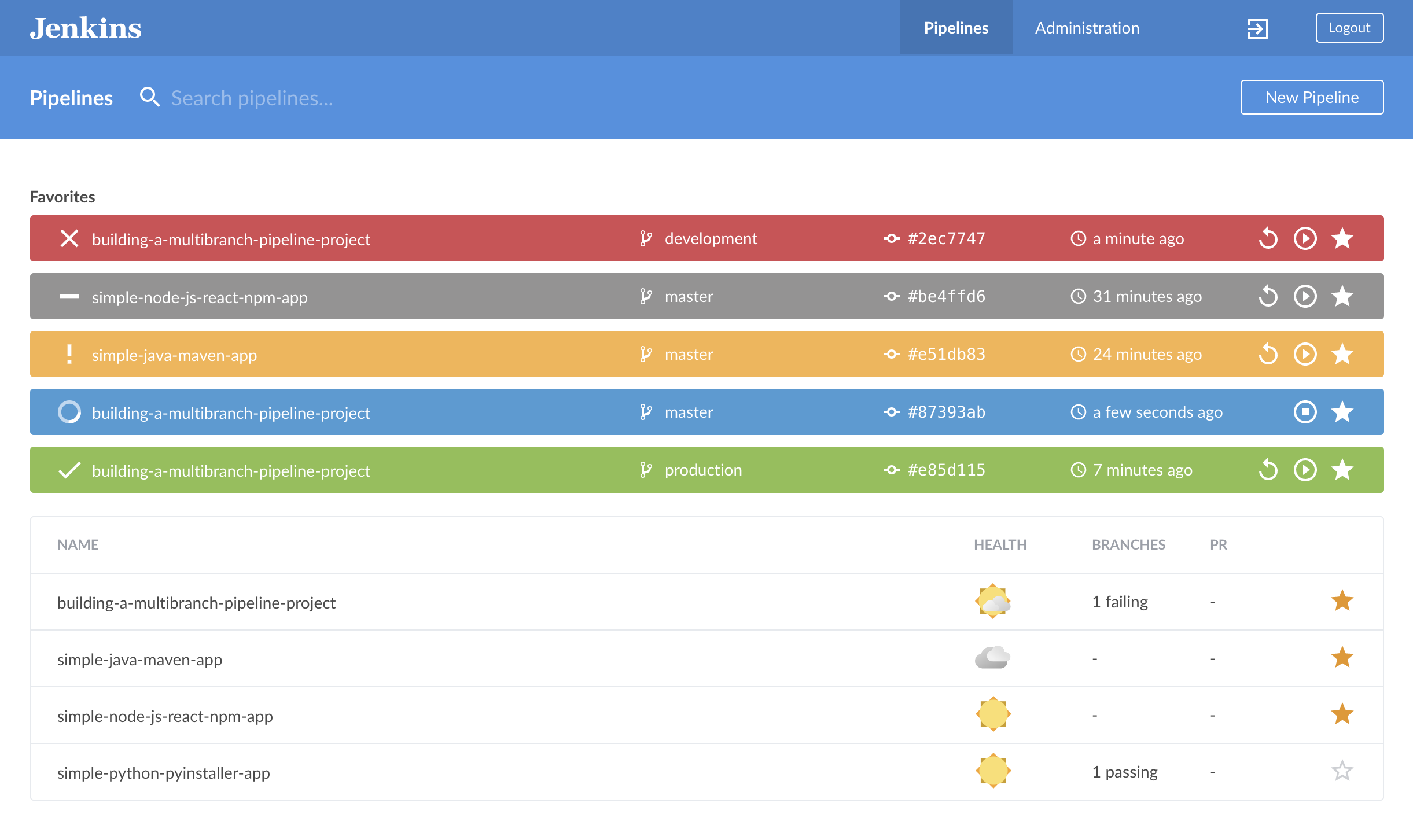

点击k Save 保存你新建的流水线项目。 Blue Ocean 在每个分支中检测

Jenkinsfile"流水线存根" 的存在并运行每条流水线以对抗其各自的分支, 它的构建结果显示在Blue Ocean主界面的 Activity 页面上。+

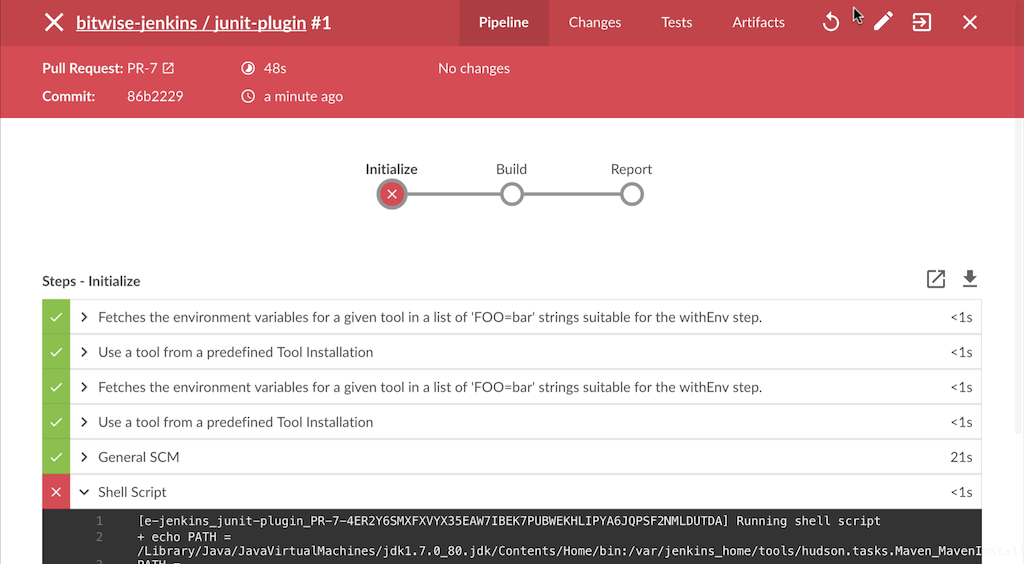

流水线存根包含一条流水线的基本要求 - 即 agent 和 stages 部分, 以及 stage 指令。为什么 building-a-multibranch-pipeline-project 仓库的原因包括Jenkinsfile 流水线存根,它的存在的作用是:在 Blue Ocean中创建流水线项目后能够立刻检测到(即 Jenkinsfile) , 这使得这些分支可以通过Blue Ocean进行访问。如果你在Blue Ocean中构建了一个流水线项目,但在你的仓库的一个或多个分支上没有一个 Jenkinsfile, 随后添加Jenkinsfile 到这些分支中,然后在Blue Ocean中访问这些分支 任一个:在多分支流水线项目中使用 Scan Multibranch Pipeline Now 特性 (可通过 Jenkins的 经典界面进行访问), 或者在 Git 仓库中实现webhooks。 | |

|---|---|

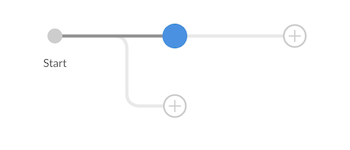

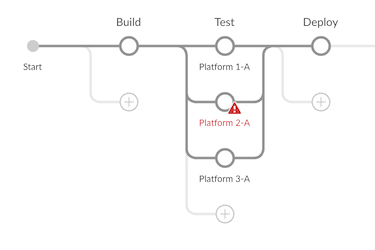

将你的带有build 和 test 阶段的初始流水线创建为Jenkinsfile

现在,你已经准备好在Jenkins中创建你的能够自动构建 Node.js 和React 应用程序的流水。 你的流水线将被创建为 Jenkinsfile, 它会提交你本地的Git仓库(building-a-multibranch-pipeline-project)的 master 分支 。

首先, 创建一个初始流水线来下载 Node Docker 镜像并将它作为Docket容器运行,它会构建简单的Node.js 和 React 应用程序。还会添加 "Build" 阶段到流水线,开始编排整个过程和"Test" 阶段 ,检查应用程序呈现的结果是否令人满意。

-

使用你最称手的文本编辑器或 IDE, 在本地

building-a-multibranch-pipeline-projectGit 仓库的根目录下打开现有的Jenkinsfile并 clear 它的内容。 Note: 确保在你的仓库的master分支上执行了该步骤。 -

复制并粘贴下面的声明式流水线代码到空的

Jenkinsfile文件中:pipeline { agent { docker { image 'node:6-alpine' args '-p 3000:3000 -p 5000:5000' } } environment { CI = 'true' } stages { stage('Build') { steps { sh 'npm install' } } stage('Test') { steps { sh './jenkins/scripts/test.sh' } } } }args使 Node 容器 (临时的) 可以通过 3000 和 5000端口进行访问。它的意义在于解释了你clone的仓库的jenkins/scripts/deliver-for-deployment.sh和jenkins/scripts/deploy-for-production.sh文件, 这将在本教程的后续部分中介绍。Note: 对

Jenkinsfile中其他组件的解释, 请参考使用npm构建Node.js和React应用教程的“Create your initial Pipeline…” 和 “Add a test stage…”章节的声明式流水线的注解。 . -

保存并提交你编辑的

Jenkinsfile文件到本地的building-a-multibranch-pipeline-projectGit 仓库。 比如在building-a-multibranch-pipeline-project目录下, 运行下面的命令:git stage .然后git commit -m "Add initial Jenkinsfile with 'Test' stage" -

再次回到Jenkins, 必要的话再次登录并进入 Jenkins的Blue Ocean的界面。

-

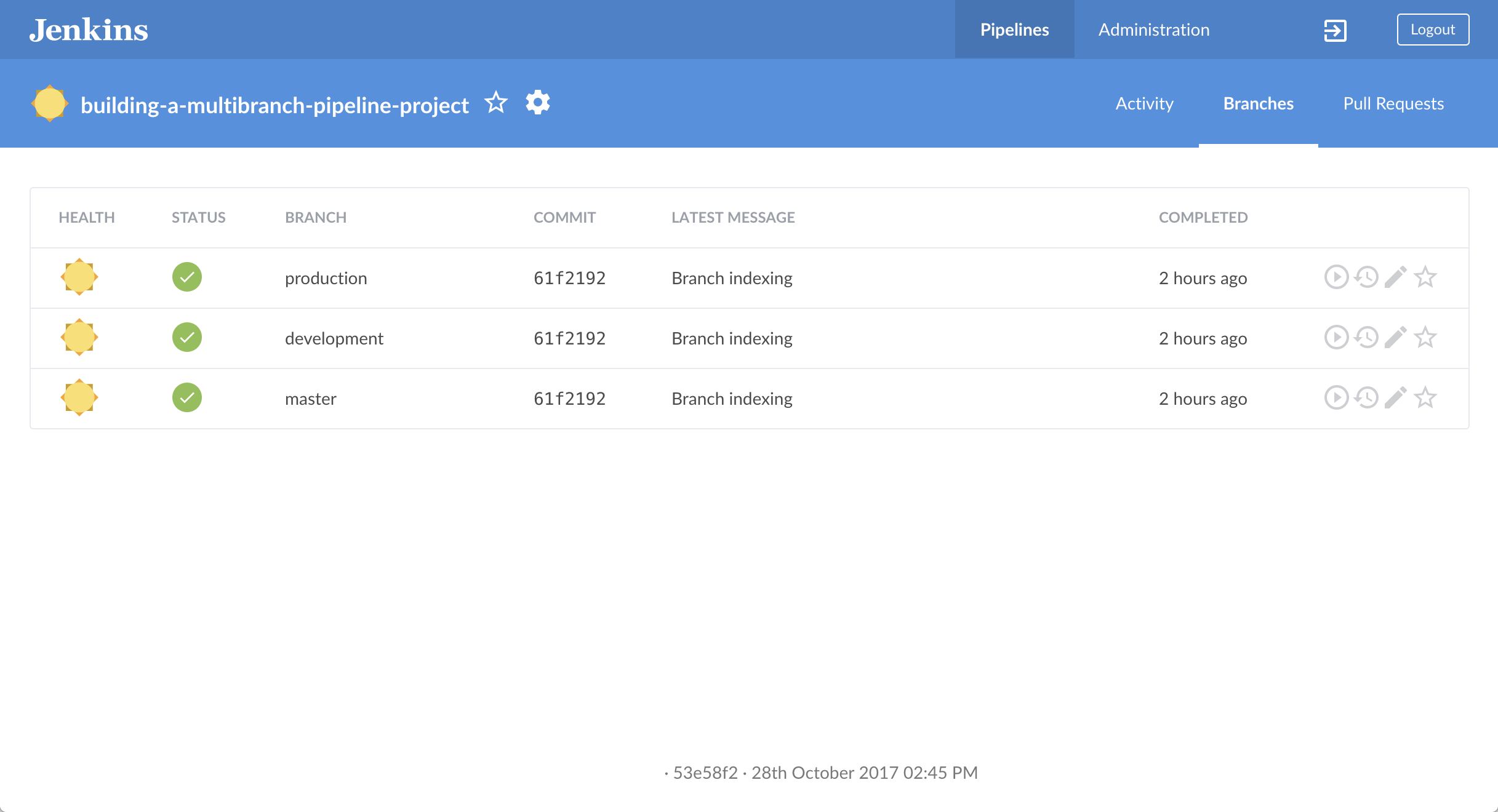

点击右上方的 Branches 进入你的流水线项目的分支列表。

-

点击你的流水线项目的

master分支的运行图标 , 然后快速的点击出现在右下方的 OPEN 链接来查看Jenkins 使用改进后的

, 然后快速的点击出现在右下方的 OPEN 链接来查看Jenkins 使用改进后的 Jenkinsfile构建master分支。 如果你点击不了OPEN 链接, 点击Blue Ocean Activity 页面 的top 行来使用这一特性。 在几分钟内, 如果Jenkins成功的从你的master分支构建了 Node.js 和 React 应用程序,Blue Ocean界面就会变成绿色。

-

点击右上方的 X 回到Blue Ocean 界面的 Activity 页面。

给你的流水线添加deliver和 deploy 阶段

接下来, 添加 "交付开发" 和 "部署生产" 阶段到你的流水线,Jenkins将会根据Jenkins所在的分支选择性的执行。

这将 "流水线即代码" 概念提升到一个新的级别, 在这个级别中, 一个单一的 Jenkinsfile 文件描述了在Jenkins中你的仓库的每个分支的整个项目的构建, 测试, 交付和部署过程。 了解更多在用户手册的 流水线 和 使用Jenkinsfile章节。

-

回到你的文本编辑器/IDE,打开

Jenkinsfile文件。 -

立刻复制并粘贴下面的声明式流水线语法到

Jenkinsfile文件的Test阶段下面:stage('Deliver for development') { when { branch 'development' } steps { sh './jenkins/scripts/deliver-for-development.sh' input message: 'Finished using the web site? (Click "Proceed" to continue)' sh './jenkins/scripts/kill.sh' } } stage('Deploy for production') { when { branch 'production' } steps { sh './jenkins/scripts/deploy-for-production.sh' input message: 'Finished using the web site? (Click "Proceed" to continue)' sh './jenkins/scripts/kill.sh' } }结果如下:

pipeline { agent { docker { image 'node:6-alpine' args '-p 3000:3000 -p 5000:5000' } } environment { CI = 'true' } stages { stage('Build') { steps { sh 'npm install' } } stage('Test') { steps { sh './jenkins/scripts/test.sh' } } stage('Deliver for development') { when { branch 'development' } steps { sh './jenkins/scripts/deliver-for-development.sh' input message: 'Finished using the web site? (Click "Proceed" to continue)' sh './jenkins/scripts/kill.sh' } } stage('Deploy for production') { when { branch 'production' } steps { sh './jenkins/scripts/deploy-for-production.sh' input message: 'Finished using the web site? (Click "Proceed" to continue)' sh './jenkins/scripts/kill.sh' } } } }when指令 (和它们的branch条件一起)决定是否stages(包括这些when指令) 会被执行。 如果branch条件的值(即模式) 与Jenkins运行构建的分支名匹配, 包含when和branch概念的stage就会被执行。Notes:

-

对

input message过程的解释, 请参考“Add a final deliver stage…” section of the Build a Node.js and React app 教程的声明式流水线的注解 4。 -

对

deliver-for-development.sh,deploy-for-production.sh和kill.sh脚本步骤的解释,请参考位于building-a-multibranch-pipeline-project仓库的根目录下的jenkins/scripts目录下的这些文件的内容。

-

-

保存并提交你编辑的

Jenkinsfile到本地的building-a-multibranch-pipeline-projectGit 仓库。 比如在building-a-multibranch-pipeline-project目录, 运行命令:git stage .然后git commit -m "Add 'Deliver...' and 'Deploy...' stages" -

再次回到Jenkins, 如果必要重新登录并进入Jenkins的Blue Ocean界面。

-

点击右上方的 Branches 来访问你的流水线项目的分支列表。

-

点击你的流水线项目的

master分支的运行图标 ,然后快速的点击出现在右下方的 OPEN 链接查看Jenkins使用改进过的

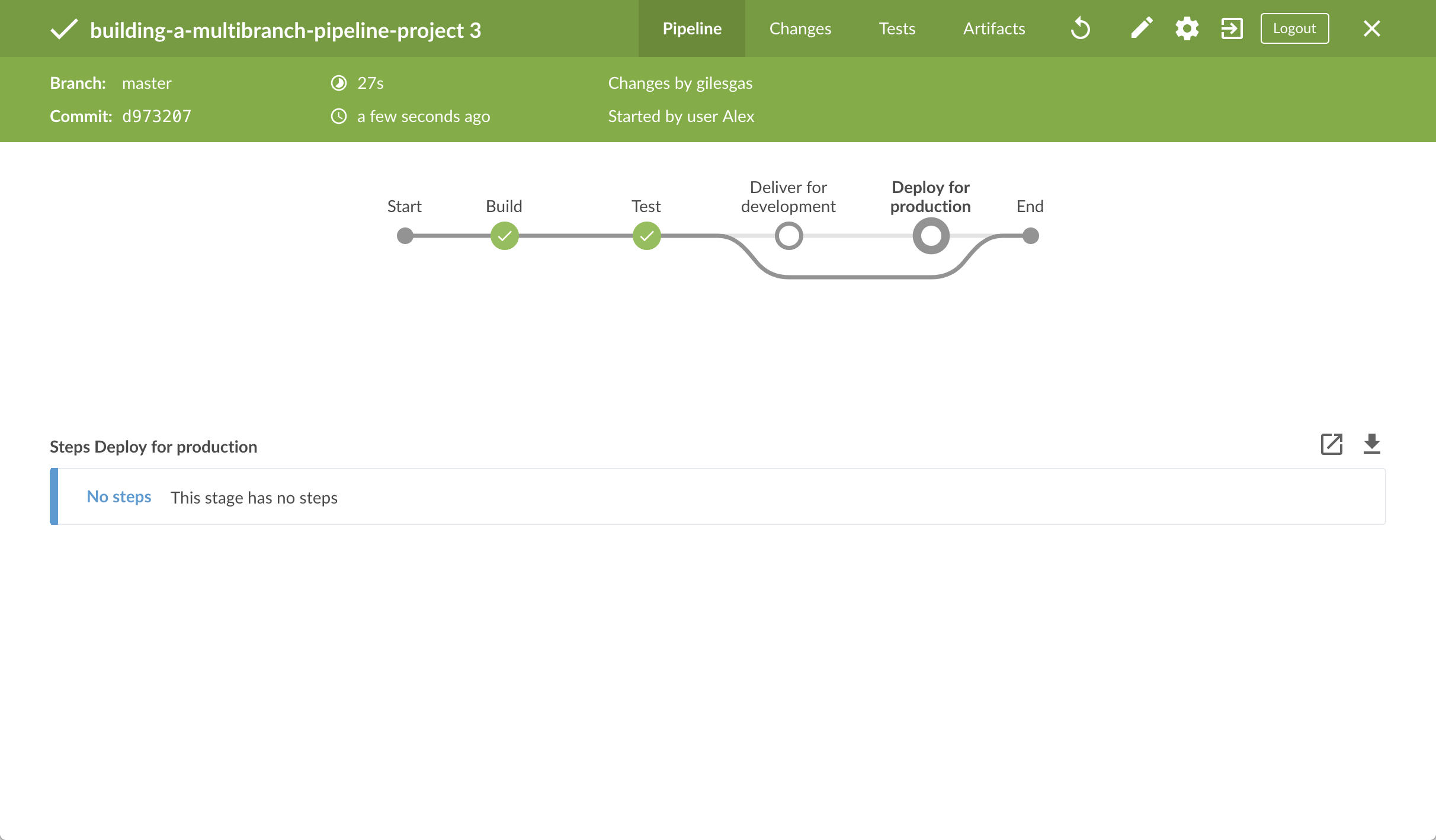

,然后快速的点击出现在右下方的 OPEN 链接查看Jenkins使用改进过的 Jenkinsfile构建master分支。I如果你点击不了 OPEN 链接, 点击Blue Ocean Activity 页面的 top 行来访问这一特性。 注意Jenkins是如何跳过你添加的最后两个阶段, 由于你正在运行构建的分支 (master) 在这些阶段不满足when指令的branch条件。

-

C点击右上方的 X 回到Blue Ocean界面的 Activity 页面。

Pull 更新的 Jenkinsfile 到其他的仓库分支中

现在你已经有一个完整的 Jenkinsfile 文件可以在Jenkins中构建你的应用, 你可以 pull 该文件从你本地仓库的 master 分支到它的 development 和 production 分支。 在你本地仓库的 building-a-multibranch-pipeline-project 目录下:

-

运行下面的命令来来pull从

master到development的改变:-

git checkout development然后 -

git pull . master

-

-

还可以运行线面的命令将更改从

masterpull到production:-

git checkout production然后 -

git pull . master

现在你的

development和production分支拥有你在master分支上对Jenkinsfile的所有修改。 -

在development分支上运行流水线

-

再次回到 Jenkins, 需要的话再次登录并进入 Jenkins的Blue Ocean界面。

-

点击右上的 Branches 进入流水线项目的分支列表。

-

点击流水线项目

development分支的运行图标 , 然后快速的点击出现在右下方的 OPEN 链接来查看Jenkins 使用改进后的

, 然后快速的点击出现在右下方的 OPEN 链接来查看Jenkins 使用改进后的 Jenkinsfile构建development分支。 如果你点击不了 OPEN 链接, 点击Blue Ocean的 Activity 页面上的 top 行来访问这一特性。 -

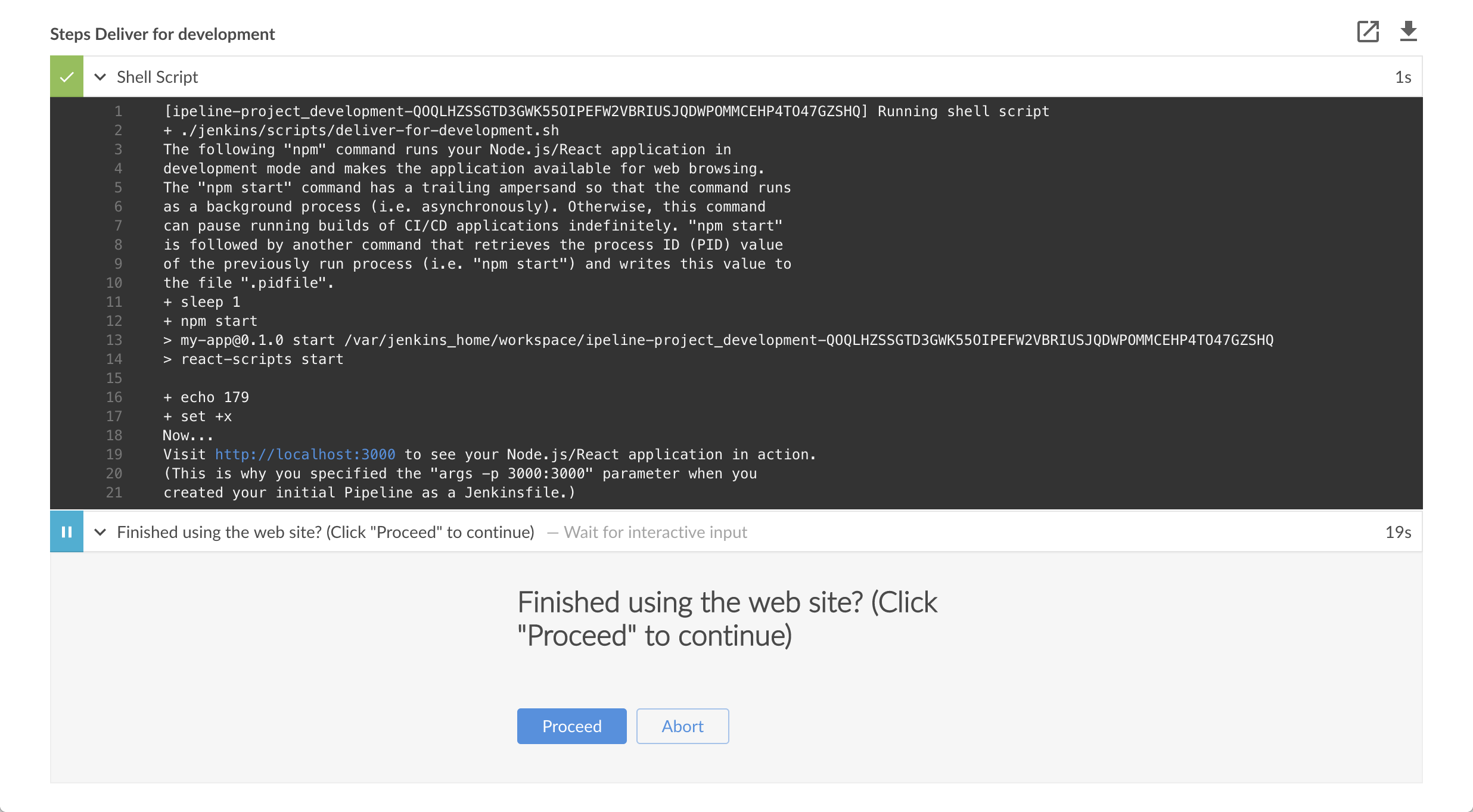

在几分钟,当构建停止时, 确保你正在查看 Deliver for development 阶段 (如果需要点击它), 然后点击顶部绿色的Shell Script 步骤来扩展它的内容 并向下滚动直到你看见

http://localhost:3000链接。 Note: 由于你正在不同的分支上构建应用程序,

Note: 由于你正在不同的分支上构建应用程序, npm install步骤需要几分钟为npm下载运行Node.js 和 React 应用所需的一些依赖 (保存在Jenkins主目录的node_modules目录下)。由于这次的Jenkins构建是你的流水线项目在development分支上的第一次运,并且每个分支都会在Jenkins的主目录中有他自己的工作区目录(包括他自己的node_modules目录),这些依赖被再次下载。 -

点击

http://localhost:3000链接查看Node.js 和 React 应用在开发模式下在一个新的web浏览器选项卡中运行 (使用npm start命令) 。 你应该会看到一个标题为 Welcome to React的页面/站点。 -

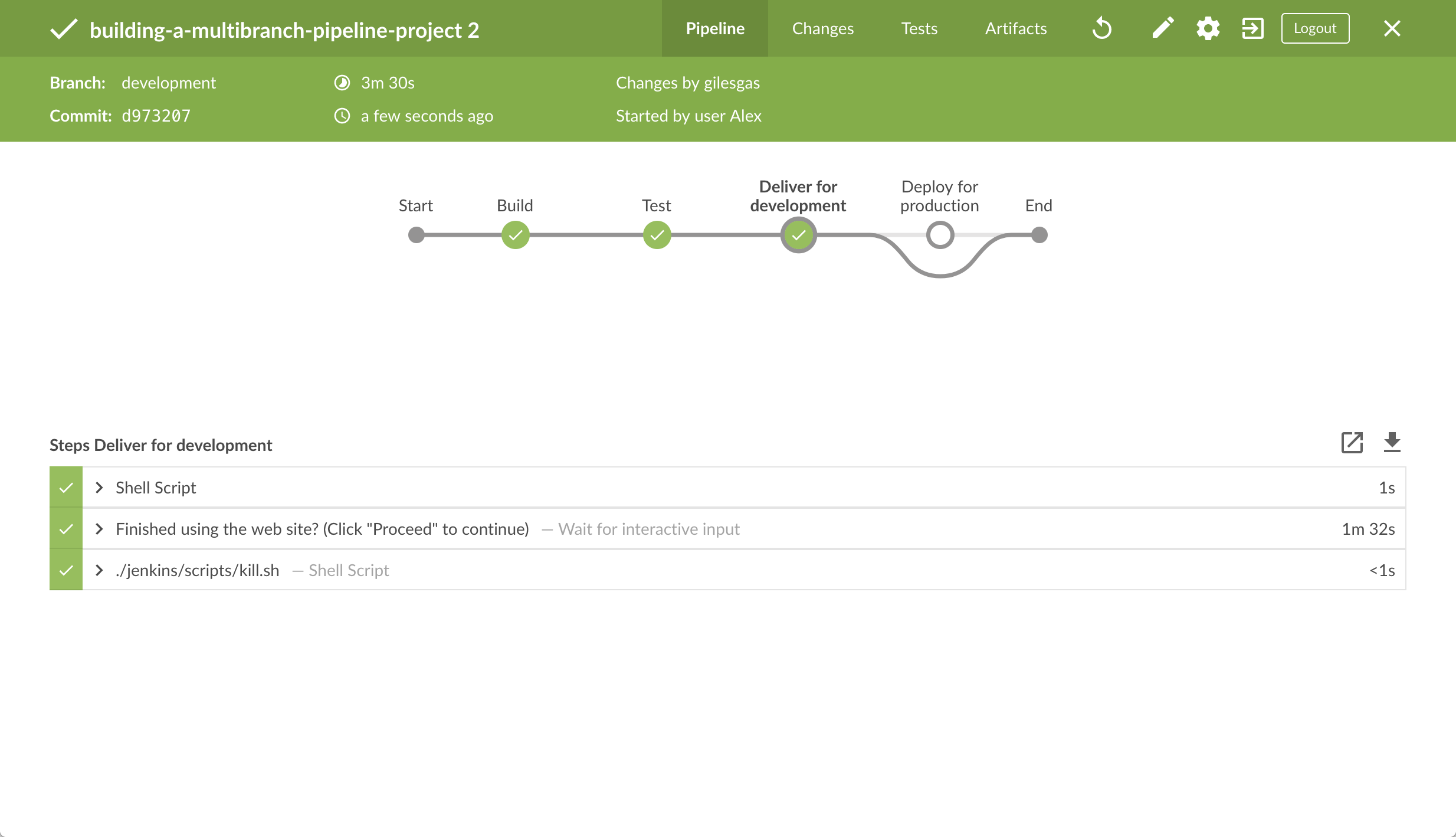

当你查看完页面/站点, 在Blue Ocean点击 Proceed 按钮完成流水线的执行。 如果Jenkins成功在

development分支上构建Node.js 和 React 应用程序,Blue Ocean界面就会变成绿色。注意 Deliver for development 阶段是如何被执行的 ,而Deploy for production 阶段却没有执行。

-

点击右上方的 X 回到Blue Ocean界面的Activity 页面。

在production分支上运行流水线

-

点击右上方的 Branches 来访问你的流水线项目的分支列表。

-

点击你的流水线项目的

production分支的运行图标 , 然后快速的点击出现在右下方的 OPEN 链接查看Jenkins使用改进后的

, 然后快速的点击出现在右下方的 OPEN 链接查看Jenkins使用改进后的 Jenkinsfile构建production分支。如果 你不能点击 OPEN 链接, 点击Blue Ocean Activity 页面的 top 行来访问这一特性。 -

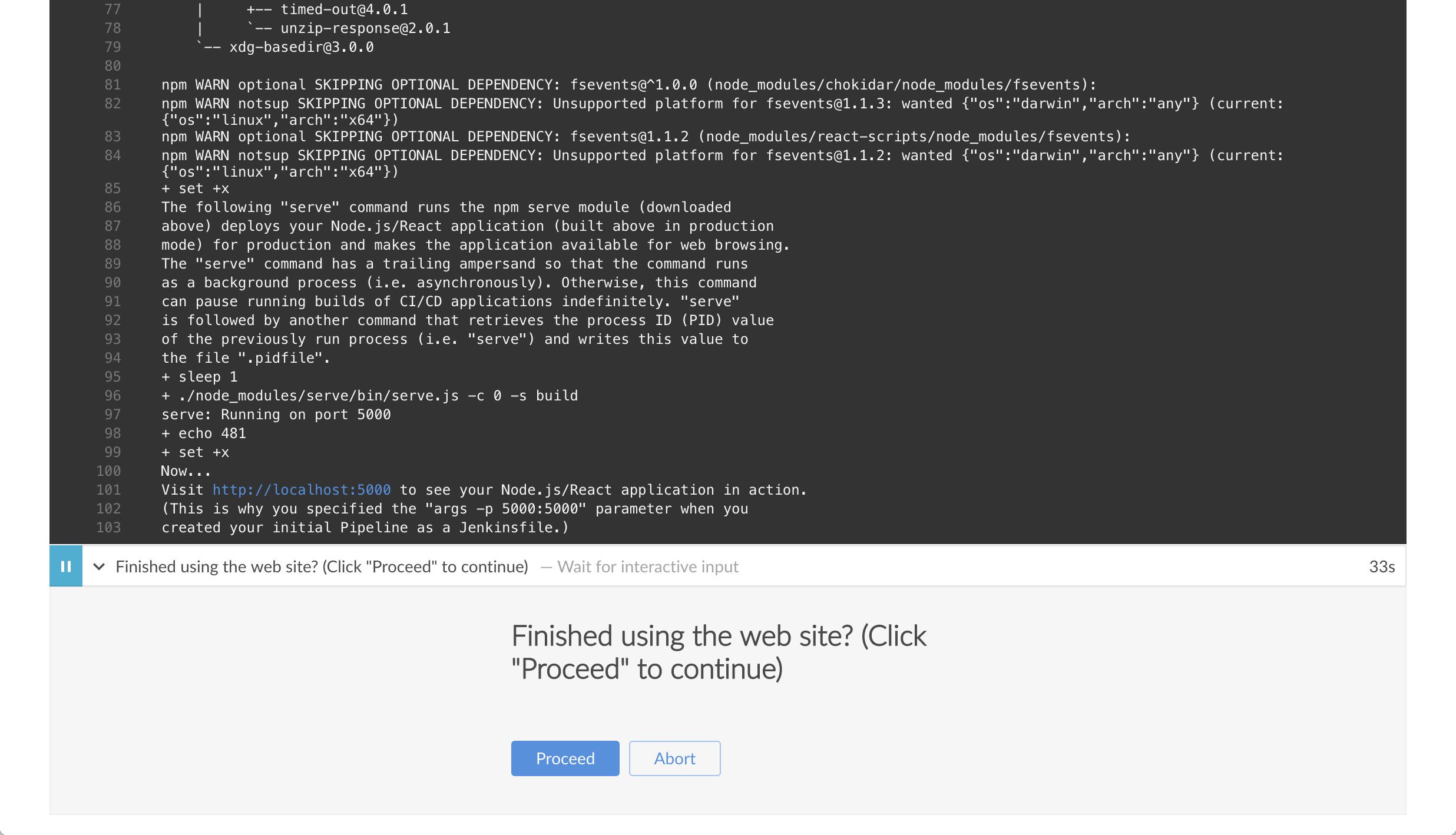

在几分钟内,当构建停止时, 确保你正在查看 Deploy for production 阶段 (如果必要点击它), 然后点击顶部绿色的Shell Script 步骤来扩展它的内容并向下滚动直到你看到

http://localhost:5000链接。

-

点击

http://localhost:5000链接在一个新的web浏览器选项卡中查看你的Node.js 和 React应用。他将会在生产模式下从你的源代码的生产构建开始运行(使用npm run build命令生产)。 同样的, 你会看到一个标题为Welcome to React的页面/站点 然而, 这一次, 该应用程序的内容是由 npmservemodule提供的,并且很可能会继续在你浏览器的后台运行。 -

当你查看完网页/站点, 在Blue Ocean中点击 Proceed 按钮 完成流水线的执行。 如果Jenkins 从

production分支成功production构建你的Node.js 和 React 应用,Blue Ocean界面就会变成绿色。 注意 Deploy for production 阶段是如何被执行的,而 Deliver for development 阶段被跳过。

-

点击右上方的 X 回到Blue Ocean界面的 Activity p页面。+ Note: 由于你的浏览器很可能会继续运行npm

serve模块提供的应用内容, 在Jenkins关闭serve进程后,你的浏览器仍然会长时间显示你在http://localhost:5000查看过的内容 。 在below阅读更多关于如何从你的浏览器清除应用程序和它的内容。

跟踪 (可选)

本节将向你介绍使用Jenkins的一种类似的开发工作流程,在它们被部署到生产 (从 production 分支)前,从development分支经由master 分支对你的应用程序 (即 App.js 源文件) 进行更改。

-

在你本地仓库的

building-a-multibranch-pipeline-project目录下, 运行命令git checkout development更改development分支。 -

回到你的文本编辑器/IDE,打开你本地的

building-a-multibranch-pipeline-projectGit仓库的src目录下的App.js文件。 -

立刻复制并粘贴下面的HTML语法到

App.js文件的To get started…行下面:<br/> This is a new line I added.结果如下:

import React, { Component } from 'react'; import logo from './logo.svg'; import './App.css'; class App extends Component { render() { return ( <div className="App"> <header className="App-header"> <img src={logo} className="App-logo" alt="logo" /> <h1 className="App-title">Welcome to React</h1> </header> <p className="App-intro"> To get started, edit <code>src/App.js</code> and save to reload. <br/> This is a new line I added. </p> </div> ); } } export default App; -

保存并提交你编辑的