近年来,智能写作机器人逐渐进入互联网,为人们提供简单的仿写、伪原创等仿写。但是,由于大多数仿写机器人只能被动地响应用户的请求,同时,大多数客人不知道仿写机器人的功能,甚至不知道它们能否正常工作,所以很多人不会轻率地选择仿写机器人。

这种现象使得仿写机器人大部分时间很难发挥实际作用,使用和互动的频率很低,使其成为“移动平板电脑”。如果仿写机器人能够主动关注工作区域的场景,针对有潜在需求的访客,在客户要求之前发起互动,既能让人有宾至如归的感觉,又能主动让用户了解仿写机器人的功能,使机器人更加智能化、人性化,增强客人体验。

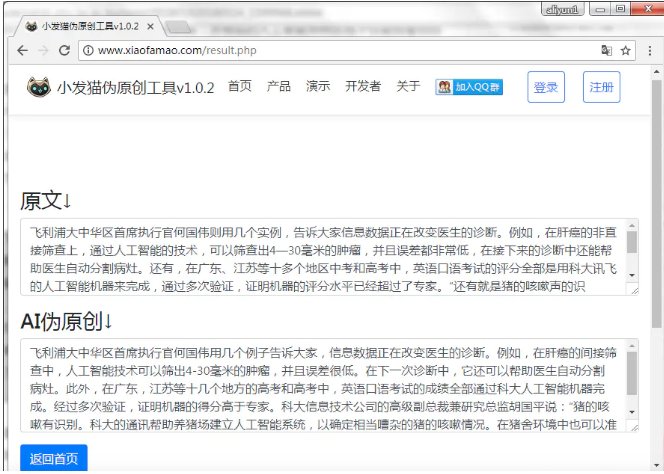

为此,互联网工程师率先在小发猫机器人上进行了技术创新。小发猫机器人降落在互联网公司各个办公楼的大堂,提供欢迎咨询、引导讲解、互动娱乐等功能,是互联网对外欢迎的重要组成部分。这项技术的目的是使小发猫机器人能够了解当前的场景,发现用户的潜在意图,并主动启动交互的第一步。

主动交互虽然在学术界已经做了一些前期工作,但主要是通过距离传感器、摄像头等设备感知行人的意图,按照预设的交互规则发起简单而宽泛的交互,比如简单地打招呼、握手等。但是这些交互模式通常都是非常有限的(比如不到10个)。

为了让机器人更好地理解场景的细节,带来更加智能、友好和自然的交互体验,互联网提出了一种全新的“中文表达方式转换器”(简称XX-BB)。该系统不仅可以观察场景,主动发起互动和引导,还包括一千多个多模态动作,可以像人类一样表现出自然主动的问候。接下来,让我们跟随示范视频来看看机器人在小发猫的新技能。

互联网提出的XX-BB框架是业界首次尝试将主动互动扩展为集表达、行动和丰富言语为一体的多模态互动模式。通过目标检测器,将可能对主动交互产生影响的相关对象提取为覆盖视觉和相对空间信息的视觉表征,然后利用Transformer网络学习一段时间内视觉表征之间的关系,从而实现交互主体的时空建模,预测交互主体是否有潜在的交互意图,以及在当前帧中什么是合适的多模态动作画。

本工作以小型机器人为主体,构建了完整的主动交互解决方案,包括数据采集、模型训练和嵌入式设备部署。小机器人工作的真实环境(通常是公共场所、大堂等)。)非常复杂,各种光照环境也给基于计算机视觉技术的主动交互计算带来巨大挑战。

为此,互联网在几个大厅收集了不同场景的视频片段,并标注了合适的触发时间点和多模态动作。总共标记了数千小时的视频剪辑,包括3800个需要启动主动交互的场景。数据和交互专家标注了1000多个多模态动作组合,并利用采样技术获取足够的负样本辅助训练。

XFM框架包括三个模块:可视化令牌提取器、多模态动作表示和基于Transformer的交互决策模型,如下图所示。TFVT-HRI框架首先使用Yolo作为视觉特征提取器,提取每个帧图像中多个物体和人的区域,并结合位置信息生成表示(a)。接下来,多帧连续信息由变换器模型(B)编码。这样,模型不仅可以得到图像中每个物体随时间运动的轨迹,还可以得到人物之间的互动关系,这对理解场景起着至关重要的作用。另一方面,我们对专家注释的多模态动作进行编码,其中语言由ERNIEE编码,ERNI是互联网,的大规模语义理解模型,动作由嵌入(C)表示。这种编码方法在语言上有很好的概括和理解能力。最后,模型需要决定是否发起主动交互和选择多模态动作。

浙公网安备 33010602011771号

浙公网安备 33010602011771号