元学习——Meta-Amortized Variational Inference and Learning

作者:凯鲁嘎吉 - 博客园 http://www.cnblogs.com/kailugaji/

这篇博客是论文“Meta-Amortized Variational Inference and Learning”的阅读笔记。博客中前半部分内容与变分自编码器(VAE)的推导极为类似,所涉及的公式推导如果有不明白的地方,可以提前阅读这篇博客:变分推断与变分自编码器。主要涉及到了概率论的相关知识。这篇博客介绍了精确推理(Exact Inference),近似变分推理(Approximate Variational Inference),摊销变分推理(Amortized Variational Inference),摊销变分自编码器(Amortized Variational Autoencoders),元摊销变分推理(Meta-Amortized Variational Inference),以及论文中提出的元变分自编码器(MetaVAE)。主要阅读了论文原理部分,实验部分没有去关注。

尽管最近在概率建模及其应用方面取得了成功,但使用传统推理技术训练的生成模型很难适应新的分布,即使目标分布可能与训练中已见过的分布密切相关。这篇文章提出了一个双重摊销变分推理模型,以解决这一挑战。通过不仅在一组查询输入中共享计算,而且在一组不同但相关的概率模型中共享计算,所提算法学习到了可迁移的潜在表示,这些表示可在多个相关的分布中进行拓展。特别地,给定一组在图像上的分布,所提算法找到了学习表示,以迁移到不同的数据变换。在MNIST(10-50%)和NORB(10-35%)上,通过引入MetaVAE验证了该方法的有效性,并表明该方法在下游图像分类任务中显著优于基准结果。

1. Exact and Approximate Inference (精确与近似推理)

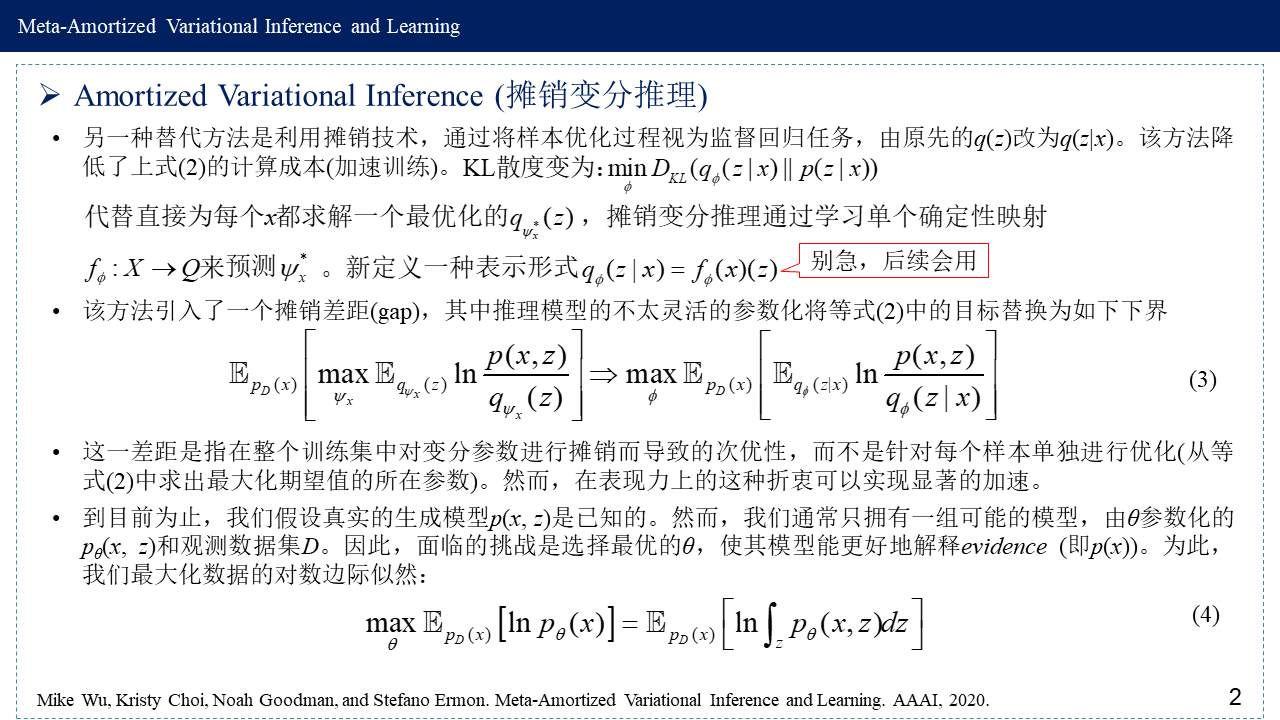

2. Amortized Variational Inference (摊销变分推理)

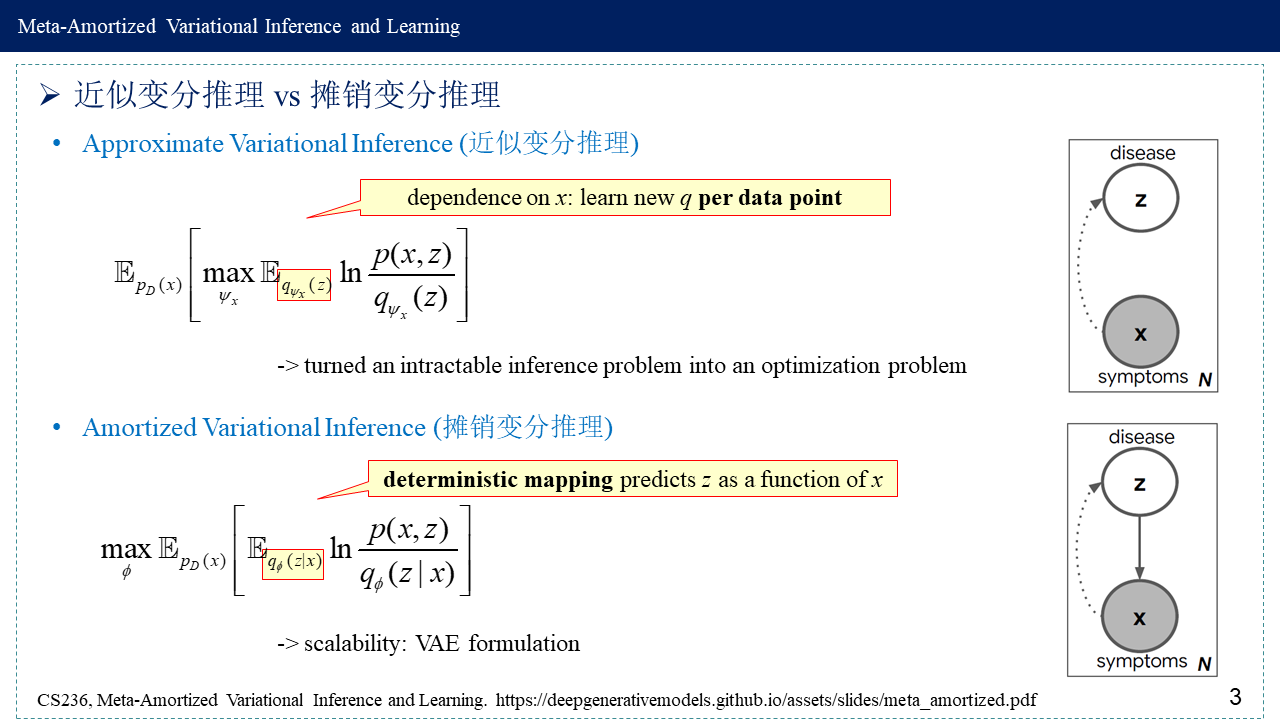

3. 近似变分推理 vs 摊销变分推理

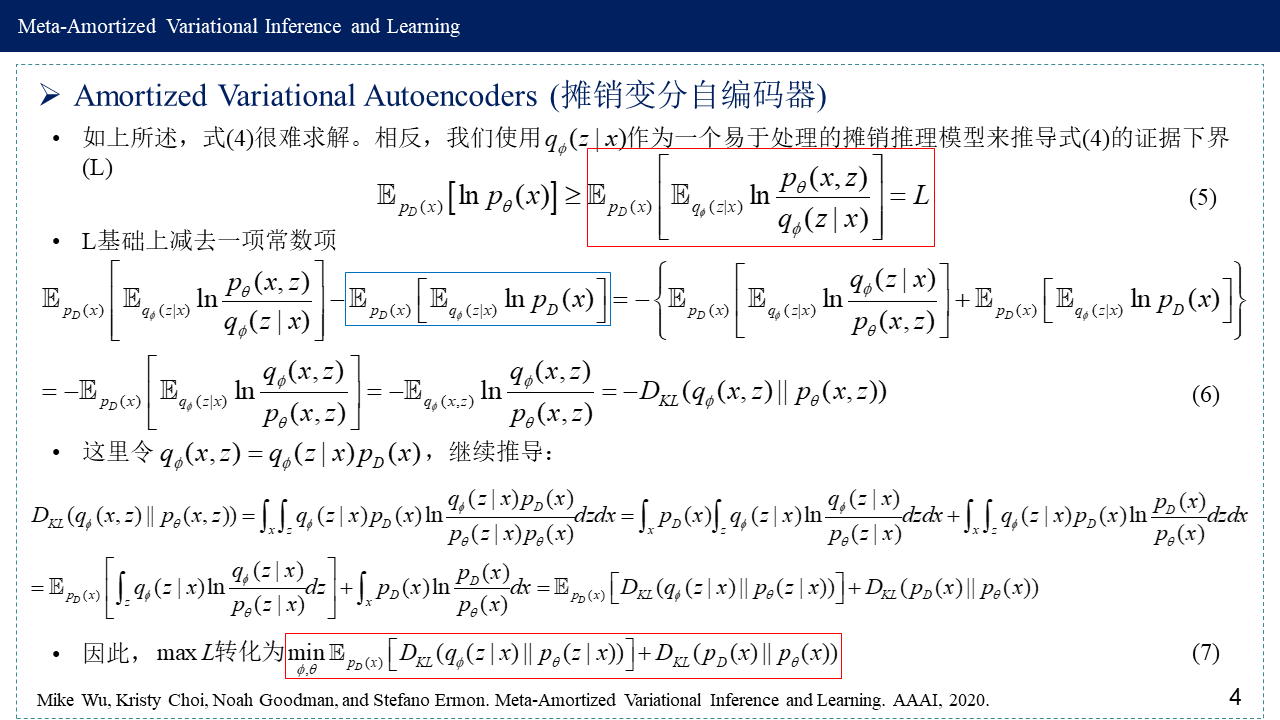

4. Amortized Variational Autoencoders (摊销变分自编码器)

这部分内容推导与直面联合分布很类似,可以参看:https://www.cnblogs.com/kailugaji/p/12463966.html#_lab2_0_2

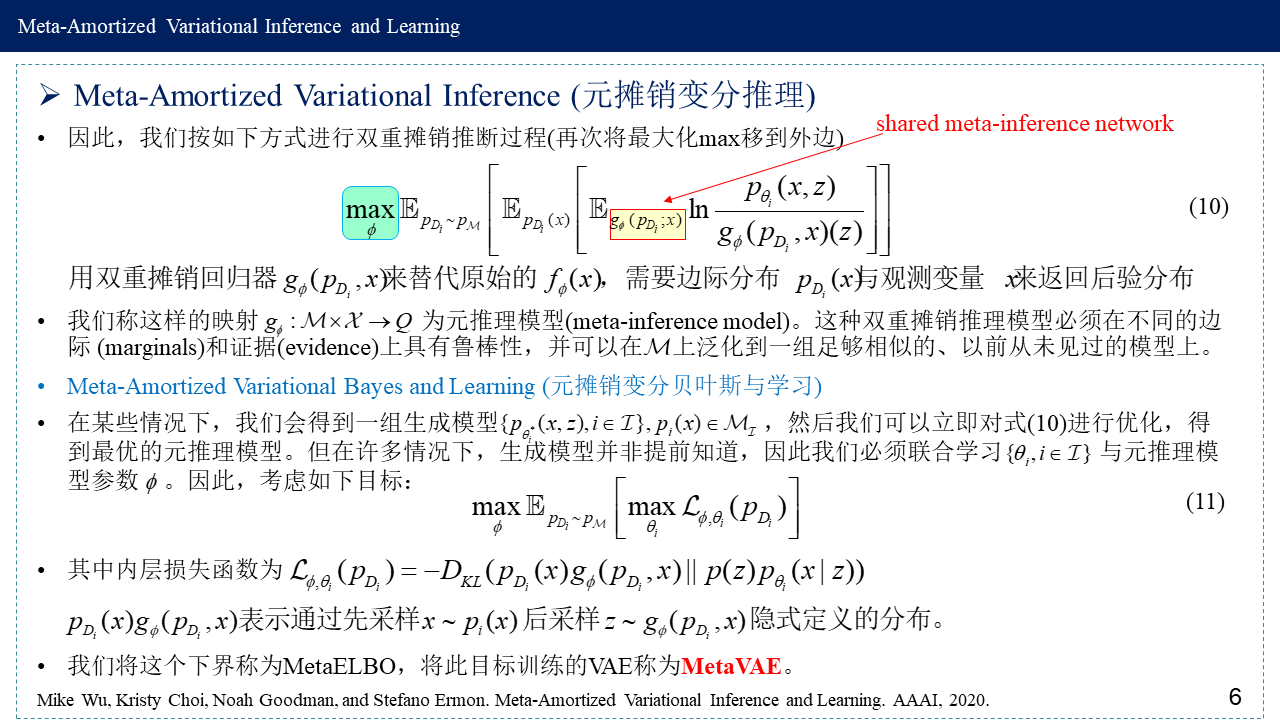

5. Meta-Amortized Variational Inference (元摊销变分推理)

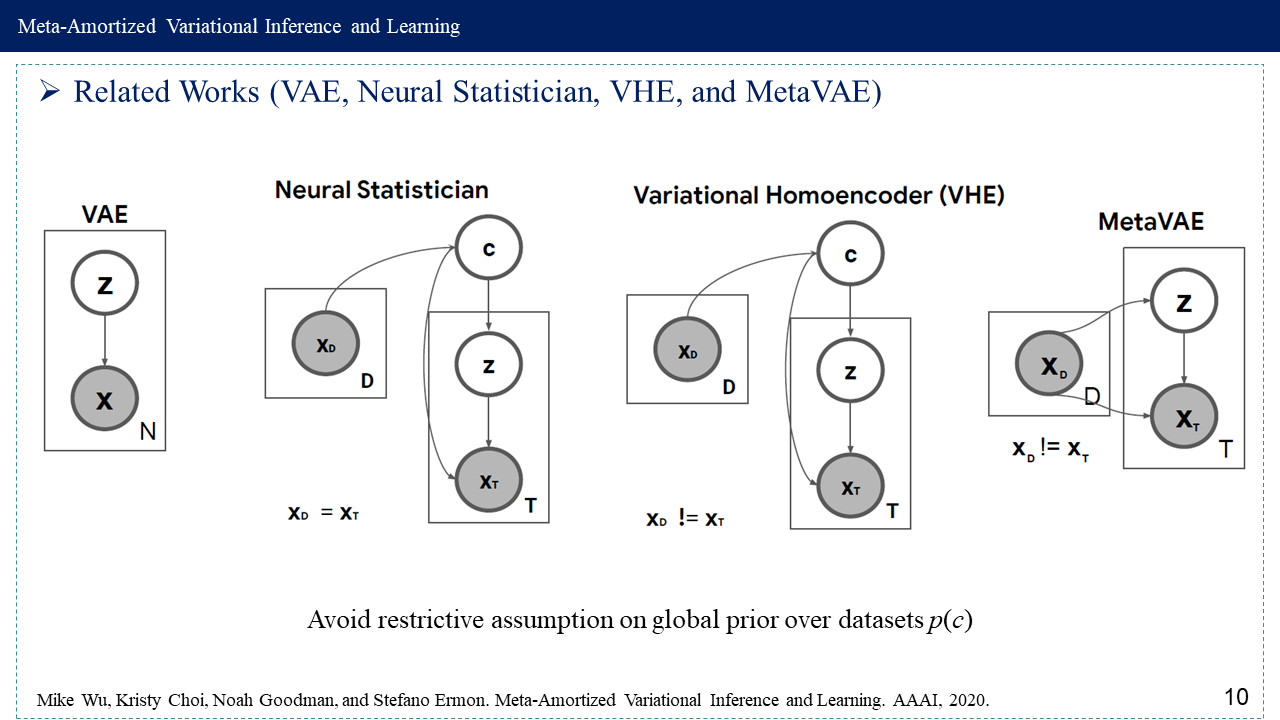

6. Related Works (VAE, Neural Statistician, VHE, and MetaVAE)

7. 参考文献

[1] Mike Wu, Kristy Choi, Noah Goodman, and Stefano Ermon. Meta-Amortized Variational Inference and Learning. AAAI, 2020.

Paper: https://ojs.aaai.org//index.php/AAAI/article/view/6111

Code: https://github.com/mhw32/meta-inference-public

[2] CS236, Meta-Amortized Variational Inference and Learning. https://deepgenerativemodels.github.io/assets/slides/meta_amortized.pdf

[3] Variational Inference: Foundations and Modern Methods, P100 Amortizing Inference, 2016, https://media.nips.cc/Conferences/2016/Slides/6199-Slides.pdf

[4] 2021 Pyro Fundamentals, Amortized Inference, and Variational Autoencoders, https://robsalomone.com/wp-content/uploads/2021/07/L4_VAE.pdf

[5] Rui Shu, Hung H. Bui, Shengjia Zhao, Mykel J. Kochenderfer, Stefano Ermon. Amortized Inference Regularization. NeurIPS 2018, https://papers.nips.cc/paper/2018/hash/1819932ff5cf474f4f19e7c7024640c2-Abstract.html

[6] Amortized Optimization - Rui Shu http://ruishu.io/2017/11/07/amortized-optimization/