重要性采样(Importance Sampling)——TRPO与PPO的补充

作者:凯鲁嘎吉 - 博客园 http://www.cnblogs.com/kailugaji/

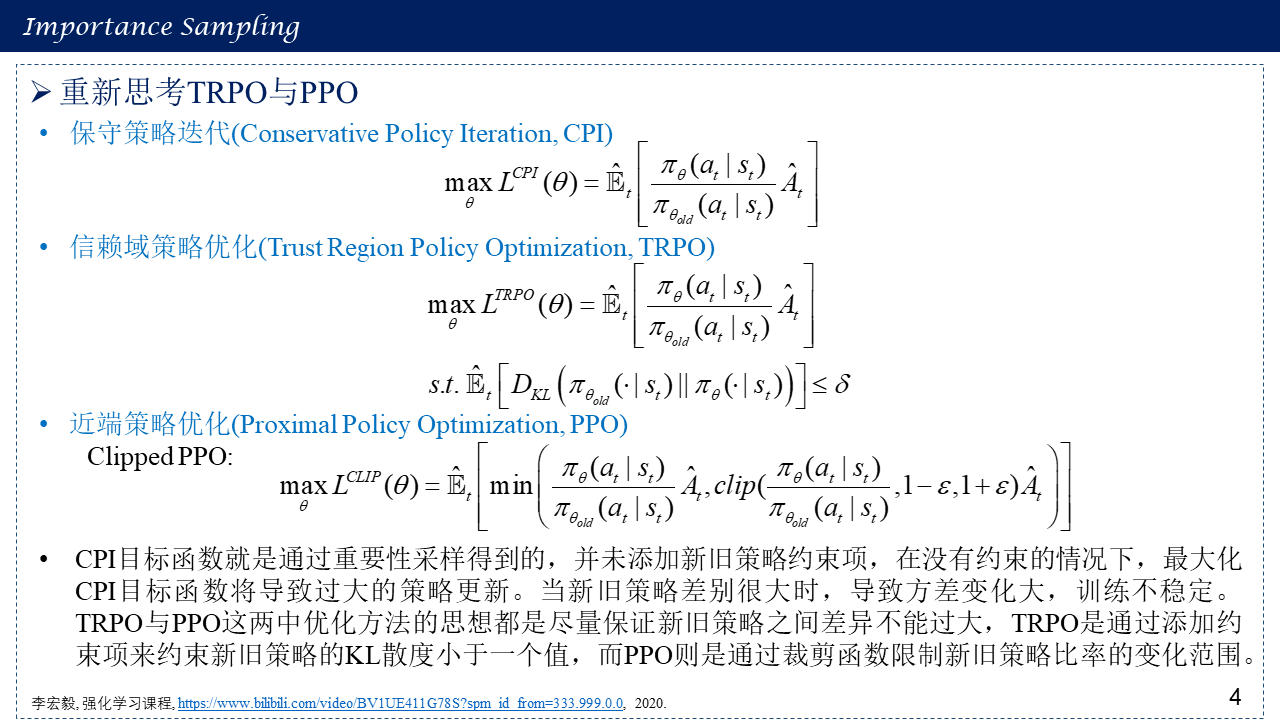

上两篇博客已经介绍了信赖域策略优化(Trust Region Policy Optimization, TRPO)与近端策略优化算法(Proximal Policy Optimization Algorithms, PPO),他们用到一个重要的技巧就是:重要性采样。但是都需要限制新旧策略使两者差异不能太大,TRPO通过添加新旧策略的KL约束项,而PPO是限制两者比率的变化范围,这究竟是为什么呢?不加这个约束会怎样?下面通过对重要性采样进行分析,来解答这个问题。更多强化学习内容,请看:随笔分类 - Reinforcement Learning。

1. 采样法(Sampling Method)/蒙特卡罗方法(Monte Carlo Method)

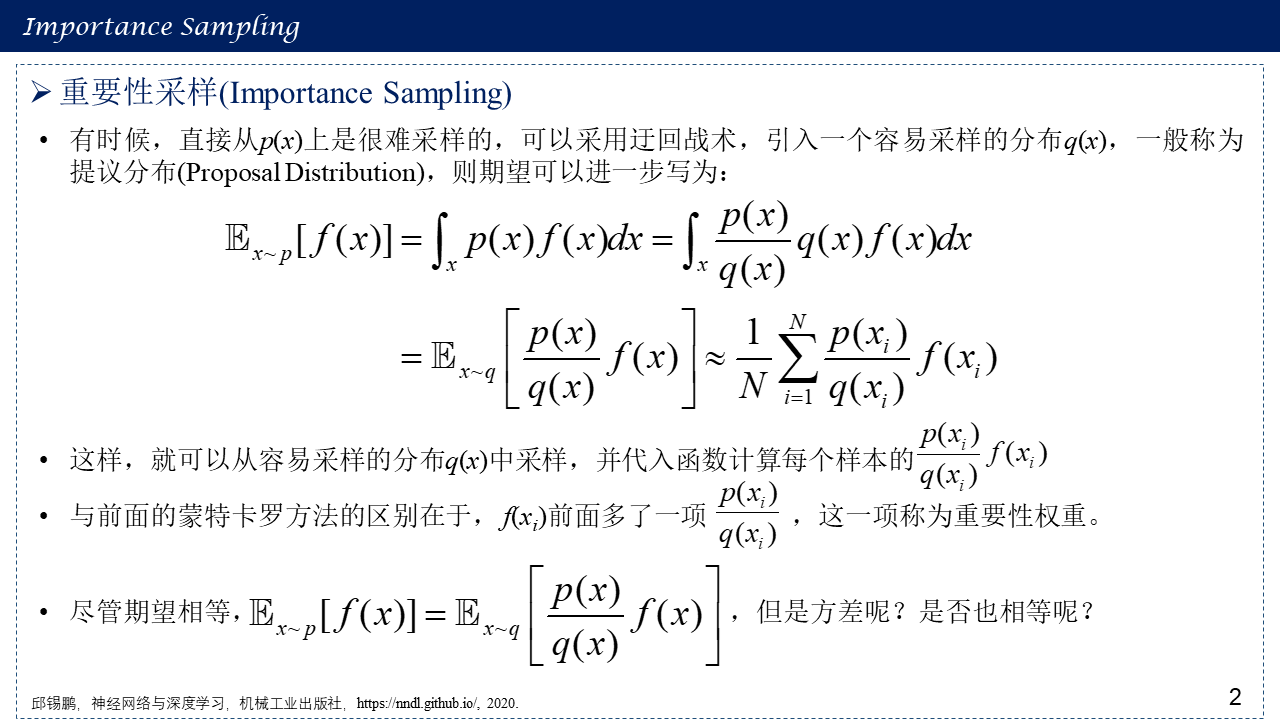

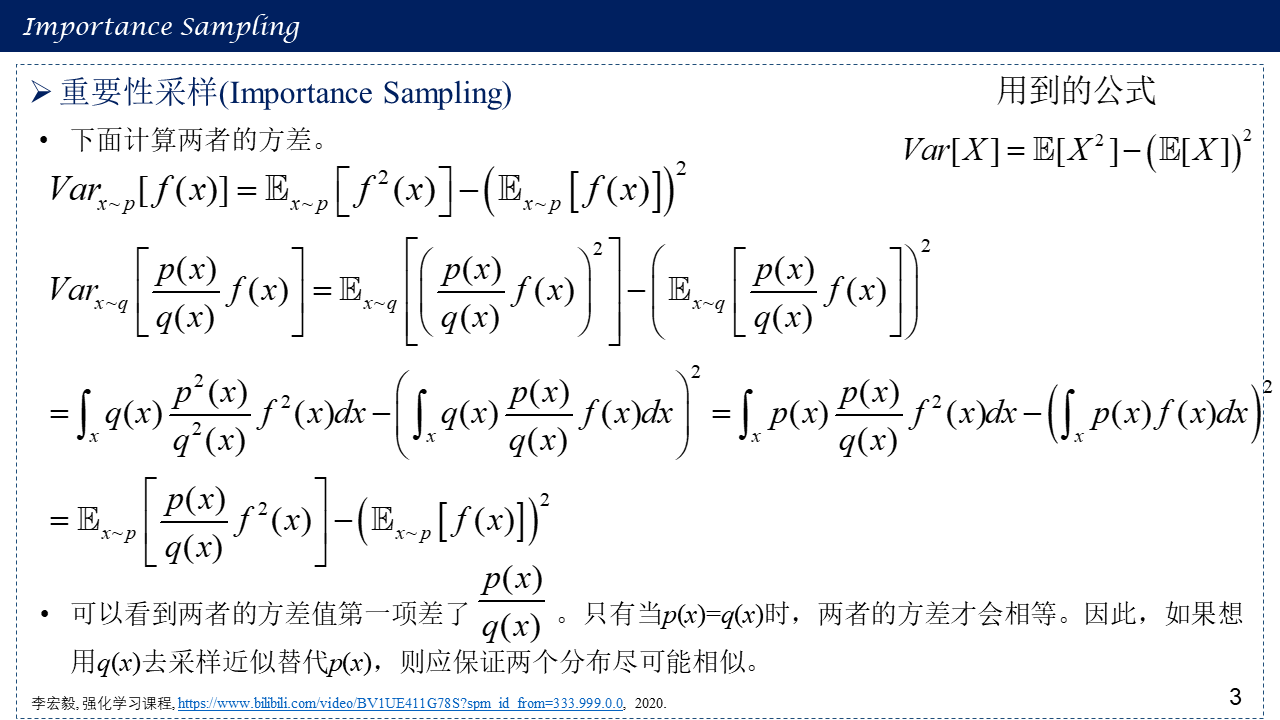

2. 重要性采样(Importance Sampling)

3. 重新思考TRPO与PPO

4. 参考文献

[1] 茆诗松, 程依明, 濮晓龙. 概率论与数理统计教程. 高等教育出版社, 2011.

[2] 邱锡鹏,神经网络与深度学习,机械工业出版社,https://nndl.github.io/, 2020.

[3] 李宏毅, 强化学习课程, https://www.bilibili.com/video/BV1UE411G78S?spm_id_from=333.999.0.0, 2020.

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步