如何得到深度学习模型的参数量和计算复杂度

摘要:1.准备好网络模型代码 import torch import torch.nn as nn import torch.optim as optim # BP_36: 输入2个节点,中间层36个节点,输出25个节点 class BP_36(nn.Module): def __init__(self)

阅读全文

posted @

2025-01-03 21:24

孜孜不倦fly

阅读(387)

推荐(0)

神经网络中间层特征图可视化(输入为音频)(二)

摘要:相比方法(一)个人感觉这种方法更好 import librosa import numpy as np import utils import torch import matplotlib.pyplot as plt class Hook: def __init__(self): self.fea

阅读全文

posted @

2023-11-22 16:17

孜孜不倦fly

阅读(127)

推荐(0)

神经网络中间层特征图可视化(输入为音频)(一)

摘要:import librosa import numpy as np import utils import torch import torch.nn.functional as F from matplotlib import pyplot as plt from torchvision.mode

阅读全文

posted @

2023-11-14 11:51

孜孜不倦fly

阅读(73)

推荐(0)

上采样的几种方式

摘要:1.插值 import torch.nn.functional as F //init中 self.up = nn.Upsample(size = (256, 2), mode = "nearest") //forward中 F.interpolate(input, size=None, scale

阅读全文

posted @

2023-10-26 20:14

孜孜不倦fly

阅读(77)

推荐(0)

深度学习设置随机数种子

摘要:seed = 2023 torch.manual_seed(seed) # torch的CPU随机性,为CPU设置随机种子 torch.cuda.manual_seed(seed) # torch的GPU随机性,为当前GPU设置随机种子 torch.cuda.manual_seed_all(seed

阅读全文

posted @

2023-10-22 11:17

孜孜不倦fly

阅读(156)

推荐(0)

打印numpy数组和张量tensor的形状

摘要:**一.打印np数组** ``` import numpy as np arr = np.array([13, 2500]) print(np.shape(arr)) ``` **二.打印tensor张量** ``` import torch arr = torch.Tensor([[1, 2, 3

阅读全文

posted @

2023-08-31 22:27

孜孜不倦fly

阅读(142)

推荐(0)

tensor和np互相转换

摘要:**1.tensor转np** ``` # 创建一个形状为[2, 2, 40, 256]的随机张量 torch_tensor = torch.rand(2, 2, 40, 256) # 将tensor转换为NumPy数组 numpy_array = torch_tensor.numpy() ```

阅读全文

posted @

2023-08-28 16:25

孜孜不倦fly

阅读(43)

推荐(0)

python数据切片特点

摘要:1.python的数据用[ ]选择数据下标 2.python的下标从0开始 3.python的数据切片是“左闭右开的”,例如:python中写a[0:5],实际上是取a中下标为“0-4”的元素,即实际中的第1~5个元素。

阅读全文

posted @

2023-07-31 11:39

孜孜不倦fly

阅读(32)

推荐(0)

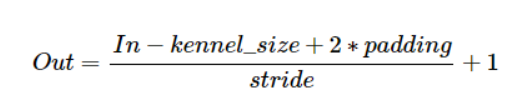

使用nn.Conv2d()和nn.MaxPool2d()调整输出的技巧

摘要:前提是没有使用dilation,牢记以下公式:  1.如果想保持张量大小不变,则:kenel_size=3(奇数),

阅读全文

posted @

2023-07-28 15:37

孜孜不倦fly

阅读(127)

推荐(0)

nn.MaxPool2d()、transpose().contiguous()、view()说明

摘要:**1.nn.MaxPool2d()** 和nn.Conv2D()基本一样,但是stride默认值是kernel_size。 **2.transpose().contiguous()、view()** contiguous一般与transpose,permute,view搭配使用:使用transpo

阅读全文

posted @

2023-07-26 22:35

孜孜不倦fly

阅读(93)

推荐(0)

nn.Conv2d()参数说明、输入输出

摘要:**1.参数说明**  **2.输入输出参数计算**

推荐(0)

获取模型的参数量和计算复杂度

摘要:``` import torch import net.bilstm import net.transformer from ptflops import get_model_complexity_info device = torch.device("cuda:0" if torch.cuda.i

阅读全文

posted @

2023-07-20 16:58

孜孜不倦fly

阅读(246)

推荐(0)

一些报错以及解决办法_1

摘要:**1.**报错信息:TYPEERROR: MAX() RECEIVED AN INVALID COMBINATION OF ARGUMENTS - GOT (AXIS=INT, OUT=NONETYPE, ), BUT EXPECTED ONE OF: 报错代码为: ``` def f1_over

阅读全文

posted @

2023-07-05 20:02

孜孜不倦fly

阅读(504)

推荐(0)

调整网络中参数的形状

摘要:1.首先阅读数据预处理的代码,确定送入神经网络的输入x的张量形状。比如现在有个语音输入特征张量x形状为[16, 1, 256, 40],【批量,通道数,像素宽度,特征维度】。 如果看不懂,可以先在网络的forward最开始进行print(x.shape)打印。 2.常见改变张量形状的方法: (1)

阅读全文

posted @

2023-07-05 11:56

孜孜不倦fly

阅读(79)

推荐(0)

深度学习代码实践_train.py文件内容(识别数字0-9)

摘要:``` import cv2 from MLP import MLP from Cnn import save_model import torch import torch.nn.functional as F from sklearn.metrics import accuracy_score,

阅读全文

posted @

2023-05-18 19:06

孜孜不倦fly

阅读(121)

推荐(0)