以下操作均在主节点进行

1.环境变量

添加FLINK_HOME以及path的内容:

export FLINK_HOME=/bigdata/flink-1.6.1 export PATH=$PATH:$JAVA_HOME/bin:$ZOOKEEPER_HOME/bin:$KAFKA_HOME/bin:${FLINK_HOME}/bin

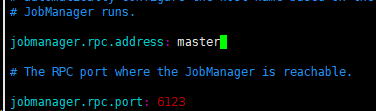

2.修改conf/flink-conf.yaml

这几乎是最简单的配置方式了,主要注意要修改jobmanager.rpc.address为集群中jobManager的IP或hostname。检查点以及HA的参数都没有配置。

jobmanager.rpc.address: master

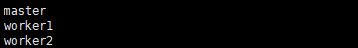

3.修改slaves文件

这个文件中存放的信息是taskmanager的hostname。

4.复制flink目录到集群中其他的机器

[root@master ~]# scp -r /bigdata/flink-1.6.1/ root@192.168.36.27:/bigdata/ [root@master ~]# scp -r /bigdata/flink-1.6.1/ root@192.168.36.28:/bigdata/

5.启动Flink集群

先启动zookeeper、kafka、HDfS。

启动Flink:[root@master ~]# start-cluster.sh

master:

[root@master ~]# jps 961 Kafka 22306 QuorumPeerMain 16786 ResourceManager 858 StandaloneSessionClusterEntrypoint 15996 SecondaryNameNode 1404 TaskManagerRunner 13853 NameNode 32701 DataNode 431 Jps

worker1:

[root@worker1 ~]# jps 32372 StandaloneSessionClusterEntrypoint 25285 Kafka 19046 QuorumPeerMain 16726 Jps 8137 NodeManager 5660 DataNode 351 TaskManagerRunner

worker2:

[root@worker2 ~]# jps 14592 TaskManagerRunner 7602 NodeManager 18388 QuorumPeerMain 4984 DataNode 14139 StandaloneSessionClusterEntrypoint 16060 Jps 23422 Kafka

关闭Flink:[root@master ~]# stop-cluster.sh