0. 关闭防火墙

重启后失效

service iptables start ;#立即开启防火墙,但是重启后失效。

service iptables stop ;#立即关闭防火墙,但是重启后失效。

重启后生效

chkconfig iptables on ;#开启防火墙,重启后生效

chkconfig iptables off ;#关闭防火墙,重启后生效

1. 配置主机

注意安装hadoop的集群主机名不能有下划线!!不然会找不到主机!无法启动!

配置主机名

# vim /etc/sysconfig/network

例如:

NETWORKING=yes

HOSTNAME=hadoop01

# source /etc/sysconfig/network

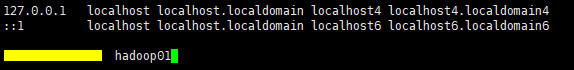

2. 配置Hosts

# vim /etc/hosts

填入以下内容:

192.168.22.130 hadoop01

注意:一定是外网IP,ifconfig查看外网IP

其他主机和ip对应信息。。。

注意:如果是Centos7,那么需要再编辑/etc/hostname文件,将其中的内容改为指定的主机名

3. 配置免密码互通

生成自己的公钥和私钥,生成的公私钥将自动存放在/root/.ssh目录下。

[root@hadoop01 software]# ssh-keygen

把生成的公钥copy到远程机器上

[root@hadoop01 software]# ssh-copy-id [user]@[host]

例如:

[root@hadoop01 software]# ssh-copy-id root@hadoop01

此时在远程主机的/root/.ssh/authorized_keys文件中保存了公钥,在known_hosts中保存了已知主机信息,当

再次访问的时候就不需要输入密码了。

$ ssh [host]

通过此命令远程连接,检验是否可以不需密码连接

重启计算机 reboot

4. 安装JDK

5. 安装hadoop

通过fz将hadoop安装包上传到linux

解压安装包 tar -zxvf [hadoop安装包位置]

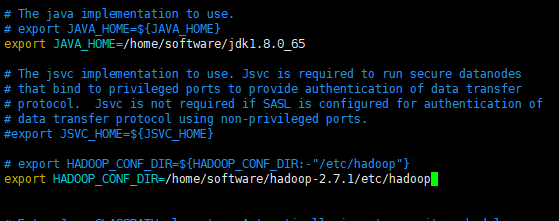

[root@hadoop01 hadoop-2.7.1]# cd ./etc/hadoop/

[root@hadoop01 hadoop]# vim hadoop-env.sh

[root@hadoop01 hadoop]# source hadoop-env.sh

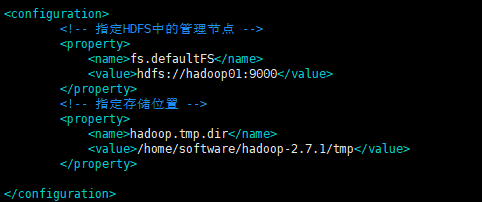

[root@hadoop01 hadoop]# vim core-site.xml

<!-- 指定HDFS中的管理节点 --> <property> <name>fs.defaultFS</name> <value>hdfs://hadoop01:9000</value> </property> <!-- 指定存储位置 --> <property> <name>hadoop.tmp.dir</name> <value>/home/software/hadoop-2.7.1/tmp</value> </property>

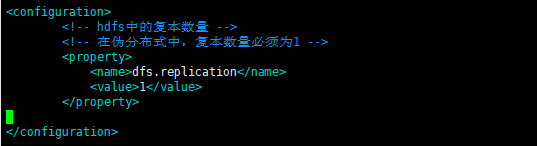

[root@hadoop01 hadoop]# vim hdfs-site.xml

<!-- hdfs中的复本数量 --> <!-- 在伪分布式中,复本数量必须为1 --> <property> <name>dfs.replication</name> <value>1</value> </property>

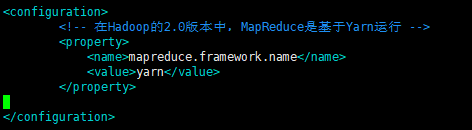

[root@hadoop01 hadoop]# cp mapred-site.xml.template mapred-site.xml

[root@hadoop01 hadoop]# vim mapred-site.xml

<!-- 在Hadoop的2.0版本中,MapReduce是基于Yarn运行 --> <property> <name>mapreduce.framework.name</name> <value>yarn</value> </property>

[root@hadoop01 hadoop]# vim yarn-site.xml

<property> <name>yarn.resourcemanager.hostname</name> <value>hadoop01</value> </property> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property>

[root@hadoop01 hadoop]# vim slaves

[root@hadoop01 hadoop]# vim /etc/profile

export HADOOP_HOME=/home/software/hadoop-2.7.1 export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

[root@hadoop01 hadoop]# source /etc/profile

[root@hadoop01 hadoop]# hadoop namenode -format

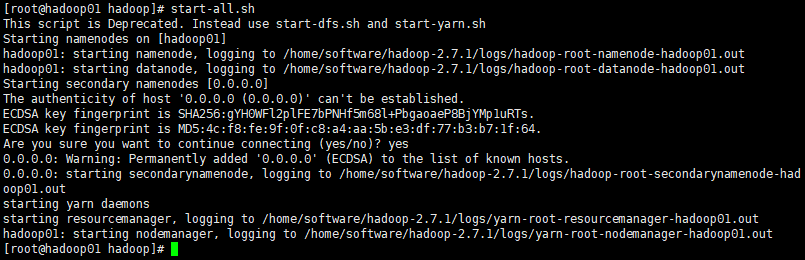

[root@hadoop01 hadoop]# start-all.sh

19. 如果启动成功,可以在浏览器中输入地址:50070访问hadoop的页面