目录

- batchsize与学习率

- mlp结构

- 6x5x4,lr=0.001,batchsize=1 完美收敛

- 4x4x4,lr=0.001,batchsize=1 部分收敛

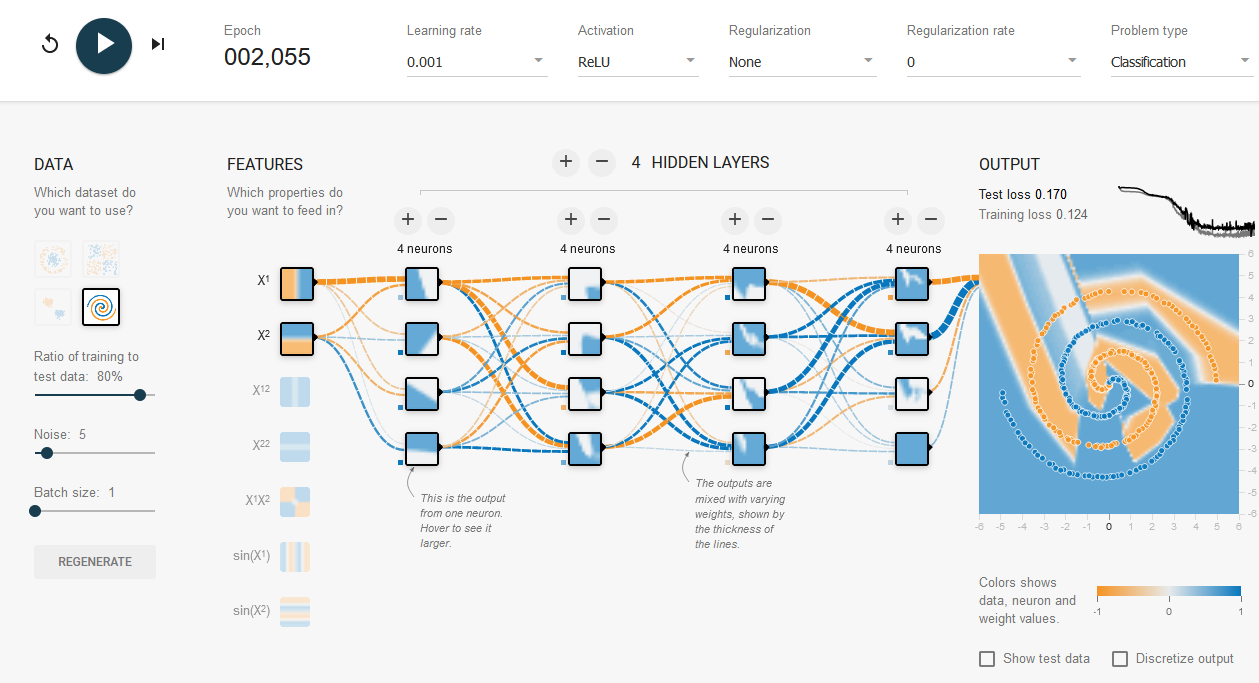

- 4x4x4x4,lr=0.001,batchsize=1,部分收敛

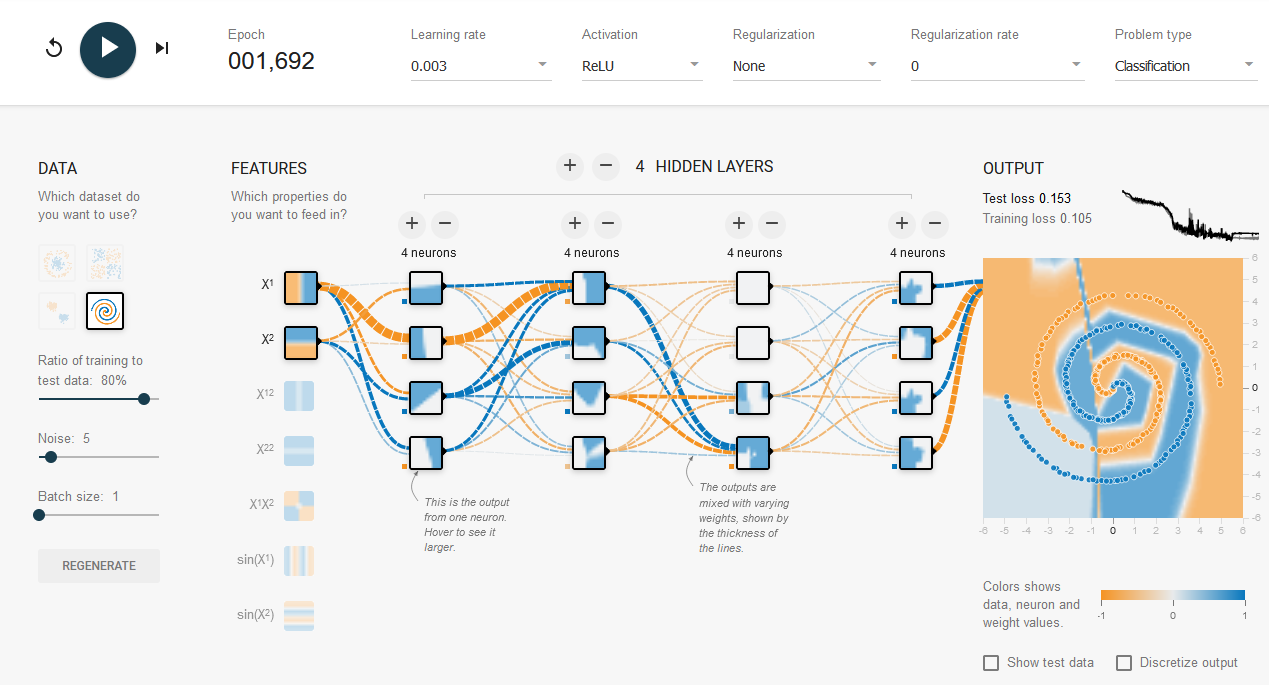

- 4x4x4x4,lr=0.003,batchsize=1,部分收敛

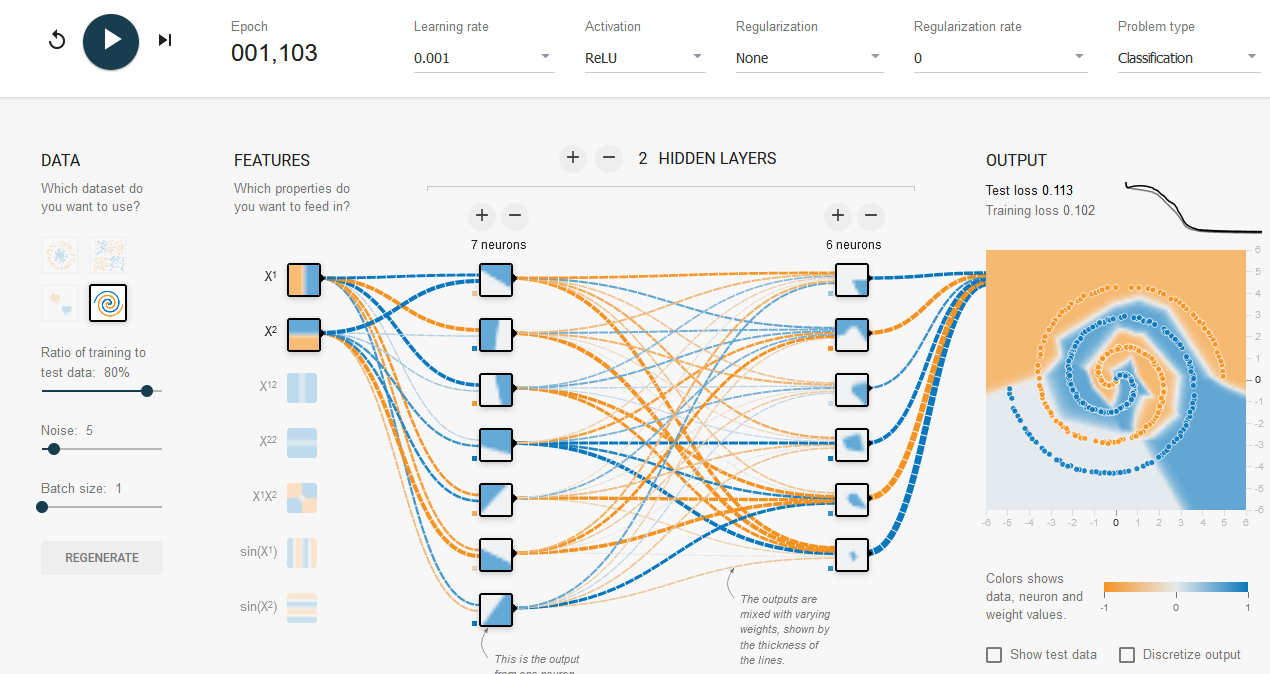

- 7x6,lr=0.001,batchsize=1,部分收敛,收敛稳定但是效果一般

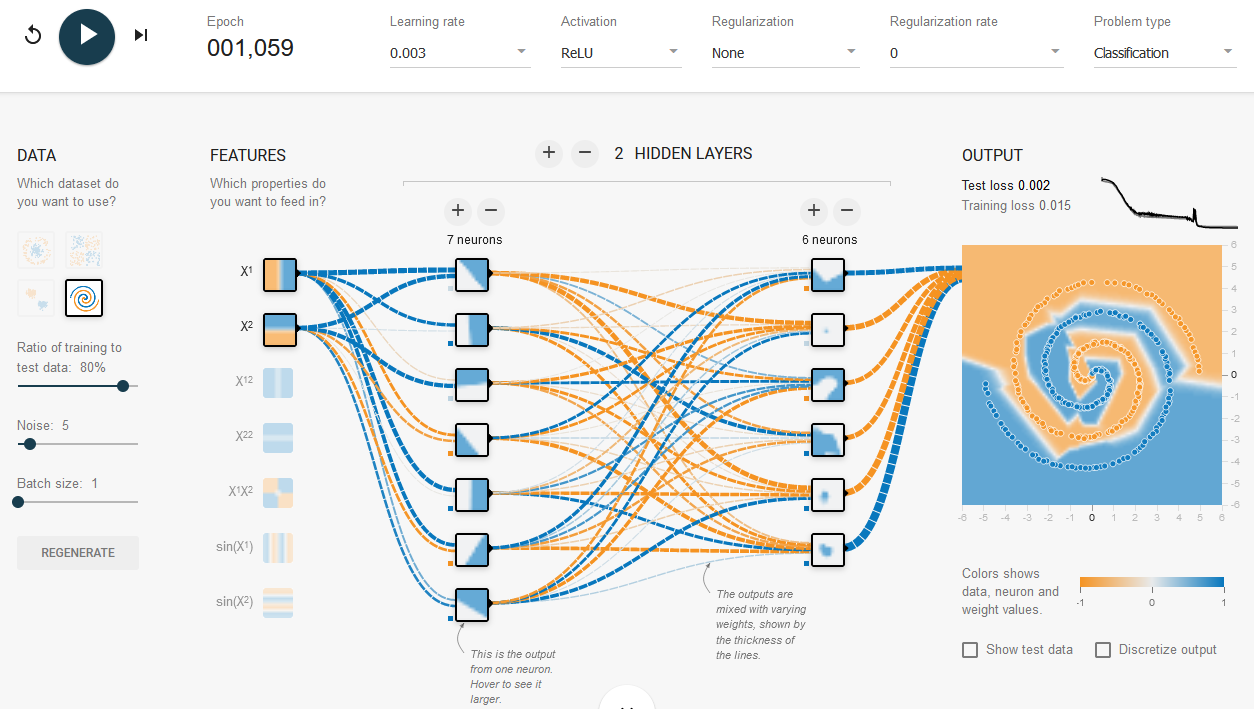

- 7x6,lr=0.003,batchsize=1,完美收敛

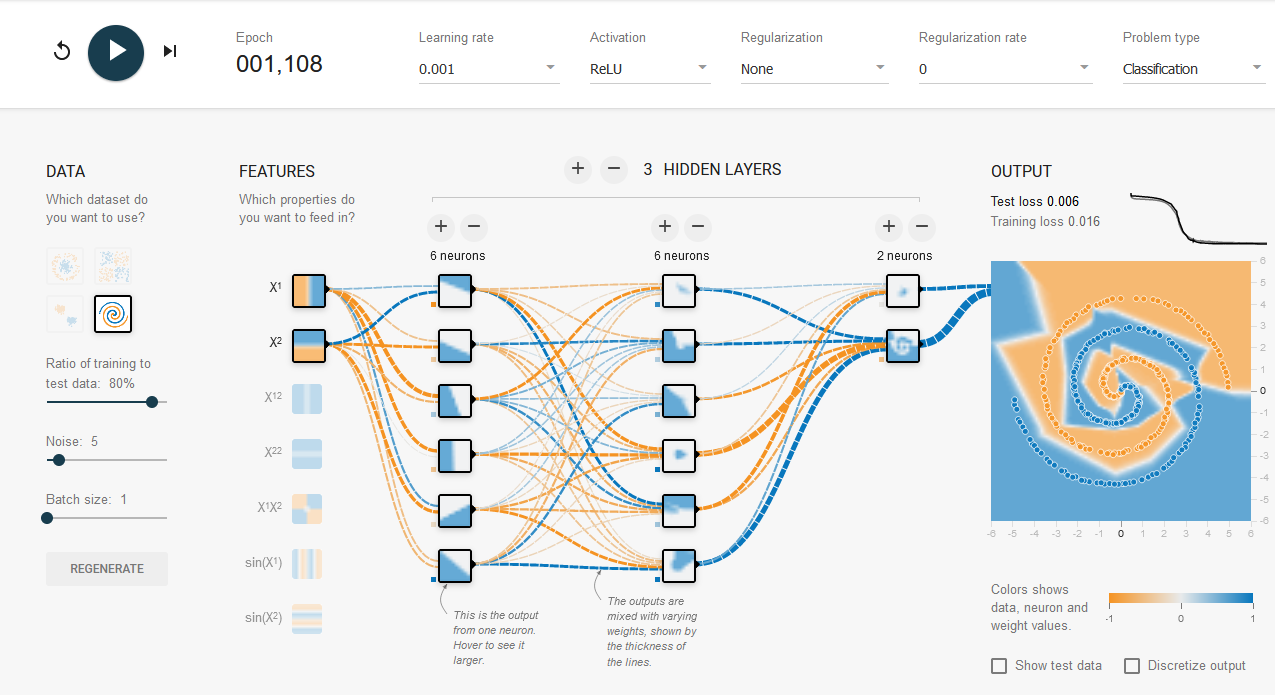

- 6x6x2,lr=0.001,batchsize=1,完美收敛

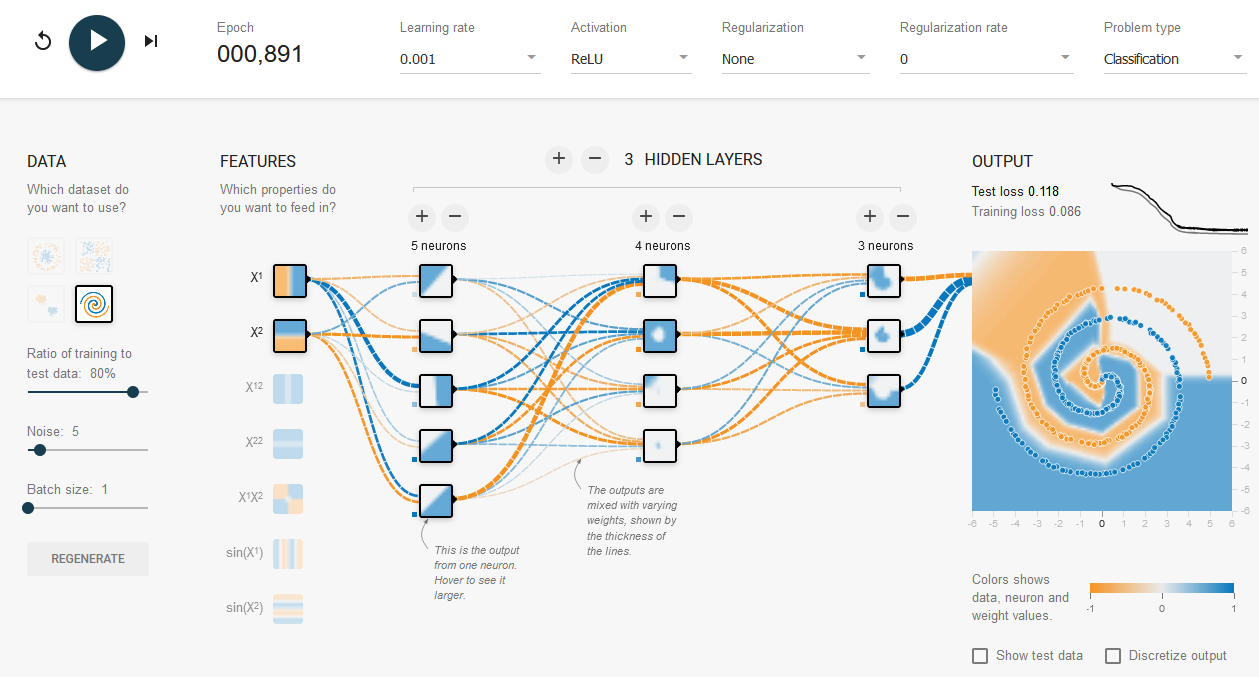

- 5x4x3,lr=0.001,batchsize=1,收敛稳定,但差点意思

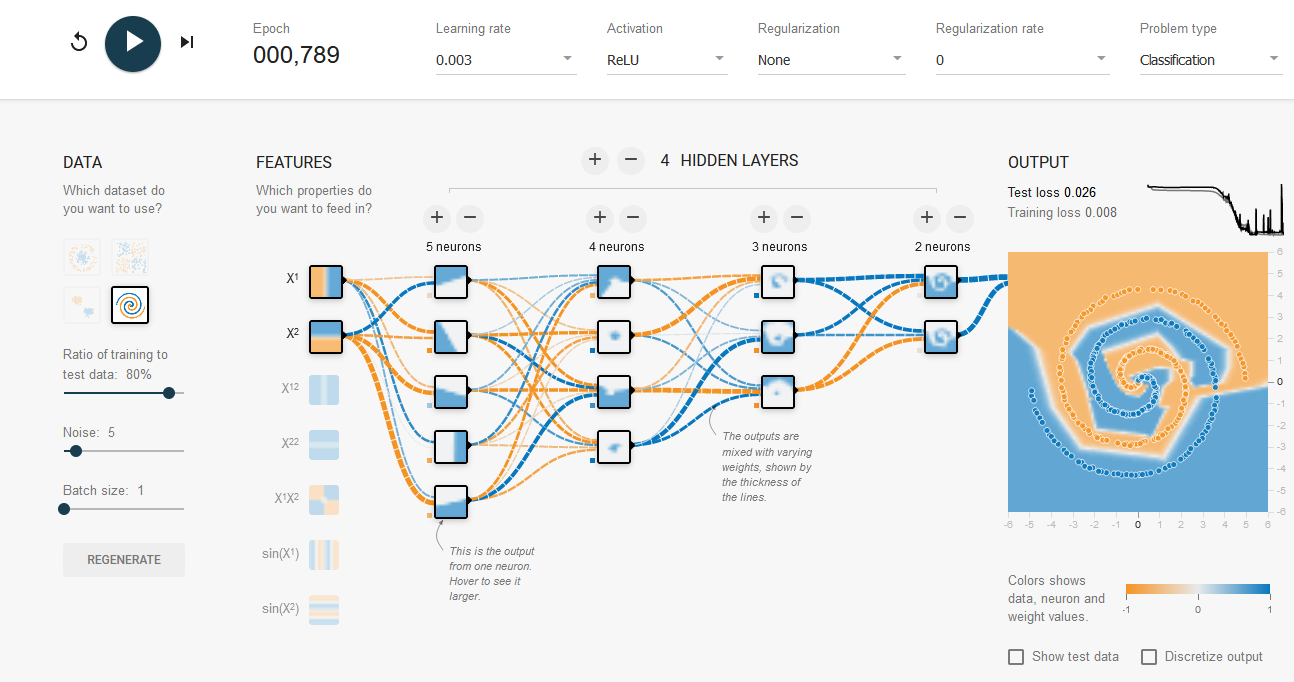

- 5x4x3x2,lr=0.003,batchsize=1,完美收敛

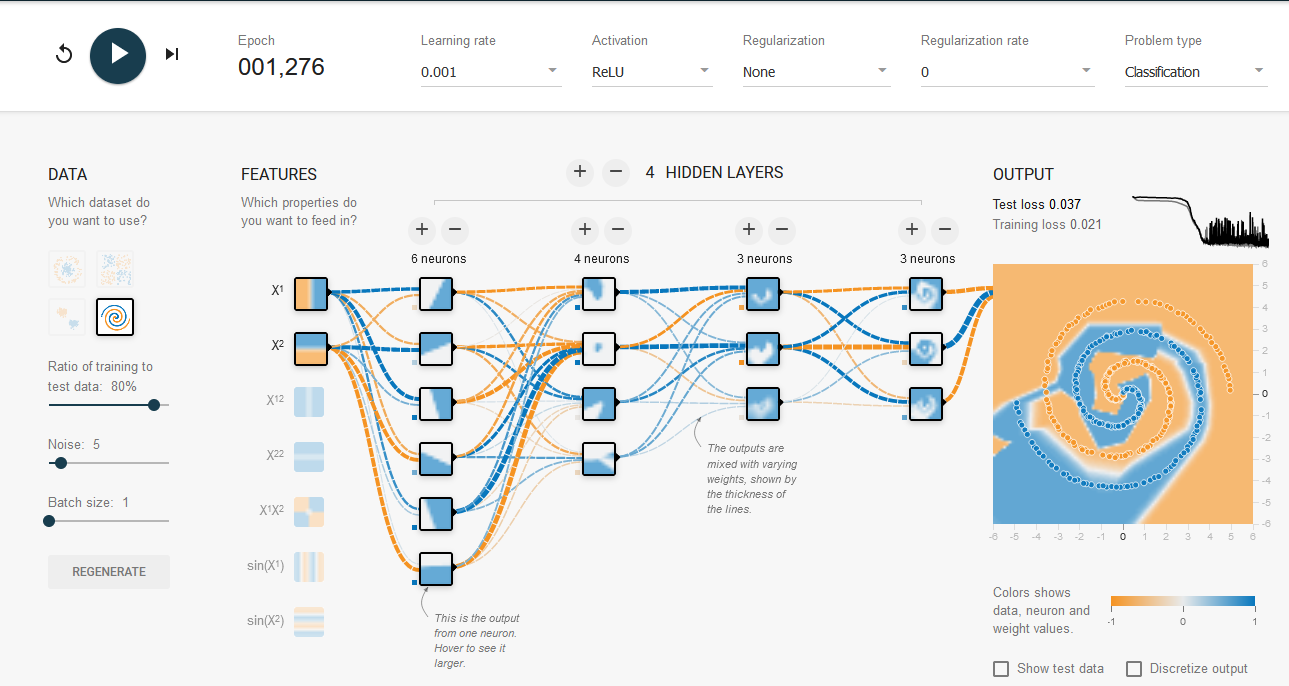

- 6x4x3x3,lr=0.001,batchsize=1,接近完美收敛,收敛异常之快。最后震荡较大

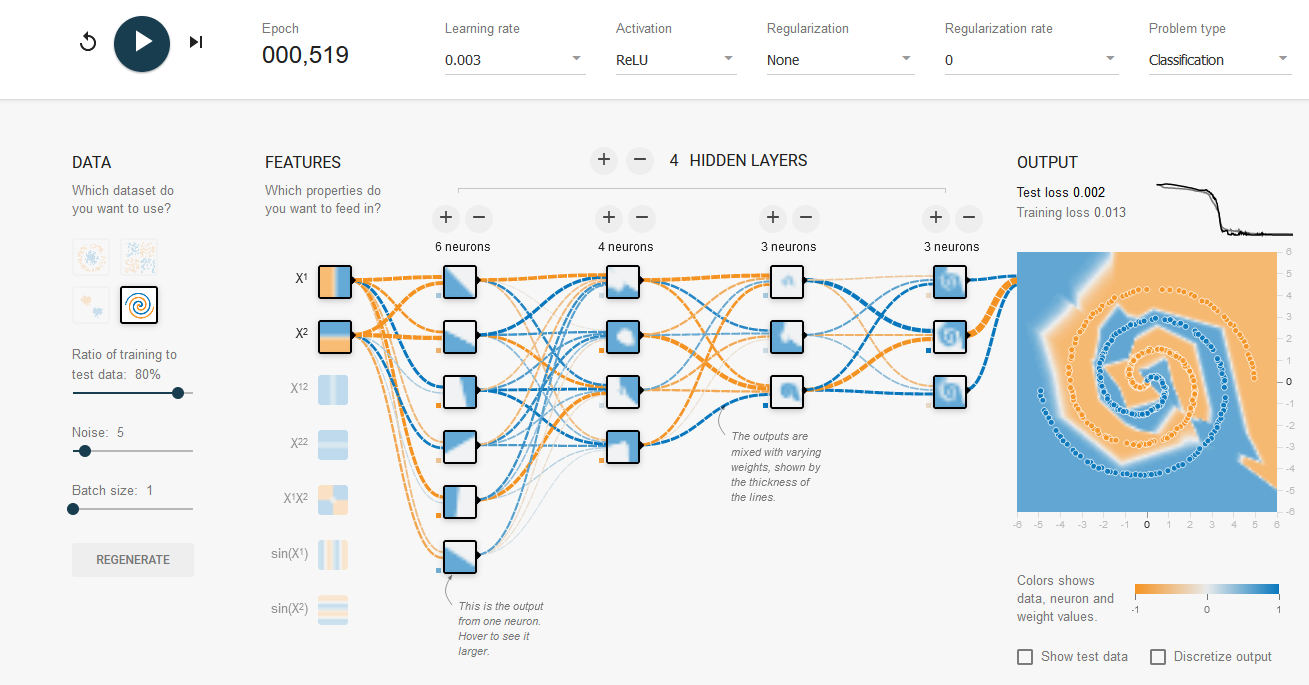

- 6x4x3x3,lr=0.003,batchsize=1,完美收敛,收敛异常之快。

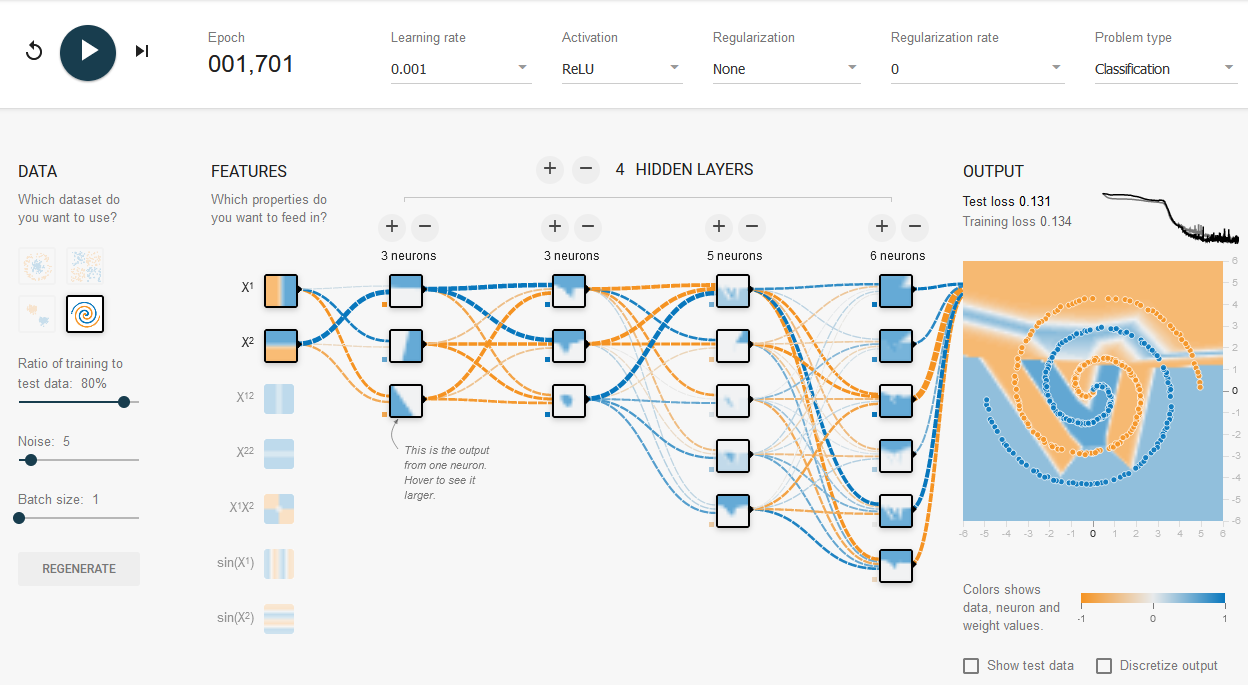

- 3x3x5x6,lr=0.001,batchsize=1,不收敛。

batchsize与学习率

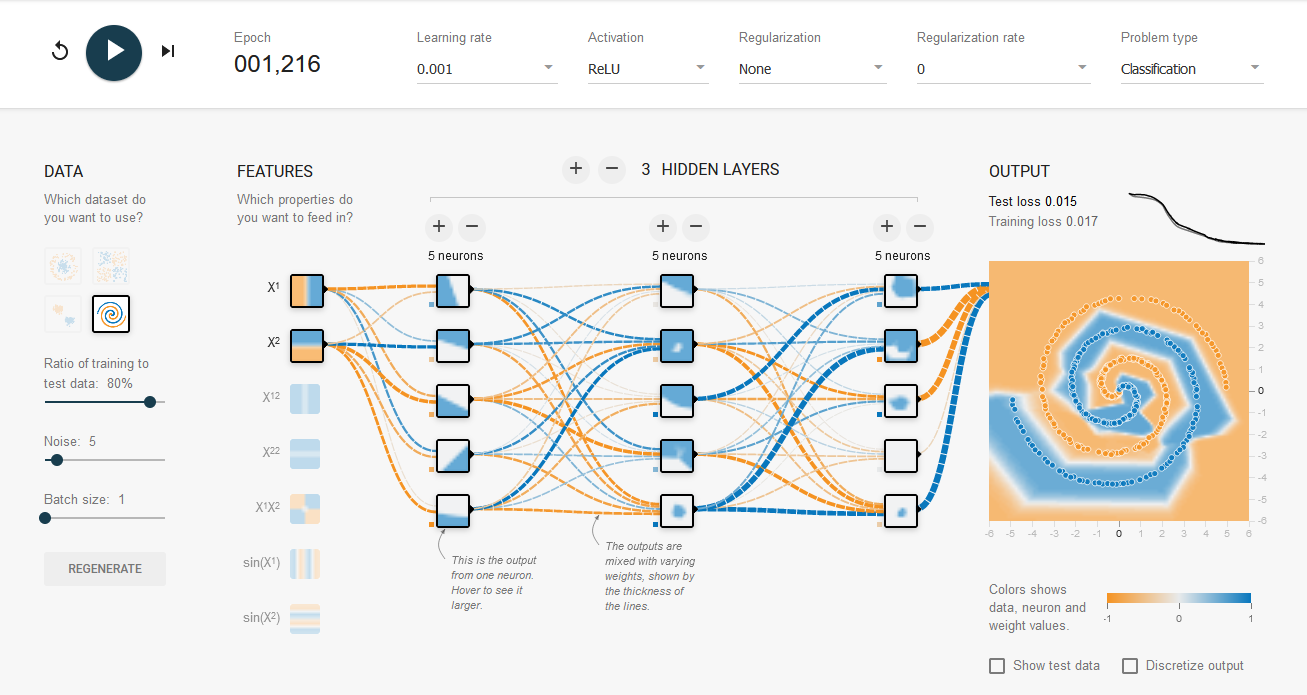

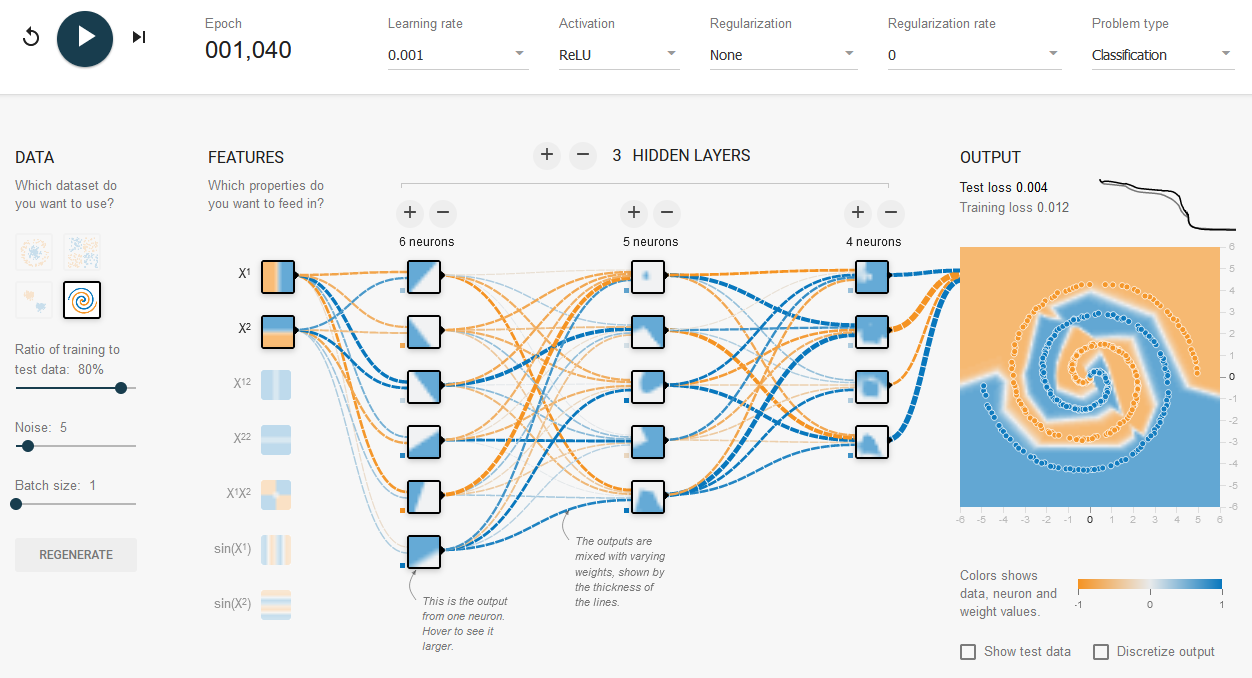

5x5x5,lr=0.001,batchsize=1 完美收敛

总权重数为 25+55+55+51=65

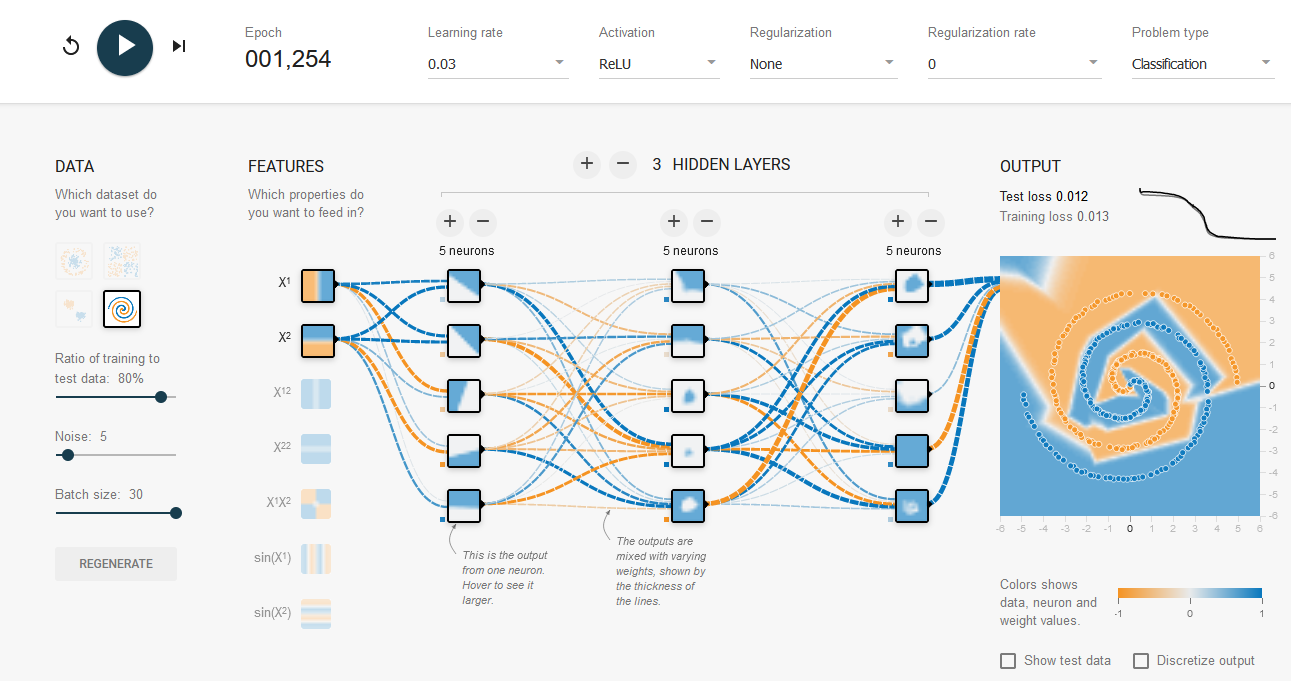

5x5x5,lr=0.03,batchsize=30 同样收敛

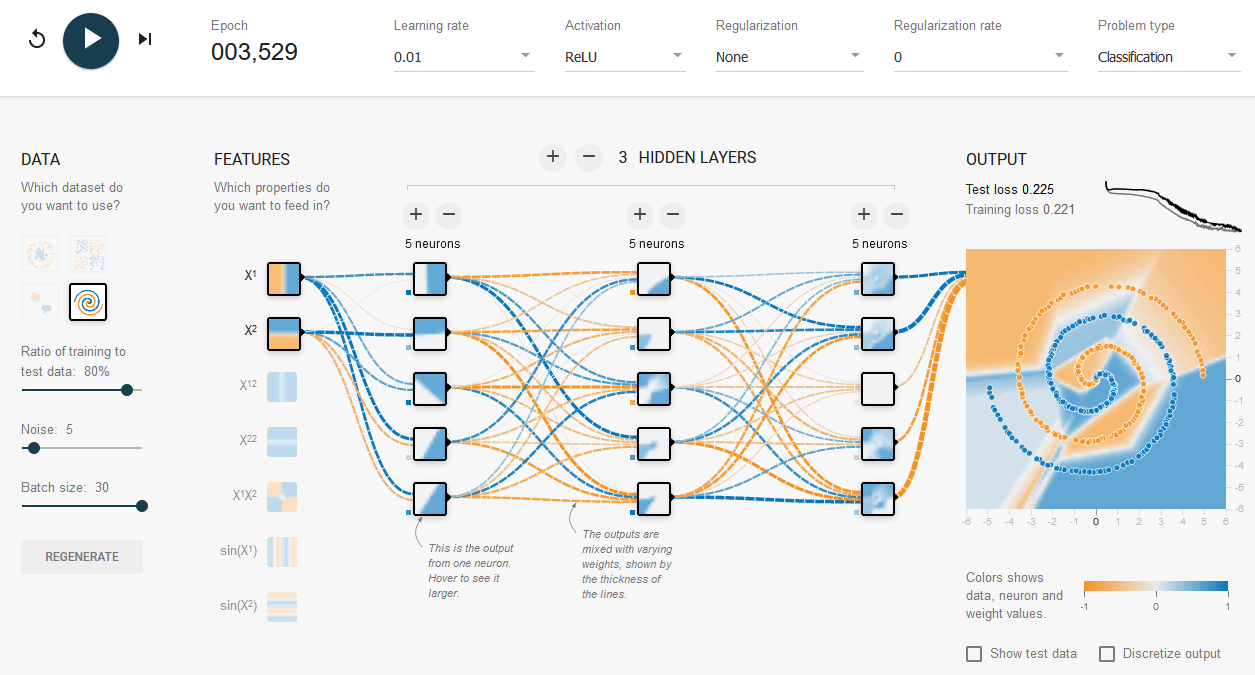

5x5x5,lr=0.01,batchsize=30,收敛的非常慢接近不收敛

结论,若在小batchsize下收敛,则到大batchsize下需要batchsize/lr接近一个常数,即增大学习率

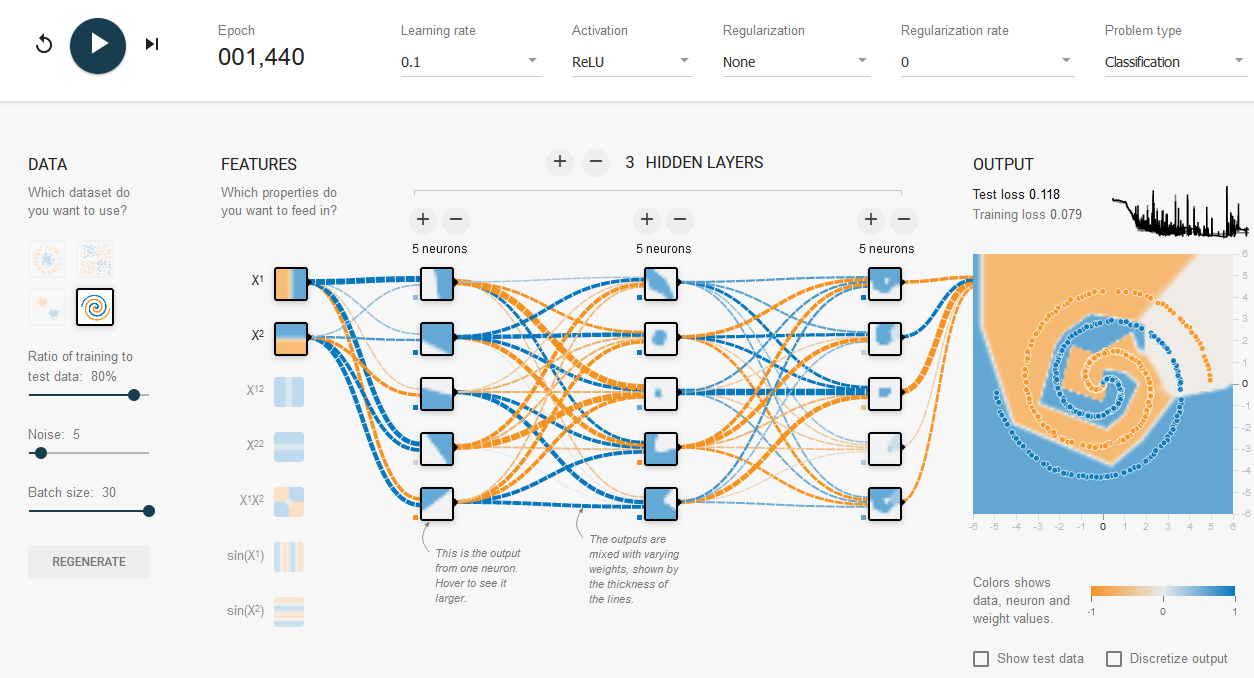

5x5x5,lr=0.1,batchsize=30,收敛快但是收敛的不好

学习率过大,抖动厉害。

mlp结构

6x5x4,lr=0.001,batchsize=1 完美收敛

4x4x4,lr=0.001,batchsize=1 部分收敛

总权重数为44

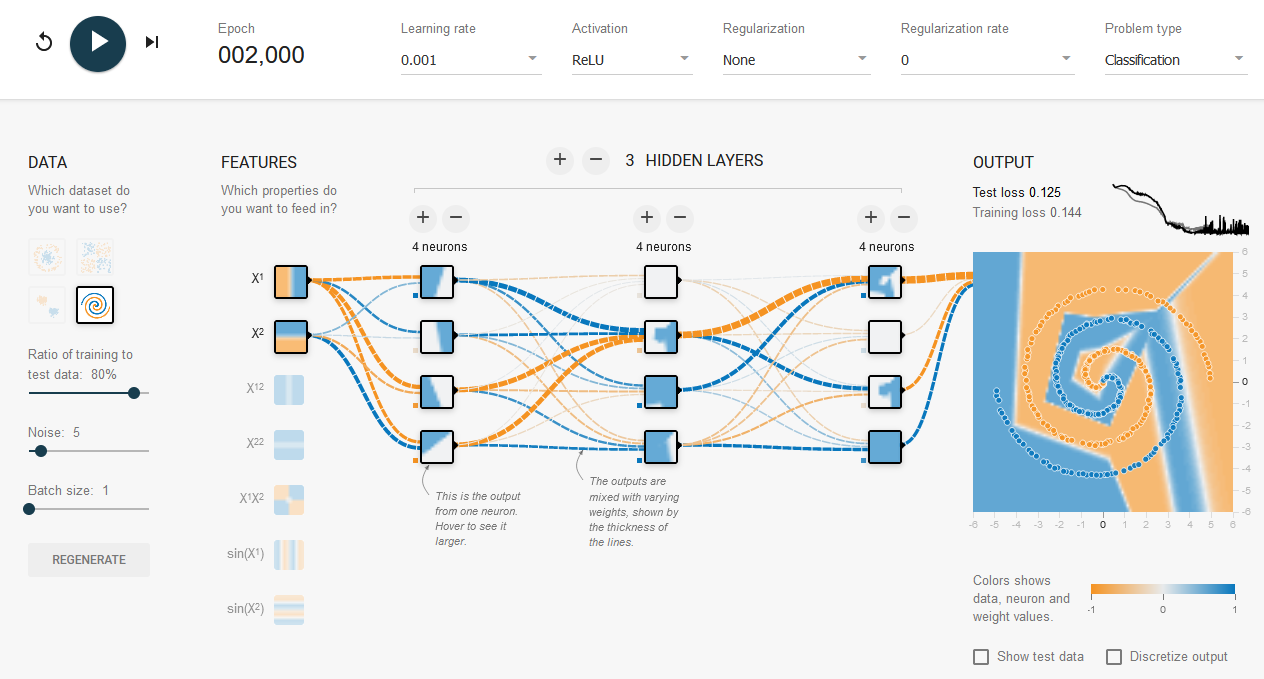

4x4x4x4,lr=0.001,batchsize=1,部分收敛

总权重数60,疑似学习率过小

4x4x4x4,lr=0.003,batchsize=1,部分收敛

非常不稳定

7x6,lr=0.001,batchsize=1,部分收敛,收敛稳定但是效果一般

总权重62

7x6,lr=0.003,batchsize=1,完美收敛

似乎层数减少学习率要增大

6x6x2,lr=0.001,batchsize=1,完美收敛

总权重62

5x4x3,lr=0.001,batchsize=1,收敛稳定,但差点意思

总权重45

5x4x3x2,lr=0.003,batchsize=1,完美收敛

总权重50

6x4x3x3,lr=0.001,batchsize=1,接近完美收敛,收敛异常之快。最后震荡较大

6x4x3x3,lr=0.003,batchsize=1,完美收敛,收敛异常之快。

3x3x5x6,lr=0.001,batchsize=1,不收敛。