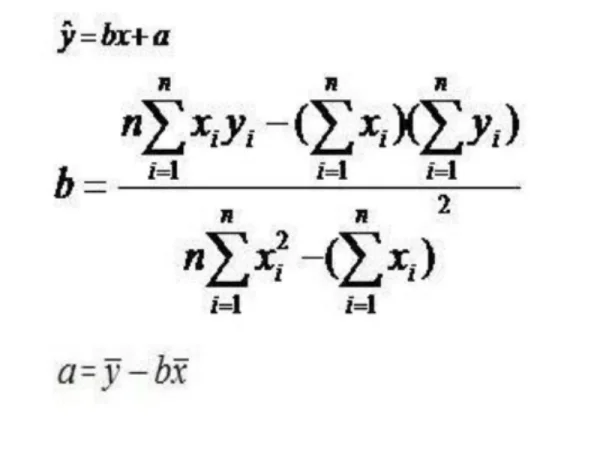

线性回归方程公式:

二、计算方法

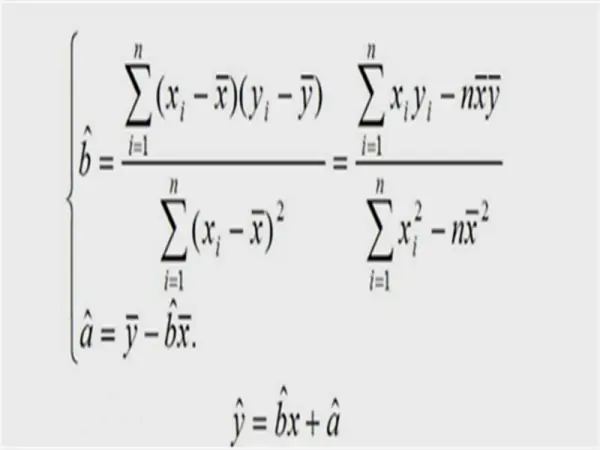

线性回归方程公式求法:

第一:用所给样本求出两个相关变量的(算术)平均值:

x_=(x1+x2+x3+...+xn)/n

y_=(y1+y2+y3+...+yn)/n

第二:分别计算分子和分母:(两个公式任选其一)

分子=(x1y1+x2y2+x3y3+...+xnyn)-nx_Y_

分母=(x1^2+x2^2+x3^2+...+xn^2)-n*x_^2

第三:计算b:b=分子/分母

用最小二乘法估计参数b,设服从正态分布,分别求对a、b的偏导数并令它们等于零,得方程组解为

其中,且为观测值的样本方差.线性方程称为关于的线性回归方程,称为回归系数,对应的直线称为回归直线.顺便指出,将来还需用到,其中为观测值的样本方差。

先求x,y的平均值X,Y

再用公式代入求解:b=(x1y1+x2y2+...xnyn-nXY)/(x1+x2+...xn-nX)

后把x,y的平均数X,Y代入a=Y-bX

求出a并代入总的公式y=bx+a得到线性回归方程

(X为xi的平均数,Y为yi的平均数)

三、应用

线性回归方程是回归分析中第一种经过严格研究并在实际应用中广泛使用的类型。这是因为线性依赖于其未知参数的模型比非线性依赖于其位置参数的模型更容易拟合,而且产生的估计的统计特性也更容易确定。

线性回归有很多实际用途。分为以下两大类:

如果目标是预测或者映射,线性回归可以用来对观测数据集的和X的值拟合出一个预测模型。当完成这样一个模型以后,对于一个新增的X值,在没有给定与它相配对的y的情况下,可以用这个拟合过的模型预测出一个y值。

给定一个变量y和一些变量X1,...,Xp,这些变量有可能与y相关,线性回归分析可以用来量化y与Xj之间相关性的强度,评估出与y不相关的Xj,并识别出哪些Xj的子集包含了关于y的冗余信息。

在线性回归中,数据使用线性预测函数来建模,并且未知的模型参数也是通过数据来估计。这些模型被叫做线性模型。最常用的线性回归建模是给定X值的y的条件均值是X的仿射函数。

不太一般的情况,线性回归模型可以是一个中位数或一些其他的给定X的条件下y的条件分布的分位数作为X的线性函数表示。像所有形式的回归分析一样,线性回归也把焦点放在给定X值的y的条件概率分布,而不是X和y的联合概率分布。

------------------------------------------------------------------------------------------------------------------------------------------------------------------

R2的计算

决定系数(coefficient ofdetermination),有的书上翻译为判定系数,也称为拟合优度。

决定系数反应了y的波动有多少百分比能被x的波动所描述,即表征依变数Y的变异中有多少百分比,可由控制的自变数X来解释.

表达式:R2=SSR/SST=1-SSE/SST

其中:SST=SSR+SSE,SST(total sum of squares)为总平方和,

SSR(regression sum of squares)为回归平方和,

SSE(error sum of squares) 为残差平方和。

回归平方和:

SSR(Sum of Squares forregression) = ESS (explained sum of squares)

残差平方和:

SSE(Sum of Squares for Error) = RSS(residual sum of squares)

总离差平方和:

SST(Sum of Squares fortotal) = TSS(total sum of squares)

SSE+SSR=SST RSS+ESS=TSS

意义:拟合优度越大,自变量对因变量的解释程度越高,自变量引起的变动占总变动的百分比高。观察点在回归直线附近越密集。取值范围:0-1.