大数据清洗阶段3

现在就是基本完成了,下一阶段将继续学习hive、 MapReduce

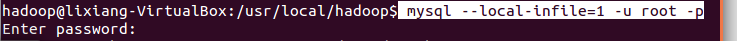

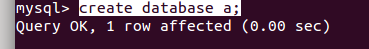

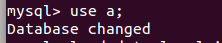

进入mysql

mysql --local-infile=1 -u root -p

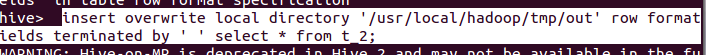

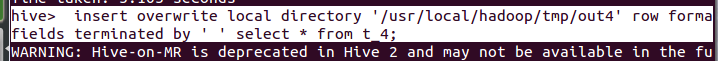

将HIVE中的表数据导出到临时文件中

insert overwrite local directory '/usr/local/hadoop/tmp/out' row format delimited fields terminated by ' ' select * from t_2;

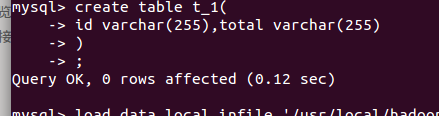

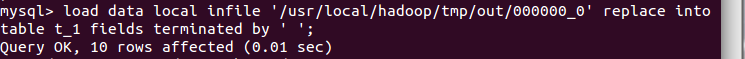

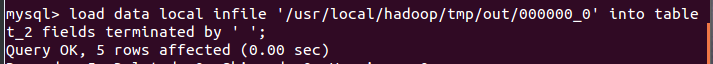

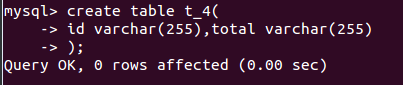

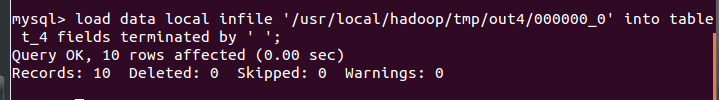

通过命令将数据导入到mysql

load data local infile '/usr/local/hadoop/tmp/out/000000_0' into table t_2 fields terminated by ' ';

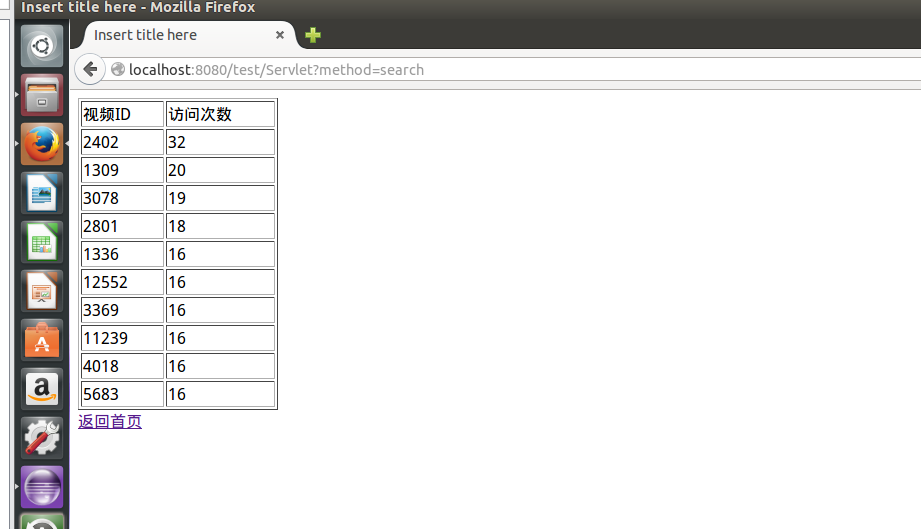

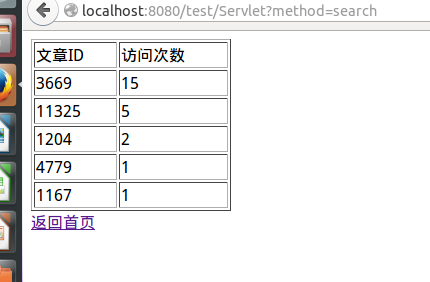

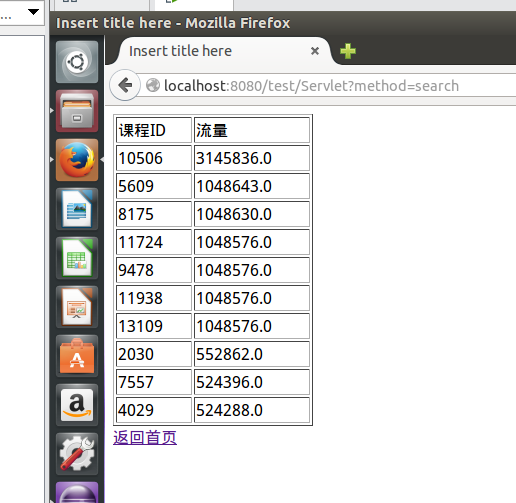

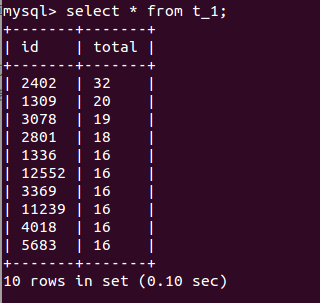

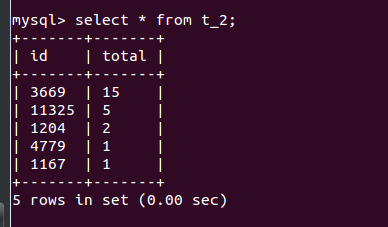

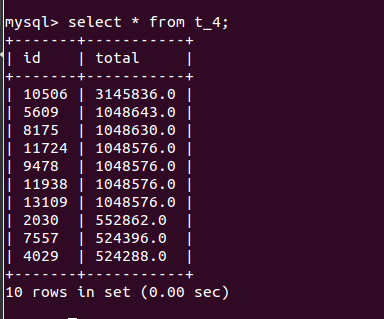

可视化展示