线性回归——简单线性回归

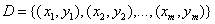

给定数据集 ,其中

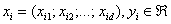

,其中 。线性回归试图学得一个线性模型以尽可能准确线性回归试图学得一个线性模型以尽可能准确地预测实值输出标记。(注:上面的

。线性回归试图学得一个线性模型以尽可能准确线性回归试图学得一个线性模型以尽可能准确地预测实值输出标记。(注:上面的 以及

以及 均表示向量;

均表示向量; 的取值表示在

的取值表示在 向量上的第d个属性)

向量上的第d个属性)

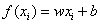

先考虑最简单的情形(简单线性回归):输入属性的数目只有一个。简单线性回归线性回归试图学得

,使得

,使得

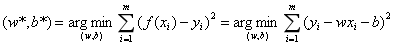

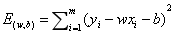

我们可以通过使均方误差最小化来求w和b,即

均方误差对应了常用的欧氏距离。基于均方误差最小化来进行模型求解的方法成为“最小二乘法”。在线性回归中,最小二乘法就是试图找到一条直线,使所有样本到直线上的欧式距离之和最小。

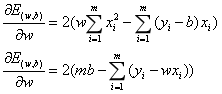

令 ,分别对w和b求偏导,可得:

,分别对w和b求偏导,可得:

这里 是凸函数,当它关于w和b的导数均为0时得到w和b的最优解。令上面的偏导为0可得:

是凸函数,当它关于w和b的导数均为0时得到w和b的最优解。令上面的偏导为0可得:

,其中

,其中

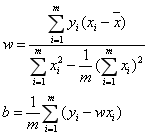

通过上式,可算出:

这就表明,在简单线性回归中,对应属性数目只有一个(也就是二维)时,最优解w是所有纵坐标之和除以所有横坐标之和。最优解b是在该w之下,数据集中所有点对应截距总和的平均值(即每个点在该w之下会有一个自己的截距,求出所有点的对应截距再求和,最后平均之后作为最优的截距)。

参考资料:机器学习(周志华版)

注:上述公式都可以简单推导出来,书中给出的w是上面的复杂的公式,在推到过程中可以不必太在意这个公式,直接结合求出的w和b的公式,联合方程组就可以求出上面那个简洁的w公式。个人认为这里推出的w很漂亮,因为很容易理解,算是第一次粗略地感受到数学之美。后续还会写一篇多元线性回归的博文,希望也可以做一个很好的解释。