Lecture2 Linear methods for regression, Optimization

书接上回,KNN模型有两个好处,一个是它很简单,另一个就是它既可以用来做回归,又可以用来做分类。但是坏处也很明显,就是它太粗暴了,基本上不怎么学习,只是对数据做一个简单的存储,等有了新的数据(测试数据)进来以后,才开始学习。所以我们也叫它“惰性学习”。在这样的情况下,KNN的计算体量,可想而知,是很大的。

另一个学习算法:linear regression 将在接下来的内容中详细介绍。

linear regression

监督学习:我们有一组数据集,并且已经知道了正确的 output,以及 input 和 output 之间的关系。我们期望根据已有的数据确定一个 input 到 output 的映射关系,从而对一组新的 input 求出 output。

监督学习通常分为“回归”和“分类”问题。线性回归模型是 监督学习模型 supervised learning model 的一种。

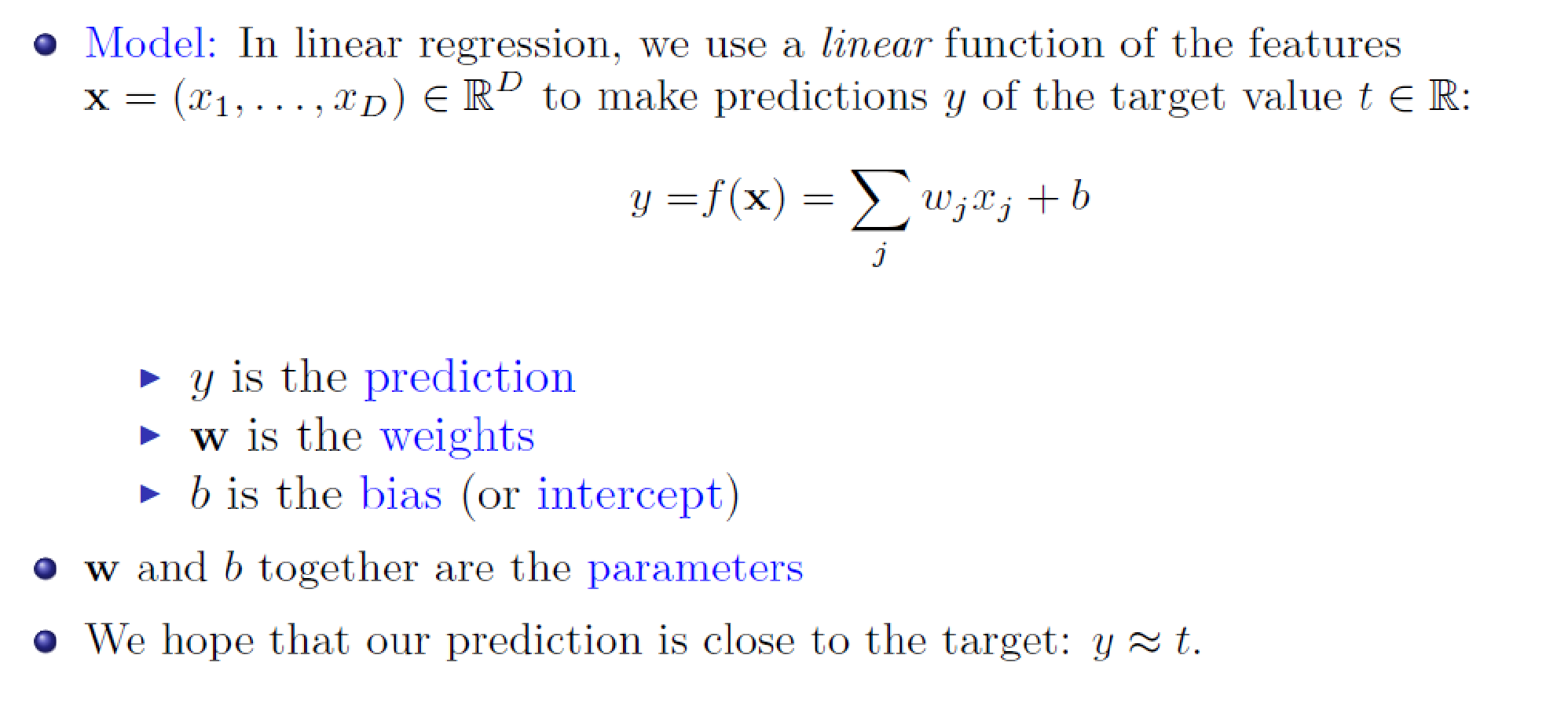

Model

note*: 加粗的字体是向量(w)

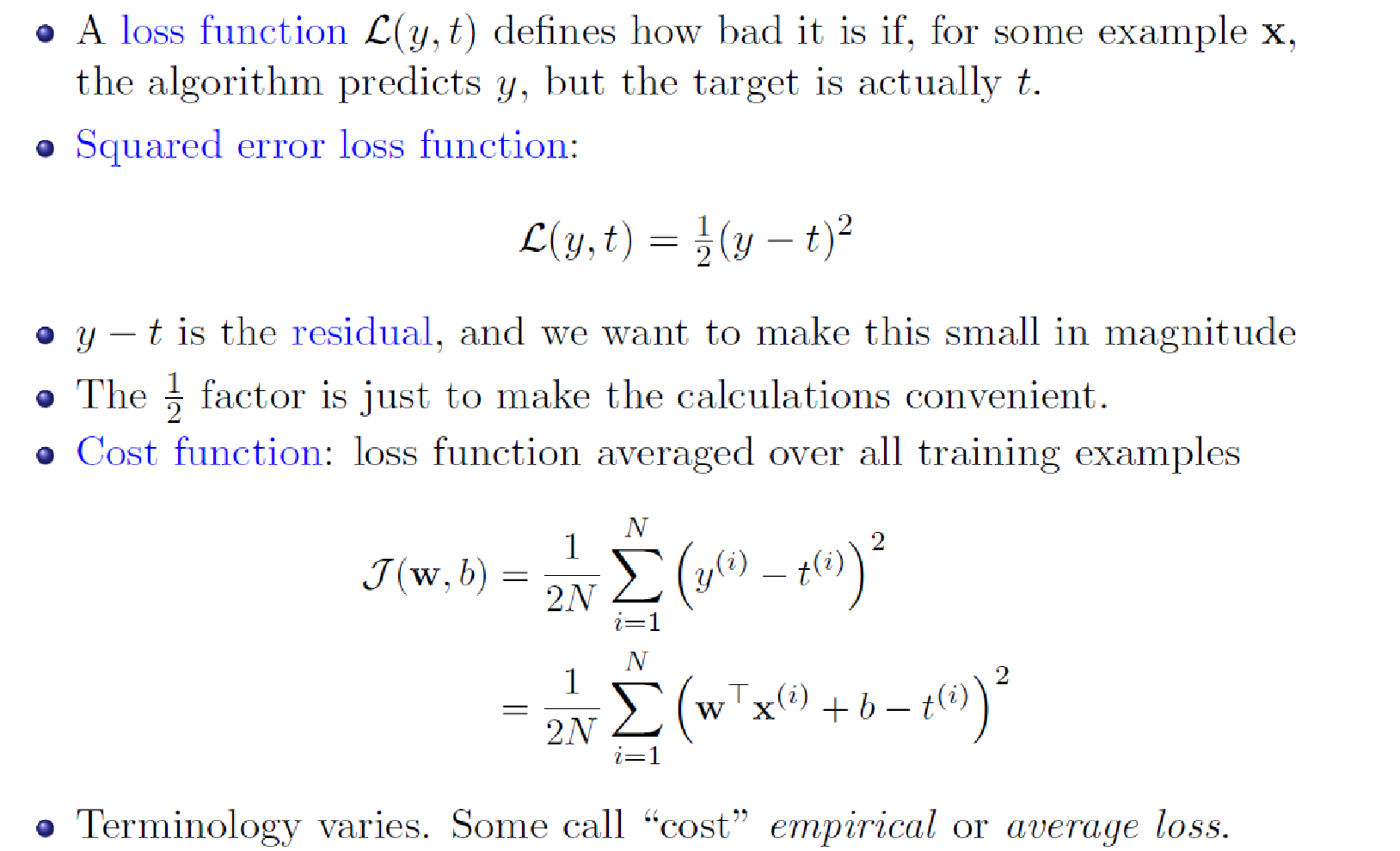

Loss function

note*:

对单个样本,你的prediction和ground truth(正确答案)之间的差异是Loss function,这种差异可以用极大似然,均方误差等表示。

针对一个整个数据集(m个样本),你的prediction和ground truth(正确答案)之间的差异是Cost function,这种差异可以用极大似然,均方误差表示。

也就是Cost function 和Loss function就差在有没有把预测值和真实值的差异求和再取平均

mse(均方误差):考虑求导后简化求和后乘1/2m, maximum likely hood :除以m

本文作者:zz-w

本文链接:https://www.cnblogs.com/zz-w/p/16712105.html

版权声明:本作品采用知识共享署名-非商业性使用-禁止演绎 2.5 中国大陆许可协议进行许可。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步