Hive调优

Hive建表优化

1,分区,分桶 一般是按照业务日期进行分区 每天的数据放在一个分区里

2,一般使用外部表,避免数据误删

3,选择适当的文件储存格式及压缩格式

4,命名要规范

5,数据分层,表分离,但是也不要分的太散

Hive查询优化

分区裁剪 where过滤,

先过滤,后join 分区分桶,

合并小文件 适当的子查询(小表全局广播,左连是大表在左,小表在右)

order by 语句: 是全局排序

sort by 语句: 是单reduce排序

distribute by语句: 是分区字段

cluster by语句: 可以确保类似的数据的分发到同一个reduce task中,并且保证数据有序防止所有的数据分发到同一个reduce上,导致整体的job时间延长

cluster by语句的等价语句: distribute by Word sort by Word ASC

Hive数据倾斜优化

原因:key分布不均匀,数据重复

表现:任务进度长时间维持在99%(或100%),查看任务监控页面,发现只有少量(1个或几个)reduce子任务未完成。因为其处理的数据量和其他reduce差异过大。单一reduce的记录数与平均记录数差异过大,通常可能达到3倍甚至更多。 最长时长远大于平均时长。

解决方案:

1、从数据源头,业务层面进行优化

2、找到key重复的具体值,进行拆分,hash。异步求和。(增加随机数,加盐,可以在key后concat拼接数,最后split切分)

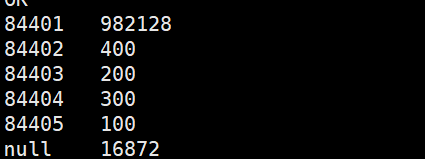

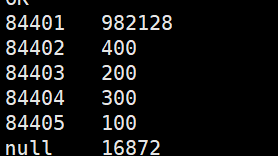

hive> select key,count(*) from data_skew group by key; (没有优化前)

hive> select t.key,sum(t.c) from

> (select key,if(key=='84401' or key=='null',floor(8*rand()),0) as hash_key,count(*) as c

> from data_skew group by key,if(key=='84401' or key=='null',floor(8*rand()),0)) t

> group by t.key;

Hive作业优化

调整mapper和reducer的数量

太多map导致启动产生过多开销

按照输入数据量大小确定reducer数目set mapred.reduce.tasks= 默认3

dfs -count /分区目录/*

hive.exec.reducers.max设置阻止资源过度消耗

参数调节

set hive.map.aggr = true (hive2默认开启)

Map 端部分聚合,相当于Combiner

hive.groupby.skewindata=true

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 10年+ .NET Coder 心语,封装的思维:从隐藏、稳定开始理解其本质意义

· .NET Core 中如何实现缓存的预热?

· 从 HTTP 原因短语缺失研究 HTTP/2 和 HTTP/3 的设计差异

· AI与.NET技术实操系列:向量存储与相似性搜索在 .NET 中的实现

· 基于Microsoft.Extensions.AI核心库实现RAG应用

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· 阿里巴巴 QwQ-32B真的超越了 DeepSeek R-1吗?

· 【译】Visual Studio 中新的强大生产力特性

· 10年+ .NET Coder 心语 ── 封装的思维:从隐藏、稳定开始理解其本质意义

· 【设计模式】告别冗长if-else语句:使用策略模式优化代码结构