IOU->GIOU->CIOU->Focal_loss

IOU->GIOU->CIOU->Focal_loss

总览

2022-1-3号补充

- 该链接下关于算是函数讨论

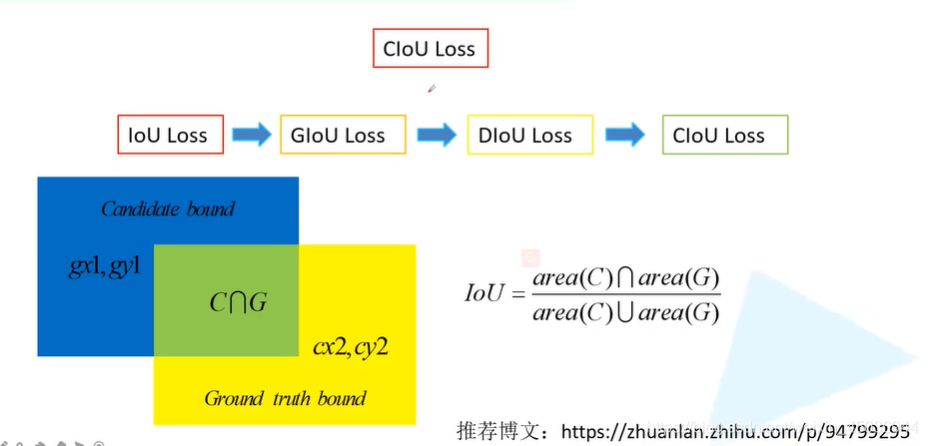

IOU loss

绿色代表Gtbox,黑色代表最终预测的边界框

但是去计算这三种L2损失时都是一样的(8.41),但是去计算IOU时很明显他们的IOU是不一样的---->说明L2损失不能很好的衡量两个目标边界框的重合程度

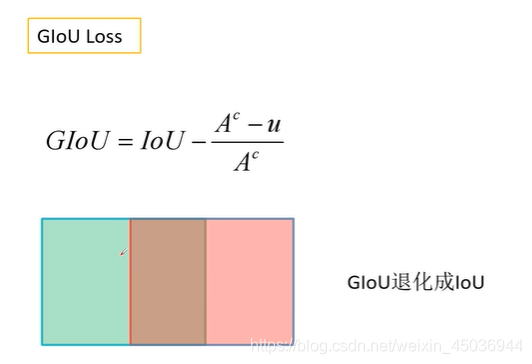

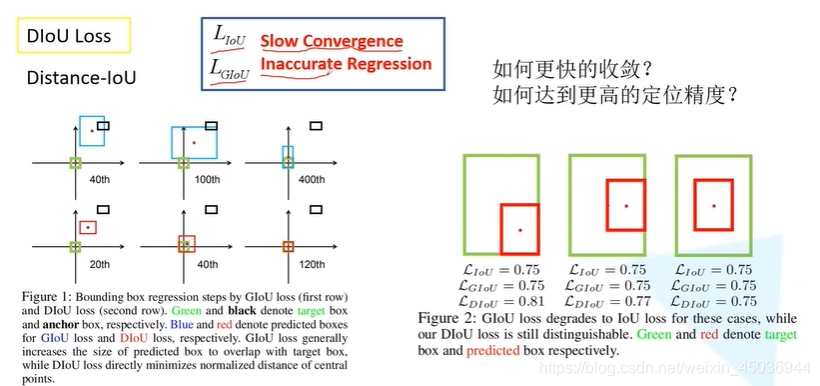

GIOU loss

上图中绿色的是真实目标边界框,红色的边界框是最终预测的边界框

外面的蓝色目标边界框就是用一个小的矩型将这两个框住-->这个蓝色目标边界框的面积=A^C,

这里的u等于蓝色和红色两个目标边界框并集的部分

- Glou缺点:当两个目标边界框是并集是GLOU退化层LOU(后面的一项退化成了0)

Diou loss

IOU: 缺点: 收敛特别的慢

GIOU:缺点: 回归的不够准确

上图中的第一行(GLOU)使用GLOU来训练网络-->让预测目标边界框尽可能地回归到真实地目标边界框

(这里的黑色代表anchor(default box),绿色是Groud truth, 蓝色是最终预测的边界框)--->目的是使蓝色边界框与绿色边界框重合在一起

(1--> 分别表示迭代40步,100步,400步)

第2行的DLOUloss,(20th--40th--120th)---->从而说明DLOU比GLOU收敛更快

观察上图的右侧--->说明IOU和GLOU不能很好的说明目标边界框重合的位置关系

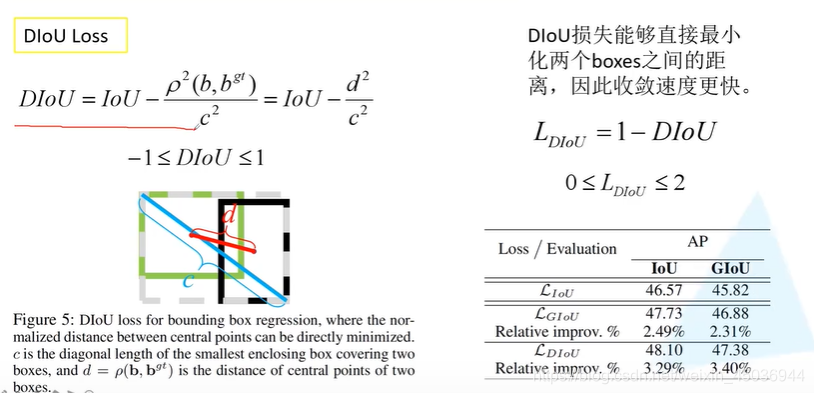

- DIOU计算公式:

上图中的ρ^2 表示b和b^gt 的欧式距离

观察上图:b是预测目标边界框的中心点b^gt 是真实目标的中心点坐标, ρ^2 是中心点的距离的平方,这里的c是这两个矩形的最小外接框的对角线长度

所以,当两个目标边界框重合在一起的时候d^2=0,当这两个边界框相聚无穷远的时候d^2 趋近于c^2

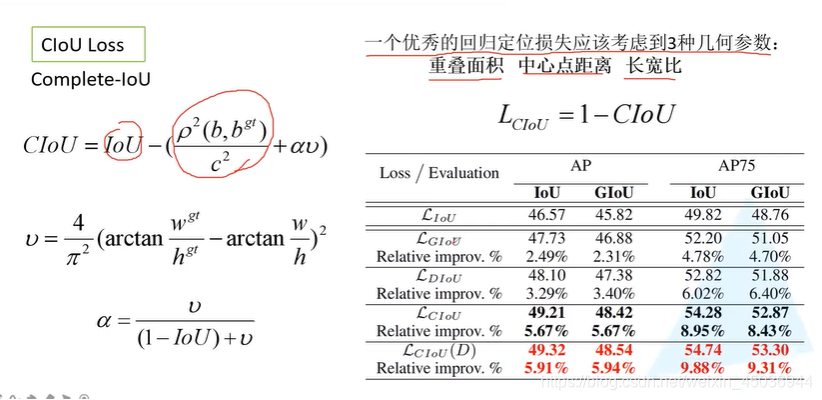

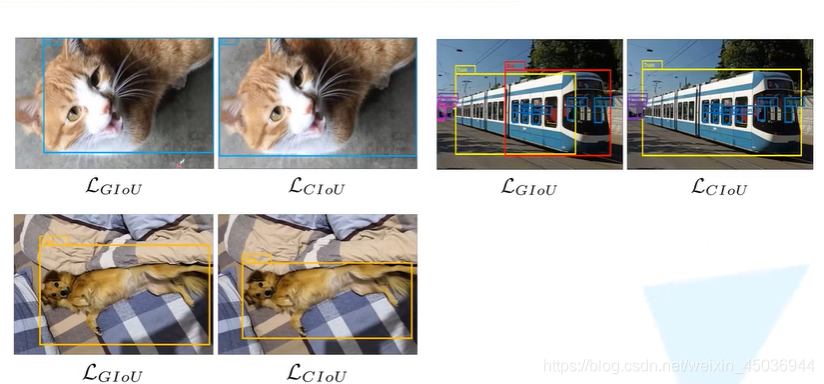

Ciou loss

- 样例

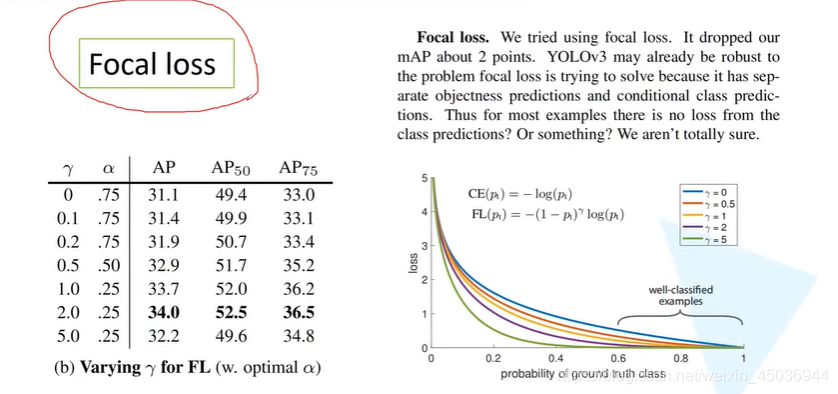

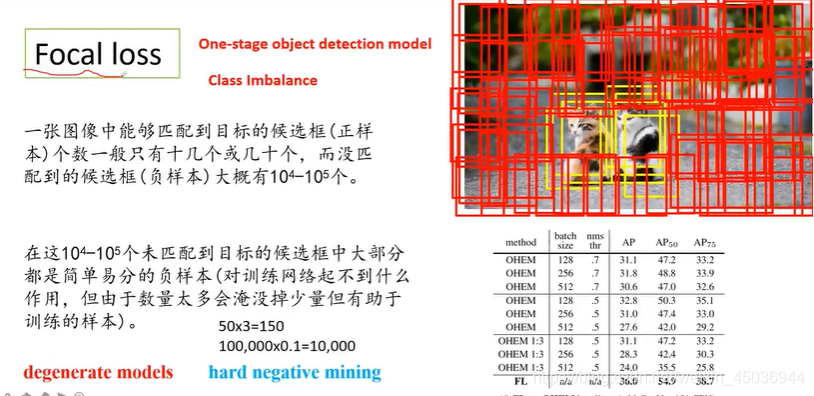

Focal loss

Focal loss针对one-stage模型,正负样本差距太大会导致

2.类别不平衡

为什么在two-stage中没有类别不均衡的问题?

1.在two-stage中的第一阶段也存在不平衡问题,但是是通过第二阶段的检测来确定最终的目标的(例如faster-rcnn经过rpn后就大概2000个框了)

- Focal Loss--->针对正负样本极不平衡的情况

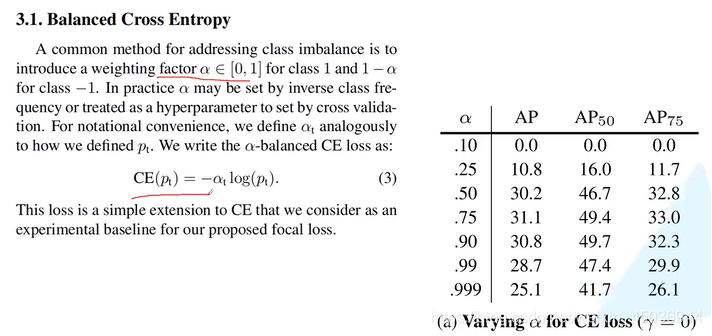

由上图可得例如当a=0.75时,可以增加正样本的权重,减少负样本的(背景)权重

- 引入a对于计算cross entropy的计算(这里的a是一个超参数,来平衡正负样本的权重)

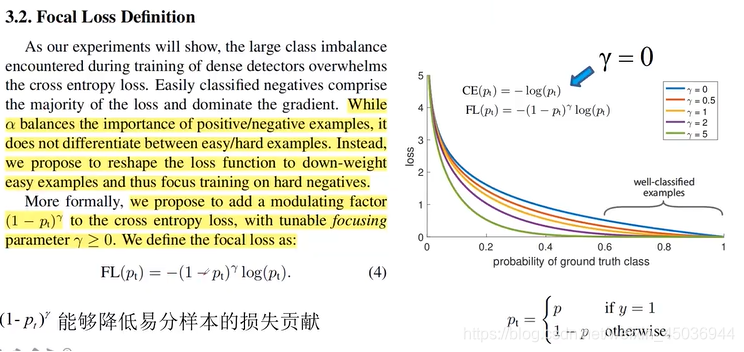

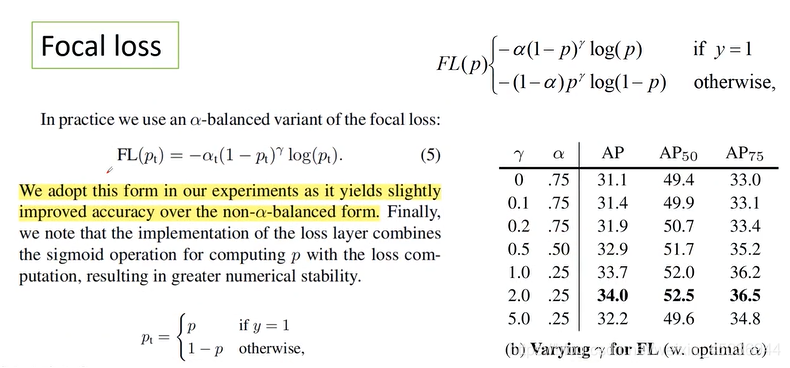

由上面右边的图可得: 当该样本是好分的样本是那么(1-p_t)^r能够降低好分样本的权重

- 降低简单样本的权重,因此能够聚焦于难分的负样本,因此作者引入了(1−P_t )^γ

- 这里的a_t 是超参数

第一列代表的是预测概率

第二列代表的是真实地标签(1对应是正样本0对应的是负样本)

第三列的CE是cross entropy loss

第四列代表的是focal loss

第五列的rate代表的是CE和FL的比值

说明Focal loss--->降低易分样本的权重的功能

使用Focal loss之后更专注于学习难学习的样本,对于简单样本就降低他的学习的权重

Focal的缺点是易受噪音的干扰(所以这里可以在标注是要尽可能地正确)