19 docker 多机器通信

1. 本章实验

2. 环境搭建

1.编写 Vagrantfile 并创建虚拟机 并虚拟机node1绑定外部 192.168.205.10:8888 node2绑定外部 192.168.205.10:9999

# -*- mode: ruby -*-

# vi: set ft=ruby :

Vagrant.require_version ">= 1.6.0"

boxes = [

{

:name => "docker-node1",

:eth1 => "192.168.205.10",

:mem => "1024",

:cpu => "1",

:port => "8888"

},

{

:name => "docker-node2",

:eth1 => "192.168.205.11",

:mem => "1024",

:cpu => "1",

:port => "9999"

}

]

Vagrant.configure(2) do |config|

config.vm.box = "centos/7"

boxes.each do |opts|

config.vm.define opts[:name] do |config|

config.vm.hostname = opts[:name]

config.vm.network "forwarded_port", guest: 80, host: opts[:port]

config.vm.provider "vmware_fusion" do |v|

v.vmx["memsize"] = opts[:mem]

v.vmx["numvcpus"] = opts[:cpu]

end

config.vm.provider "virtualbox" do |v|

v.customize ["modifyvm", :id, "--memory", opts[:mem]]

v.customize ["modifyvm", :id, "--cpus", opts[:cpu]]

end

config.vm.network :private_network, ip: opts[:eth1]

end

end

config.vm.synced_folder "./labs", "/home/vagrant/labs"

config.vm.provision "shell", privileged: true, path: "./setup.sh"

end

2.创建labs 文件夹 及编写 setup.sh 文件

mkdir labs

vim setup.sh

#setup.sh

#/bin/sh

# install some tools

sudo yum install -y wget

sudo mv /etc/yum.repos.d/CentOS-Base.repo /etc/yum.repos.d/CentOS-Base.repo_bak

sudo wget -O /etc/yum.repos.d/CentOS-Base.repo http://mirrors.aliyun.com/repo/Centos-7.repo

sudo yum makecache

sudo yum -y update

sudo yum install -y git vim gcc glibc-static telnet bridge-utils

# install docker

curl -fsSL get.docker.com -o get-docker.sh

sh get-docker.sh

# start docker service

sudo groupadd docker

sudo usermod -aG docker vagrant

sudo systemctl start docker

rm -rf get-docker.sh

sudo tee /etc/docker/daemon.json <<-'EOF'

{

"registry-mirrors": ["https://v2ltjwbg.mirror.aliyuncs.com"]

}

EOF

sudo systemctl daemon-reload

sudo systemctl restart docker

docker version

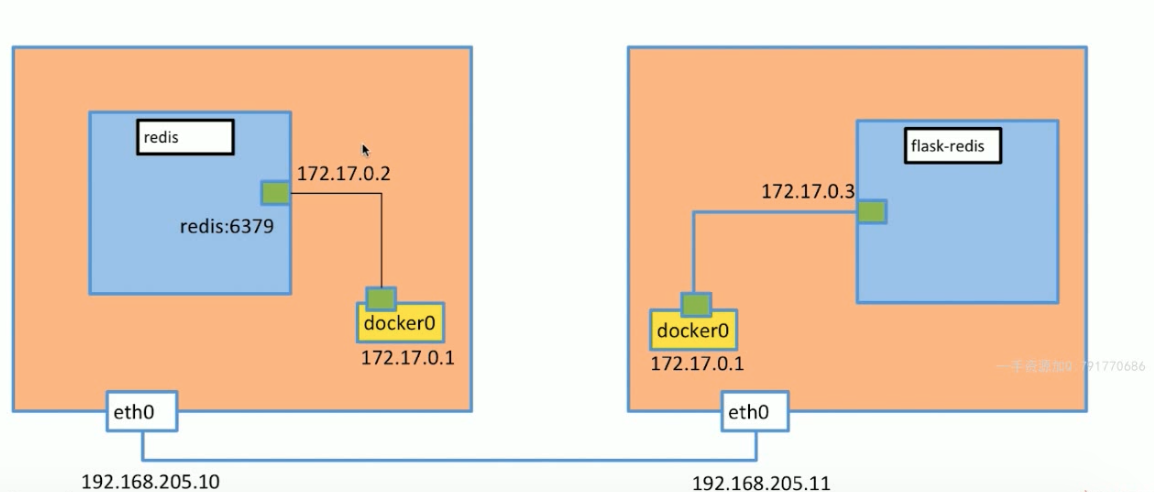

3. 实现多级通讯 是 通过 VXLAN 实现的 (原理)

承载基础网络传输的 叫做 underlay

承载网络信息或叙述的 叫做 overlay

4.安装分布式存储 (防止 ip 被占用)etcd

在docker-node1上

1.获取 etcd

wget https://github.com/coreos/etcd/releases/download/v3.0.12/etcd-v3.0.12-linux-amd64.tar.gz

2.解压 etcd 并 进入 etcd 文件夹

tar zxvf etcd-v3.0.12-linux-amd64.tar.gz && cd etcd-v3.0.12-linux-amd64

3. 运行监听网络命令

nohup ./etcd --name docker-node1 --initial-advertise-peer-urls http://192.168.205.10:2380 --listen-peer-urls http://192.168.205.10:2380 --listen-client-urls http://192.168.205.10:2379,http://127.0.0.1:2379 --advertise-client-urls http://192.168.205.10:2379 --initial-cluster-token etcd-cluster --initial-cluster docker-node1=http://192.168.205.10:2380,docker-node2=http://192.168.205.11:2380 --initial-cluster-state new&

在docker-node2上

1.获取 etcd

wget https://github.com/coreos/etcd/releases/download/v3.0.12/etcd-v3.0.12-linux-amd64.tar.gz

2.解压 etcd 并 进入 etcd 文件夹

tar zxvf etcd-v3.0.12-linux-amd64.tar.gz && cd etcd-v3.0.12-linux-amd64

3. 运行监听网络命令

nohup ./etcd --name docker-node2 --initial-advertise-peer-urls http://192.168.205.11:2380 --listen-peer-urls http://192.168.205.11:2380 --listen-client-urls http://192.168.205.11:2379,http://127.0.0.1:2379 --advertise-client-urls http://192.168.205.11:2379 --initial-cluster-token etcd-cluster --initial-cluster docker-node1=http://192.168.205.10:2380,docker-node2=http://192.168.205.11:2380 --initial-cluster-state new&

在docker-node1 和 docker-node2 上 分别查看etcd的状态 在etcd的文件夹内 并停止 etcd

./etcdctl cluster-health

![]()

sudo service docker stop

在docker-node1 上

sudo /usr/bin/dockerd -H tcp://0.0.0.0:2375 -H unix:///var/run/docker.sock --cluster-store=etcd://192.168.205.10:2379 --cluster-advertise=192.168.205.10:2375&

在docker-node2上

sudo /usr/bin/dockerd -H tcp://0.0.0.0:2375 -H unix:///var/run/docker.sock --cluster-store=etcd://192.168.205.11:2379 --cluster-advertise=192.168.205.11:2375&

为防止 在屏幕上直接打印 log 信息

先退出 再登陆 到虚拟机

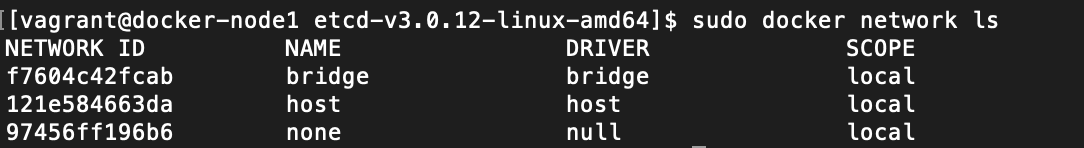

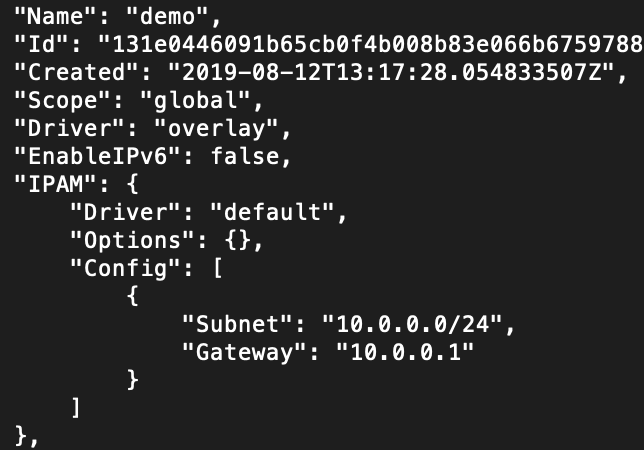

5.创建overlay network

在docker-node1上创建一个demo的overlay network

查看原有网络

sudo docker network ls

创建 overlay 网络

sudo docker network create -d overlay demo

![]()

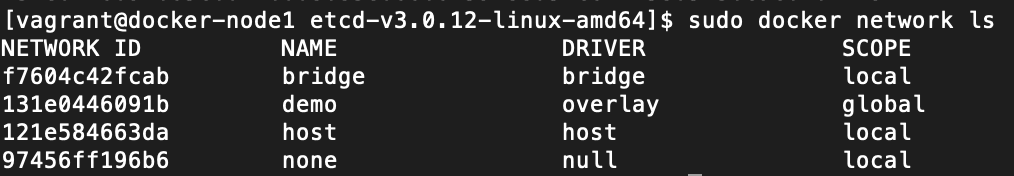

查看网络详情

sudo docker network inspect demo

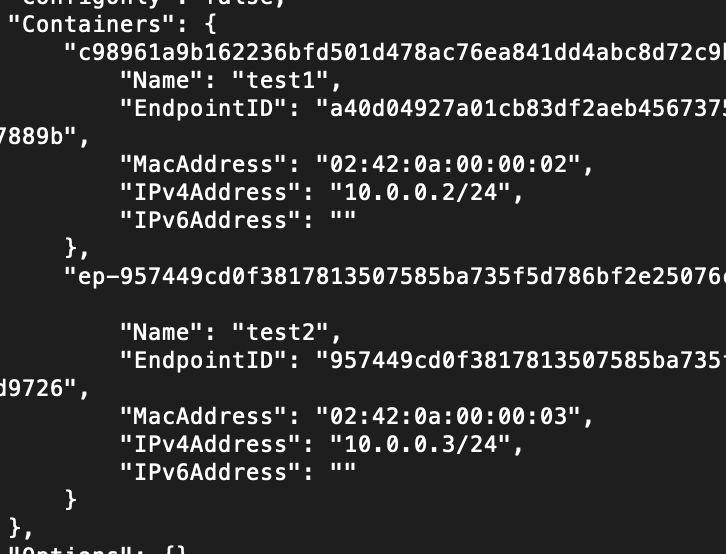

在node2上,这个demo的overlay network会被同步创建

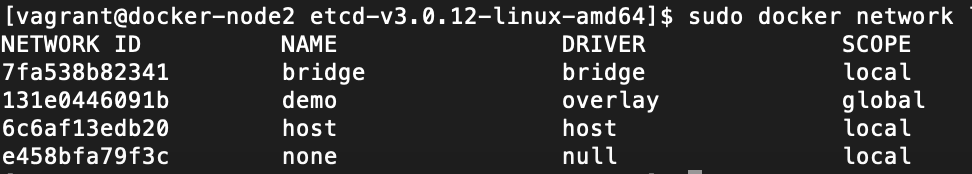

sudo docker network ls

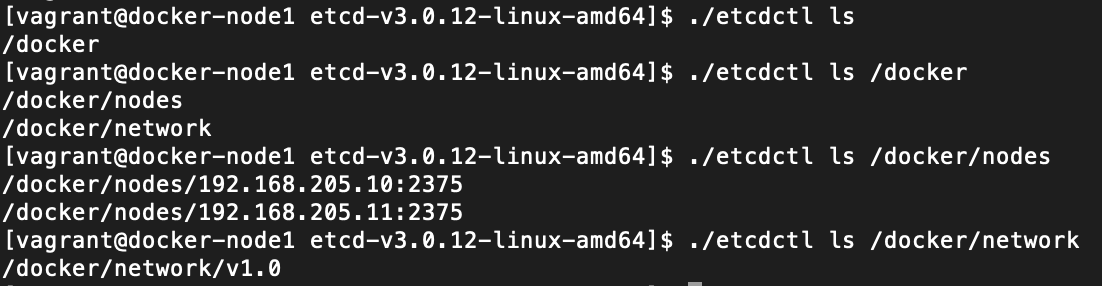

通过查看etcd的key-value, 我们获取到,这个demo的network是通过etcd从node1同步到node2的

在docker-node2 上运行

./etcdctl ls

./etcdctl ls /docker

./etcdctl ls /docker/nodes

./etcdctl ls /docker/network

./etcdctl ls /docker/network/v1.0

./etcdctl ls /docker/network/v1.0/network

![]()

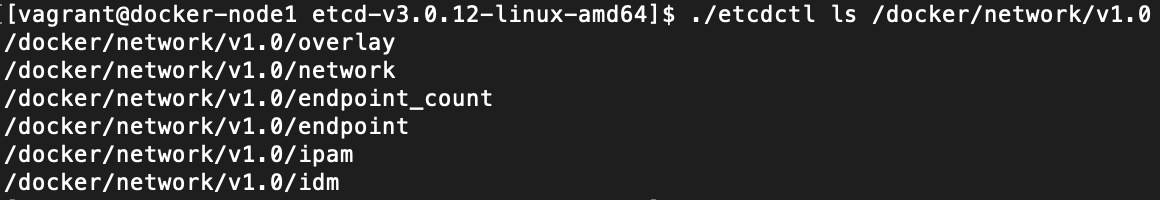

可以看出 与上面创建的 overlay 网络是一致的

![]()

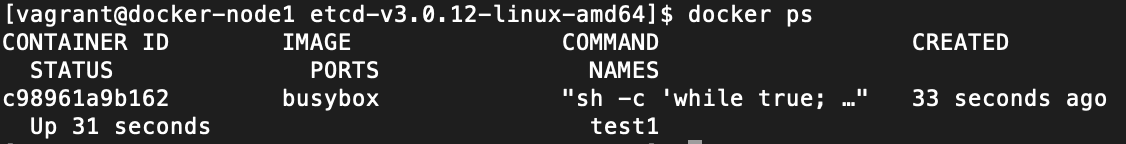

6.在overlay 网络上创建container

在 docker-node1 上 创建容器

sudo docker run -d --name test1 --net demo busybox sh -c "while true; do sleep 3600; done"

查看容器

sudo docker ps

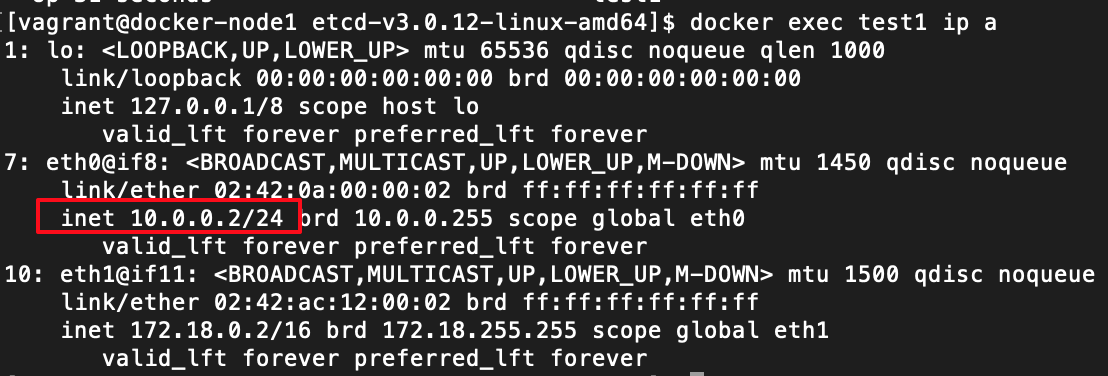

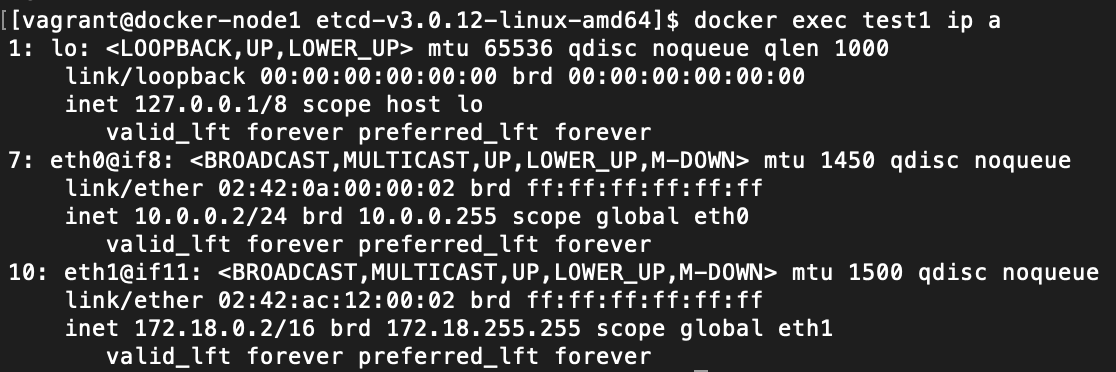

查看 test1 ip 地址

docker exec test1 ip a

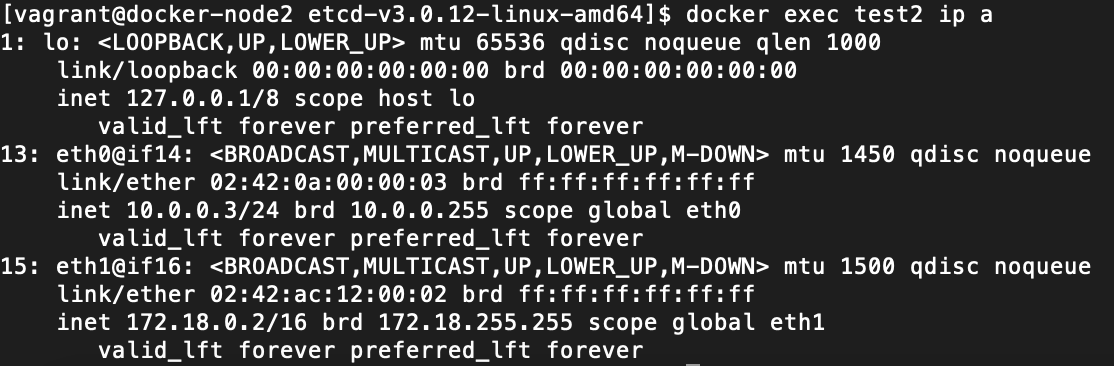

在docker-node2上创建容器

如果想再docker-node2 上创建 test1 容器 是不行的 会报错

![]()

创建 test2

sudo docker run -d --name test2 --net demo busybox sh -c "while true; do sleep 3600; done"

![]()

查看test2 ip 地址

查看 overlay 网络下的 容器情况

docker network inspect demo

可以看出两个容器的 ip 地址为 10.0.0.2 和 10.0.0.3

用 test1 ping test2 或者 用 test2 ping test1 发现是可以ping通的

在docker-node 1 下运行

docker exec test1 ping 10.0.0.3 或者 docker exec test1 ping test2

在docker-node 2 下运行

docker exec test2 ping 10.0.0.2 或者 docker exec test2 ping test1

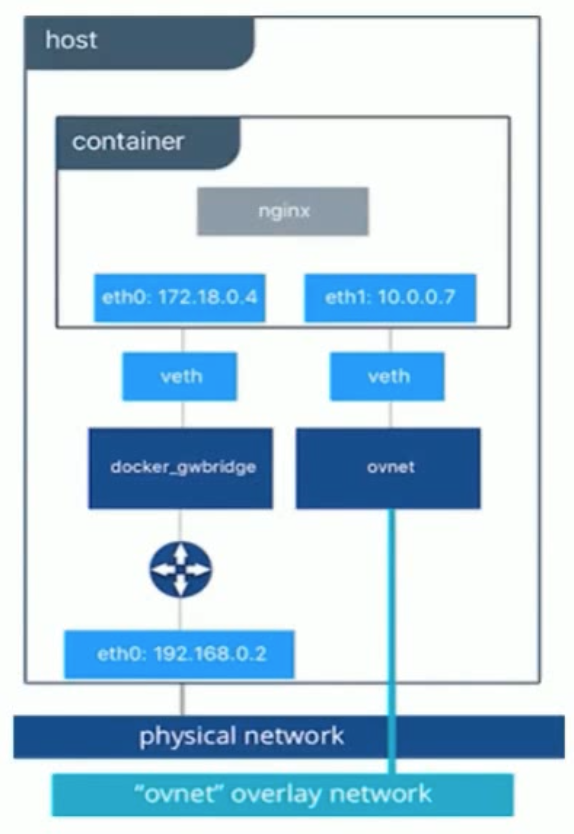

6. 为啥 docker exec test ip a 会有三个网络

lo 是 管道

if8 的 10.0.0.1 是 overlay 的网络

if11 是 container 连接 docker 的 网络

如下图

浙公网安备 33010602011771号

浙公网安备 33010602011771号