暑假第二周

第二周熟悉了一些Linux的指令,林子雨老师教程原址:http://dblab.xmu.edu.cn/blog/1624-2/

cd /home/hadoop #把/home/hadoop设置为当前目录

cd .. #返回上一级目录

cd ~ #进入到当前Linux系统登录用户的主目录(或主文件夹)。在 Linux 系统中,~代表的是用户的主文件夹,即“/home/用户名”这个目录,如果当前登录用户名为 hadoop,则~就代表“/home/hadoop/”这个目录

ls #查看当前目录中的文件

ls -l #查看文件和目录的权限信息

mkdir input #在当前目录下创建input子目录

mkdir -p src/main/scala #在当前目录下,创建多级子目录src/main/scala

cat /proc/version #查看Linux系统内核版本信息

cat /home/hadoop/word.txt #把/home/hadoop/word.txt这个文件全部内容显示到屏幕上

cat file1 file2 > file3 #把当前目录下的file1和file2两个文件进行合并生成文件file3

head -5 word.txt #把当前目录下的word.txt文件中的前5行内容显示到屏幕上

cp /home/hadoop/word.txt /usr/local/ #把/home/hadoop/word.txt文件复制到“/usr/local”目录下

rm ./word.txt #删除当前目录下的word.txt文件

rm –r ./test #删除当前目录下的test目录及其下面的所有文件

rm –r test* #删除当面目录下所有以test开头的目录和文件

tar -zxf ~/下载/spark-2.1.0.tgz -C /usr/local/ #把spark-2.1.0.tgz这个压缩文件解压到/usr/local目录下

mv spark-2.1.0 spark #把spark-2.1.0目录重新命名为spark

chown -R hadoop:hadoop ./spark # hadoop是当前登录Linux系统的用户名,把当前目录下的spark子目录的所有权限,赋予给用户hadoop

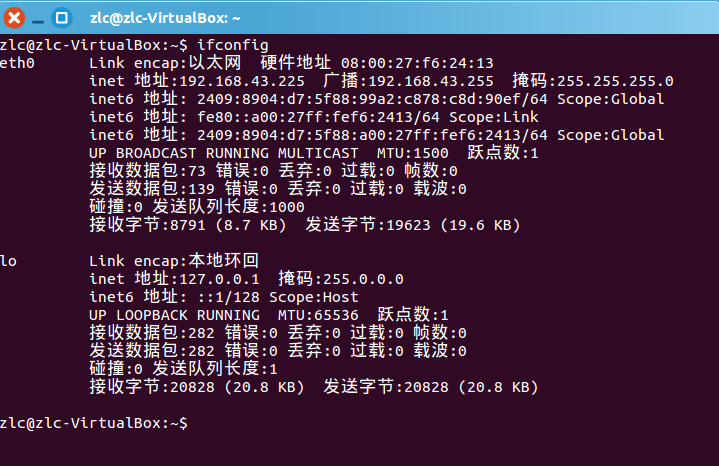

ifconfig #查看本机IP地址信息

exit #退出并关闭Linux终端

之后不知道如何向虚拟机中传输文件,之后在林子雨老师的教程中发现了在Windows系统中通过FTP软件向Ubuntu传输文件,原址:http://dblab.xmu.edu.cn/blog/1608-2/

在虚拟机Ubuntu系统中打开终端输入ifconfig找到以太网的ip地址,这里我搞混过一次,注意不是本地环回的地址127.0.0.1,而是以太网ip地址!

如图: