ProlificDreamer(VSD) 论文阅读笔记

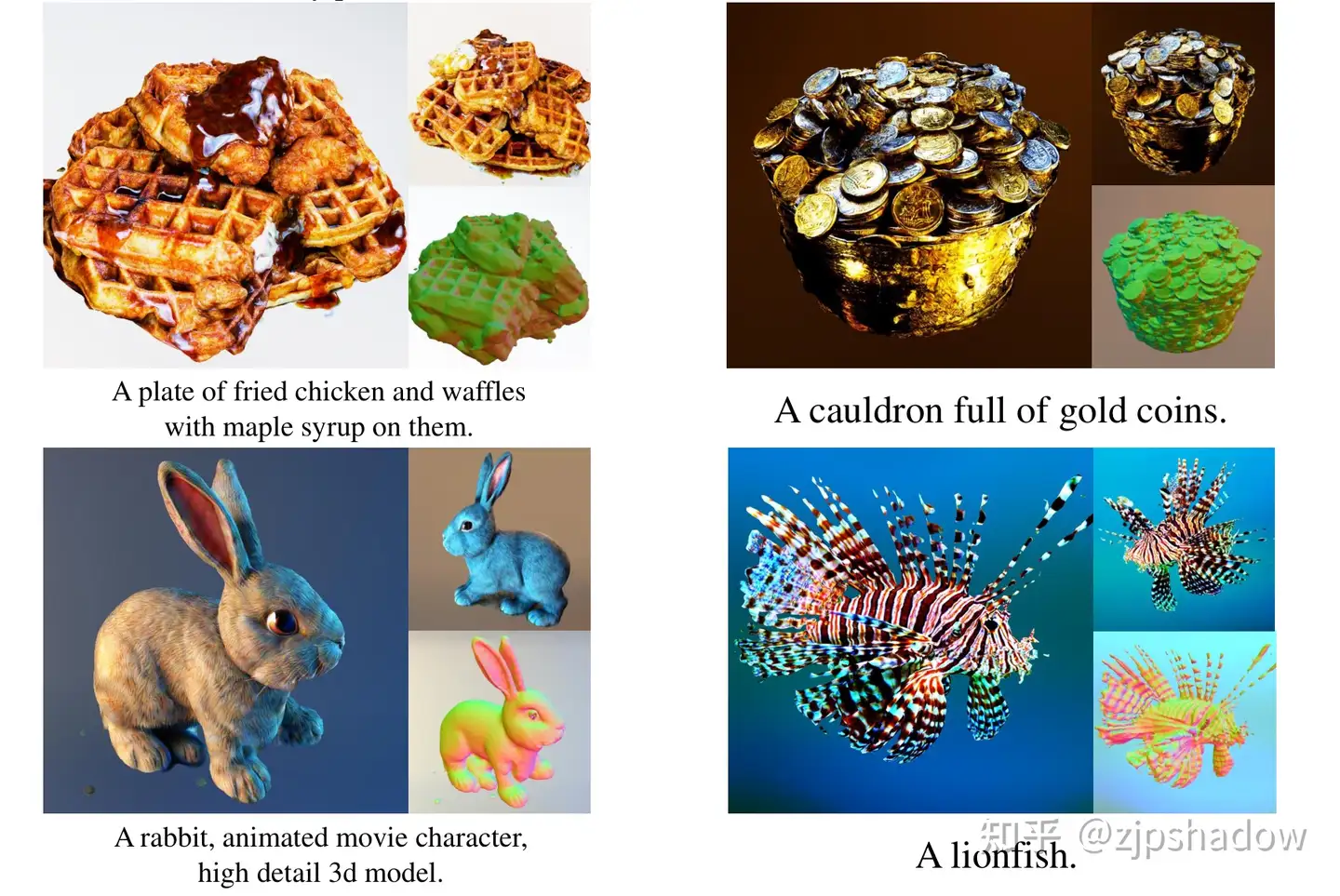

这是一篇 text to 3D 方向的突破性的文章,效果确实非常棒,据说一作的朋友圈中也说“他们将这个领域从20分提升到了70分的水平”,预测之后会有许多基于该方法的优秀文章与产品出现,毕竟之前 SDS follow 的文章也有很大一批。本阅读笔记就简要去记录一下这篇论文的主要方法和思想。

Variational Score Distillation (VSD) 是将之前提出的 Score Distillation Sampling (SDS)方法进行了泛化,换言之文章证明了 SDS 是 VSD 的一个特殊情况。目前所有 2D to 3D 做生成的基本都是基于 SDS 方法(DreamFusion),也有基于 SJC 的工作,但二者方法大体上基本一致,取得了一定的效果。

背景

论文首先简要回顾一下 Diffusion 和 SDS 方法。

Diffusion Models

对于前向过程 会向数据点 逐渐添加噪声 ,反向过程 生成数据。前向满足 且反向满足 (相关推导可以看原版Diffusion Model 的内容,网上很多)。这里的 和 为超参,满足 (即 )

为了学习这个反向的过程,也就是生成的过程,这里需要训练一个降噪的网络 ,用如下经典 loss 去训练:

是关于 的一个权重函数(这个 MSE loss 意义是让网络预测的噪声 尽量贴近真实噪声 )。这样保证了在 情况下满足可以采样出 。这里可以用 SDE 那篇文章中的 score function 表示 。

对于常见的 text-to-image 生成过程,用的是 其中 为 text prompt,classifier-free guidance(CFG)是常用的方法,用于平衡多样性和质量。用 来表示,其中 为 guidance scale。

Text-to-3D 生成 score distillation sampling (SDS)

SDS方法顾名思义就是用来蒸馏预训练好的扩散模型,目前已经成了 2D-to-3D 路线中唯一的一个方法。即如果有预训练好的 2D Diffusion 模型 与网络 ,那么 SDS 会优化在一个参数 下的 3D 表达。

引入一些符号:相机参数 (内参+外参)、分布 以及可微渲染函数 。 为渲染图 在时刻 前向扩散过程中的分布(这里分布指的是 2D Diffusion)。

那么对于 SDS 他们需要优化的是参数 ,即最小化 loss:

即让可微渲染图在第 步扩散与预训练模型的分布近似,从而让最后整体在 的分布进行近似,用这里 KL 散度保证这个事情。

我们要优化这个得分函数,只需要求得这个梯度,可以近似为

这就是基于 SDS 的核心逻辑 ,不断去优化下一个对应获得参数。相关推导以及理论可以参考 DreamFusion 及其引用。

3D 表示

这里用经典的 NeRF(Neural Radiance Fields)和 DMTet(Deep Marching Tetrahedra)两种主流方法作为 3D 表示。

-

NeRF 用 MLP 表示3D,利用 坐标输入得出 即颜色与密度表示。这里 为 MLP 的参数,那么给出相机位姿 ,就有渲染可微渲染函数 ,意义为从每个像素发射射线,计算沿着每条射线采样点的颜色的加权和,合成每个像素的颜色。NeRF在优化方面非常灵活,并能够表示极其复杂的场景。

-

DMTet 这种方法是需要拉出三角网格,用网格点的颜色表示纹理。这里的 为三角网格坐标和纹理的参数,那么有可微渲染函数 ,意义为从像素发射射线并计算射线与网格表面的交点来获得每个像素的颜色。这个方法消耗显存小,并且渲染非常快,所以可以支持高像素,但是对于复杂场景支持一般。

Variational Score Distillation(VSD)

这篇文章提出的核心就是 VSD ,通过在 3D场景的分布中采样,用3D参数 particles 去表示 3D 分布,基于 Wasserstein 梯度流推导出一种基于梯度的 particles 更新规则。

从3D场景中采样进行变分推断

和前面一致,若有 text prompt ,那么就存在一个对于所有 3D 表示的随机概率分布,在一个 3D 参数 表示下,这个分布我们可以记成一个概率密度函数 。并且记 为渲染图 的隐式分布(我的理解是这个为基于网络参数对渲染图的分布表达),那么有 为这个的边缘分布(对于原来联合分布相对于相机分布 的部分)。并且我们这里记 为 时预训练的 2D Diffusion 的边缘分布。

那么需要获得高质量的 3D 表示的话,作者在这里提出了用 KL Loss 拟合这个边缘分布的方法:

这是一个经典的变分推断问题,用变分分布 去近似目标分布 ,前者的边缘分布意义可以理解为没有相机渲染视角指导下的图片分布,其应该对应上 2D Diffusion 从 web scale 图片下获取的分布。

直接最优化这个函数是比较复杂的,因为 是相当复杂的一个分布,并且在高维空间中这个分布的高密度区域是很稀疏的。有一种解释是如果这个分布是支撑在高维空间中的低维流形时,他们重叠部分的测度为 的概率几乎是 ,这样直接去近似的 Loss 是很难下降的。

但仍可以借鉴扩散模型的思路去转化为优化每一个 的扩散分布,这个之前有许多成功的先例,形如 SDS ,这里就使用变分分数蒸馏(VSD)方法去优化这个 loss:

这里大部分定义和前面 SDS 可以类比的,其中分布定义有 ,类似地 为前者的边缘分布,并且 为时间 对应的加噪分布,根据Diffusion Model 的推导有 ,这里 与前面的定义类似为时间权重函数。等式成立的条件是因为联合分布和边缘分布在 KL 散度下的一致性。

这里就可以发现该方法与 SDS 的区别了,SDS是为了3D表示的参数 也就是单个数据点,但 VSD 是为了得出整体 3D的概率分布空间 ,从整个空间中我们再采样出数据点 。

而且作者在附录中证明了优化这个额外 KL loss 就可以达到最初近似分布的目的,即对于任意 都有

VSD 的更新方法

为了解决 ,最简单的方法是训练另一个以 为参数的生成模型,但这会带来许多计算上的消耗。这里介绍了 particle-based 的变分推断方法,即使用 个(平衡效果和计算消耗)3D 参数 作为 particles 并且遵循一个更新法则。直观地说,用这 个 particles 来代表当前的分布 ,并且 会从优化后的分布 中进行采样(如果收敛的话)。

这样的优化过程可以被写成模拟一个关于 的 ODE 的过程,下面进行描述:

-

对于 VSD 的 Wasserstein 梯度流:

Wasserstein梯度流:基于Wasserstein距离的梯度信息,定义了一个概率分布随时间演化的微分方程。在Wasserstein梯度流中,考虑一个初始概率分布 和目标概率分布 ,目标是找到一个时间依赖的概率分布 ,其中 在 范围内变化,使得 在每个时间点 的 Wasserstein 距离与目标分布 最小化。

剩余相关证明和推导可以见原文附录,下面仅作定理叙述。

从初始分布 开始,对于任意时刻 ,记在分布空间最优化 过程的 Wasserstein 梯度流为 其中 ,那么我们可以从 中采样 ,首先采样 然后之后的用如下 ODE 进行模拟:

只需要求出足够大的 ,就能近似到希望求出的分布 。

右式类似于 SDS 的梯度求法,其中对于 score of noisy real images 可以直接用预训练好的 2D Diffusion 降噪网络 进行近似,对于后者 我们这里采用另外一个降噪网络 进行近似,这个我们用 渲染好的图片以及标准的Diff Loss 进行训练:

即用这个 MSE Loss 去拟合这个标准噪声。

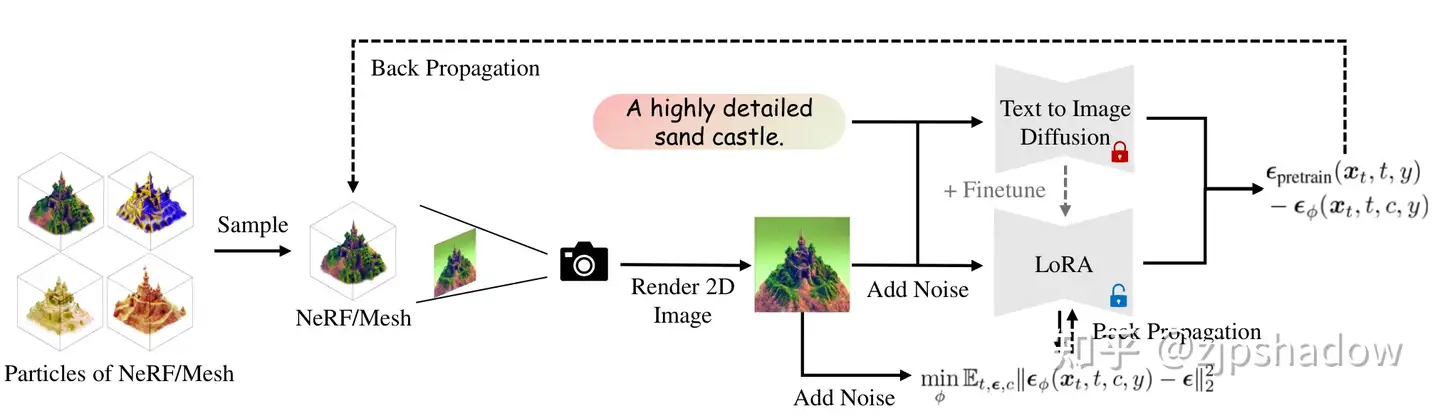

这篇文章用了一个 U-Net 或者对于原来预训练模型 的 LoRA 去表示这个参数 ,并且添加了相机的位姿 作为 condition embedding 到网络中。作者根据实验说 LoRA 在 few-shot 下的保真度非常好。

注意到对于每个 ODE 的时刻 ,需要去确认 符合当前的 3D分布 ,这样需要轮流优化 和 。对于 particle 我们用 进行优化(其中 为 learning rate),由之前的式子,这个梯度可以被表示为

在这里有 即渲染图在时刻 加噪后的情况。

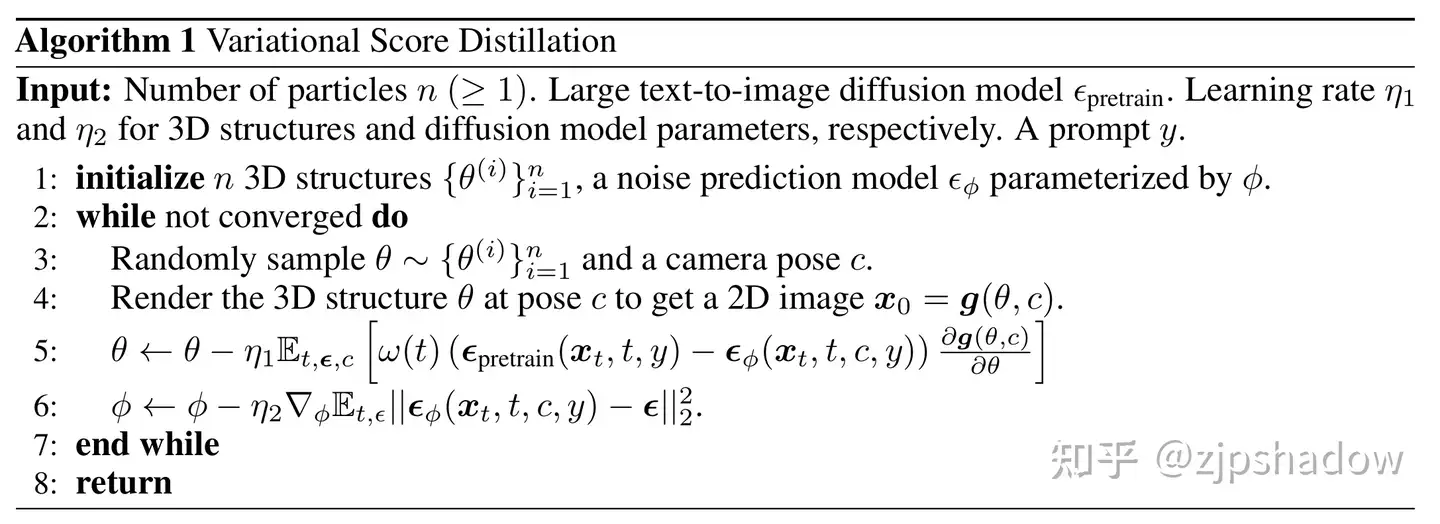

伪代码如下:

网络结构

整体网络结构与 SDS 方法是类似的,结合上面的伪代码即可看懂。

- 首先随机从当前分布中采样网络的3D参数 ,以及相机位姿

- 然后利用可微渲染方法,渲染出对应的 2D 图片

- 而后更新3D表达的参数 为

- 最后更新 LoRA 中蕴含的潜在 3D 分布 为 ,即更加贴近原本 的分布,如此往复直至收敛。

__EOF__

本文链接:https://www.cnblogs.com/zjp-shadow/p/17437139.html

关于博主:评论和私信会在第一时间回复。或者直接私信我。

版权声明:本博客所有文章除特别声明外,均采用 BY-NC-SA 许可协议。转载请注明出处!

声援博主:如果您觉得文章对您有帮助,可以点击文章右下角【推荐】一下。您的鼓励是博主的最大动力!

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 单线程的Redis速度为什么快?

· 展开说说关于C#中ORM框架的用法!

· Pantheons:用 TypeScript 打造主流大模型对话的一站式集成库

· SQL Server 2025 AI相关能力初探

· 为什么 退出登录 或 修改密码 无法使 token 失效

2018-05-27 LOJ #2541. 「PKUWC 2018」猎人杀(容斥 , 期望dp , NTT优化)

2018-05-27 LOJ #2540. 「PKUWC 2018」随机算法(概率dp)