FFmpeg学习:FFmpeg4数据结构分析

FFmpeg数据结构分析

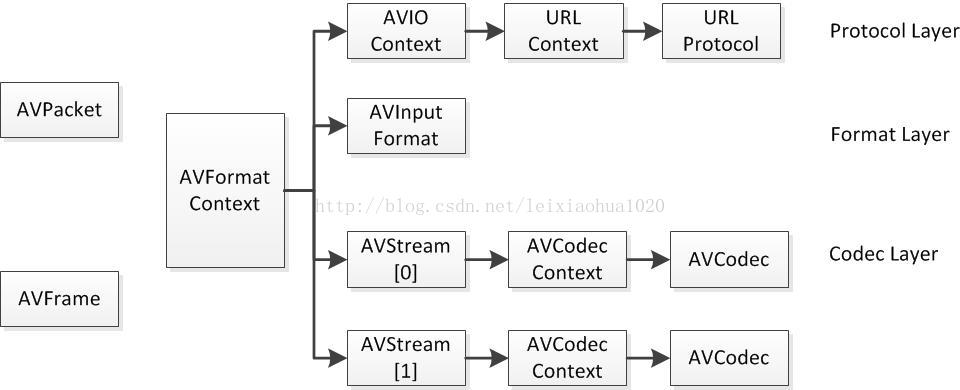

FFMPEG中结构体很多。最关键的结构体可以分成以下几类:

1、解协议(http,rtsp,rtmp,mms)

AVIOContext,URLProtocol,URLContext主要存储视音频使用的协议的类型以及状态。URLProtocol存储输入视音频使用的封装格式。每种协议都对应一个URLProtocol结构。(注意:FFMPEG中文件也被当做一种协议“file”)

2、解封装(flv,avi,rmvb,mp4)

AVFormatContext主要存储视音频封装格式中包含的信息;AVInputFormat存储输入视音频使用的封装格式。每种视音频封装格式都对应一个AVInputFormat 结构。

3、解码(h264,mpeg2,aac,mp3)

每个AVStream存储一个视频/音频流的相关数据;每个AVStream对应一个AVCodecContext,存储该视频/音频流使用解码方式的相关数据;每个AVCodecContext中对应一个AVCodec,包含该视频/音频对应的解码器。每种解码器都对应一个AVCodec结构。

4、存数据

视频的话,每个结构一般是存一帧;音频可能有好几帧

解码前数据:AVPacket

解码后数据:AVFrame

它们之间的关系如下图所示

常见结构体初始化与销毁函数

| 结构体 | 初始化 | 销毁 |

|---|---|---|

| AVFormatContext | avformat_alloc_context() | avformat_free_context() /avformat_close_input() |

| AVOutputFormat | avformat_alloc_output_context | |

| AVIOContext | avio_alloc_context() | |

| AVStream | avformat_new_stream() | |

| AVCodecContext | avcodec_alloc_context3() | |

| AVPacket | av_packet_alloc() | av_packet_free() |

| AVFrame | av_frame_alloc() ,av_image_fill_arrays() | av_frame_free() |

AVFormatContext(位于avformat.h)

- 描述媒体文件或媒体流的构成和基本信息,贯穿ffmpeg使用整个流程,很多函数都要用到它作为参数。它是FFMPEG解封装(flv,mp4,rmvb,avi)功能的结构体。下面看几个主要变量的作用

AVInputFormat *iformat、AVOutputFormat *oformat:输入或者输出流的格式(只能存在一个)

AVIOContext *pb:管理输入输出数据

unsigned int nb_streams:音视频流的个数

AVStream **streams:音视频流

char *url:文件名

int64_t duration:时长

int bit_rate:比特率(单位bite/s)

AVDictionary *metadata:元数据(查看元数据:ffprobe filename)

- 视频的时长可以转换成HH:MM:SS的形式,示例代码如下:

AVFormatContext *pFormatCtx;

CString timelong;

...

//duration是以微秒为单位

//转换成hh:mm:ss形式

int tns, thh, tmm, tss;

tns = (pFormatCtx->duration)/1000000;

thh = tns / 3600;

tmm = (tns % 3600) / 60;

tss = (tns % 60);

timelong.Format("%02d:%02d:%02d",thh,tmm,tss);

- 视频的原数据(metadata)信息可以通过AVDictionary获取。元数据存储在AVDictionaryEntry结构体中,如下所示

typedef struct AVDictionaryEntry {

char *key;

char *value;

} AVDictionaryEntry;

每一条元数据分为key和value两个属性。

在ffmpeg中通过av_dict_get()函数获得视频的原数据。

下列代码显示了获取元数据并存入meta字符串变量的过程,注意每一条key和value之间有一个"\t:",value之后有一个"\r\n"

//MetaData------------------------------------------------------------

//从AVDictionary获得

//需要用到AVDictionaryEntry对象

//CString author,copyright,description;

CString meta=NULL,key,value;

AVDictionaryEntry *m = NULL;

//使用循环读出

//(需要读取的数据,字段名称,前一条字段(循环时使用),参数)

while(m=av_dict_get(pFormatCtx->metadata,"",m,AV_DICT_IGNORE_SUFFIX)){

key.Format(m->key);

value.Format(m->value);

meta+=key+"\t:"+value+"\r\n" ;

}

AVInputFormat 打开输入文件封装格式

typedef struct AVInputFormat {

const char *name;//输入时的封装格式名

const char *long_name;//同上,但是更人性化

const char *extensions;//输入封装格式的扩展名

/*......*/

}AVInputFormat;

- 解复用时由avformat_open_input初始化赋值,且只在解复用有效,复用无效(不使用它,而使用另一个AVOutputFormat )。

注:有效是指输入时的AVFormatContext->AVInputFormat有效,而输出时是指另一个AVFormatContext->AVOutputFormat有效,第一个AVFormatContext和第二个AVFormatContext是不同的,一个是输入时的解封装上下文,一个是输出时的封装上下文。

AVOutputFormat 输出文件封装格式

AVOutputFormat和AVInputFormat非常相似,里面只是存放要输出文件的相关属性。例如flv,mkv封装格式名称。其它均为avformat内部处理封装格式的API,即priv_class以下的字段。

typedef struct AVOutputFormat{

const char *name;//输出时的封装格式名

const char *long_name;//同上,但是更人性化

const char *extensions;//输出封装格式的扩展名

/*......*/

}AVOutputFormat;

- 由avformat_alloc_output_context2(&m_outputContext, nullptr, “flv”, outUrl.c_str())打开时确定对应的封装格式(例如flv)进行开辟内存并初始化赋值,只有在复用时才有效,解复用无效。

AVIOContext(位于 avio.h)

AVIOContext:文件(协议)操作的顶层对象

- AVIOContext是FFMPEG管理输入输出数据的结构体。本文将会详细分析一下该结构体里每个变量的含义和作用。

unsigned char *buffer:缓冲开始位置

int buffer_size:缓冲区大小(默认32768)

unsigned char *buf_ptr:当前指针读取到的位置

unsigned char *buf_end:缓存结束的位置

void *opaque:URLContext结构体

(*read_packet)(...):读取音视频数据的函数指针

(*write_packet)(...):写入音视频数据的函数指针

(*read_pause)(...):网络流媒体协议的暂停或恢复播放函数指针

在解码的情况下,buffer用于存储ffmpeg读入的数据。例如打开一个视频文件的时候,先把数据从硬盘读入buffer,然后在送给解码器用于解码。

其中opaque指向了URLContext。注意,这个结构体并不在FFMPEG提供的头文件中,而是在FFMPEG的源代码中。

URLContext:每种协议,有一个协议操作对象和一个关联的协议对象

char* name:协议名称

const struct URLProtocol *prot:协议操作对象(ff_file_protocol、ff_librtmp_protocol...)

void *priv_data:协议对象(FileContext、LibRTMPContext)

URLContext结构体中还有一个结构体URLProtocol。注:每种协议(rtp,rtmp,file等)对应一个URLProtocol。这个结构体也不在FFMPEG提供的头文件中。

URLProtocol:协议操作对象

从FFMPEG源代码中翻出其的定义:

typedef struct URLProtocol {

const char *name;

int (*url_open)(URLContext *h, const char *url, int flags);

int (*url_read)(URLContext *h, unsigned char *buf, int size);

int (*url_write)(URLContext *h, const unsigned char *buf, int size);

int64_t (*url_seek)(URLContext *h, int64_t pos, int whence);

int (*url_close)(URLContext *h);

struct URLProtocol *next;

int (*url_read_pause)(URLContext *h, int pause);

int64_t (*url_read_seek)(URLContext *h, int stream_index,

int64_t timestamp, int flags);

int (*url_get_file_handle)(URLContext *h);

int priv_data_size;

const AVClass *priv_data_class;

int flags;

int (*url_check)(URLContext *h, int mask);

} URLProtocol;

在这个结构体中,除了一些回调函数接口之外,有一个变量const char *name,该变量存储了协议的名称。每一种输入协议都对应这样一个结构体。

AVStream

- AVStream是存储每一个视频/音频流信息的结构体

int index:音频流或视频流的索引

AVRational time_base:计算pts或dts是使用的时间戳基本单位(显示时间:pt = av_q2d(video_stream->time_base) * frame->pts)

int64_t duration:该视频/音频流长度

AVRational avg_frame_rate:平均帧率(对于视频来说,frame_rate=avg_frame_rate.num / avg_frame_rate.den)

AVCodecParameters *codecpar:解码器参数

AVCodecParameter 和 AVCodecContext

- 新的 ffmpeg 中 AVStream.codecpar(struct AVCodecParameter) 代替 AVStream.codec(struct AVCodecContext):AVCodecParameter 是由 AVCodecContext 分离出来的,AVCodecParameter中没有函数

- AVCodecContext 结构体仍然是编解码时不可或缺的结构体:avcodec_send_packet 和 avcodec_receive_frame 使用 AVCodecContext

- AVCodecContext 和 AVCodec 的获取方法

//=============== new version code ===============

char filePath[] = "test.mp4";

AVFormatContext *pFormatCtx;

AVCodecContext *pCodecCtx;

AVCodec *pCodec;

pFormatCtx = avformat_alloc_context();

av_register_all();

avformat_network_init();

avformat_open_input(&pFormatCtx, filePath, NULL, NULL);

avformat_find_stream_info(pFormatCtx, NULL);

for (int i = 0; i < pFormatCtx->nb_streams; i++)

{

AVStream *pStream = pFormatCtx->streams[i];

pCodec = avcodec_find_decoder(pStream->codecpar->codec_id);

pCodecCtx = avcodec_alloc_context3(pCodec);

avcodec_parameters_to_context(pCodecCtx, pStream->codecpar);

}

- AVCodecContext关键参数:可参考 AVCodecContextavcodec_parameters_to_context 源码

num AVMediaType codec_type:编解码器的类型(视频,音频...)

enum AVCodecID codec_id:标示特定的编码器

AVCodecContext:struct AVCodec *codec:采用的解码器AVCodec(H.264,MPEG2...)

unsigned int codec_tag:

int bit_rate:平均比特率

uint8_t *extradata; int extradata_size:针对特定编码器包含的附加信息(例如对于H.264解码器来说,存储SPS,PPS等)

AVRational time_base; 根据该参数可以将pts转化为时间(AVCodecContext->time_base单位同样为秒,不过精度没有AVStream->time_base高,大小为1/framerate)

AVCodecContext:enum AVPixelFormat pix_fmt:像素格式(视频)

int width, height:宽和高(视频)

int gop_size; 一组图片的数量,编码时用户设置,解码时不使用

int refs; 参考帧的数量

enum AVColorSpace colorspace; YUV色彩空间类型

enum AVColorRange color_range; MPEG JPEG YUV范围

AVCodecContext:enum AVSampleFormat sample_fmt:采样格式(音频)

int sample_rate:采样率(音频)

int frame_size; 每个音频帧中每个声道的采样数量

int channels:声道数(音频)

uint64_t channel_layout:声道格式

AVCodecParameters:int format:像素格式(视频)/采样格式(音频)

int profile;配置类型(画质高低,会影响码率)

int level;级别

av_opt_set(pCodecEncodeCtx_Video->priv_data, "tune", "zerolatency", 0);//避免

AVCodec:编解码器结构体

- AVCodec是存储编解码器信息的结构体

- 关键成员变量如下:

const char *name:编解码器短名字(形如:"h264")

const char *long_name:编解码器全称(形如:"H.264 / AVC / MPEG-4 AVC / MPEG-4 part 10")

enum AVMediaType type:媒体类型:视频、音频或字幕

enum AVCodecID id:标示特定的编码器

const AVRational *supported_framerates:支持的帧率(仅视频)

const enum AVPixelFormat *pix_fmts:支持的像素格式(仅视频)

const int *supported_samplerates:支持的采样率(仅音频)

const enum AVSampleFormat *sample_fmts:支持的采样格式(仅音频)

const uint64_t *channel_layouts:支持的声道数(仅音频)

enum AVMediaType type

- AVMediaType定义如下:

enum AVMediaType {

AVMEDIA_TYPE_UNKNOWN = -1, ///< Usually treated as AVMEDIA_TYPE_DATA

AVMEDIA_TYPE_VIDEO,

AVMEDIA_TYPE_AUDIO,

AVMEDIA_TYPE_DATA, ///< Opaque data information usually continuous

AVMEDIA_TYPE_SUBTITLE,

AVMEDIA_TYPE_ATTACHMENT, ///< Opaque data information usually sparse

AVMEDIA_TYPE_NB

};

enum AVCodecID id

- AVCodecID定义如下:

enum AVCodecID {

AV_CODEC_ID_NONE,

/* video codecs */

AV_CODEC_ID_MPEG1VIDEO,

AV_CODEC_ID_MPEG2VIDEO, ///< preferred ID for MPEG-1/2 video decoding

AV_CODEC_ID_MPEG2VIDEO_XVMC,

AV_CODEC_ID_H261,

AV_CODEC_ID_H263,

AV_CODEC_ID_RV10,

AV_CODEC_ID_RV20,

AV_CODEC_ID_MJPEG,

AV_CODEC_ID_MJPEGB,

AV_CODEC_ID_LJPEG,

AV_CODEC_ID_SP5X,

AV_CODEC_ID_JPEGLS,

AV_CODEC_ID_MPEG4,

AV_CODEC_ID_RAWVIDEO,

AV_CODEC_ID_MSMPEG4V1,

AV_CODEC_ID_MSMPEG4V2,

AV_CODEC_ID_MSMPEG4V3,

AV_CODEC_ID_WMV1,

AV_CODEC_ID_WMV2,

AV_CODEC_ID_H263P,

AV_CODEC_ID_H263I,

AV_CODEC_ID_FLV1,

AV_CODEC_ID_SVQ1,

AV_CODEC_ID_SVQ3,

AV_CODEC_ID_DVVIDEO,

AV_CODEC_ID_HUFFYUV,

AV_CODEC_ID_CYUV,

AV_CODEC_ID_H264,

...(代码太长,略)

}

const enum AVPixelFormat *pix_fmts

- AVPixelFormat定义如下:

enum AVPixelFormat {

AV_PIX_FMT_NONE = -1,

AV_PIX_FMT_YUV420P, ///< planar YUV 4:2:0, 12bpp, (1 Cr & Cb sample per 2x2 Y samples)

AV_PIX_FMT_YUYV422, ///< packed YUV 4:2:2, 16bpp, Y0 Cb Y1 Cr

AV_PIX_FMT_RGB24, ///< packed RGB 8:8:8, 24bpp, RGBRGB...

AV_PIX_FMT_BGR24, ///< packed RGB 8:8:8, 24bpp, BGRBGR...

AV_PIX_FMT_YUV422P, ///< planar YUV 4:2:2, 16bpp, (1 Cr & Cb sample per 2x1 Y samples)

AV_PIX_FMT_YUV444P, ///< planar YUV 4:4:4, 24bpp, (1 Cr & Cb sample per 1x1 Y samples)

AV_PIX_FMT_YUV410P, ///< planar YUV 4:1:0, 9bpp, (1 Cr & Cb sample per 4x4 Y samples)

AV_PIX_FMT_YUV411P, ///< planar YUV 4:1:1, 12bpp, (1 Cr & Cb sample per 4x1 Y samples)

AV_PIX_FMT_GRAY8, ///< Y , 8bpp

AV_PIX_FMT_MONOWHITE, ///< Y , 1bpp, 0 is white, 1 is black, in each byte pixels are ordered from the msb to the lsb

AV_PIX_FMT_MONOBLACK, ///< Y , 1bpp, 0 is black, 1 is white, in each byte pixels are ordered from the msb to the lsb

AV_PIX_FMT_PAL8, ///< 8 bit with PIX_FMT_RGB32 palette

AV_PIX_FMT_YUVJ420P, ///< planar YUV 4:2:0, 12bpp, full scale (JPEG), deprecated in favor of PIX_FMT_YUV420P and setting color_range

AV_PIX_FMT_YUVJ422P, ///< planar YUV 4:2:2, 16bpp, full scale (JPEG), deprecated in favor of PIX_FMT_YUV422P and setting color_range

AV_PIX_FMT_YUVJ444P, ///< planar YUV 4:4:4, 24bpp, full scale (JPEG), deprecated in favor of PIX_FMT_YUV444P and setting color_range

AV_PIX_FMT_XVMC_MPEG2_MC,///< XVideo Motion Acceleration via common packet passing

AV_PIX_FMT_XVMC_MPEG2_IDCT,

...(代码太长,略)

}

AVPacket(位于avcodec.h文件中)

- AVPacket是存储压缩编码数据相关信息的结构体

- 关键成员变量

AVBufferRef *buf:管理data指向的数据

uint8_t *data:压缩编码的数据

int size:data的大小

int64_t pts:显示时间戳

int64_t dts:解码时间戳

int stream_index:标识该AVPacket所属的视频/音频流

- AVPacket内存管理:AVPacket本身并不包含压缩的数据,通过data指针引用数据的缓存空间

- 多个AVPacket共享同一个数据缓存(AVBufferRef、AVBuffer)

- AVBuffer拥有独立的数据缓存

AVBuffer 关键成员变量

uint8_t *data:压缩编码的数据

size_t size:数据长度

atomic_uint refcount:引用计数,如果引用计数为0,则释放数据缓存空间

AVFrame(位于avcodec.h)详细链接

- AVFrame是包含码流参数较多的结构体,存储解码后数据的结构体。

uint8_t *data[AV_NUM_DATA_POINTERS]:解码后原始数据(对视频来说是YUV,RGB,对音频来说是PCM)

int linesize[AV_NUM_DATA_POINTERS]:data中“一行”数据的大小。注意:未必等于图像的宽,一般大于图像的宽。

int width, height:视频帧宽和高(1920x1080,1280x720...)

int nb_samples:音频的一个AVFrame中可能包含多个音频帧,在此标记包含了几个

int format:解码后原始数据类型(YUV420,YUV422,RGB24...)

int key_frame:是否是关键帧

enum AVPictureType pict_type:帧类型(I,B,P...)

AVRational sample_aspect_ratio:图像宽高比(16:9,4:3...)

int64_t pts:显示时间戳

int coded_picture_number:编码帧序号

int display_picture_number:显示帧序号

int sample_rate; 采样率(音频)

uint64_t channel_layout; 声道格式(音频)

int channels; 声道数量(编码未使用),解码只读

int interlaced_frame;是否隔行扫描

int8_t *qscale_table;QP表

int quality; 帧的质量,1表示好 FF_LAMBDA_MAX表示bad

enum AVColorRange color_range; MPEG,JPEG,YUV的色彩范围

enum AVColorSpace colorspace; YUV的色彩空间

int64_t pkt_duration; 相关包的流逝时间

AVDictionary *metadata;元数据

uint8_t * data[AV_NUM_DATA_POINTERS];

对于packed格式的数据会存到data[0]中,例如RGB24

对于plannar格式的数据会存到data[0],data[1]…,例如YUV420P,会分开存到Y : data[0],U :data[1],V:data[2]

浙公网安备 33010602011771号

浙公网安备 33010602011771号