基于IDEA环境下的Spark2.X程序开发

1.Windows开发环境配置与安装

下载IDEA并安装,可以百度一下免费文档。

2.IDEA Maven工程创建与配置

1)配置maven

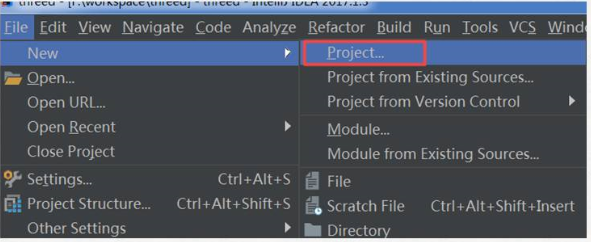

2)新建Project项目

3)选择maven骨架

4)创建项目名称

5)选择maven地址

6)生成maven项目

7)选择scala版本

选中项目按“F4”键

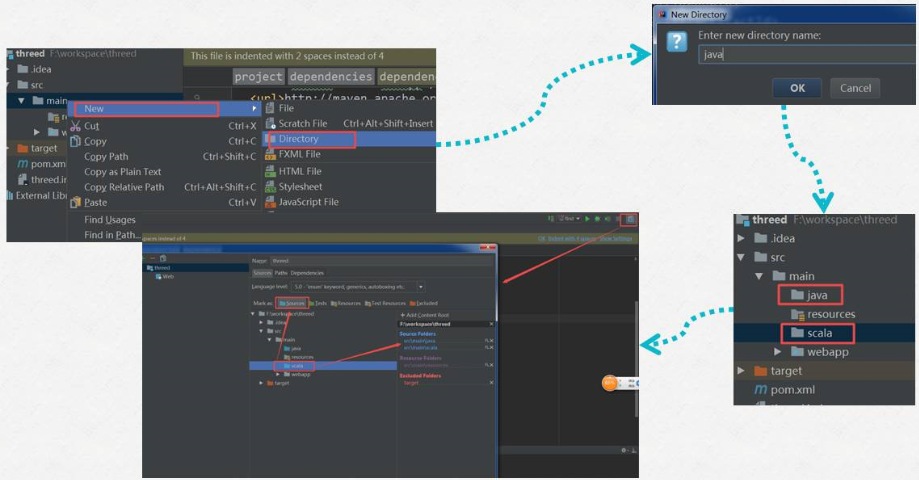

8)新建Java 和 scala目录及Class类

现在我们右键是无法找到新建Class类的选项的,需要做如下设置:

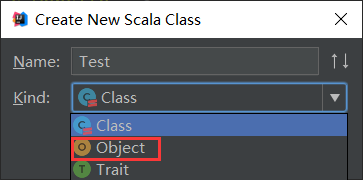

然后新建一个package(com.zimo.spark自定义),再新建一个scala Object:

9)编辑pom.xml文件

a)参考地址一

b)参考地址二

3.开发Spark Application程序并进行本地测试

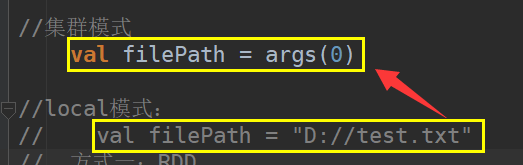

1)idea编写WordCount程序

在本地磁盘新建一个测试文件test.txt

4.本地测试

报错:

解决方案一:

解决方案二:

本地测试成功:

5.Spark Application程序打包

1)修改代码

2)项目编译及打包

完成后可以在本地项目文件目录找到打包好的jar包

3)spark-submit方式提交作业

先上传jar包

然后启动hadoop集群,将测试文件上传到HDFS上:

运行:

运行结果:

以上就是博主为大家介绍的这一板块的主要内容,这都是博主自己的学习过程,希望能给大家带来一定的指导作用,有用的还望大家点个支持,如果对你没用也望包涵,有错误烦请指出。如有期待可关注博主以第一时间获取更新哦,谢谢!同时也欢迎转载,但必须在博文明显位置标注原文地址,解释权归博主所有!

本博文由博主子墨言良原创,未经允许禁止转载,若有兴趣请关注博主以第一时间获取更新哦!