focal loss 两点理解

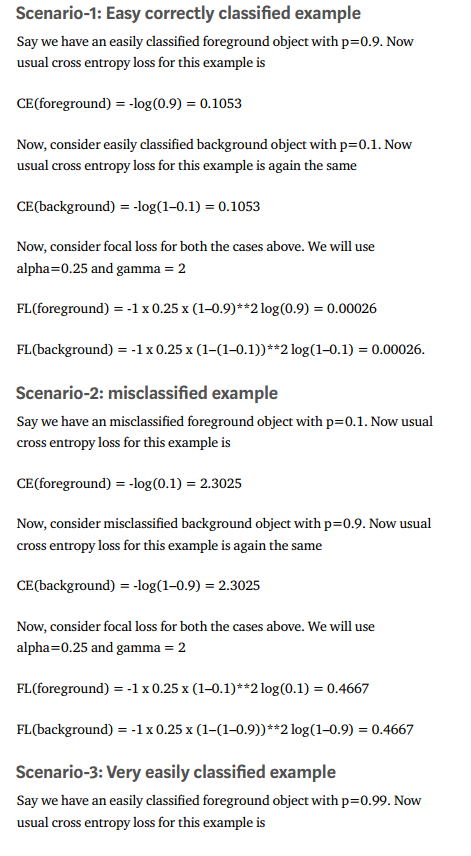

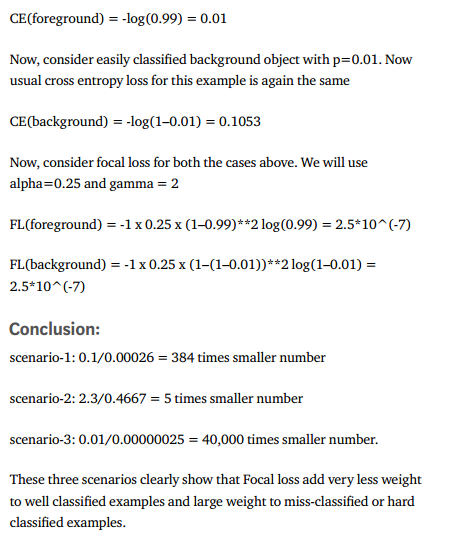

博客给出了三个算例。

可以看出,focal loss 对可很好分类的样本赋予了较小的权重,但是对分错和不易分的样本添加了较大的权重。

对于类别不平衡,使用了\(\alpha_t\)进行加权,文章中提到较好的值是0.25,说明在训练过程中仍然需要对正样本进行降权。

正常的理解是训练过程中负样本的数量应该远大于正样本,0.25的值应该是经过大量实验得出的。

一个合理的解释就是经过权重调整,随着训练的进行,正样本的权重应该逐渐下降。这个解释感觉有点牵强附会了。。。