数据挖掘概念杂记

目录

一 混淆矩阵

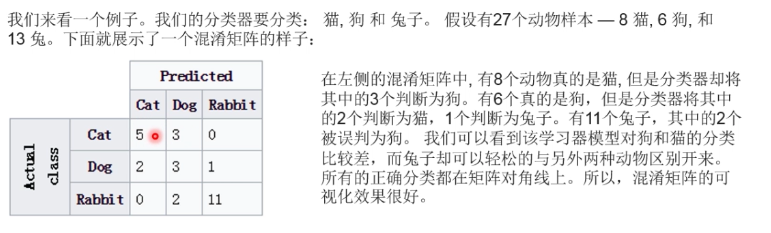

利用混淆矩阵可更好的分辨出分类中分错误的。

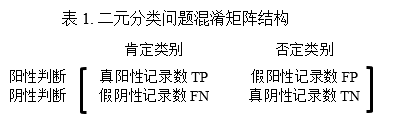

1. 数据集中的记录总数=TP+FP+FN+TN

2. 数据集中肯定记录数=TP+FN

3. 数据集中否定记录数=FP+TN

4. 分类模型作出阳性判断的记录数=TP+FP

5. 分类模型作出阴性判断的记录数=FN+TN

6. 分类模型作出正确分类的记录数=TP+TN

7. 分类模型作出错误分类的记录数=FP+FN

表1中给出的二元分类问题混淆矩阵结构可以很容易地推广到多元分类问题。对于存在n 个类别的分类问题,混淆矩阵是个n ×n的情形分析表,每一列对应一个真实的类别,而每一行对应分类模型判断的一个类别 (混淆矩阵的行和列互换没有实质影响)。

二 正确率,召回率,AUC

1 正确率

预测正确的比率

TP/(TP+FP)

2 召回率

预测为正的真实正例占所有正例的比例

TP/(TP+FN)

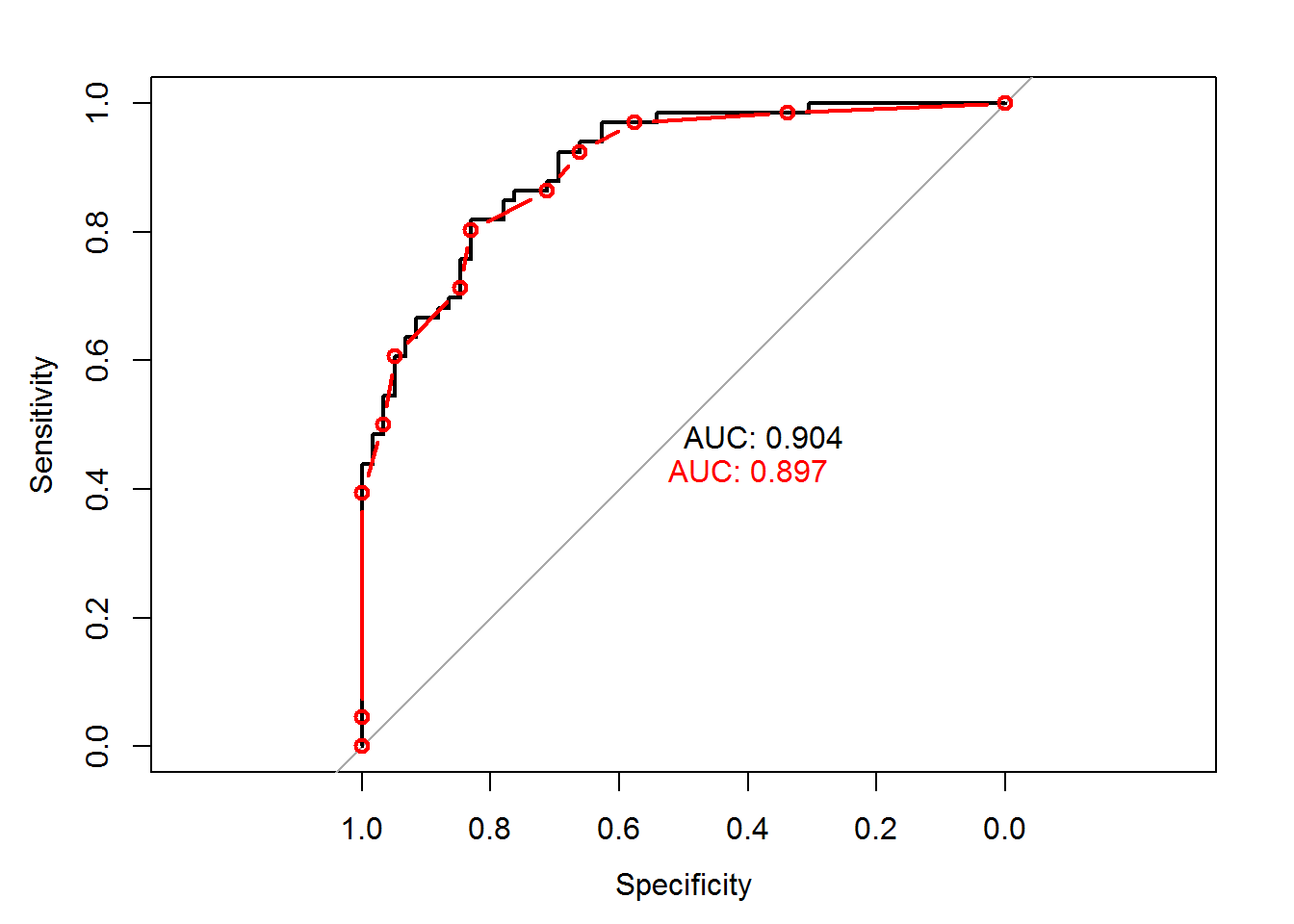

3 AUC

是指召回率曲线的以下的面积,AUC给出分类器的平均性能,一个完美的分类器AUC为1,随机猜测AUC是0.5

三 随机森林

随机森林顾名思义,是用随机的方式建立一个森林,森林里面有很多的决策树组成,随机森林的每一棵决策树之间是没有关联的。

下面是随机森林的构造过程:

1. 假如有N个样本,则有放回的随机选择N个样本(每次随机选择一个样本,然后返回继续选择)。这选择好了的N个样本用来训练一个决策树,作为决策树根节点处的样本。

2. 当每个样本有M个属性时,在决策树的每个节点需要分裂时,随机从这M个属性中选取出m个属性,满足条件m << M。然后从这m个属性中采用某种策略(比如说信息增益)来选择1个属性作为该节点的分裂属性。

3. 决策树形成过程中每个节点都要按照步骤2来分裂(很容易理解,如果下一次该节点选出来的那一个属性是刚刚其父节点分裂时用过的属性,则该节点已经达到了叶子节点,无须继续分裂了)。一直到不能够再分裂为止。注意整个决策树形成过程中没有进行剪枝。

4. 按照步骤1~3建立大量的决策树,这样就构成了随机森林了。

随机化有助于减少决策树之间的相关性,从而改善组合分类器的泛化误差。

让每一颗数完全的增长不进行剪枝,这可能有助于减少结果数的偏移。

可以使用多数表决权来组合预测结果。

随机森林的准确性可以与Adaboost相媲美,而且要比Adaboost的运行速度快。

四 互信息

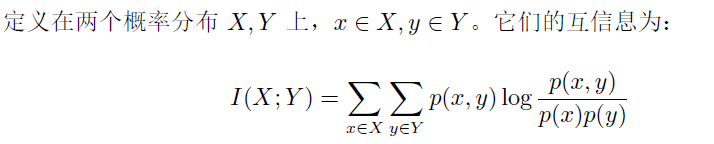

互信息,Mutual Information,缩写为MI,表示两个变量X与Y是否有关系,以及关系的强弱。

直观上,互信息度量 X 和 Y 共享的信息:它度量知道这两个变量其中一个,对另一个不确定度减少的程度。例如,如果 X 和 Y 相互独立,则知道 X 不对 Y 提供任何信息,反之亦然,所以它们的互信息为零。在另一个极端,如果 X 是 Y 的一个确定性函数,且 Y 也是 X 的一个确定性函数,那么传递的所有信息被 X 和 Y 共享:知道 X 决定 Y 的值,反之亦然。因此,在此情形互信息与 Y(或 X)单独包含的不确定度相同,称作 Y(或 X)的熵。而且,这个互信息与 X 的熵和 Y 的熵相同。(这种情形的一个非常特殊的情况是当 X 和 Y 为相同随机变量时。)

互信息是 X 和 Y 联合分布相对于假定 X 和 Y 独立情况下的联合分布之间的内在依赖性。于是互信息以下面方式度量依赖性:I(X; Y) = 0 当且仅当 X 和 Y 为独立随机变量。

此外,互信息是非负的(即 I(X;Y) ≥ 0; 见下文),而且是对称的(即 I(X;Y) = I(Y;X))

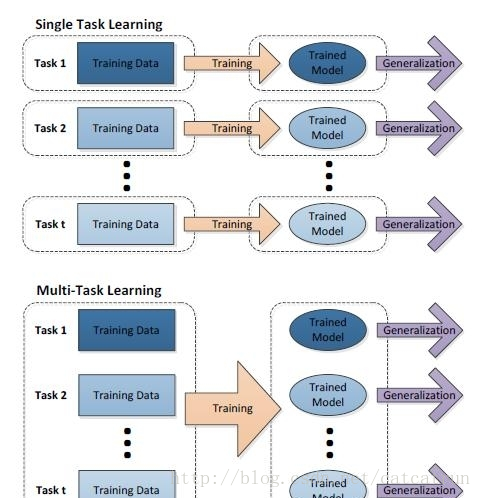

五 多任务学习

多任务学习(Multitask Learning)是一种推导迁移学习方法,主任务(main tasks)使用相关任务(related tasks)的训练信号(training signal)所拥有的领域相关信息(domain-specific information),做为一直推导偏差(inductive bias)来提升主任务(main tasks)泛化效果(generalization performance)的一种机器学习方法。多任务学习涉及多个相关的任务同时并行学习,梯度同时反向传播,多个任务通过底层的共享表示(shared representation)来互相帮助学习,提升泛化效果。简单来说:多任务学习把多个相关的任务放在一起学习(注意,一定要是相关的任务,后面会给出相关任务(related tasks)的定义,以及他们共享了那些信息),学习过程(training)中通过一个在浅层的共享(shared representation)表示来互相分享、互相补充学习到的领域相关的信息(domain information),互相促进学习,提升泛化的效果。

(1) 多人相关任务放在一起学习,有相关的部分,但也有不相关的部分。当学习一个任务(Main task)时,与该任务不相关的部分,在学习过程中相当于是噪声,因此,引入噪声可以提高学习的泛化(generalization)效果。

(2) 单任务学习时,梯度的反向传播倾向于陷入局部极小值。多任务学习中不同任务的局部极小值处于不同的位置,通过相互作用,可以帮助隐含层逃离局部极小值。

(3) 添加的任务可以改变权值更新的动态特性,可能使网络更适合多任务学习。比如,多任务并行学习,提升了浅层共享层(shared representation)的学习速率,可能,较大的学习速率提升了学习效果。

(4) 多个任务在浅层共享表示,可能削弱了网络的能力,降低网络过拟合,提升了泛化效果。

六 计算数据混乱度的方式

1 熵

2 方差

首先计算数据的均值,然后捐每条数据到均值的差值,为了对正负差值同等看待,一般使用绝对值或平方替代,方差是平方误差的均值(均方差)。

七 关联规则

关联规则:用于表示数据内隐含的关联性,例如:购买尿布的人往往会购买啤酒。

支持度(support)

支持度:{X, Y}同时出现的概率,例如:{尿布,啤酒}同时出现的概率

support=同时购买{X,Y}的人数/总人数

{尿布,啤酒}的支持度 = 800 / 10000 = 0.08

{尿布,面包}的支持度 = 100 / 10000 = 0.01

注意:{尿布,啤酒}的支持度等于{啤酒,尿布}的支持度,支持度没有先后顺序之分

置信度(confidence)

置信度:购买X的人,同时购买Y的概率,例如:购买尿布的人,同时购买啤酒的概率,而这个概率就是购买尿布时购买啤酒的置信度

confidence(X−>Y)=同时购买{X,Y}的人数/购买X的人数

confidence(Y−>X)=同时购买{X,Y}的人数/购买Y的人数

( 尿布 -> 啤酒 ) 的置信度 = 800 / 1000 = 0.8

( 啤酒 -> 尿布 ) 的置信度 = 800 / 2000 = 0.4

八 时间序列分析模型——ARIMA模型

什么是截尾和拖尾?

(1)p阶自回归模型 AR(P)

AR(p)模型的偏自相关函数PACF在p阶之后应为零,称其具有截尾性;

AR(p)模型的自相关函数ACF不能在某一步之后为零(截尾),而是按指数衰减(或成正弦波形式),称其具有拖尾性。

(2)q阶移动平均模型 MA(q)

MA(q)模型的自相关函数ACF在q阶之后应为零,称其具有截尾性;

MA(q)模型的偏自相关函数PACF不能在某一步之后为零(截尾),而是按指数衰减(或成正弦波形式),称其具有拖尾性。

如何判断拖尾和截尾?

(1)如果样本自相关系数(或偏自相关系数)在最初的d阶明显大于2倍标准差范围,而后几乎95%的样本自相关(偏自相关)系数都落在2倍标准差范围以内,而且由非零自相关(偏自相关)系数衰减为小值波动的过程非常突然,这时,通常视为自相关(偏自相关)系数截尾。

(2)如果有超过5%的样本相关系数落在2倍标准差范围以外,或者是由显著非零的相关函数衰减为小值波动的过程比较缓慢或者非常连续,这时,通常视为相关系数不截尾。

这张图可以看到,很明显的自相关和偏自相关都是拖尾,因为数据到后面还有增大的情况,没有明显的收敛趋势。

如果你的图片成这样,估计十有八九是一个ARMA模型了。自相关7阶拖尾(n从7开始缩至置信区间),偏自相关2阶拖尾。

自相关,偏自相关

https://blog.csdn.net/WMN7Q/article/details/70174300

侧重理论

https://www.cnblogs.com/babyfei/p/7001527.html

应用

http://www.cnblogs.com/taojake-ML/p/6400858.html

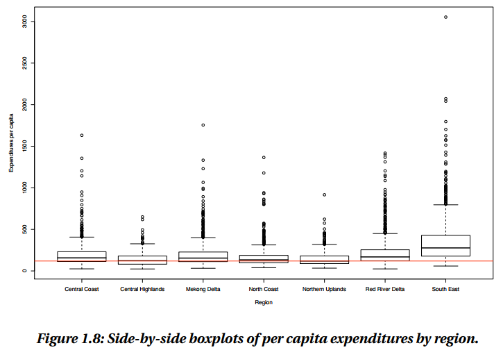

九 箱线图

箱线图(Box plot)也称箱须图(Box-whisker Plot)、箱线图、盒图,可以用来反映一组或多组连续型定量数据分布的中心位置和散布范围,因形状如箱子而得名。1977年,美国著名数学家John W. Tukey首先在他的著作《Exploratory Data Analysis》中介绍了箱形图。

图片来源:CHAPTER 1. EXPLORATORY DATA ANALYSIS

注:

连续型数据:在一定区间内可以任意取值的变量叫连续变量,其数值是连续不断的。例如,生产零件的规格尺寸,人体测量的身高、体重等,其数值只能用测量或计量的方法取得。可视化这类数据的图表主要有箱形图和直方图。

离散型数据:数值只能用自然数或整数单位计算的则为离散变量。例如,企业个数,职工人数,设备台数等,只能按计量单位数计数,数值一般用计数方法取得。大多数图表可视化的都是这类数据,比如柱状图、折线图等。

在箱线图中,箱子的中间有一条线,代表了数据的中位数。箱子的上下底,分别是数据的上四分位数(Q3)和下四分位数(Q1),这意味着箱体包含了50%的数据。因此,箱子的高度在一定程度上反映了数据的波动程度。上下边缘则代表了该组数据的最大值和最小值。有时候箱子外部会有一些点,可以理解为数据中的“异常值”。

由于箱线图不像柱状图、折线图那样简单常见,许多人都对它敬而远之。但只要我们搞清楚了以下几个统计学的基本概念,箱线图也可以变得“平易近人”。

01

四分位数

一组数据按照从小到大顺序排列后,把该组数据四等分的数,称为四分位数。第一四分位数 (Q1)、第二四分位数 (Q2,也叫“中位数”)和第三四分位数 (Q3)分别等于该样本中所有数值由小到大排列后第25%、第50%和第75%的数字。第三四分位数与第一四分位数的差距又称四分位距(interquartile range, IQR)。

02

偏态

与正态分布相对,指的是非对称分布的偏斜状态。在统计学上,众数和平均数之差可作为分配偏态的指标之一:如平均数大于众数,称为正偏态(或右偏态);相反,则称为负偏态(或左偏态)。

魔法箱子,会用才是王道

箱线图包含的元素虽然有点复杂,但也正因为如此,它拥有许多独特的功能:

01

直观明了地识别数据批中的异常值

箱形图可以用来观察数据整体的分布情况,利用中位数,25/%分位数,75/%分位数,上边界,下边界等统计量来来描述数据的整体分布情况。通过计算这些统计量,生成一个箱体图,箱体包含了大部分的正常数据,而在箱体上边界和下边界之外的,就是异常数据。

02

判断数据的偏态和尾重

对于标准正态分布的大样本,中位数位于上下四分位数的中央,箱形图的方盒关于中位线对称。中位数越偏离上下四分位数的中心位置,分布偏态性越强。异常值集中在较大值一侧,则分布呈现右偏态;异常值集中在较小值一侧,则分布呈现左偏态。

03

比较多批数据的形状

箱子的上下限,分别是数据的上四分位数和下四分位数。这意味着箱子包含了50%的数据。因此,箱子的宽度在一定程度上反映了数据的波动程度。箱体越扁说明数据越集中,端线(也就是“须”)越短也说明数据集中。

凭借着这些“独门绝技”,箱线图在使用场景上也很不一般,最常见的是用于质量管理、人事测评、探索性数据分析等统计分析活动。