“Datawhale x魔搭 AI夏令营”-AIGC方向-Day3从零入门AI生图原理&实践

学习内容提要

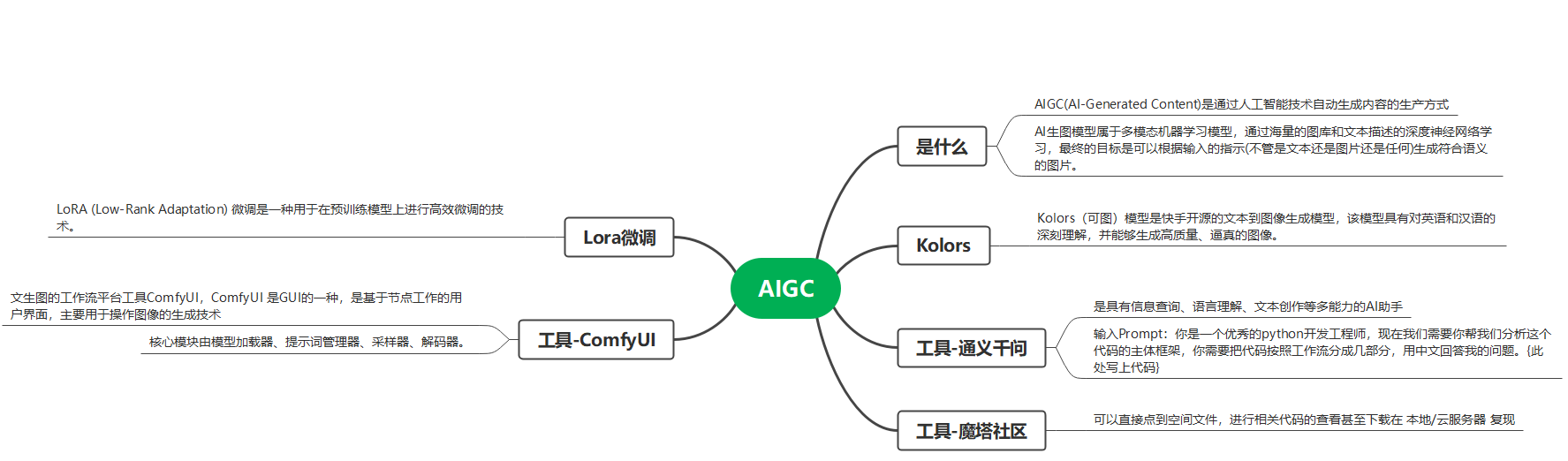

从通过代码实现AI文生图逐渐进阶,教程偏重图像工作流、微调、图像优化等思路,最后会简单介绍AIGC应用方向、数字人技术(选学)

Task03:进阶上分-实战优化

具体Datawhale教程学习内容见链接:https://linklearner.com/activity/14/10/37

框架

资源网站

| 名称 | 链接地址 |

| 在魔搭使用ComfyUI,玩转AIGC! | https://modelscope.cn/headlines/article/429 |

| ComfyUI的官方地址 | https://github.com/comfyanonymous/ComfyUI |

| ComfyUI官方示范 | https://comfyanonymous.github.io/ComfyUI_examples/ |

| 别人的基础工作流示范 | https://github.com/cubiq/ComfyUI_Workflows |

| https://github.com/wyrde/wyrde-comfyui-workflows | |

| 工作流分享网站 | https://comfyworkflows.com/ |

| 推荐一个比较好的comfyui的github仓库网站 | https://github.com/ZHO-ZHO-ZHO/ComfyUI-Workflows-ZHO?tab=readme-ov-file |

Lora 微调参数表

| 参数名称 | 参数值 | 说明 |

pretrained_unet_path |

models/kolors/Kolors/unet/diffusion_pytorch_model.safetensors | 指定预训练UNet模型的路径 |

pretrained_text_encoder_path |

models/kolors/Kolors/text_encoder | 指定预训练文本编码器的路径 |

pretrained_fp16_vae_path |

models/sdxl-vae-fp16-fix/diffusion_pytorch_model.safetensors | 指定预训练VAE模型的路径 |

lora_rank |

16 | 设置LoRA的秩(rank),影响模型的复杂度和性能 |

lora_alpha |

4 | 设置LoRA的alpha值,控制微调的强度 |

dataset_path |

data/lora_dataset_processed | 指定用于训练的数据集路径 |

output_path |

./models | 指定训练完成后保存模型的路径 |

max_epochs |

1 | 设置最大训练轮数为1 |

center_crop |

启用中心裁剪,用于图像预处理 | |

use_gradient_checkpointing |

启用梯度检查点,节省显存 | |

precision |

"16-mixed" | 设置训练时的精度为混合16位精度(half precision) |

数据集来源整理

以下渠道来源均需要考虑合规性问题,请大家在使用数据集过程中谨慎选择。

来源类型 | 推荐 |

公开的数据平台 | 魔搭社区内开放了近3000个数据集,涉及文本、图像、音频、视频和多模态等多种场景,左侧有标签栏帮助快速导览,大家可以看看有没有自己需要的数据集。 其他数据平台推荐:

|

使用API或爬虫获取 |

|

数据合成 | 利用现有的图形引擎(如Unity、Unreal Engine)或特定软件生成合成数据,这在训练某些类型的模型时非常有用。 最近Datawhale联合阿里云天池,做了一整套多模态大模型数据合成的学习,欢迎大家一起交流。 |

数据增强 | 对于较小的数据集,可以通过旋转、翻转、缩放、颜色变换等方式进行数据增强。 |

购买或定制 | 如果你的应用是特定领域的,比如医学影像、卫星图像等,建议从靠谱的渠道购买一些数据集。 |