zookeeper集群搭建

前言:本人通过mac m1搭建,使用虚拟机,jdk等环境均为arm架构

1,Zookeeper概述

1.1 简要

ZooKeeper是一个分布式的,开放源码的分布式应用程序协调服务,是Google的Chubby一个开源的实现,是Hadoop和Hbase的重要组件。它是一个为分布式应用提供一致性服务的软件,提供的功能包括:配置维护、域名服务、分布式同步、组服务等。 Zookeeper是一个分布式协调服务;就是为用户的分布式应用程序提供协调服务

| 序号 | 功能 |

|---|---|

| 1 | 为别的分布式程序服务的 |

| 2 | 本身就是一个分布式程序 |

| 3 | 主从协调 服务器节点动态上下线 统一配置管理 分布式共享锁 统一名称服务 |

| 4 | 管理(存储,读取)用户程序提交的数据 并为用户程序提供数据节点监听服务 |

1.2 Zookeeper的集群机制

Zookeeper是为其他分布式程序提供服务的,所以本身自己不能随便就挂了,所以zookeeper自身的集群机制就很重要。zookeeper的集群机制采用的是半数存活机制,也就是整个集群节点中有半数以上的节点存活,那么整个集群环境可用。这也就是说们的集群节点最好是奇数个节点。

Zookeeper集群节点的角色

Leader

Leader服务器是Zookeeper集群工作的核心,其主要工作如下

-

事务请求的唯一调度和处理者,保证集群事务处理的顺序性。

-

集群内部各服务器的调度者

Follower

Follower是Zookeeper集群的跟随者,其主要工作如下

-

处理客户端非事务性请求(读取数据),转发事务请求给Leader服务器。

-

参与事务请求Proposal的投票。

-

参与Leader选举投票。

Observer

Observer充当观察者角色,观察Zookeeper集群的最新状态变化并将这些状态同步过来,其对于非事务请求可以进行独立处理,对于事务请求,则会转发给Leader服务器进行处理。Observer不会参与任何形式的投票,包括事务请求Proposal的投票和Leader选举投票

2,集群环境准备

通过上面的介绍我们了解到zookeeper的集群环境应该配置奇数个节点,所以我们在本文中搭建的zookeeper环境准备在3个节点上搭建。接下来我们介绍下需要准备的环境。

2.1 准备3个节点

我这里以3个centos8的虚拟机节点为例,并且安装配置好JDK8,

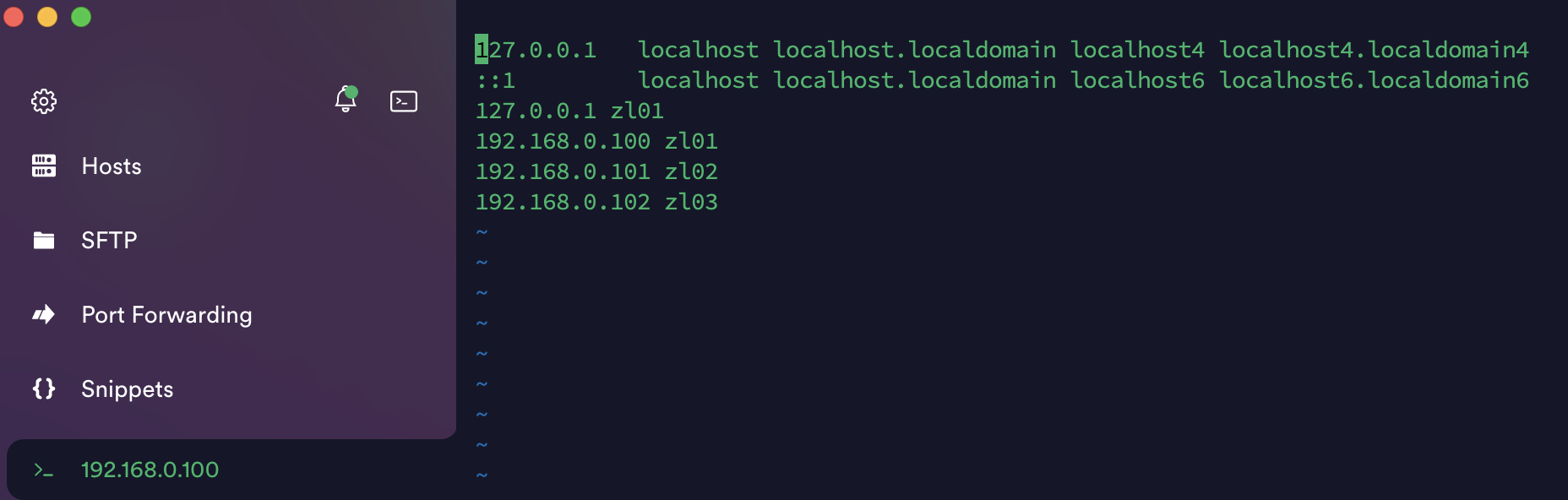

| ip | 主机名 |

|---|---|

| 192.168.0.100 | zl01 |

| 192.168.0.101 | zl02 |

| 192.168.0.102 | zl03 |

(创建好一个虚拟机后,通过VMware的克隆或者直接复制文件夹的方式来创建另外两个新的节点)

2.2 节点的映射关系

先修改主机名,vi hostname 分别为zl01,zl02,zl03

每个节点设置相应的ip和主机名的映射关系,方便集群环境的部署

修改hosts配置文件中的信息

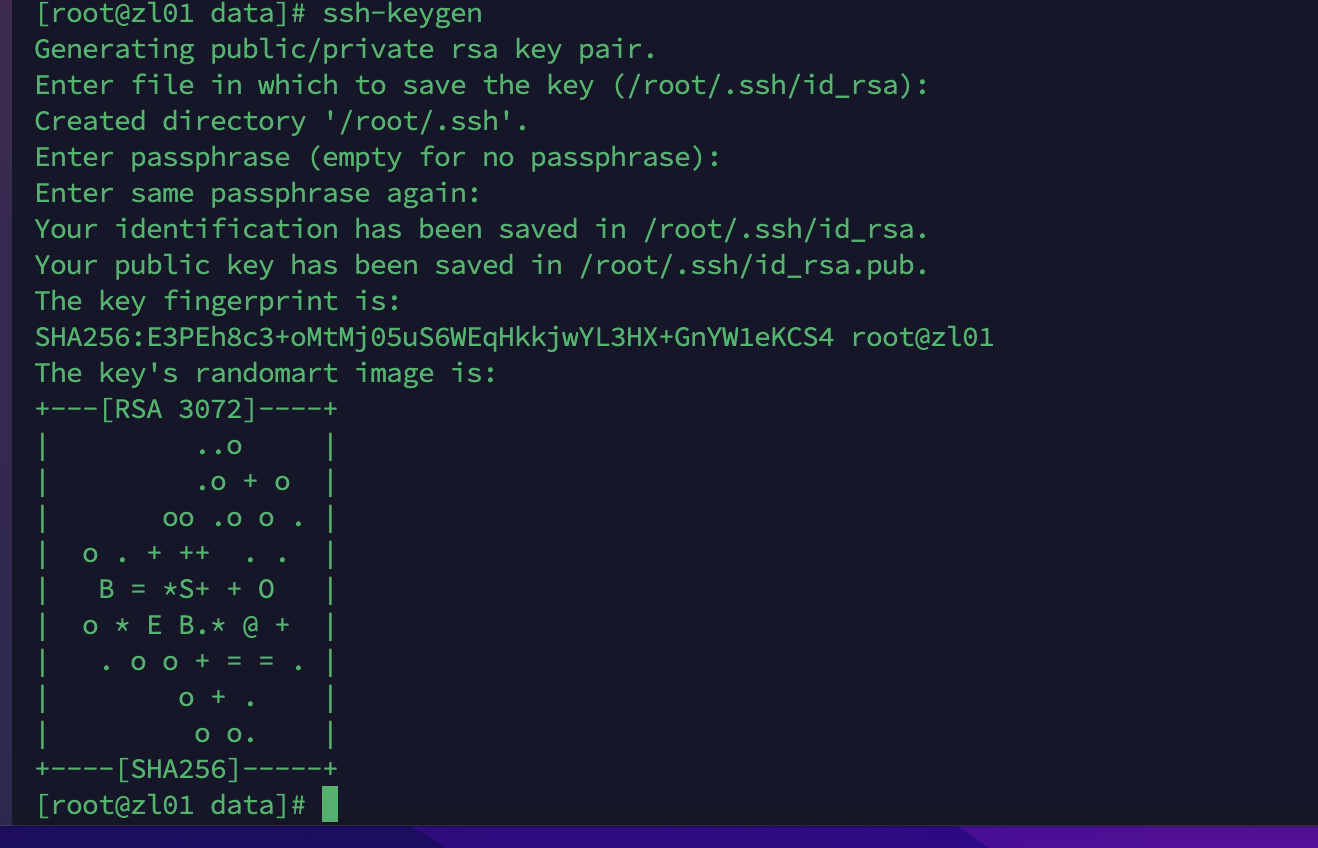

2.3 配置免密登录(一个节点配置好zookeeper后直接分发给其他节点)

生成公钥和私钥

ssh-keygen

输入命令后根据提示,四次回车即可

发送公钥给需要免密登录的节点

ssh-copy-id zl01

ssh-copy-id zl02

ssh-copy-id zl03

节点和节点发送文件通过scp命令实现(文件分发),一个节点配置好zookeeper后直接分发给其他节点

例子:scp -r b.txt zl01:/root/

sudo systemctl stop firewalld

3. Zookeeper集群环境搭建

3.1 获取安装文件

下载地址:https://mirrors.bfsu.edu.cn/apache/zookeeper/

通过wget命令将安装文件下载到opt目录下

注意:

apache-zookeeper-3.5.9-bin.tar.gz和apache-zookeeper-3.5.9.tar.gz的区别 -bin是编译后的文件 我们用这个

wget https://mirrors.bfsu.edu.cn/apache/zookeeper/zookeeper-3.5.9/apache-zookeeper-3.5.9-bin.tar.gz

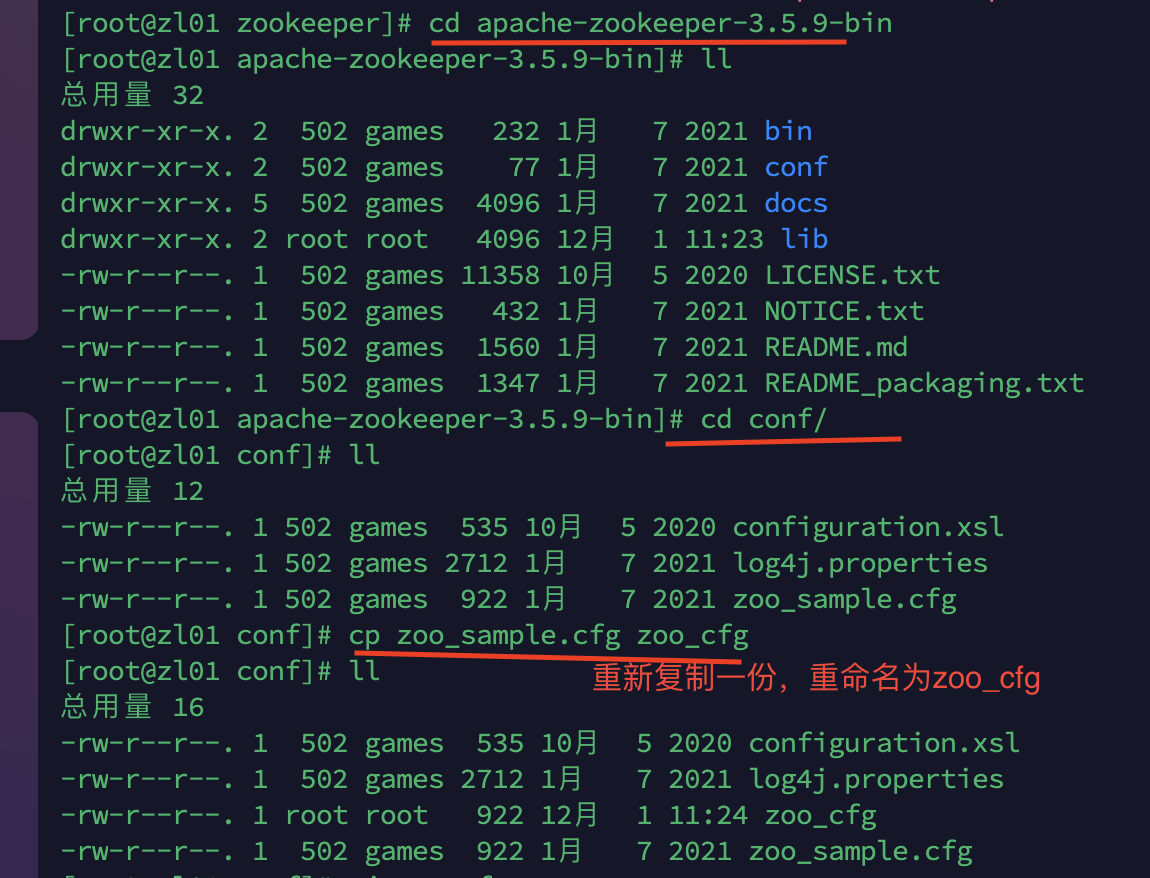

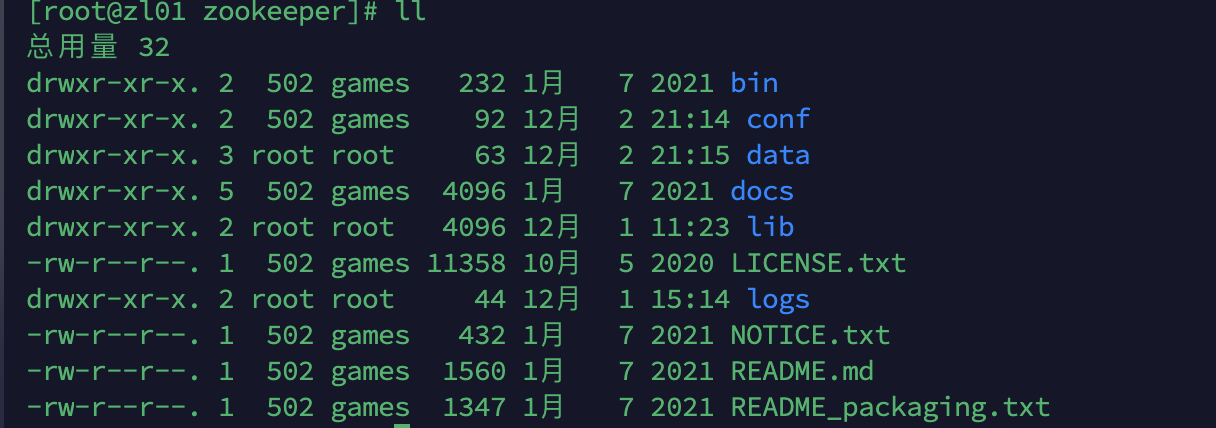

3.2 下载解压

进入目录,修改配置文件

将文件都移动到/opt/zookeeper文件夹下,并创建新的文件夹data

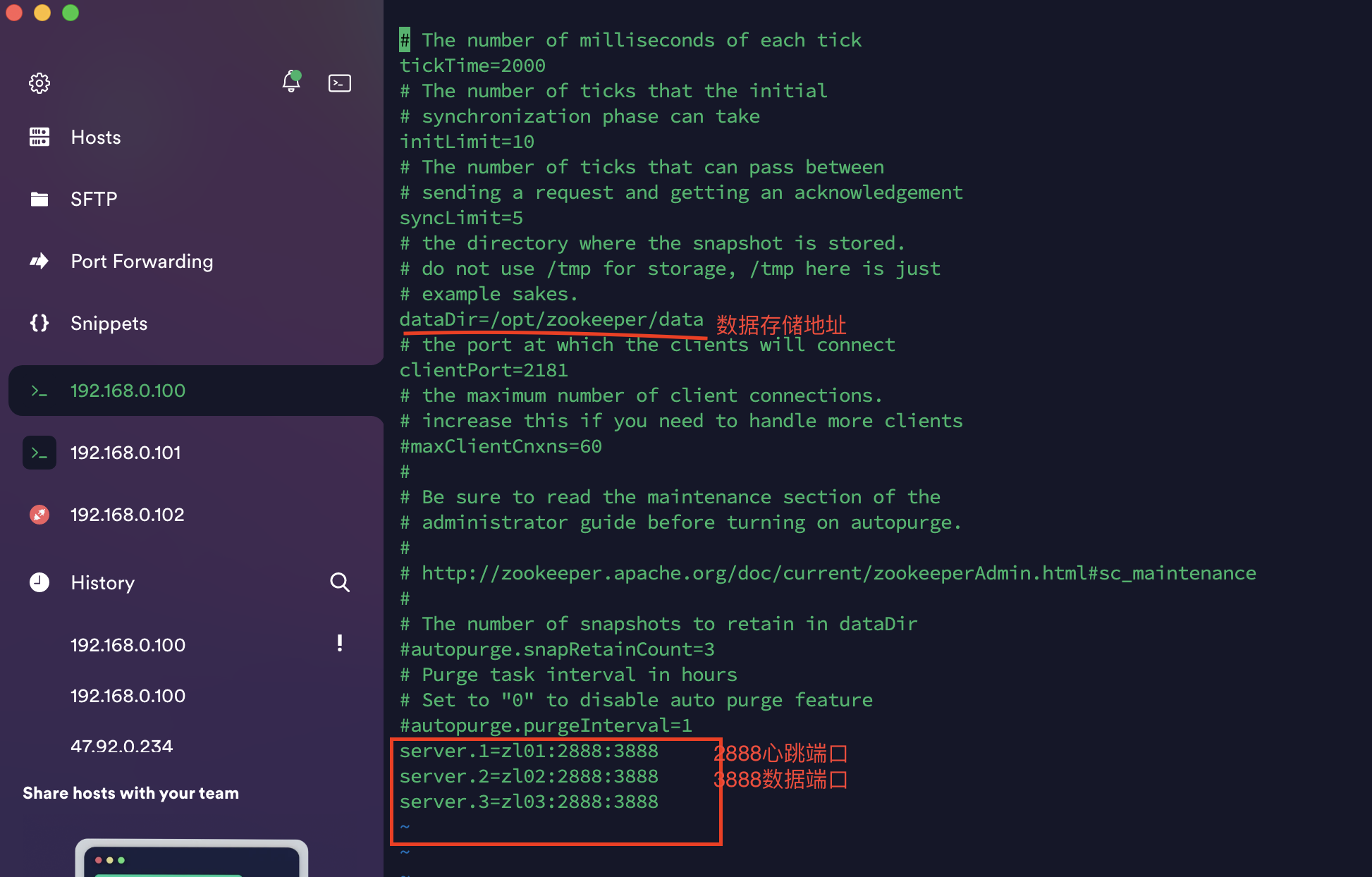

修改文件vi zoo_cfg

配置myid文件

我们需要在zookeeper的数据存储的目录中创建一个myid文件,文件中的内容只有一行信息,即表示我们集群几点的标识,范围是1-255,每个节点的myid的数字和我们在zoo.cfg中配置的server.数字是对应的

在data文件夹下新增文件myid

echo > 1 myid

分发文件

scp -r apache-zookeeper-3.5.9-bin zl02:`pwd`

scp -r apache-zookeeper-3.5.9-bin zl03:`pwd`

分发成功后我们需要修改各个节点中的myid的信息为配置文件中对应的数字

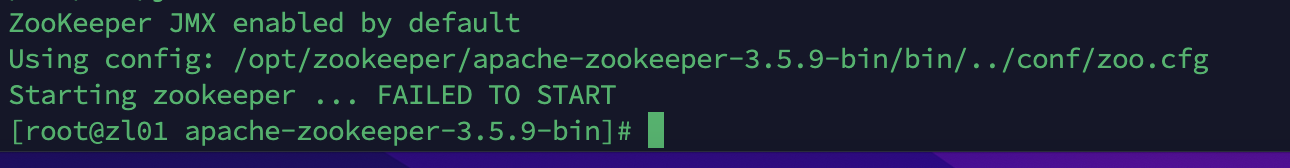

启动测试

整个集群环境都配置好了之后我们就可以测试启动了

启动命令

./bin/zkServer.sh start

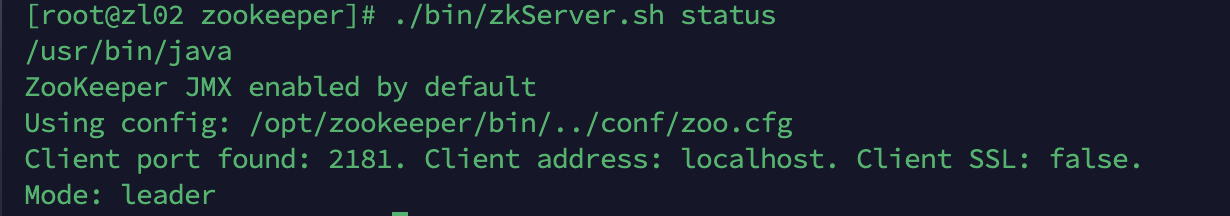

当我们仅仅启动一个节点的时候,因为半数存活机制,3个节点只启动一个节点是没有效果的

当我们启动第二个节点后发现集群环境可以使用了

注意:如果启动不成功,将三台机器对应zoo.cfg文件修改一下

192.168.0.100的zoo.cfg(部分配置):

server.1=0.0.0.0:2888:3888

server.2=zl02:2888:3888

server.3=zl03:2888:3888

192.168.0.101的zoo.cfg(部分配置):

server.1=zl01:2888:3888

server.2=0.0.0.0:2888:3888

server.3=zl03:2888:3888

192.168.0.102的zoo.cfg(部分配置):

server.1=zl01:2888:3888

server.2=zl02:2888:3888

server.3=0.0.0.0:2888:3888

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

2020-12-02 个人服务器(阿里云)搭建svn