模型可解释大纲

模型的性能虽然很重要,但是知道我们的模型为什么做出这样或那样的预测也非常重要。为什么模型会预测对?为什么模型会预测错?

说到模型可解释,就和算法其本身的原理相关的,因此可解释模型的框架基本可以从几个角度入手

可自解释模型

基于样例(Example-based)

局部可解释方法(Local Model-Agnostic Methods)

局部可解释方法从 单个样本级别(individual)的角度去理解我们的模型。大部分此类方法的操作都是通过微小的改变模型的输入来看模型所做出的预测变化。这里的local指的是训练好的模型本身。

所以这种解释方法的结论直接来源于你改变输入之后,模型对每个样本所做出的回应。

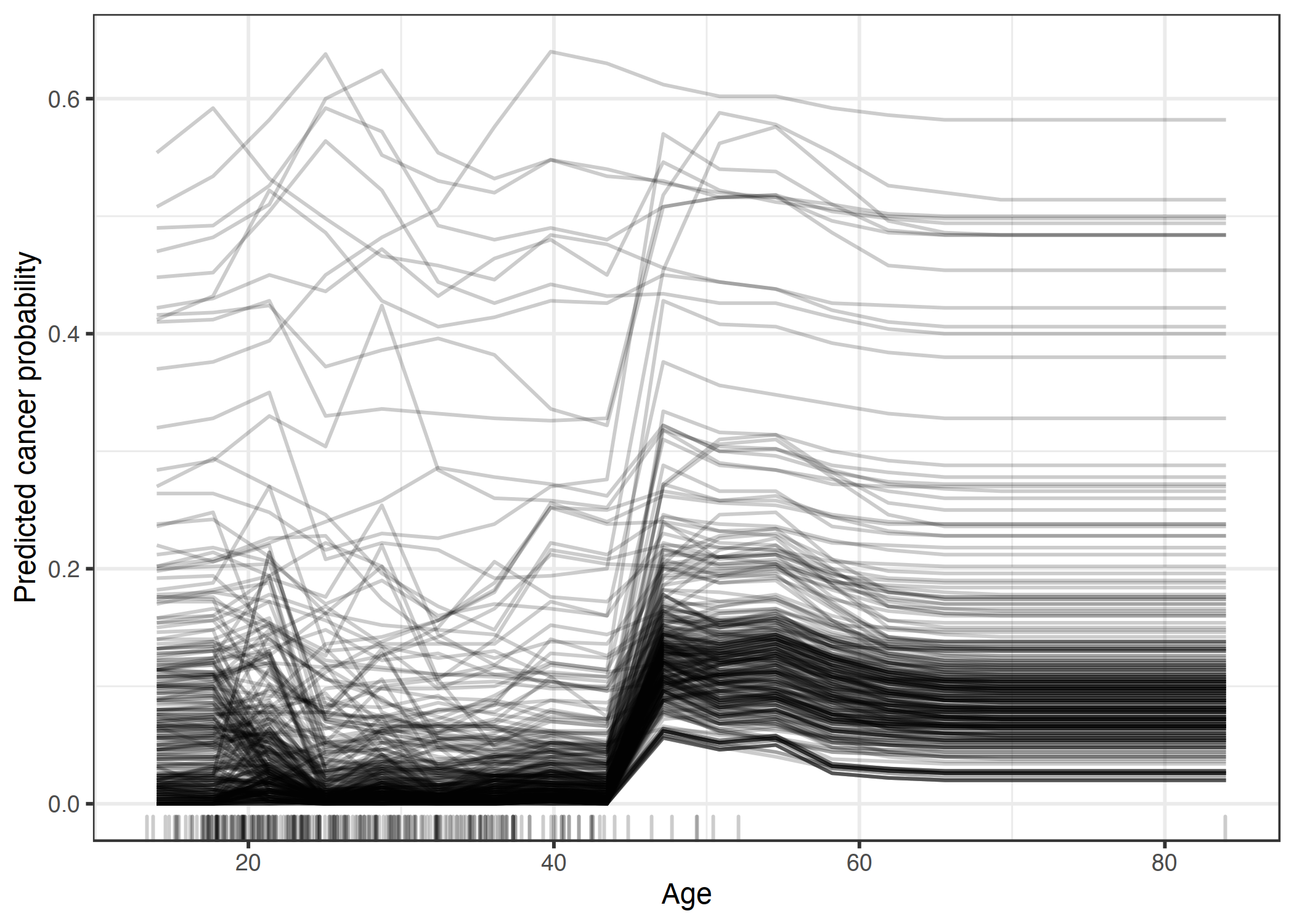

个体条件期望曲线(Individual conditional expectation curves, ICE)

这种可解释方式其实是展示一系列的曲线,每条曲线表示一个样本,代表着你的特征取值变化的时候,模型的预测值会做何种变化

Local Surrogate (LIME)

Scoped rules

Counterfactual explanations(反事实解释)

Shapley values和Shap

全局可解释方法

与局部可解释方法不同,全局可解释相对来说站在更高的角度去解释模型,这种方法是去解释模型的一种行为模式,比如:决策树的决策规则。

部分依赖图PDF

参考文献

Interpretable Machine Learning-Christoph Molnar

Model Agnostic Supervised Local Explanatio