马尔科夫模型

马尔科夫模型(Markov Model) 是一种用于描述系统状态转移的概率模型,广泛应用于统计学、机器学习、自然语言处理、物理学等领域。它的核心假设是:未来的状态仅依赖于当前状态,而与过去的历史状态无关,这个假设被称为“马尔科夫性”或“无记忆性”。

1. 马尔科夫过程

马尔科夫模型基于一个叫做“马尔科夫过程”(Markov Process)的概念,通常表示为一个状态空间及其状态间的转移概率。假设系统的状态空间为 S={s1,s2,…,sn},从一个状态到另一个状态的转移由一个转移概率矩阵来描述。

如果当前系统在状态 st,那么下一个时刻 st+1 的状态的概率仅与当前的状态 st有关,而与之前的历史状态无关。

2. 马尔科夫链(Markov Chain)

当马尔科夫过程的状态空间是离散的,并且每一步转移是从一个状态到另一个状态时,这样的过程叫做“马尔科夫链”。马尔科夫链可以用一个转移概率矩阵来表示,其中矩阵的每个元素 Pij表示从状态 si 转移到状态 sj 的概率。

3. 转移概率矩阵

转移概率矩阵 P 是一个 n×n的矩阵,其中 Pij表示从状态 si 转移到状态 sj 的概率,满足:

0≤Pij≤1

每行的元素和为 1,即 ∑jPij=1

例如,假设有三个状态 s1,s2,s3,则转移概率矩阵可能是:

这表示:

- 从状态 s1 转移到 s1 的概率是 0.1,从 s1 转移到 s2 的概率是 0.6,从 s1 转移到 s3 的概率是 0.3。

- 从状态 s2 转移到 s1 的概率是 0.4,依此类推。

4. 马尔科夫决策过程(MDP)

当马尔科夫链引入了控制和奖励机制时,形成了一个马尔科夫决策过程(MDP)。MDP 是强化学习中的基础,主要包括以下元素:

- 状态空间 S

- 动作空间 A

- 状态转移概率 P(s′∣s,a),表示在状态 s 下采取动作 a 后,转移到状态 s′ 的概率。

- 奖励函数 R(s,a),表示在状态 s 下采取动作 a 后得到的奖励。

- 折扣因子 γ,表示未来奖励的重要性。

5. 应用领域

- 自然语言处理:例如在词序列的建模、语音识别、隐马尔科夫模型(HMM)等方面有广泛应用。

- 金融建模:股票市场预测、资产价格变化等。

- 图像处理:用于图像分割、物体跟踪等。

- 生物信息学:基因序列的分析、蛋白质折叠预测等。

问题场景

假设你有一个天气预报系统,今天的天气可以是 晴天(Sunny) 或 雨天(Rainy)。根据历史数据,有以下转移概率:

- 如果今天是晴天,明天是晴天的概率是 0.8,雨天的概率是 0.2。

- 如果今天是雨天,明天是晴天的概率是 0.4,雨天的概率是 0.6。

用马尔科夫模型,我们可以预测未来某一天的天气。

符号定义

- 状态集合 S={Sunny,Rainy}

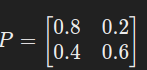

- 转移矩阵 P:

行表示当前状态(晴天、雨天),列表示下一状态。

示例计算

假设今天是晴天(概率为 1,即初始状态向量为 [1,0]),我们想知道明天和后天的天气分布。

第一天

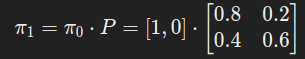

- 初始状态向量 π0=[1,0](表示今天晴天的概率为 1)。

- 用转移矩阵计算明天的状态分布:

计算:

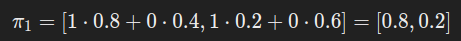

计算:

-

结果:明天晴天的概率是 0.8,雨天的概率是 0.2。

第二天

从 π1=[0.8,0.2] 继续计算后天的状态分布:

计算:π2=[0.8⋅0.8+0.2⋅0.4,0.8⋅0.2+0.2⋅0.6]=[0.64+0.08,0.16+0.12]=[0.72,0.28]

结果:后天晴天的概率是 0.72,雨天的概率是 0.28。

本文来自博客园,作者:z_s_s,转载请注明原文链接:https://www.cnblogs.com/zhoushusheng/p/18574926

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 震惊!C++程序真的从main开始吗?99%的程序员都答错了

· 【硬核科普】Trae如何「偷看」你的代码?零基础破解AI编程运行原理

· 单元测试从入门到精通

· 上周热点回顾(3.3-3.9)

· winform 绘制太阳,地球,月球 运作规律