人工智能之机器学习基础——逻辑回归

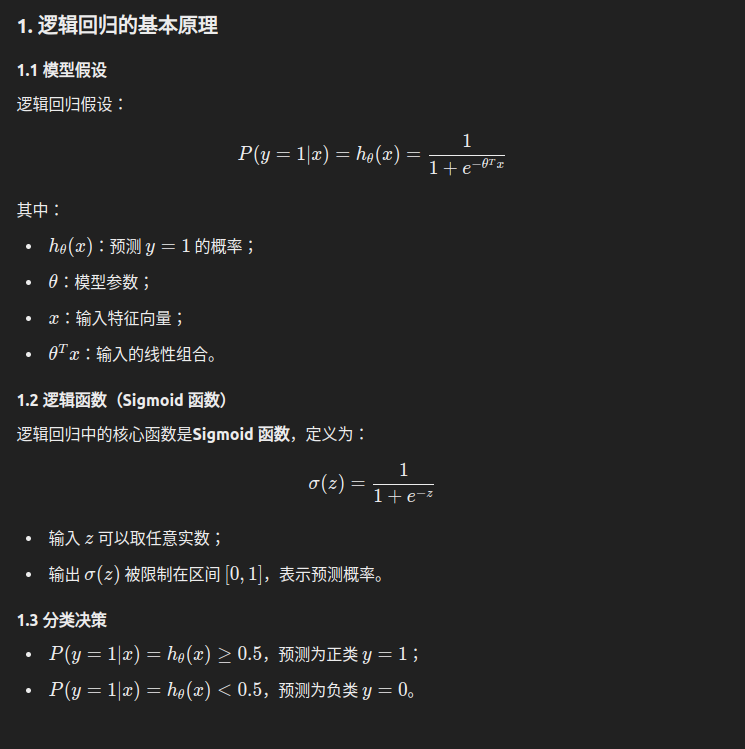

逻辑回归是一种广泛应用的分类模型,尽管名字中有“回归”一词,但它主要用于解决分类问题。逻辑回归模型的核心思想是通过使用一个逻辑函数(Sigmoid 函数)将线性回归的输出映射到概率值 [0,1],从而完成分类任务。

有个叫交叉熵损失函数实际上是负对数似然函数(Negative Log-Likelihood, NLL)的一种形式,具体来说,它是逻辑回归模型的似然函数取对数并加负号后得到的。

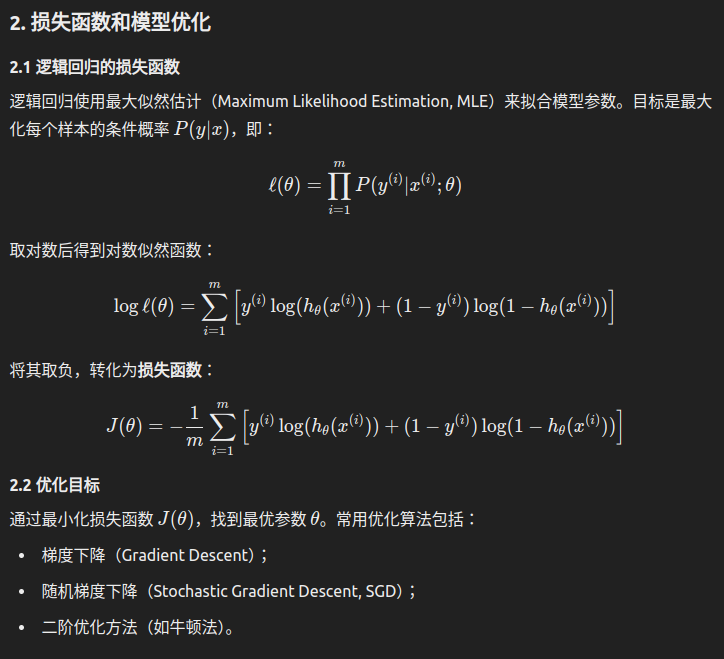

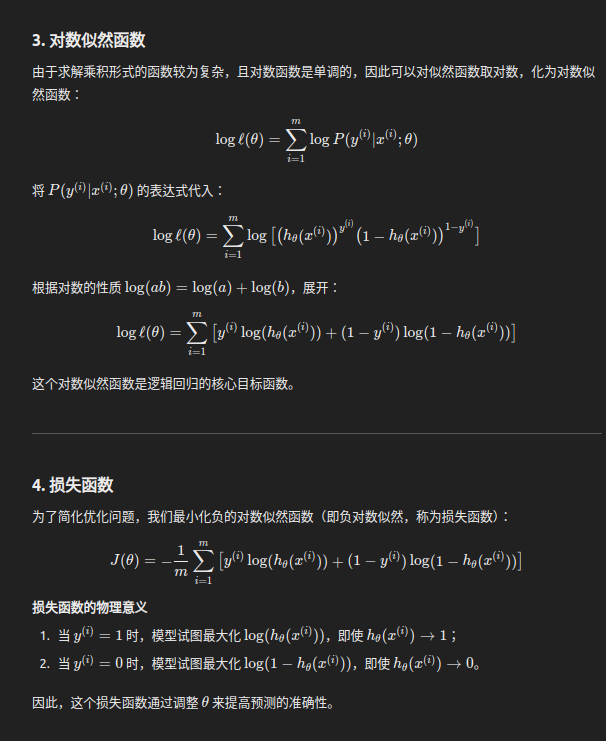

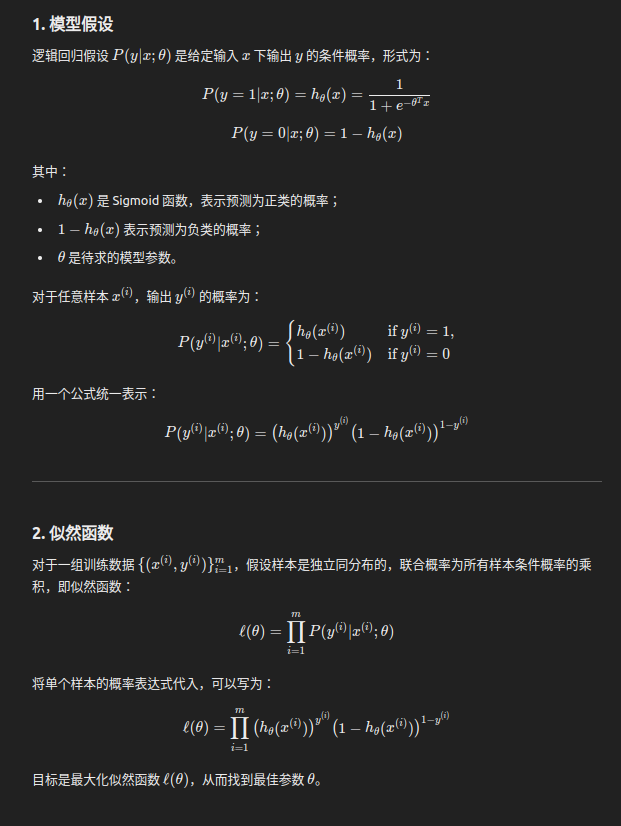

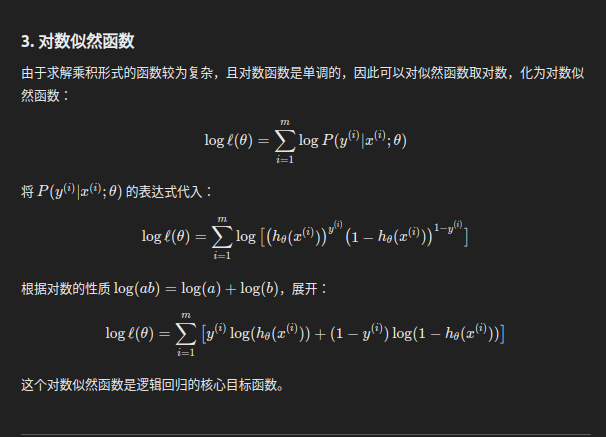

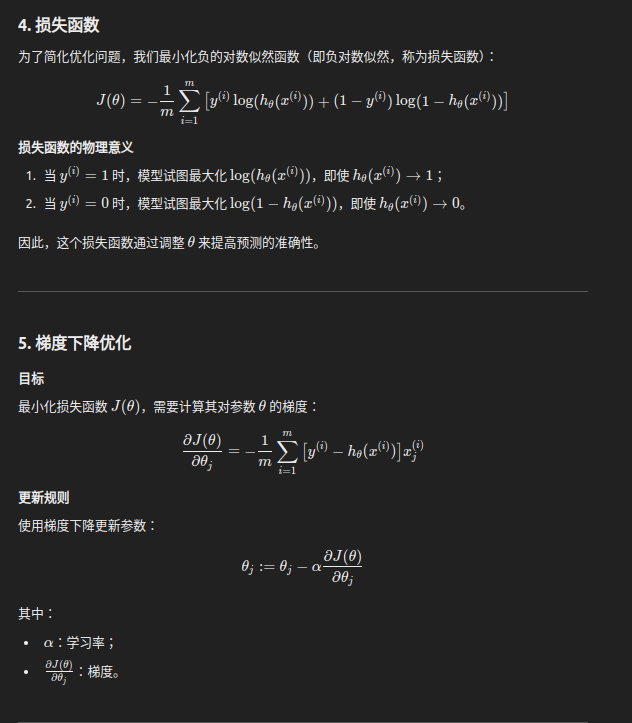

让我们详细推导逻辑回归的最大似然估计过程,包括如何从似然函数推导到对数似然函数,以及最终的损失函数。

- 似然函数:最大化所有样本的条件概率;

- 对数似然函数:对似然函数取对数,转化为加法形式;

- 损失函数:最小化负对数似然;

逻辑回归通过最大化对数似然估计找到最优参数,并使用梯度下降等优化方法进行训练。

3. 逻辑回归的特点

3.1 优点

- 简单易解释:输出概率值,便于理解模型预测。

- 高效:在特征数量和样本数量较小时,训练和预测都很快。

- 适合线性可分数据:对于线性可分的数据,效果良好。

- 概率预测:模型输出的是概率,可以灵活调整决策阈值。

3.2 缺点

- 线性假设:模型只能拟合线性决策边界,复杂关系需要非线性扩展。

- 易受异常值影响:特征未标准化或存在异常值时,模型性能可能下降。

- 维数灾难:当特征数量过多时,模型性能可能受限。

4. 逻辑回归的扩展

4.1 正则化

- 为防止过拟合,可以在损失函数中加入正则化项:

- L1 正则化:稀疏解;

- L2 正则化:防止模型参数过大,增加泛化能力。

4.2 多分类逻辑回归

- 一对多(One-vs-Rest):将多分类问题拆解为多个二分类问题。

- Softmax 回归:扩展 Sigmoid 函数,用于直接预测多分类概率。

5. 逻辑回归的应用

逻辑回归被广泛用于二分类问题,常见应用场景包括:

- 医学诊断:根据病人的体征预测是否患病;

- 金融风控:评估贷款用户的违约概率;

- 广告点击率预测:预测用户是否会点击广告;

- 信用卡欺诈检测:识别是否存在异常交易行为;

- 分类问题:如垃圾邮件过滤。

本文来自博客园,作者:z_s_s,转载请注明原文链接:https://www.cnblogs.com/zhoushusheng/p/18553430

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 阿里最新开源QwQ-32B,效果媲美deepseek-r1满血版,部署成本又又又降低了!

· 开源Multi-agent AI智能体框架aevatar.ai,欢迎大家贡献代码

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· AI技术革命,工作效率10个最佳AI工具