开发PySpark 所需准备环境

1) 安装python环境

安装python有两种方式:原生安装、Ancona安装

以上安装路径中不能有中文,不能有空格

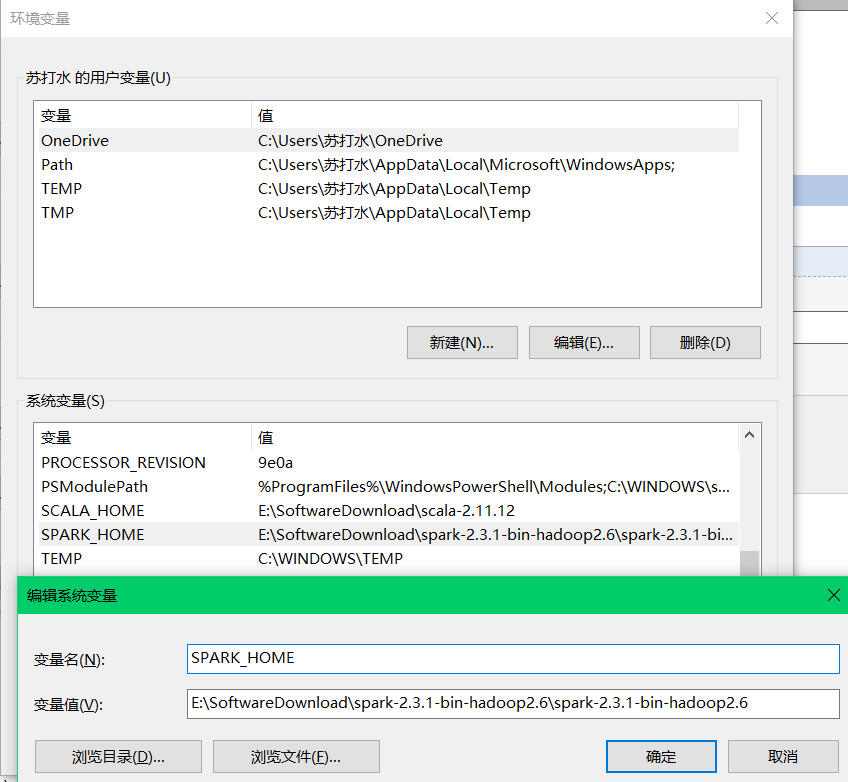

2) window中必须配置SPARK_HOME

3) 在python中安装py4j模块

两种安装方式:建议使用第二(2)种

(1)使用 pip install py4j

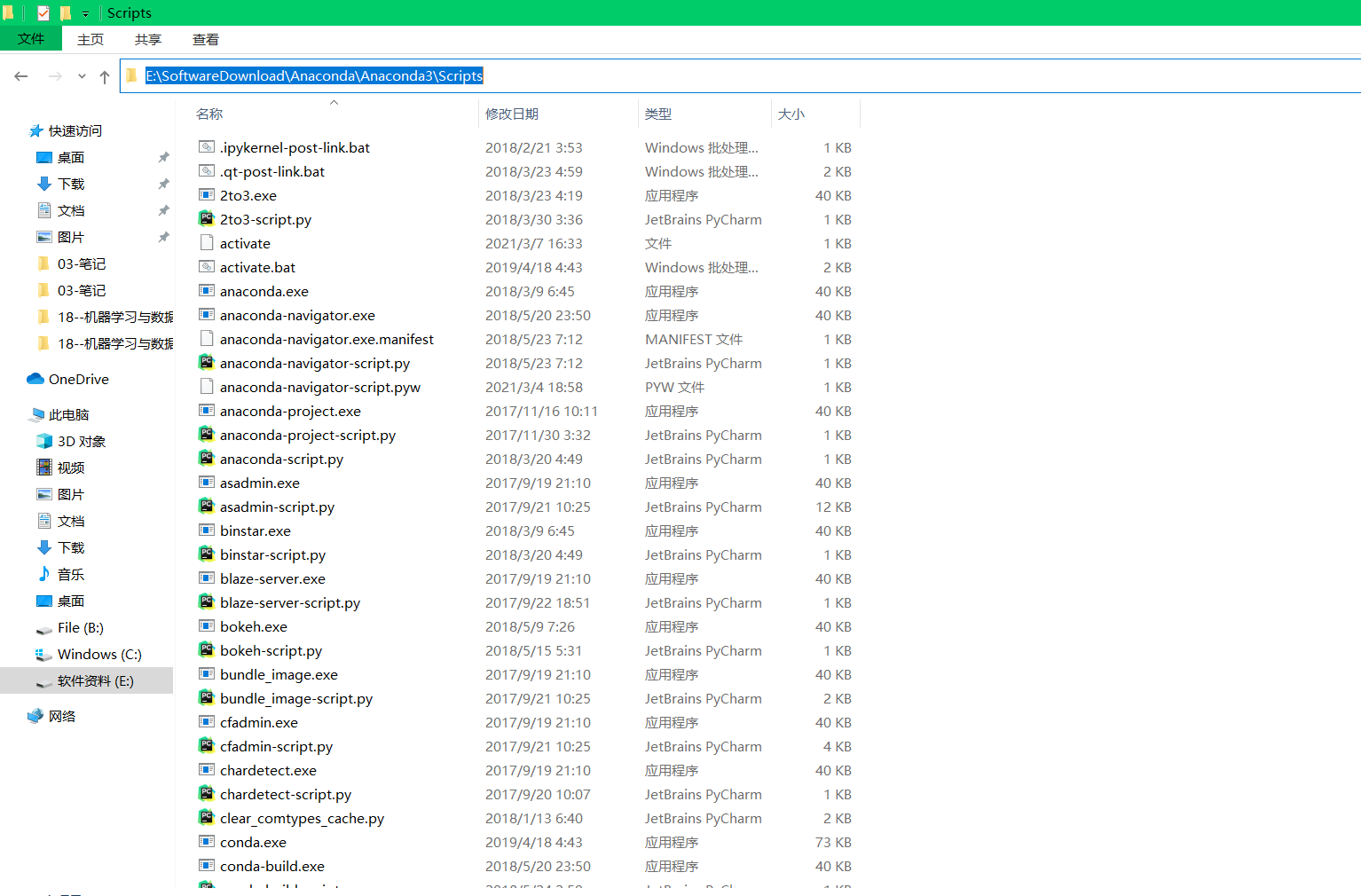

进入 Anaconda3的Scripts目录下,cmd

输入:pip install py4j

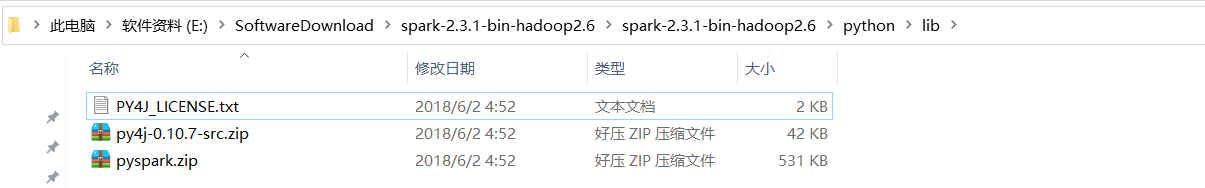

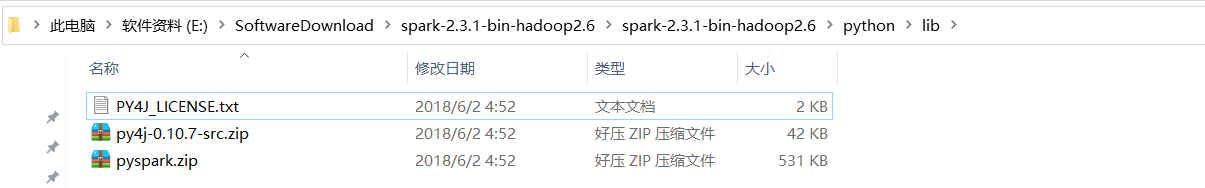

(2)找到spark-2.3.1-bin-hadoop2.6\python\lib目录

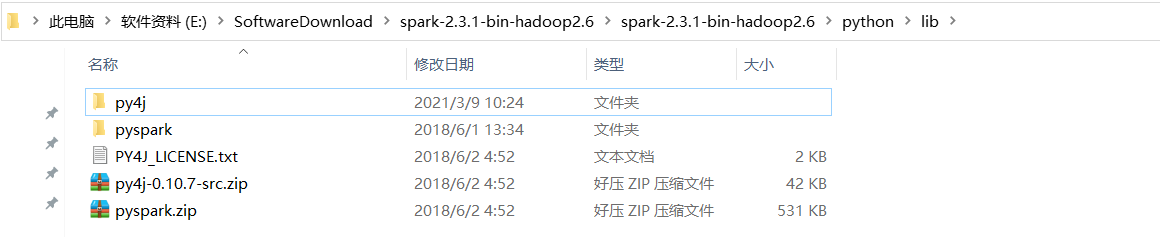

解压py4j-0.10.7-src.zip和pyspark.zip两个文件:

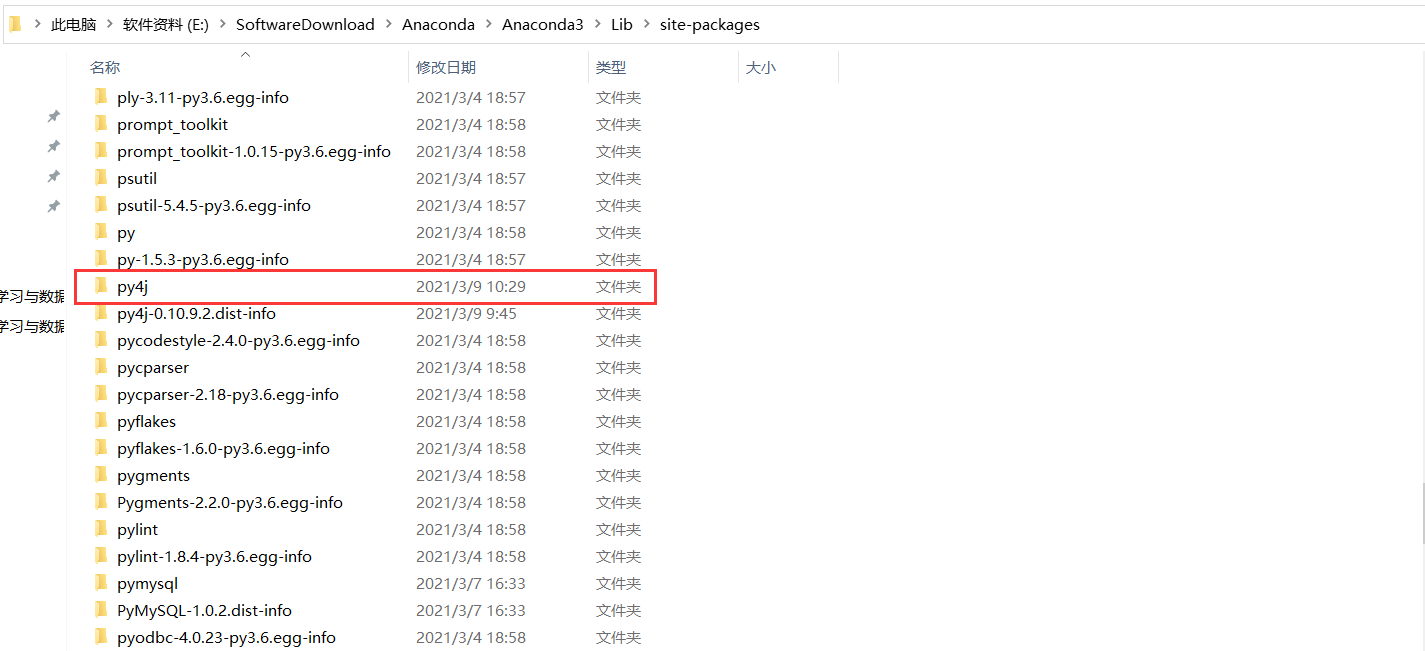

将py4j文件夹复制到Anaconda3\Lib\site-packages下:

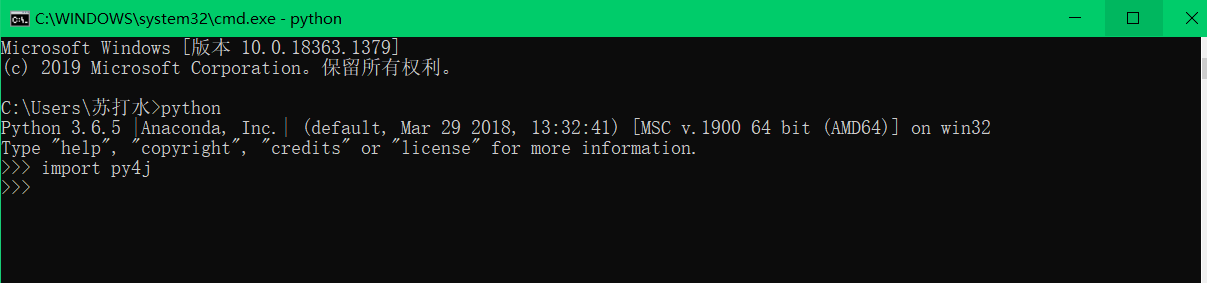

验证py4j是否安装成功:

只要不报错,说明py4j已经安装成功。

4) 在python中安装pyspark模块(pyspark提供了开发spark代码时所需的各种包)

两种安装方式:建议使用第(2)中

(1)使用 pip install py4j

(2)找到spark-2.3.1-bin-hadoop2.6\python\lib目录

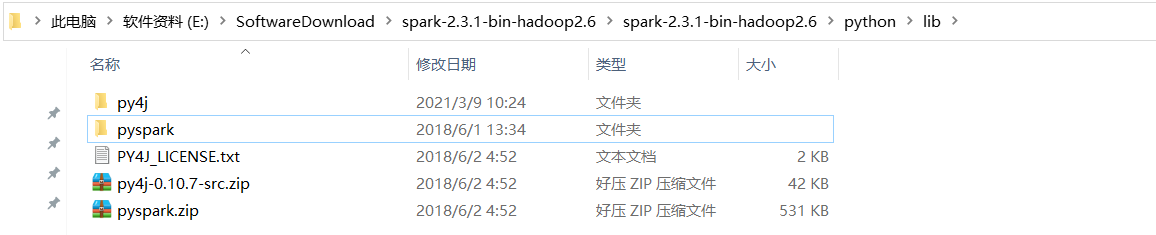

解压py4j-0.10.7-src.zip和pyspark.zip两个文件:

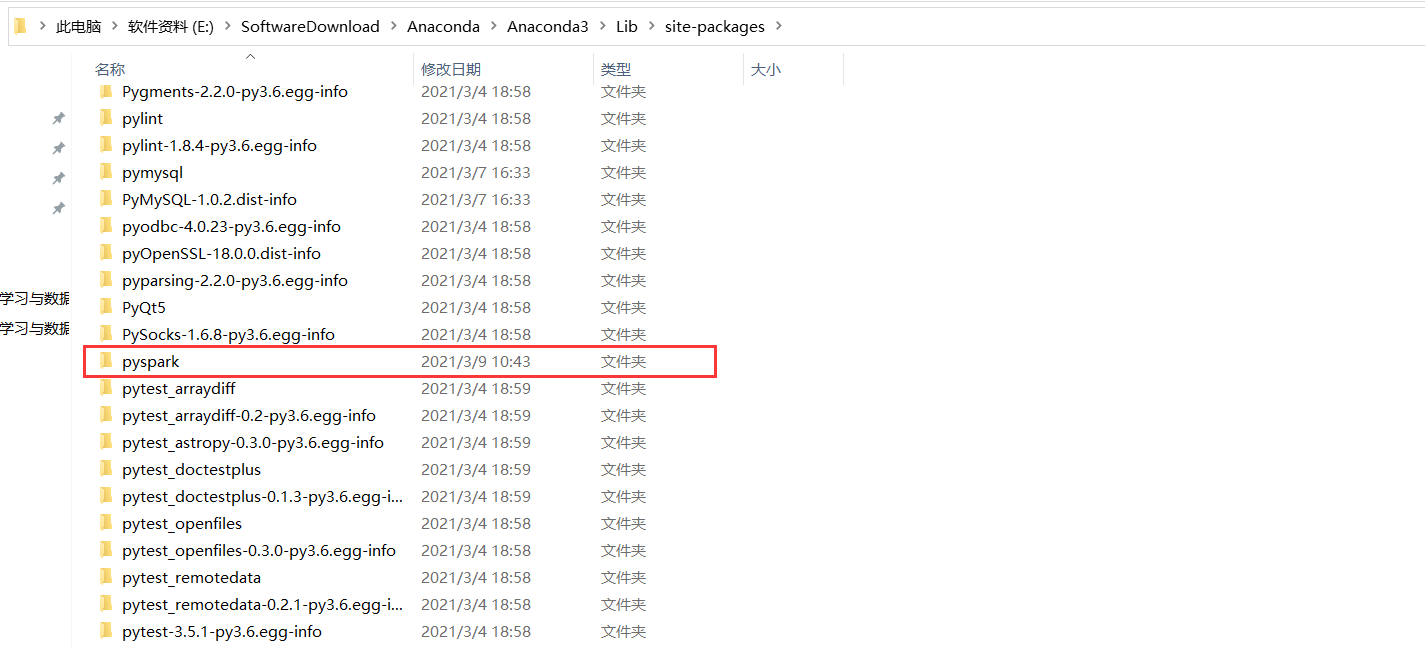

将pyspark文件夹复制到Anaconda3\Lib\site-packages下:

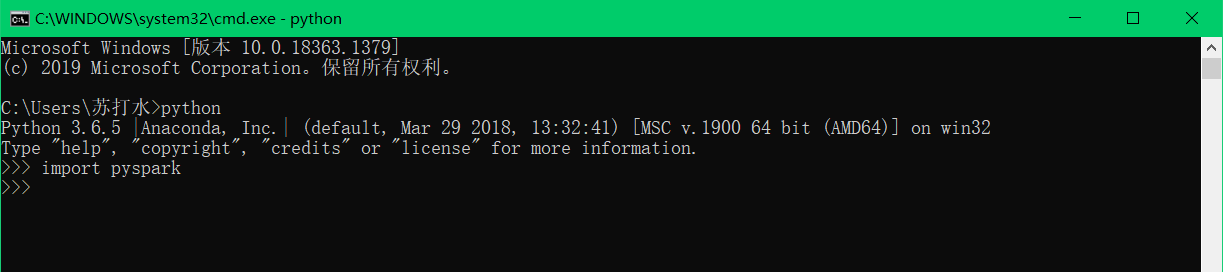

验证pyspark是否安装成功:

只要不报错,说明pyspark已经安装成功。

完成开发PySpark 所需准备环境这四个步骤之后,就可以开始下代码了。

注意:

★py4j是一个用 Python和Java编写的库。通过Py4J,Python程序能够动态访问Java虚拟机中的Java对象,Java程序也能够回调Python对象。

★pyspark 是 Spark 为 Python 开发者提供的 API