机器学习:10.分类与监督学习,朴素贝叶斯分类算法

1.理解分类与监督学习、聚类与无监督学习。

简述分类与聚类的联系与区别。

答:分类的意思大概就是根据数据集中已知的类别进行的分类;而聚类意思就是数据集中把未知的数据根据它们的相似性而进行聚类。

简述什么是监督学习与无监督学习。

答:监督学习:就是分类,通过已有的训练样本去训练得到一个最优模型,再利用这个模型将所有的输入映射为相应的输出,对输出进行简单的判断从而实现分类的目的,也就具有了对未知数据进行分类的能力。无监督学习:它与监督学习的不同之处,在于我们事先没有任何训练样本,而需要直接对数据进行建模。

2.朴素贝叶斯分类算法实例

利用关于心脏病患者的临床历史数据集,建立朴素贝叶斯心脏病分类模型。

有六个分类变量(分类因子):性别,年龄、KILLP评分、饮酒、吸烟、住院天数

目标分类变量疾病:

–心梗

–不稳定性心绞痛

新的实例:–(性别=‘男’,年龄<70, KILLP=‘1',饮酒=‘是’,吸烟≈‘是”,住院天数<7)

最可能 是哪个疾病?

上传手工演算过程。

|

|

性别 |

年龄 |

KILLP |

饮酒 |

吸烟 |

住院天数 |

疾病 |

|

1 |

男 |

>80 |

1 |

是 |

是 |

7-14 |

心梗 |

|

2 |

女 |

70-80 |

2 |

否 |

是 |

<7 |

心梗 |

|

3 |

女 |

70-81 |

1 |

否 |

否 |

<7 |

不稳定性心绞痛 |

|

4 |

女 |

<70 |

1 |

否 |

是 |

>14 |

心梗 |

|

5 |

男 |

70-80 |

2 |

是 |

是 |

7-14 |

心梗 |

|

6 |

女 |

>80 |

2 |

否 |

否 |

7-14 |

心梗 |

|

7 |

男 |

70-80 |

1 |

否 |

否 |

7-14 |

心梗 |

|

8 |

女 |

70-80 |

2 |

否 |

否 |

7-14 |

心梗 |

|

9 |

女 |

70-80 |

1 |

否 |

否 |

<7 |

心梗 |

|

10 |

男 |

<70 |

1 |

否 |

否 |

7-14 |

心梗 |

|

11 |

女 |

>80 |

3 |

否 |

是 |

<7 |

心梗 |

|

12 |

女 |

70-80 |

1 |

否 |

是 |

7-14 |

心梗 |

|

13 |

女 |

>80 |

3 |

否 |

是 |

7-14 |

不稳定性心绞痛 |

|

14 |

男 |

70-80 |

3 |

是 |

是 |

>14 |

不稳定性心绞痛 |

|

15 |

女 |

<70 |

3 |

否 |

否 |

<7 |

心梗 |

|

16 |

男 |

70-80 |

1 |

否 |

否 |

>14 |

心梗 |

|

17 |

男 |

<70 |

1 |

是 |

是 |

7-14 |

心梗 |

|

18 |

女 |

70-80 |

1 |

否 |

否 |

>14 |

心梗 |

|

19 |

男 |

70-80 |

2 |

否 |

否 |

7-14 |

心梗 |

|

20 |

女 |

<70 |

3 |

否 |

否 |

<7 |

不稳定性心绞痛 |

解:设x(x1!~x6)为人的特征,y(y1:心梗,y2:不稳定性心绞痛),则P(x)=0.4*0.25*0.5*0.2*0.45*0.3=0.00135

在已有的数据中患有心梗疾病的个数为y1:16,概率P(y1)为:80%;

在心梗的前提下是男性的个数为:7,概率P(y1|x1)为:43.7%。

在心梗的前提下是年龄<70的个数为:4,概率P(y1|x2)为:25%。

在心梗的前提下是KILLP=’1’的个数为:9,概率P(y1|x3)为:56.2%。

在心梗的前提下是饮酒=‘是’的个数为:2,概率P(y1|x4)为:18.7%。

在心梗的前提下是吸烟=‘是’的个数为:7,概率P(y1|x5)为:43.7%。

在心梗的前提下是住院天数<7的个数为:4,概率P(y1|x6)为:25%。

所以:

P(y1|x)=(p(x1|y1)p(x2|y1)p(x3|y1)p(x4|y1)p(x5|y1)p(x6|y1)p(y1))/P(x)

=(43.7%*25%*56.2%*18.7%*43.7%*25%*0.8)/0.00135

=0.0010034848/0.00135

≈74.3%

在已有的数据中患有不稳定性心绞痛疾病的个数为y2:2,概率P(y2)为:20%;

在不稳定性心绞痛的前提下是男性的个数为:1,概率P(y2|x1)为:25%。

在不稳定性心绞痛的前提下是年龄<70的个数为:1,概率P(y2|x2)为:25%。

在不稳定性心绞痛的前提下是KILLP=’1’的个数为:1,概率P(y2|x3)为:25%。

在不稳定性心绞痛的前提下是饮酒=‘是’的个数为:1,概率P(y2|x4)为:25%。

在不稳定性心绞痛的前提下是吸烟=‘是’的个数为:2,概率P(y2|x5)为:50%。

在不稳定性心绞痛的前提下是住院天数<7的个数为:2,概率P(y2|x6)为:50%。

所以:

P(y2|x)=(p(x1|y2)p(x2|y2)p(x3|y2)p(x4|y2)p(x5|y2)p(x6|y2)p(y2))/P(x)

=(25%*25%*25%*25%*50%*50%*20%)/0.00135

=0.0001953125/0.00135

≈14.5%

因为P(x1|y1)>P(x2|y2),所以患者为心梗疾病的概率大一些。

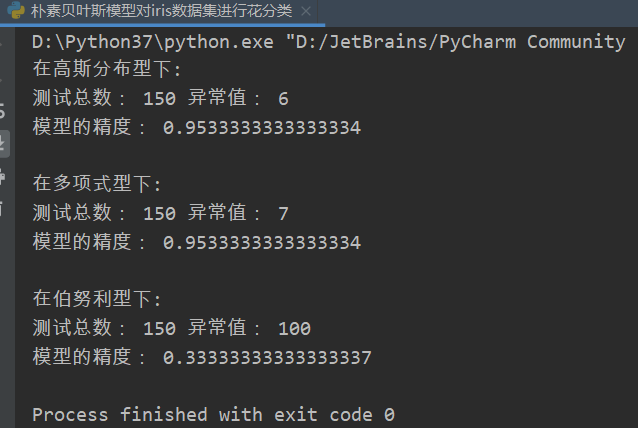

3.使用朴素贝叶斯模型对iris数据集进行花分类。

尝试使用3种不同类型的朴素贝叶斯:

- 高斯分布型

- 多项式型

- 伯努利型

并使用sklearn.model_selection.cross_val_score(),对各模型进行交叉验证。

from sklearn.datasets import load_iris from sklearn.naive_bayes import GaussianNB, MultinomialNB, BernoulliNB from sklearn.model_selection import cross_val_score # 引入库里的数据集 iris = load_iris() # 切割数据集 X = iris['data'] y = iris['target'] # 高斯分布型 GNB_model = GaussianNB() # 构建高斯分布模型 GNB_model.fit(X, y) # 训练模型 GNB_pre = GNB_model.predict(X) # 预测模型 print("在高斯分布型下:") print("测试总数:", X.shape[0], "异常值:", (y != GNB_pre).sum()) # 进行交叉验证 GNB_score = cross_val_score(GNB_model, X, y, cv=10) print('模型的精度:', GNB_score.mean()) # 多项式型 MNB_model = MultinomialNB() # 构建多项式模型 MNB_model.fit(X, y) # 训练模型 MNB_pre = MNB_model.predict(X) # 预测模型 print("\n在多项式型下:") print("测试总数:", X.shape[0], "异常值:", (y != MNB_pre).sum()) # 进行交叉验证 MNB_score = cross_val_score(MNB_model, X, y, cv=10) print('模型的精度:', MNB_score.mean()) # 伯努利型 BNB_model = BernoulliNB() # 构建伯努利模型 BNB_model.fit(X, y) # 训练模型 BNB_pre = BNB_model.predict(X) # 预测模型 print("\n在伯努利型下:") print("测试总数:", X.shape[0], "异常值:", (y != BNB_pre).sum()) # 进行交叉验证 BNB_score = cross_val_score(BNB_model, X, y, cv=10) print('模型的精度:', BNB_score.mean())

测试结果如下