Towards Life-Long Autonomy of Mobile Robots Through Feature-Based Change Detection

在许多工业和家庭环境中,自主移动机器人变得越来越重要。为了应对终生自治的最终目标,应对不可预见的情况是一个棘手的问题。在移动机器人上使用的基于计算机视觉的方法(例如本地化或导航)中,主要问题之一是场景的动态性。如果未检测和管理动态环境中常见的更改,则机器人的自主操作可能变得不可靠。移动椅子,打开和关闭门或窗户,更换桌子上的物体以及其他更改使许多传统方法都失败了。为了解决这个问题,我们提出了一种基于局部视觉特征相似性的变化检测新方法。该算法的核心思想是将场景的重要稳定区域与正在变化的区域区分开。为了评估变化检测算法,我们设计了一个基于特征匹配的简单视觉本地化框架,并进行了一系列实际的本地化实验。结果表明,与使用无变化检测的基线定位方法相比,变化检测方法大大提高了机器人定位的准确性。

核心:将场景的重要稳定区域与正在变化的区域区分开,本文的主要目的,似乎还是重定位,对于object没有维护,应该是这样

能应对场景里正在发生的变化吗。

在这项工作中,我们提出了一种基于局部特征描述符的变化检测新方法。机械手持续监视其环境并检测已发生的变化。在检测到更改后,机器人会更新其环境表示,以合并有关更改的信息。关键在于自动学习每个场景的持久区域,这些区域在很长一段时间内保持不变。

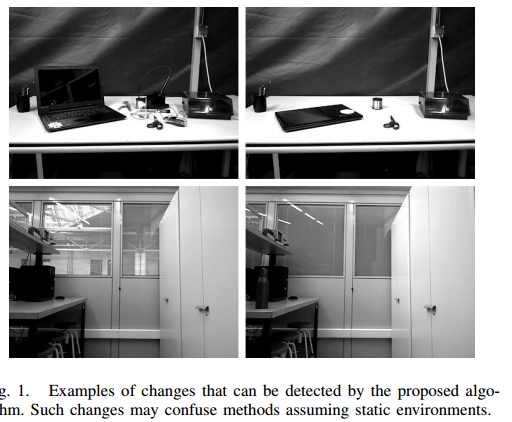

我们在工作中主要考虑的更改类型包括移动椅子和桌子上的物品,更改计算机或电视屏幕上的图片,更改白板和告示板的内容,打开或关闭门,调整窗户上的百叶窗等。这些变化每天都在各种工业,家庭和办公环境中发生。图1显示了此类更改的示例。(还挺丰富的。更改屏幕图像这种,很有必要,右边图里的变化不太看得懂

section2,相关文献

大多数变化检测算法基于长期运行中的对象检测和跟踪[2],[3],[4],[5]。在[2]中,机器人在室内环境中巡逻,并通过变化检测和时间推理来检测可移动物体。他们的目标是确定环境中有多少可移动物体并跟踪其位置。 Rao-Blackwellized粒子滤波器和期望最大化算法用于跟踪对象并学习环境动力学的参数。在[3]中,服务机器人部署在不同的室内环境中,并且通过将当前的物体检测结果与已映射的物体检测结果进行比较,维护了该环境的层次图,该图考虑了物体位置的变化。在[5]中,通过关于观察的推理来处理变化检测问题。根据长期特征,短期特征和动态特征对观测进行分类,分别对应于映射的静态对象,未映射的静态对象和未映射的动态对象。短期特征会产生对机器人轨迹信念的局部调整,而长期特征则会产生整体调整

其他作品直接检测机器人视图或图像之间的变化和对应关系[6],[7],[8],[9],[10],[11],[12]。完整的RGB-D视图在[6]中用于构建机器人世界的地图。计算连续视图之间的变化以发现对象(运动区域)并学习它们。类似地,在[8]中,保留了截断符号距离函数(TSDF)网格和环境的3D重建。新的观测值与以前的观测值一致,并包含在新的重建中。将新的重构与先前的重构进行比较,以识别两个重构之间的动态簇。图像视图在[9]中用于使用高斯混合模型(GMM)检测变化。由于GMM的计算时间很长,因此“垂直曲面法线直方图”提供了主平面区域,这些主平面区域在更改搜索中被丢弃。变化检测是通过为两个图像生成的高斯差来实现的。在[10]中将来自LiDAR的Pointclouds与基于八叉树的占用图进行比较,以获得一组变化。用Mahalanobis距离计算更改候选者并过滤以消除异常值。 [11]中的作者提出了基于2D LiDAR的框架,用于在以前的平面图上进行长期室内定位。该系统结合了基于图形的映射技术和贝叶斯过滤,以检测环境中的重大变化。他们使用基于ICP的扫描匹配来确定与轨迹姿态相关的LiDAR扫描对应于当前可观察环境的概率。该概率用于通过更新先前的节点来改善轨迹估计。在[12]中,提出了一种使用来自图像的二进制序列进行终身视觉定位的方法。假设使用图像序列而不是单个图像来识别位置的想法。使用全局LDP描述符提取特征以获得每个图像的二进制代码。通过计算汉明距离,可以有效地匹配这些二进制描述符。

对于室外环境,变化检测也得到了广泛的研究[13],[14],[15]。在[13]中从街景图像中检测结构变化。多传感器融合SLAM,深度反卷积网络和快速3D重建用于确定图像对之间的变化区域。在[14]中,提出了一种贝叶斯滤波器来对道路和交通要素的特征持久性进行建模。单特征和邻近特征信息用于检测基于特征的地图中的更改并估计特征持久性。为了克服室外环境导航的季节性变化,人们也做出了巨大的努力[16],[17],[18],[19]。在[16]中,HOG特征和深度卷积网络用于将新获取的图像与图像数据库进行比较和匹配,而不受天气和季节条件的影响。 [17]中提出的方法在捕获季节性变化的全景图像上基于外观的拓扑定位框架中比较了SIFT和SURF特征检测器的不同变体。

相关文献

challenge介绍:

[1] Robot planning in the real world: research challenges and opportunities

解决方案:

[2] Multiple object detection, tracking and long-term dynamics learning in large 3d maps

[3] Soma: A framework for understanding change in everyday environments using semantic object maps

[4] The strands project: Long-term autonomy in everyday environments

[5] Episodic non-markov localization: Reasoning about short-term and long-term features

Section3 视觉定位框架

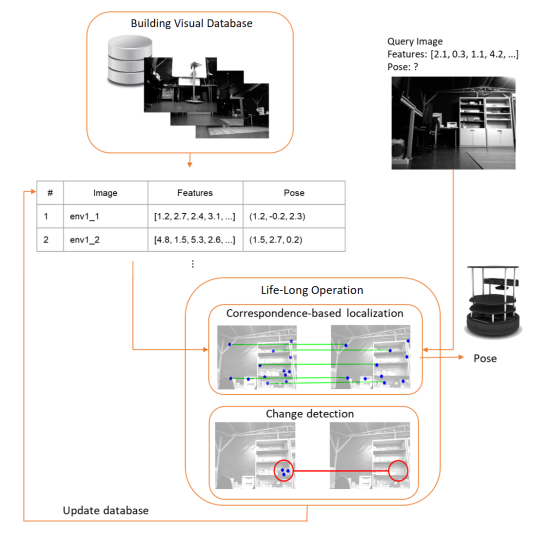

本文提出的变化检测方法可用于基于局部特征的各种算法的定位或位置检测。 在本节中,我们介绍一个简单的可视化本地化框架,该框架将用作基线,并将在以后使用建议的变更检测方法进行扩展。

首先,配备摄像头的机器人会以视觉数据库的形式构建环境的离散表示,其中图像与位置坐标一起存储。 请注意,需要使用在静态环境中具有自定位功能的机器人来构建地图(可视数据库)。 基于车轮编码器和激光测距仪读数的标准方法可以应用于执行此任务。(这段类似于slam的建图吧,但是并没有建图,只是把图像和位置bind在了一起)

framework如果是这张图的话,未免有些直接了,和我做的事情差不多了,只是匹配图片还是地图的区别

本文用了surf描述子,匹配的过程就是在数据库里找到一个描述子符合最多的图片

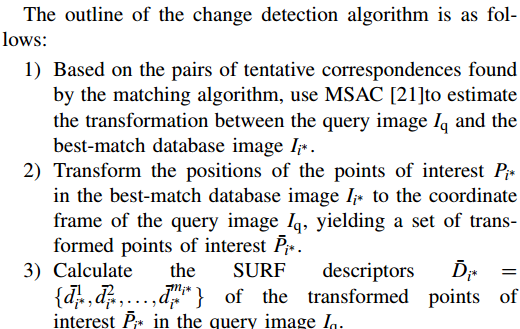

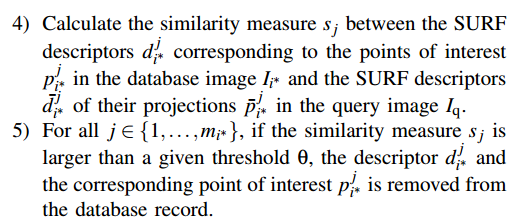

Section 4 变化检测方法

本文的方法确实很直接,通过描述子的图像匹配之后,找出位姿计算出位姿变换,然后比较对应点的描述子,如果变化过大,就

认为发生了变化,把它删除掉,剩下维护的,就是那些不会变的场景,把场景变单调了噢

设置了时间和空间相关性,来减少误匹配的可能性

空间相关性:最佳匹配图像和其它次佳匹配的一组图像,(k张图像),的距离不能离得太远

时间相关性:检查当前位置和先前位置之间的距离是否小于给定阈值d。它考虑了机器人的物理局限性,并在机器人似乎已移动得可能超出极限时放弃了不可靠的匹配。仅当当前和先前图像都满足空间条件时,才测试时间条件,这可以在定位失败后恢复。

总结一下的话,这篇论文的做法还是针对,提取不变的场景特征这一块,对于变化的,没有去关注

浙公网安备 33010602011771号

浙公网安备 33010602011771号