1.18

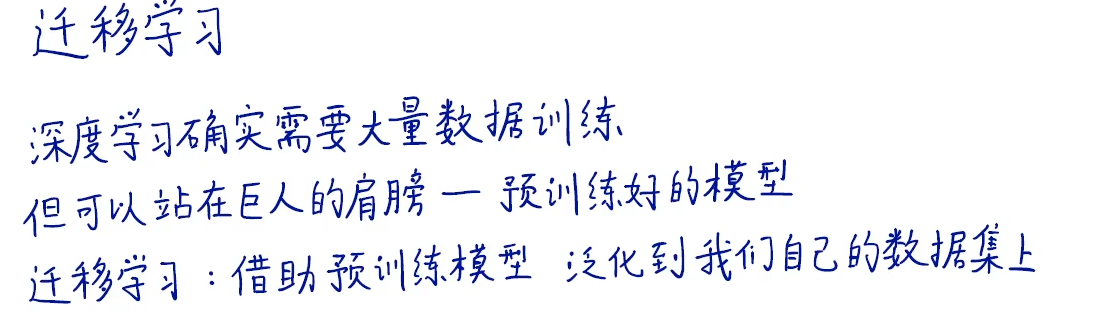

Lenet5奠定了最基础的卷积神经网络结构:卷积、池化、卷积、池化、全连接、全连接、输出

AlexNet使用了ReLU激活函数,可以有效地避免梯度消失,使用了数据增强(图片旋转、平移、遮挡等),使用了dropout(随机掐死部分神经元)

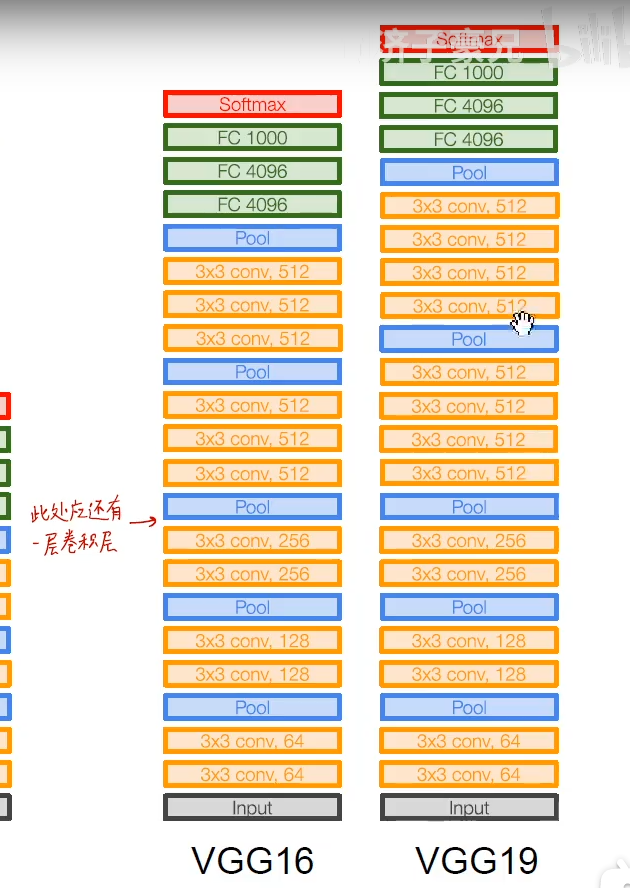

VGGnet主要就有VGG16和VGG19,VGG19比16多了几层

VGGnet就是用俩3x3的卷积代替5x5的卷积,仨3x3的卷积代替7x7的卷积,减少参数量,并加深神经网络

GoogLeNet使用了inception模块(用不同尺寸的卷积核进行卷积,生成同样长宽的featuremap(通过给尺寸大的卷积核加pad),这样让神经网络对图片中目标的大小普适),并且可以通过1x1的卷积核对图像进行降维,减少参数量,增加非线性表示能力

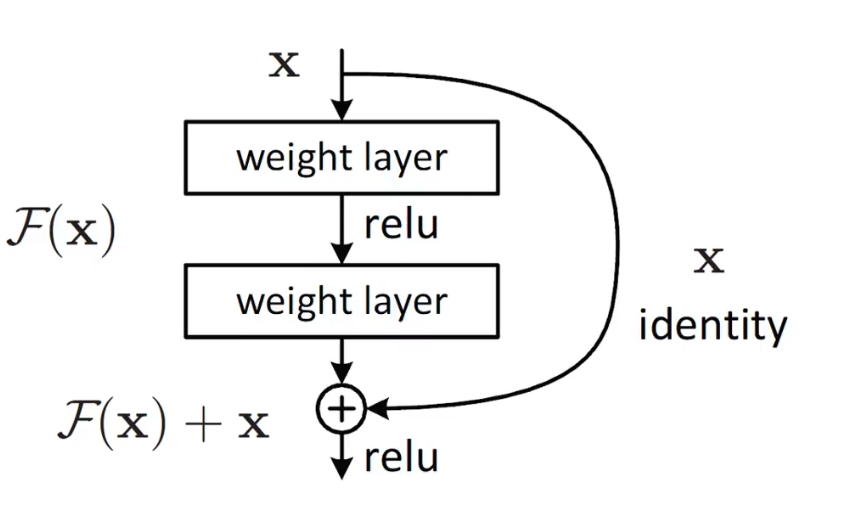

RseNet

可以防止梯度消失现象

可以防止梯度消失现象