08-模型加速之轻量化模型

当前的经典物体检测结构大都依赖使用卷积网络进行特征提取,即Backbone,在前面的章节中我们也详细介绍过如VGGNet、ResNet等优秀的基础网络。但很遗憾,这些网络往往计算量巨大,当前依靠这些基础网络的检测算法很难达到实时运行的要求,尤其是在ARM、FPGA及ASIC等计算力有限的移动端硬件平台。因此如何将物体检测算法加速到满足工业应用的要求,是一个亟待解决的问题。

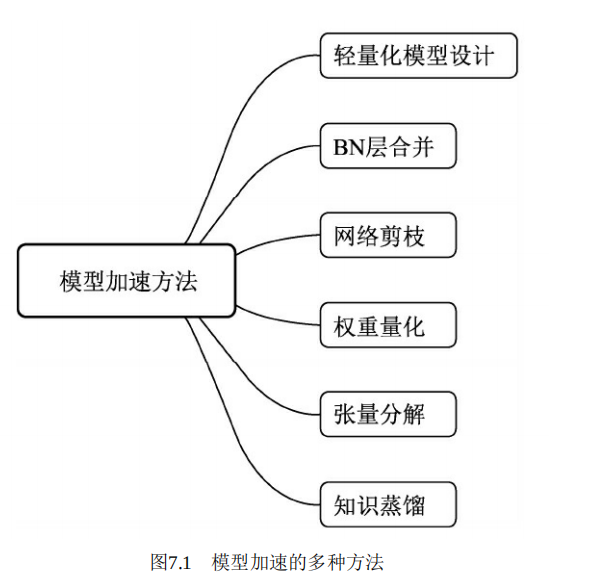

当前,实现模型加速的方法很多,如轻量化设计、BN层合并、剪枝与量化、张量分解、蒸馏与迁移学习等,这些方法相互之间并不独立,可以灵活地结合使用,如图7.1所示。

轻量化设计:从模型设计时就采用一些轻量化的思想,例如采用深度可分离卷积、分组卷积等轻量卷积方式,减少卷积过程的计算量。此外,利用全局池化来取代全连接层,利用1×1卷积实现特征的通道降维,也可以降低模型的计算量,这两点在众多网络中已经得到了应用。

BN层合并:在训练检测模型时,BN层可以有效加速收敛,并在一定程度上防止模型的过拟合,但在前向测试时,BN层的存在也增加了多余的计算量。由于测试时BN层的参数已经固定,因此可以在测试时将BN层的计算合并到卷积层,从而减少计算量,实现模型加速。

网络剪枝:在卷积网络成千上万的权重中,存在着大量接近于0的参数,这些属于冗余参数,去掉后模型也可以基本达到相同的表达能力,因此有众多学者以此为出发点,搜索网络中的冗余卷积核,将网络稀疏化,称之为网络剪枝。具体来讲,网络剪枝有训练中稀疏与训练后剪枝两种方法。

权重量化:是指将网络中高精度的参数量化为低精度的参数,从而加速计算的方法。高精度的模型参数拥有更大的动态变化范围,能够表达更丰富的参数空间,因此在训练中通常使用32位浮点数(单精度)作为网络参数的模型。训练完成后为了减小模型大小,通常可以将32位浮点数量化为16位浮点数的半精度,甚至是int8的整型、0与1的二值类型。典型方法如Deep Compression。

本章主要从网络的轻量化设计出发,依次介绍SqueezeNet、MobileNet及ShuffleNet等网络结构的思想与实现方法,为物体检测技术移动端的部署与应用提供更强有力的方法。