L01.linux技术-bond

一、bonding技术#

bonding(绑定)是一种linux系统下的网卡绑定技术,可以把服务器上n个物理网卡在系统内部抽象(绑定)成一个逻辑上的网卡,能够提升网络吞吐量、实现网络冗余、负载等功能,有很多优势。

bonding技术是linux系统内核层面实现的,它是一个内核模块(驱动)。使用它需要系统有这个模块, 我们可以modinfo命令查看下这个 模块的信息, 一般来说都支持.

[root@localhost shell]# modinfo bonding

filename: /lib/modules/3.10.0-862.el7.x86_64/kernel/drivers/net/bonding/bonding.ko.xz

author: Thomas Davis, tadavis@lbl.gov and many others

description: Ethernet Channel Bonding Driver, v3.7.1

version: 3.7.1

license: GPL

alias: rtnl-link-bond

retpoline: Y

rhelversion: 7.5

srcversion: C02EA747B46FAEE18023C4D

depends:

intree: Y

vermagic: 3.10.0-862.el7.x86_64 SMP mod_unload modversions

signer: CentOS Linux kernel signing key

sig_key: 3A:F3:CE:8A:74:69:6E:F1:BD:0F:37:E5:52:62:7B:71:09:E3:2B:96

sig_hashalgo: sha256

parm: max_bonds:Max number of bonded devices (int)

parm: tx_queues:Max number of transmit queues (default = 16) (int)

parm: num_grat_arp:Number of peer notifications to send on failover event (alias of num_unsol_na) (int)

parm: num_unsol_na:Number of peer notifications to send on failover event (alias of num_grat_arp) (int)

parm: miimon:Link check interval in milliseconds (int)

parm: updelay:Delay before considering link up, in milliseconds (int)

parm: downdelay:Delay before considering link down, in milliseconds (int)

parm: use_carrier:Use netif_carrier_ok (vs MII ioctls) in miimon; 0 for off, 1 for on (default) (int)

parm: mode:Mode of operation; 0 for balance-rr, 1 for active-backup, 2 for balance-xor, 3 for broadcast, 4 for 802.3ad, 5 for balance-tlb, 6 for balance-alb (charp)

parm: primary:Primary network device to use (charp)

parm: primary_reselect:Reselect primary slave once it comes up; 0 for always (default), 1 for only if speed of primary is better, 2 for only on active slave failure (charp)

parm: lacp_rate:LACPDU tx rate to request from 802.3ad partner; 0 for slow, 1 for fast (charp)

parm: ad_select:802.3ad aggregation selection logic; 0 for stable (default), 1 for bandwidth, 2 for count (charp)

parm: min_links:Minimum number of available links before turning on carrier (int)

parm: xmit_hash_policy:balance-xor and 802.3ad hashing method; 0 for layer 2 (default), 1 for layer 3+4, 2 for layer 2+3, 3 for encap layer 2+3, 4 for encap layer 3+4 (charp)

parm: arp_interval:arp interval in milliseconds (int)

parm: arp_ip_target:arp targets in n.n.n.n form (array of charp)

parm: arp_validate:validate src/dst of ARP probes; 0 for none (default), 1 for active, 2 for backup, 3 for all (charp)

parm: arp_all_targets:fail on any/all arp targets timeout; 0 for any (default), 1 for all (charp)

parm: fail_over_mac:For active-backup, do not set all slaves to the same MAC; 0 for none (default), 1 for active, 2 for follow (charp)

parm: all_slaves_active:Keep all frames received on an interface by setting active flag for all slaves; 0 for never (default), 1 for always. (int)

parm: resend_igmp:Number of IGMP membership reports to send on link failure (int)

parm: packets_per_slave:Packets to send per slave in balance-rr mode; 0 for a random slave, 1 packet per slave (default), >1 packets per slave. (int)

parm: lp_interval:The number of seconds between instances where the bonding driver sends learning packets to each slaves peer switch. The default is 1. (uint)

二、bonding的工作模式#

mode=0(balance-rr)#

表示负载分担round-robin,并且是轮询的方式,比如第一个包走eth0,第二个包走eth1,直到数据包发送完毕。

优点:可用带宽提高一倍

缺点:需要接入交换机做端口聚合,否则可能无法使用

交换机配置端口聚合参考:网络章节端口聚合配置

mode=1(active-backup)#

表示主备模式,即同一时间时只有1块网卡在工作。

优点:冗余性高

缺点:链路利用率低,两块网卡只有1块在工作,N块网卡绑定时利用率是1/N

mode=2(balance-xor)平衡策略#

表示使用MAC地址的XOR Hash负载分担,网络上特定的通信双方会始终经由某一个网卡的链路通信,和交换机的聚合强制不协商方式配合。(需要xmit_hash_policy[1],需要交换机配置port channel)

特点:基于指定的传输HASH策略传输数据包。缺省的策略是:(源MAC地址 XOR 目标MAC地址) % slave数量。其他的传输策略可以通过xmit_hash_policy选项指定,此模式提供负载平衡和容错能力。

mode=3(broadcast)(广播策略)#

表示所有包从所有绑定的网络接口发出,不考虑均衡流量的分担,只有冗余机制,但过于浪费资源。此模式适用于金融行业,因为他们需要高可靠性的网络,不允许出现任何问题。需要和交换机的聚合强制不协商方式配合。

特点:在每个slave接口上传输每个数据包,此模式提供了容错能力

mode=4(802.3ad)(IEEE 802.3ad 动态链接聚合)#

表示支持802.3ad协议,和交换机的聚合LACP方式配合(需要xmit_hash_policy).标准要求所有设备在聚合操作时,要在同样的速率和双工模式。

特点:创建一个聚合组,它们共享同样的速率和双工设定。根据802.3ad规范将多个slave工作在同一个激活的聚合体下。外出流量的slave选举是基于传输hash策略,该策略可以通过xmit_hash_policy选项从缺省的XOR策略改变到其他策略。需要注意的是,并不是所有的传输策略都是802.3ad适应的,尤其考虑到在802.3ad标准43.2.4章节提及的包乱序问题。不同的实现可能会有不同的适应性。

必要条件:

条件1:ethtool支持获取每个slave的速率和双工设定

条件2:switch(交换机)支持IEEE802.3ad Dynamic link aggregation

条件3:大多数switch(交换机)需要经过特定配置才能支持802.3ad模式

mode=5(balance-tlb)(适配器传输负载均衡)#

是根据每个slave的负载情况选择slave进行发送,接收时使用当前轮到的slave。该模式要求slave接口的网络设备驱动有某种ethtool支持;而且ARP监控不可用。

特点:不需要任何特别的switch(交换机)支持的通道bonding。在每个slave上根据当前的负载(根据速度计算)分配外出流量。如果正在接受数据的slave出故障了,另一个slave接管失败的slave的MAC地址。

必要条件:

ethtool支持获取每个slave的速率

mode=6(balance-alb)(适配器适应性负载均衡)#

在5的tlb基础上增加了rlb(接收负载均衡receiveload balance).不需要任何switch(交换机)的支持。接收负载均衡是通过ARP协商实现的.

与交换机对接的要求

模式1、模式5和模式6不需要交换机端的设置,网卡能自动聚合。

模式4需要支持802.3ad(交换机一侧需要配置lacp链路聚合)。

模式0、模式2和模式3理论上需要静态聚合方式。(据说实测中模式0可以通过mac地址欺骗的方式在交换机不设置的情况下不太均衡地进行接收。)

三:网卡bond配置方法#

登录系统加载bonding模块

systemctl stop NetworkManager.service # 停止NetworkManager服务

systemctl disable NetworkManager.service # 禁止开机启动NetworkManager服务

# 加载 bonding 模块

# 在正常情况下,执行该命令是没有输出的;

[root@test ~]# modprobe bonding 加载模块(重启系统后就不用手动再加载了)

# 如果输出 modprobe: ERROR: could not insert 'bonding': Module already in kernel 表示模块已加载;

# 确认是否加载成功

lsmod | grep bonding

bonding 136705 0

bond1配置:#

1.创建bond配置文件:ifconfig-bond0

vim /etc/sysconfig/network-scripts/ifcfg-bond0

DEVICE=bond0

TYPE=Ethernet

ONBOOT=yes

BOOTPROTO=static

IPADDR=192.168.0.10

NETMASK=255.255.255.0

GATEWAY=192.168.0.1

BONDING_OPTS='mode=1 miimon=100' #该处主要是用来bonding模式选择配置,如果在虚拟机上的话需要配置:fail_over_mac=1

2.网卡配置文件配置

物理网卡1:eth0

vi /etc/sysconfig/network-scripts/ifcfg-eth0

DEVICE=eth0 #网口名:eth0

TYPE=Ethernet #网口类型:以太网接口

ONBOOT=yes #系统启动时网口状态为激活

BOOTPROTO=none #网口激活协议:nono不适用任何协议

MASTER=bond0 #指定虚拟网口的名字

SLAVE=yes #备用(从设备)

物理网卡2:eth1

vi /etc/sysconfig/network-scripts/ifcfg-eth1

DEVICE=eth1

TYPE=Ethernet

ONBOOT=yes

BOOTPROTO=none

MASTER=bond0

SLAVE=yes

3.配置bond模式

vi /etc/modprobe.d/bond.conf

alias bond0 bonding

options bond0 miimon=100 mode=1

#miimon是用来进行链路监测的:miimon=100表示系统每100ms监测一次链路连接状态,如果有一条线路不通就转入另一条线路。

#mode=1表示属于主备模式

4.设置网卡主备顺序

vi /etc/rc.d/rc.local # eth0 eth1的工作顺序(仅在主备模式(mode1)下需要做这个设置,其他的模式不需要做这个设置)

ifenslave bond0 eth0 eth1

5.重启网络

systemctl restart network

bond4配置:#

1.创建bond配置文件:ifconfig-bond0

vim /etc/sysconfig/network-scripts/ifcfg-bond0

TYPE=Ethernet

BOOTPROTO=static

NAME=bond0

DEVICE=bond0

ONBOOT=yes

NM_CONTROLLED=no

BONDING_OPTS="miimon=100 mode=4"

IPADDR=10.xxx.xx.x

NETMASK=255.255.255.0

GATEWAY=10.xxx.xx.x

2.网卡配置文件配置

物理网卡1:eth0

vi /etc/sysconfig/network-scripts/ifcfg-eth0

TYPE=Ethernet

BOOTPROTO=none

NAME=eno0

DEVICE=eno0

ONBOOT=yes

MASTER=bond0

SLAVE=yes

USERCTL=no

NM_CONTROLLED=no

物理网卡2:eth1

TYPE=Ethernet

BOOTPROTO=none

NAME=eno1

DEVICE=eno1

ONBOOT=yes

MASTER=bond0

SLAVE=yes

USERCTL=no

NM_CONTROLLED=no

3、保存配置重启网络

systemctl restart network

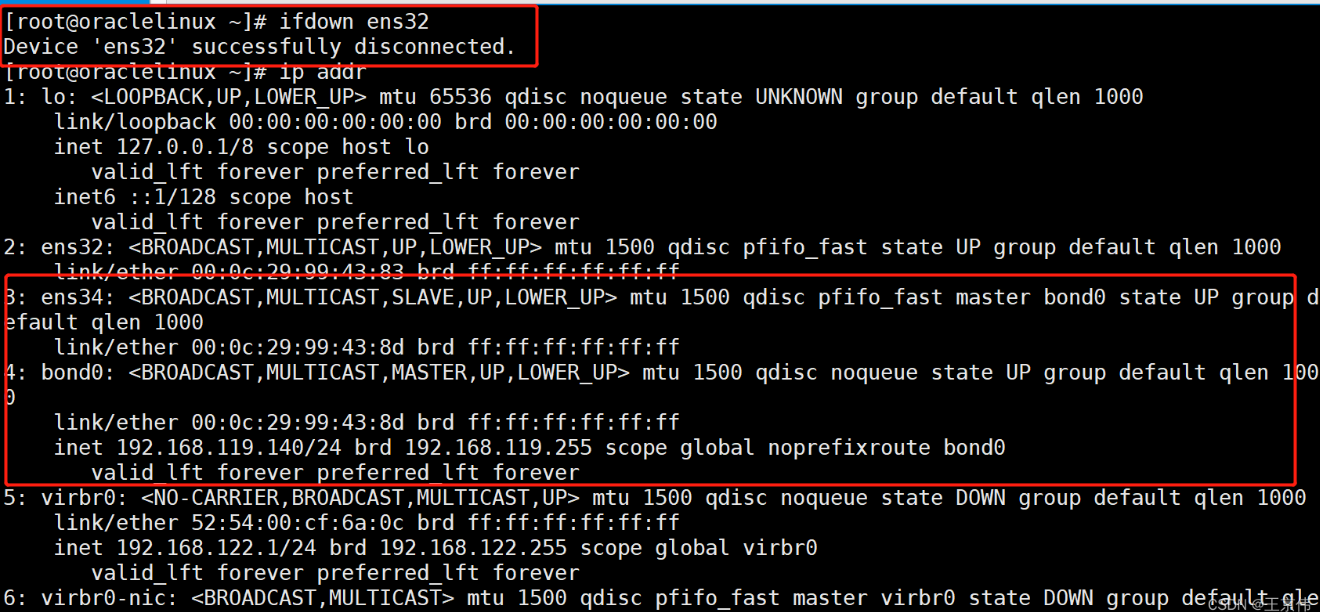

4、验证bonding配置成功

cat /proc/net/bonding/bond0

ifconfig

其他参数补充#

xmit_hash_policy:

这个参数的重要性我认为仅次于mode参数,mode参数定义了分发模式 ,而这个参数定义了分发策略 ,文档上说这个参数用于mode2和mode4。

layer2:使用二层帧头作为计算分发出口的参数,这导致通过同一个网关的数据流将完全从一个端口发送,为了更加细化分发策略,必须使用一些三层信息,然而却增加了计算开销。

layer2+3:在1的基础上增加了三层的ip报头信息,计算量增加了,然而负载却更加均衡了,一个个主机到主机的数据流形成并且同一个流被分发到同一个端口,根据这个思想,如果要使负载更加均衡。

layer3+4:可以形成一个个端口到端口的流,负载更加均衡。通过TCP及UDP端口及其IP地址进行HASH计算。

miimon和arp: 使用miimon仅能检测链路层的状态,也就是链路层的端到端连接(即交换机某个口和与之直连的本地网卡口),然而交换机的上行口如果down掉了还是无法检测到,因此必然需要网络层的状态检测,最简单也是最直接的方式就是arp了,可以直接arp网关,如果定时器到期网关还没有回复arp reply,则认为链路不通了。

作者:zhaopei123

出处:https://www.cnblogs.com/zhaopei123/p/16884884.html

版权:本作品采用「署名-非商业性使用-相同方式共享 4.0 国际」许可协议进行许可。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· winform 绘制太阳,地球,月球 运作规律

· 超详细:普通电脑也行Windows部署deepseek R1训练数据并当服务器共享给他人

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· AI 智能体引爆开源社区「GitHub 热点速览」

· 写一个简单的SQL生成工具