tensorflow(三十八):Batch Normalization

一、不进行归一化,某些W变化对loss影响较大

二、进行归一化

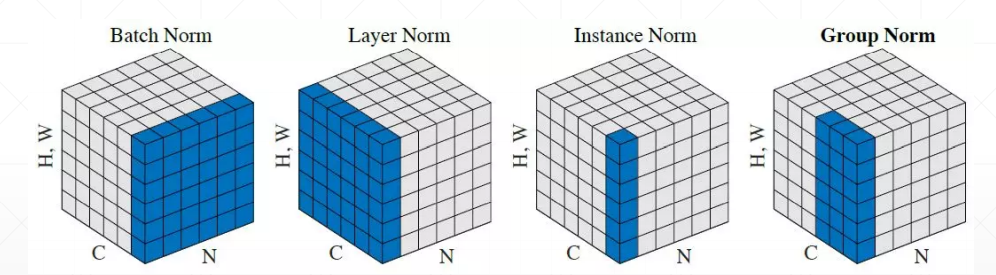

1、可以看到,Batch Norm结束后,只得到三个数值,每个通道一个。

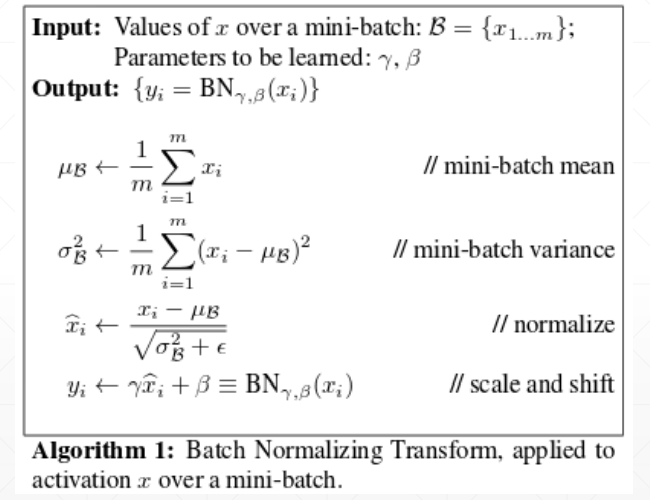

2、正常的Batch Norm过后,均值为0,方差为1,但是需要再加一个贝塔和伽马。(B,r)需要学出来。

变成了均值为B,方差为r。

三、用法

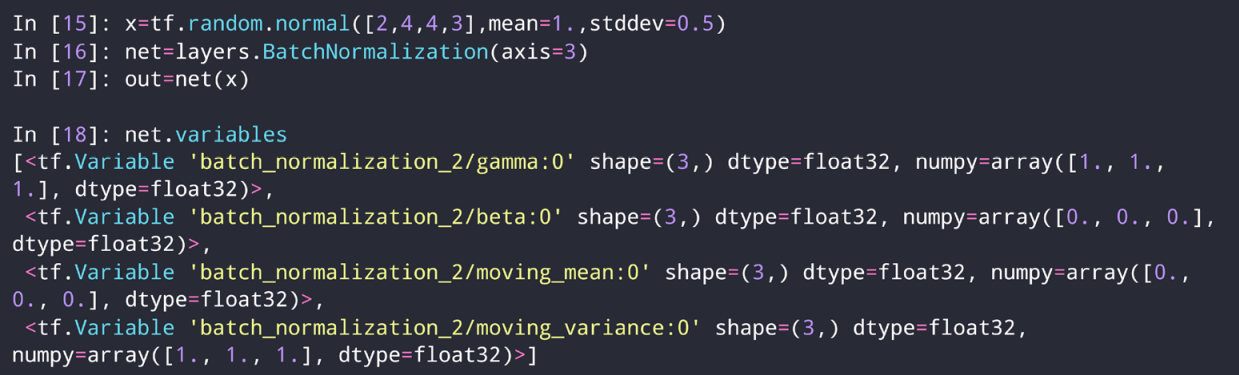

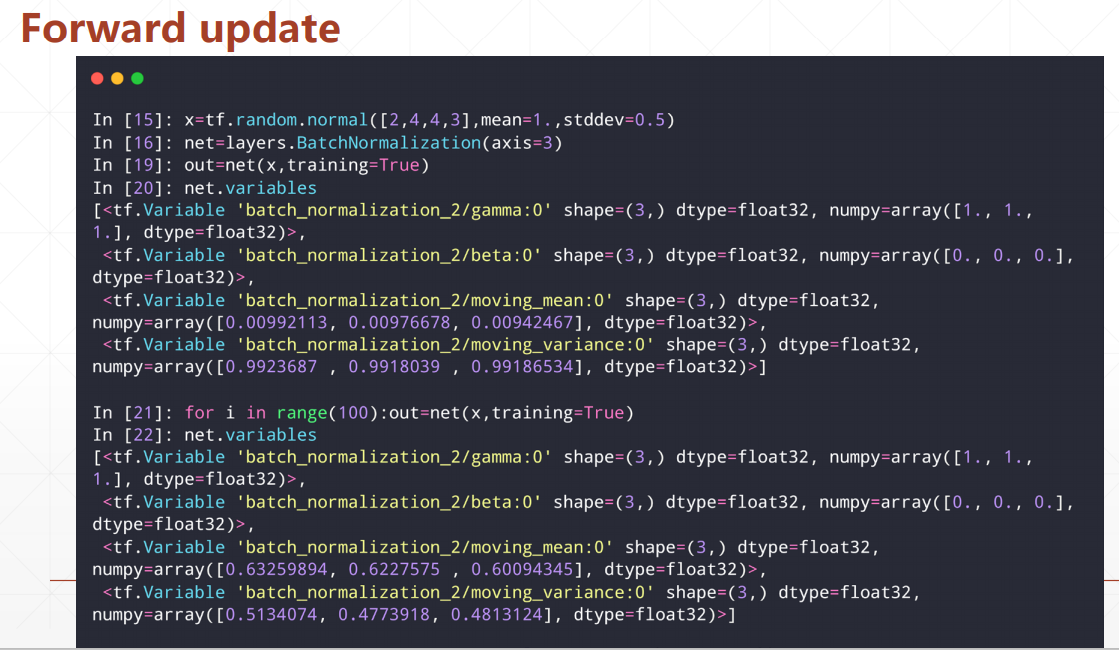

1、下面的center是均值B,scale是方差r。最后一个参数用于测试时候。

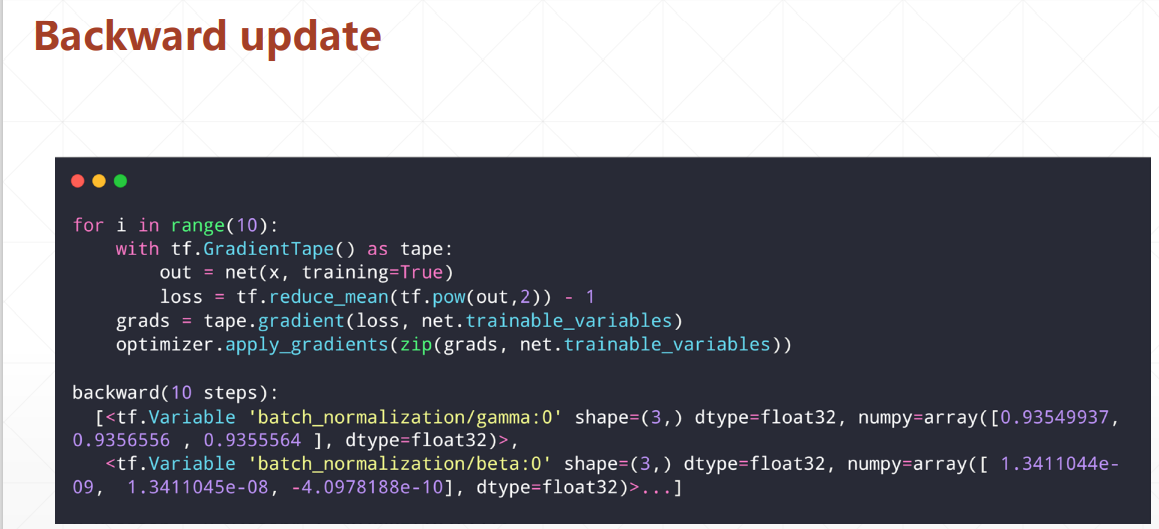

import tensorflow as tf from tensorflow import keras from tensorflow.keras import layers, optimizers # 2 images with 4x4 size, 3 channels # we explicitly enforce the mean and stddev to N(1, 0.5) x = tf.random.normal([2,4,4,3], mean=1.,stddev=0.5) net = layers.BatchNormalization(axis=-1, center=True, scale=True, trainable=True) out = net(x) print('forward in test mode:', net.variables) out = net(x, training=True) print('forward in train mode(1 step):', net.variables) for i in range(100): out = net(x, training=True) print('forward in train mode(100 steps):', net.variables) optimizer = optimizers.SGD(lr=1e-2) for i in range(10): with tf.GradientTape() as tape: out = net(x, training=True) loss = tf.reduce_mean(tf.pow(out,2)) - 1 grads = tape.gradient(loss, net.trainable_variables) optimizer.apply_gradients(zip(grads, net.trainable_variables)) print('backward(10 steps):', net.variables)

分类:

tensorflow2基础

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 开发者必知的日志记录最佳实践

· SQL Server 2025 AI相关能力初探

· Linux系列:如何用 C#调用 C方法造成内存泄露

· AI与.NET技术实操系列(二):开始使用ML.NET

· 记一次.NET内存居高不下排查解决与启示

· 阿里最新开源QwQ-32B,效果媲美deepseek-r1满血版,部署成本又又又降低了!

· 开源Multi-agent AI智能体框架aevatar.ai,欢迎大家贡献代码

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧