原生ceph更换故障硬盘过程

准备

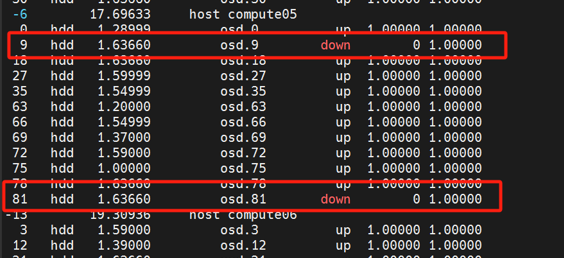

1 、确定故障硬盘所在节点的信息,避免操作错误

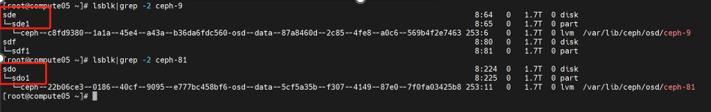

2 确定故障osd的lvm信息

ceph-c8fd9380-1a1a-45e4-a43a-b36da6fdc560

ceph-22b06ce3-0186-40cf-9095-e777bc458bf6

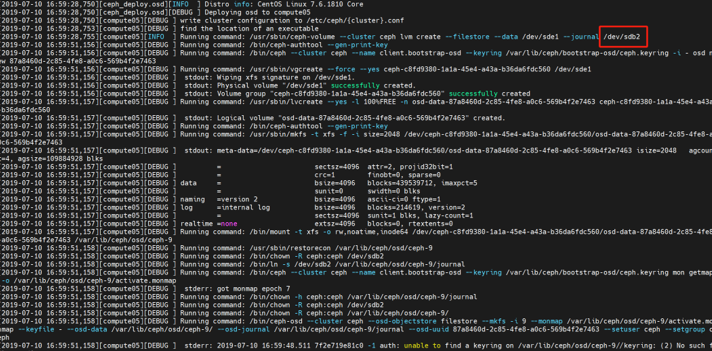

3 确认数据盘对应的缓存盘(查看ceph部署时的日志)

osd.9->sdb2

osd.81->sdc6

更换步骤

1 禁止平台数据同步与回填

#ceph osd set norecover

#ceph osd set nobackfill

2 从存储集群中删除故障硬盘

#ceph osd rm osd.9

#ceph osd rm osd.81

#ceph auth del osd.9

#ceph auth del osd.81

3 删除lvm osd对应的uuid

#vgremove ceph-c8fd9380-1a1a-45e4-a43a-b36da6fdc560

#vgremove ceph-22b06ce3-0186-40cf-9095-e777bc458bf6

4 机房更换故障硬盘

5 创建云硬盘

格式化新加入的云硬盘

# parted -s /dev/sde mklabel gpt mkpart primary xfs 0% 100%

# parted -s /dev/sdo mklabel gpt mkpart primary xfs 0% 100%

6 添加osd filestore

#cd /root/ceph_deploy

#/usr/bin/ceph-deploy osd create --filestore --fs-type xfs --data /dev/sde1 --journal /dev/sdb2 compute05

#/usr/bin/ceph-deploy osd create --filestore --fs-type xfs --data /dev/sdo1 --journal /dev/sdc6 compute05

验证

查看存储集群compute05中故障硬盘状态是否恢复正常

#ceph osd tree

正常之后

开启集群数据同步与回填

#ceph osd unset norecover

#ceph osd unset nobackfill

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 分享一个免费、快速、无限量使用的满血 DeepSeek R1 模型,支持深度思考和联网搜索!

· 基于 Docker 搭建 FRP 内网穿透开源项目(很简单哒)

· ollama系列01:轻松3步本地部署deepseek,普通电脑可用

· 25岁的心里话

· 按钮权限的设计及实现

2020-05-29 OpenStack运维记录-USB透传