爬虫综合大作业——爬取兰州二手房房屋情况

作业来源于:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE1/homework/3159

作业要求:

可以用pandas读出之前保存的数据:

newsdf = pd.read_csv(r'F:\duym\gzccnews.csv')

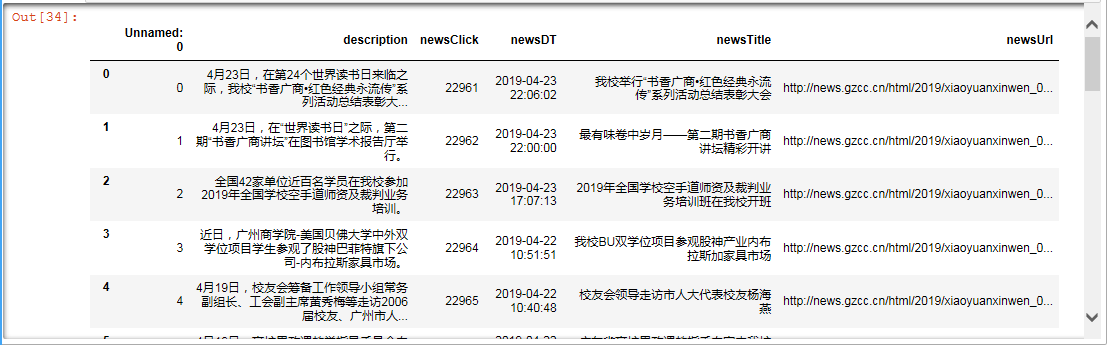

运行代码:

import pandas as pd newsdf=pd.DataFrame(allnews) newsdf.to_csv(r'F:\gzccnews.csv',encoding = 'utf-8') newsdf = pd.read_csv(r'F:\gzccnews.csv',encoding = 'utf-8') newsdf

运行截图:

一.把爬取的内容保存到数据库sqlite3

import sqlite3

with sqlite3.connect('gzccnewsdb.sqlite') as db:

newsdf.to_sql('gzccnews',con = db)

with sqlite3.connect('gzccnewsdb.sqlite') as db:

df2 = pd.read_sql_query('SELECT * FROM gzccnews',con=db)

运行代码:

import sqlite3 with sqlite3.connect('gzccnewsdb.sqlite') as db: newsdf.to_sql('gzccnews',con = db) with sqlite3.connect('gzccnewsdb.sqlite') as db: df2 = pd.read_sql_query('SELECT * FROM gzccnews',con=db) df2

运行截图:

保存到MySQL数据库

- import pandas as pd

- import pymysql

- from sqlalchemy import create_engine

- conInfo = "mysql+pymysql://user:passwd@host:port/gzccnews?charset=utf8"

- engine = create_engine(conInfo,encoding='utf-8')

- df = pd.DataFrame(allnews)

- df.to_sql(name = ‘news', con = engine, if_exists = 'append', index = False)

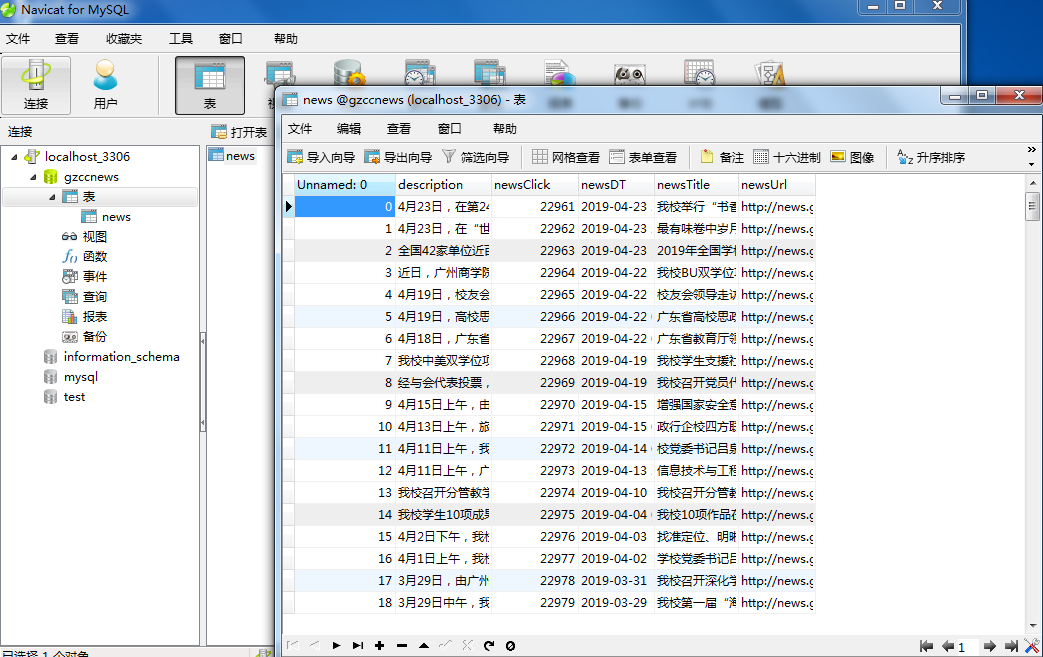

运行代码:

import pandas as pa import pymysql from sqlalchemy import create_engine coninfo='mysql+pymysql://root:@localhost:3306/gzccnews?charset=utf8' engine = create_engine(coninfo,encoding='utf_8') newsdf.to_sql(name = 'news',con = engine,if_exists = 'append',index = False,index_label='id') newsdf.to_sql(name = 'news',con = engine,if_exists = 'append',index = False) conn = pymysql.connect(host='localhost',port=3306,user='root',passwd='',db='gzccnews',charset='utf8')

运行截图:

二.爬虫综合大作业

- 选择一个热点或者你感兴趣的主题。

- 选择爬取的对象与范围。

- 了解爬取对象的限制与约束。

- 爬取相应内容。

- 做数据分析与文本分析。

- 形成一篇文章,有说明、技术要点、有数据、有数据分析图形化展示与说明、文本分析图形化展示与说明。

- 文章公开发布。

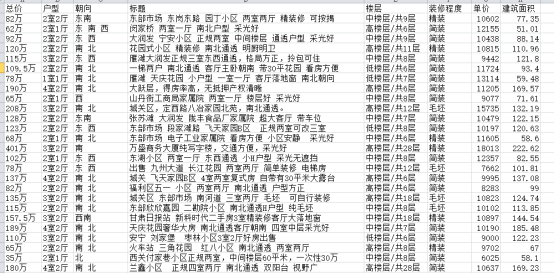

爬取兰州二手房房屋情况

1)运行代码

对数据的首页进行解析

from bs4 import BeautifulSoup #将兰州在售二手房源网页首页url(http://esf.sh.fang.com/)赋值给domain domain = 'https://lz.lianjia.com/ershoufang/' #创建BeautifulSoup对象对res响应包进行解析,结果命名为soup soup = BeautifulSoup(res.text,'html.parser') #循环遍历获取网页首页所有房源详细内容页的url,循环变量名为house(提示:检查定位路径定位查找的节点是否为空) for house in soup.select('.info.clear .title a'): #(提示:如果存在返回的标签节点有空的情况,需要进行判断!) if house: #利用domain与存储房屋详细内容的相对url的标签节点构建房屋的url #打印输出查看url print(house['href']) #输出======表示间隔 print('===========================================')

对详细页内容进行解析

#根据上面分析定义一个获取网页详细内容页的函数getHouseDetail def getHouseDetail(url): # info = {} res = requests.get(url,headers=header)#根据url请求网页内容 soup = BeautifulSoup(res.text,'html.parser')#解析详细内容页,结果命名为soup info={ '标题' :soup.select('.title h1')[0].text, '总价' : soup.select('.total')[0].text+soup.select('.unit')[0].text , '单价' :soup.select('.text .unitPrice')[0].text , '户型' : soup.select('.room .mainInfo')[0].text , '楼层':soup.select('.room .subInfo')[0].text , '朝向':soup.select('.type .mainInfo')[0].text , '建筑面积' :soup.select('.area .mainInfo')[0].text , '装修程度': soup.select('.type .subInfo')[0].text } return info

输出内容信息

import pandas as pd import time from bs4 import BeautifulSoup houseary=[] #定义列表用于存储所有房屋的相关数据 for i in range(1,87): url = 'https://lz.lianjia.com/ershoufang/pg' + str(i) + '/' res = requests.get(url,headers = header) soup = BeautifulSoup(res.text,'html.parser') #创建BeatifulSoup对象并进行解析 for detail in soup.select('.info.clear .title a'): #遍历获取网页首页中存有的标签节点,循环变量命名为detail url = detail['href'] #存储房屋详细内容的相对url的标签节点构建房屋的url houseary.append(getHouseDetail(url)) #调用getHouseDetail函数获取每一房屋相关数据并追加到houseary time.sleep(2) #时间间隔为2秒

2)运行截图

参考:

爬了一下天猫上的Bra购买记录,有了一些羞羞哒的发现...

Python做了六百万字的歌词分析,告诉你中国Rapper都在唱些啥

分析了42万字歌词后,终于搞清楚民谣歌手唱什么了

十二星座的真实面目

唐朝诗人之间的关系到底是什么样的?

中国姓氏排行榜

三.爬虫注意事项

1.设置合理的爬取间隔,不会给对方运维人员造成压力,也可以防止程序被迫中止。

- import time

- import random

- time.sleep(random.random()*3)

2.设置合理的user-agent,模拟成真实的浏览器去提取内容。

- 首先打开你的浏览器输入:about:version。

- 用户代理:

- 收集一些比较常用的浏览器的user-agent放到列表里面。

- 然后import random,使用随机获取一个user-agent

- 定义请求头字典headers={’User-Agen‘:}

- 发送request.get时,带上自定义了User-Agen的headers

3.需要登录

发送request.get时,带上自定义了Cookie的headers

headers={’User-Agen‘:

'Cookie': }

4.使用代理IP

通过更换IP来达到不断高 效爬取数据的目的。

headers = {

"User-Agent": "",

}

proxies = {

"http": " ",

"https": " ",

}

response = requests.get(url, headers=headers, proxies=proxies)

四、第11周课堂检查