论文-Swish: A self-gated Active Function

Swish: A self-gated Active Function

在深度网络中,激活函数的选择,对训练网络和网络性能有着很重要的影响。目前使用的最多的是Relu(Rectified Linear Unit), 本文提出了一种新的激活函数,Swish,f(x) = x * sigmoid(x),实验证明了Swish比ReLUs在深层网络可以取得更好的效果。对于新的激活函数,在ImageNet上top-1 accuracy对于Mobile NASNet-A提高了0.9%,对Inception-ResNet-v2取得了0.6%的提升。因为Swish的简单和与ReLUs的相似让Swish更好的代替并实现在神经网络上。

Swish:

f(x) = x*sigmoid(x) , sigmoid(x) = 1/(1 +exp(-x))

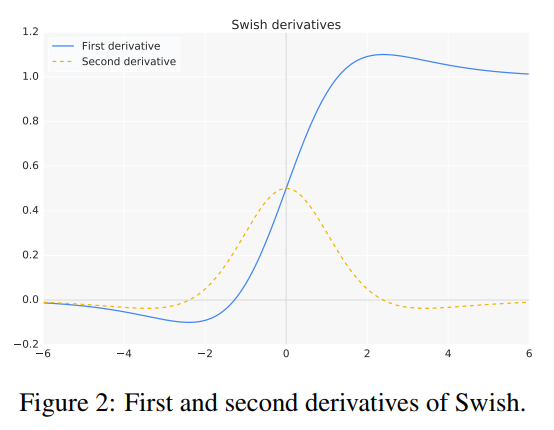

Swish有着下界和没有上界,该函数是连续的,但非单调。非单调的特点是Swish区别于其他active function的特点。

同时,Swish也可以定义为参数版本:

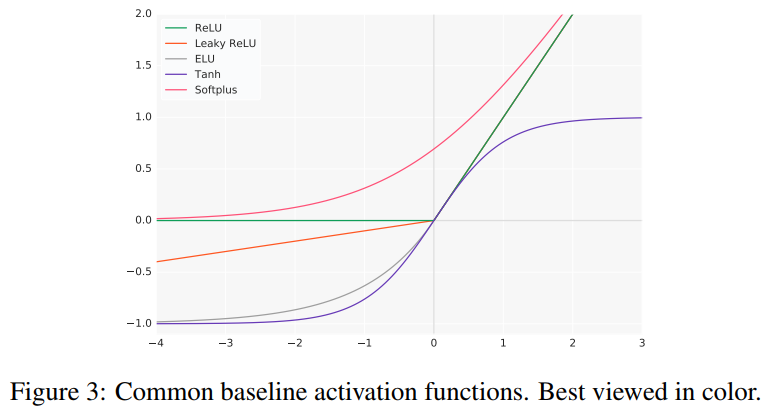

Swish与其他active function之间的比较:

Unboundedness(无界性)有利于防止在slow training时gradient逐渐趋于0,造成饱和。同时,being bounded也是有优势的,因为bounded的active function可以有很强的regulairzation,较大的negative inputs会被化解。

同时,smoothness也是对optimization和generalization也是有着很重要的角色。

该实验是:随机初始化一个6层神经网络,采集Swish layer后的loss landscape,对于一个smooth 的loss landscape更加容易去做优化,因为该Swish layer有着更强的traversable,同时减小了对初始化和learning rate的依赖。

个人感想:

对于一种新的active function这种较小的网络元件,作者采用了丰富的论文技巧来阐述Swish,很值得写论文的学生一看。