scala使用spark对txt文件数据进行去重

1.功能简介

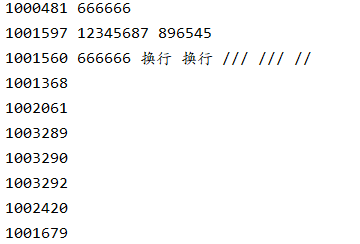

将txt文件中的数据进行数据去重并显示在输出框中

2.txt数据格式

3.源代码

import org.apache.spark.rdd.RDD import org.apache.spark.{SparkConf, SparkContext} object spark01_wordcount { def main(args: Array[String]): Unit = { val sparConf = new SparkConf().setMaster("local").setAppName("WordCount") val sc = new SparkContext(sparConf) val lines:RDD[String] = sc.textFile("filepath") //filepath为txt文件路径 val words:RDD[String]=lines.flatMap(_.split(" ")) //此处为以某个分隔符对每行数据进行切分,我用的是空格也可更改为其他符号如逗号 val afterdeal=words.distinct().collect().mkString(",") //去重操作并将去重结果以逗号为分隔符组成一个字符串 val realwords:Array[String] = afterdeal.split(",") realwords.foreach(println) sc.stop() } }

4.结果截图