18@shell队列实现线程并发控制

0|1文章目录

1|0shell实现线程并发控制

需求:并发检测1000台web服务器状态(或者并发为1000台web服务器分发文件等):

如何利用shell进行实现

1|1一、方案一(for循环)

一个for循环1000次,顺序执行1000次任务

1、脚本编写使用

2、脚本解析

1|2二、方案二(for循环)

一个for循环1000次,循环体里面的每个任务都放入后台运行(在命令后面加***&***符号代表后台运行)

1、脚本编写使用

2、脚本解析

1|3三、方案三

基于方案二,使用linux管道文件特性制作队列,控制线程数目

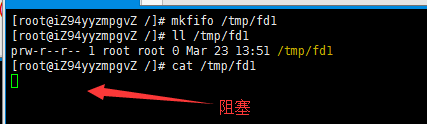

1、管道文件

2、管道文件特性

echo “test” > /tmp/fd1(如果没有读管道的操作,则阻塞)

总述:利用有名管道的上述特性就可以实现一个队列控制了

3、文件描述符

4、脚本编写及使用

5、脚本解析

6、问题示列

__EOF__

本文作者:ଲ小何才露煎煎饺

本文链接:https://www.cnblogs.com/zeny/p/15121510.html

关于博主:评论和私信会在第一时间回复。或者直接私信我。

版权声明:本博客所有文章除特别声明外,均采用 BY-NC-SA 许可协议。转载请注明出处!

声援博主:如果您觉得文章对您有帮助,可以点击文章右下角【推荐】一下。您的鼓励是博主的最大动力!

本文链接:https://www.cnblogs.com/zeny/p/15121510.html

关于博主:评论和私信会在第一时间回复。或者直接私信我。

版权声明:本博客所有文章除特别声明外,均采用 BY-NC-SA 许可协议。转载请注明出处!

声援博主:如果您觉得文章对您有帮助,可以点击文章右下角【推荐】一下。您的鼓励是博主的最大动力!

本文来自博客园,作者:ଲ小何才露煎煎饺,转载请注明原文链接:https://www.cnblogs.com/zeny/p/15121510.html

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Linux系列:如何用heaptrack跟踪.NET程序的非托管内存泄露

· 开发者必知的日志记录最佳实践

· SQL Server 2025 AI相关能力初探

· Linux系列:如何用 C#调用 C方法造成内存泄露

· AI与.NET技术实操系列(二):开始使用ML.NET

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· 无需6万激活码!GitHub神秘组织3小时极速复刻Manus,手把手教你使用OpenManus搭建本

· C#/.NET/.NET Core优秀项目和框架2025年2月简报