Keras如何在学习过程中降低学习率

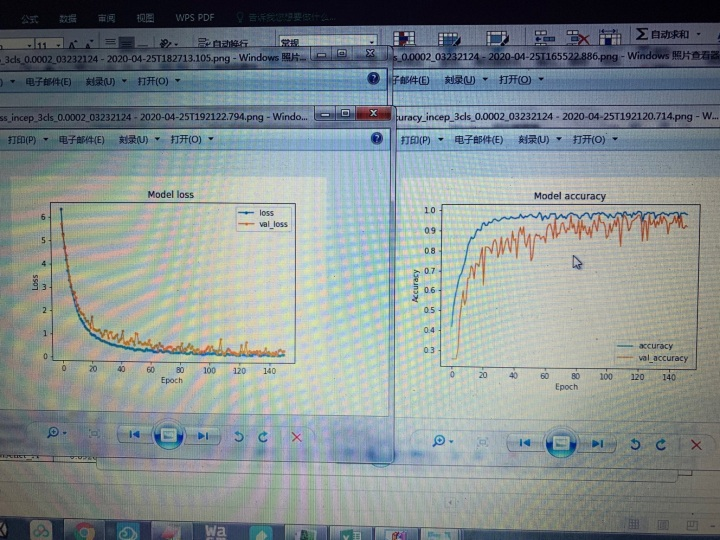

波动是正常现象,而且你这个算法跑得还可以(可以看出train和val差的很少),你可以尝试学习率递减,因为你看到了后期train基本上没怎么动,而对val影响还不小,因此后期可以让学习率降低(反正acc上升空间也不大),然后多跑一会就行

Keras学习率调整

1. LearningRateScheduler

keras.callbacks.LearningRateScheduler(schedule)

该回调函数是学习率调度器.

参数

- schedule:函数,该函数以epoch号为参数(从0算起的整数),返回一个新学习率(浮点数)

代码

import keras.backend as K

from keras.callbacks import LearningRateScheduler

def scheduler(epoch):

# 每隔100个epoch,学习率减小为原来的1/10

if epoch % 100 == 0 and epoch != 0:

lr = K.get_value(model.optimizer.lr)

K.set_value(model.optimizer.lr, lr * 0.1)

print("lr changed to {}".format(lr * 0.1))

return K.get_value(model.optimizer.lr)

reduce_lr = LearningRateScheduler(scheduler)

https://blog.csdn.net/zzc15806/article/details/79711114

随着学习的进行,深度学习的学习速率逐步下降 为什么比 固定的学习速率 得到的结果更加准确?

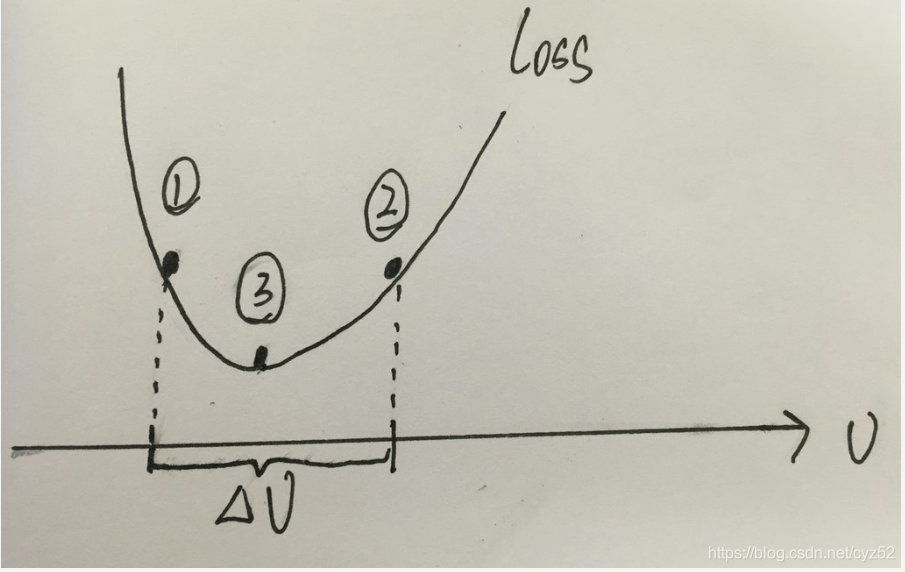

如上图所示,曲线代表损失值,小球一开始位于(1)处,假设学习速率设置为 △ v,那么根据梯度下降,损失值将在(1) (2)之间来回移动,无法到达最小值(3)处。要想到达(3),只能降低学习速率。

2. ReduceLROnPlateau

learning_rate_reduction = ReduceLROnPlateau(monitor='val_acc', patience=3, verbose=1, factor=0.5, min_lr=0.00001)

#并且作为callbacks进入generator,开始训练

history = model.fit_generator(datagen.flow(X_train,Y_train, batch_size=batch_size),

epochs = epochs, validation_data = (X_val,Y_val),

verbose = 2, steps_per_epoch=X_train.shape[0] // batch_size

, callbacks=[learning_rate_reduction])

文档:

ReduceLROnPlateau keras.callbacks.ReduceLROnPlateau(monitor='val_loss', factor=0.1, patience=10, verbose=0, mode='auto', epsilon=0.0001, cooldown=0, min_lr=0)

当评价指标不在提升时,减少学习率。当学习停滞时,减少2倍或10倍的学习率常常能获得较好的效果。该回调函数检测指标的情况,如果在patience个epoch中看不到模型性能提升,则减少学习率

参数

monitor:被监测的量

factor:每次减少学习率的因子,学习率将以lr = lr*factor的形式被减少

patience:当patience个epoch过去而模型性能不提升时,学习率减少的动作会被触发

mode:‘auto’,‘min’,‘max’之一,在min模式下,如果检测值触发学习率减少。在max模式下,当检测值不再上升则触发学习率减少。

epsilon:阈值,用来确定是否进入检测值的“平原区”

cooldown:学习率减少后,会经过cooldown个epoch才重新进行正常操作

min_lr:学习率的下限

转载:https://www.cnblogs.com/jsxyhelu/p/9251101.html