python3爬虫 -----新浪微博(m)-------评论爬取

1 import requests 2 import time 3 import re 4 5 6 7 p=0 8 while p<=0: 9 p+=1 10 url = "https://m.weibo.cn/api/comments/show?id=4257289713596342&page="+str(p) #杨洋为例 11 html = requests.get(url) 12 print(html) 13 try: 14 for c in range(len(html.json()['data']['data'])): 15 data=html.json()['data']['data'][c]['text'] 16 with open('comments.txt','a',encoding='utf-8') as f: 17 comments=''.join(re.findall('[\u4e00-\u9fa5]',data)) 18 print(comments) 19 f.write(comments+'\n'*2) 20 except: 21 None

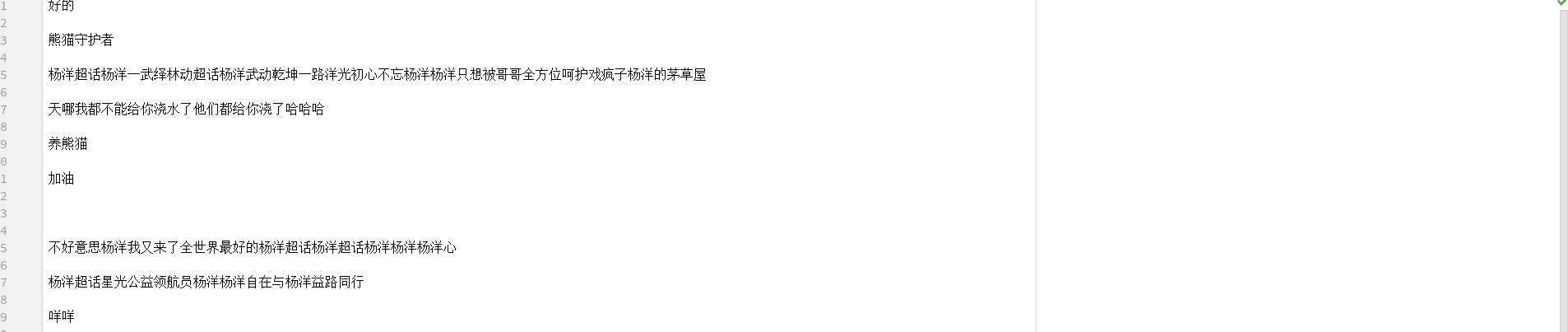

效果如下所示:

分类:

python----spider

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】凌霞软件回馈社区,博客园 & 1Panel & Halo 联合会员上线

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 智能桌面机器人:用.NET IoT库控制舵机并多方法播放表情

· Linux glibc自带哈希表的用例及性能测试

· 深入理解 Mybatis 分库分表执行原理

· 如何打造一个高并发系统?

· .NET Core GC压缩(compact_phase)底层原理浅谈

· 新年开篇:在本地部署DeepSeek大模型实现联网增强的AI应用

· DeepSeek火爆全网,官网宕机?本地部署一个随便玩「LLM探索」

· Janus Pro:DeepSeek 开源革新,多模态 AI 的未来

· 上周热点回顾(1.20-1.26)

· 【译】.NET 升级助手现在支持升级到集中式包管理