批量下载小说网站上的小说(python爬虫)

随便说点什么

因为在学python,所有自然而然的就掉进了爬虫这个坑里,好吧,主要是因为我觉得爬虫比较酷,才入坑的。

想想看,你可以批量自动的采集互联网上海量的资料数据,是多么令人激动啊!

所以我就被这块大蛋糕吸引过来了 :)

想学爬虫自然要去找学习资料了,不过网上有很多,我找了不少,个人觉得崔庆才的爬虫教程写得不错。起码对我来说,入门是够了。

感兴趣的朋友可以点进链接看看:Python爬虫学习系列教程 <==这位兄台博客做得也很好

掌握了基本的爬虫知识,主要是urllib,urlib2,re 这些库,以及Request(),urlopen()的基本用法之后,我就开始寻找爬取目标。

正好女朋友的哥哥让她帮忙下载小说,找我推荐几本,我一时也不知道他哥喜欢什么类型的,心想干脆找个小说网批量下载一些小说。

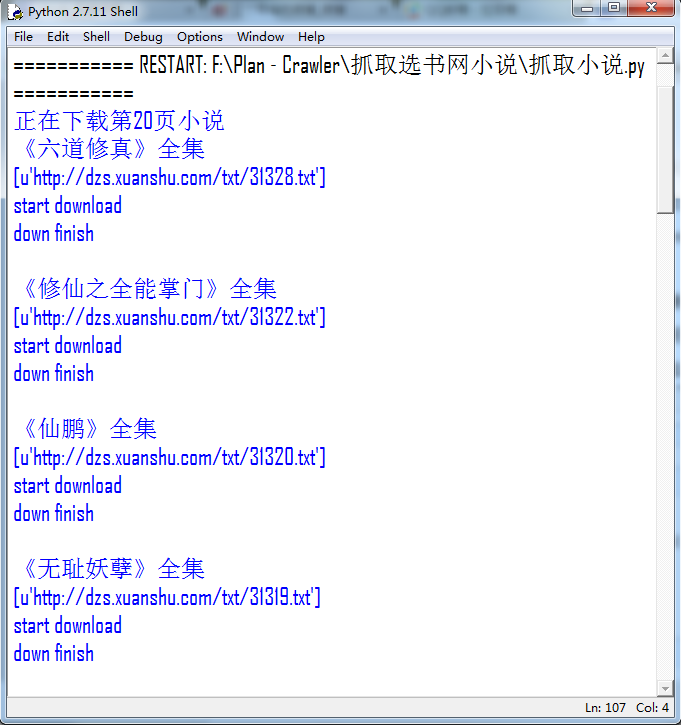

于是说干就干,用了一个中午时间写了一个粗糙的爬虫脚本,启动发现可以运行,让脚本在这儿跑着,我回去躺在床上呼呼大睡。

起来之后发现脚本遇到错误,停掉了,于是debug,干掉bug之后跑起来陆续又发现几个错误,于是干脆在一些容易出错的地方,例如urlopen()请求服务器的地方,本地write()写入的地方(是的,这也会有超时错误!)加入了try-except捕获错误进行处理,另外加入了socket.timeout网络超时限制,修修补补之后总算可以顺畅的运行。

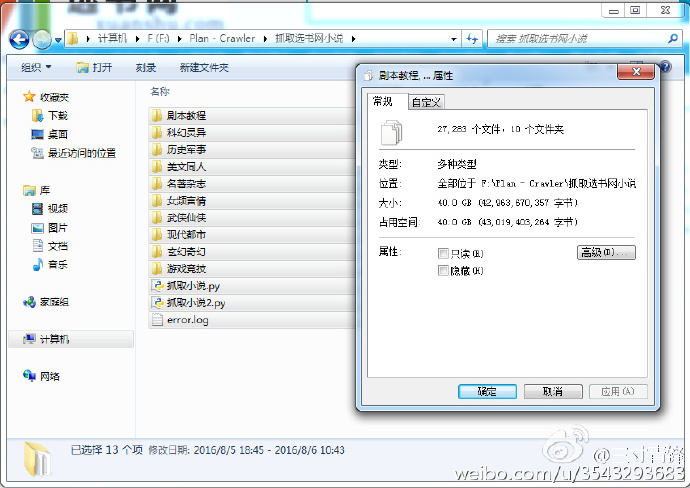

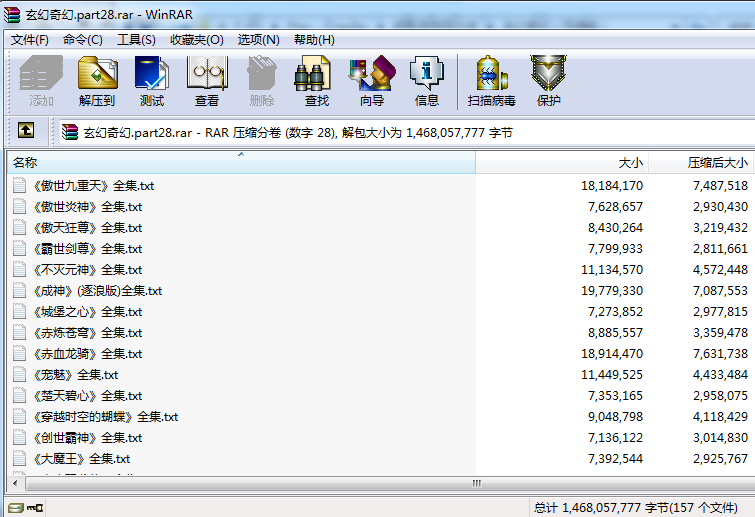

如此,运行了两天,爬虫脚本把这个小说网上的几乎所有小说都下载到了本地,一共27000+本小说,一共40G。

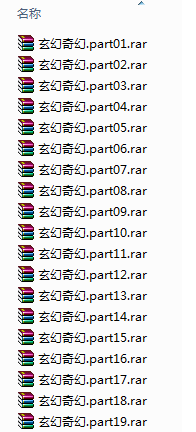

自此,大功告成,打包发了过去。另外说一句,百度云真坑,每次上传数量有限制,分享给朋友文件数量有限制,分享的文件夹大小也有限制,害的我还得整成压缩版才能分享。

下载界面

下面附上代码

1 #coding=utf-8

2 import urllib

3 import urllib2

4 import re

5 import os

6

7 webroot = 'http://www.xuanshu.com'

8

9 for page in range(20,220):

10 print '正在下载第'+str(page)+'页小说'

11

12 url = 'http://www.xuanshu.com/soft/sort02/index_'+str(page)+'.html'

13 headers = {'User-Agent':'Mozilla/5.0 (Windows; U; Windows NT 6.1; en-US; rv:1.9.1.6) Gecko/20091201 Firefox/3.5.6' }

14 try:

15 request = urllib2.Request(url,headers=headers)

16 response = urllib2.urlopen(request,timeout=180)

17 #print response.read()

18 except urllib2.URLError, e:

19 if hasattr(e,"code"):

20 print e.code

21 if hasattr(e,"reason"):

22 print e.reason

23

24 html = response.read().decode('utf-8')

25 #print html

26 pattern = re.compile(u'<li>.*?<div class="s">.*?target="_blank">(.*?)</a><br />大小:(.*?)<br>.*?</em><br>更新:(.*?)</div>.*?<a href="(.*?)"><img.*?>(.*?)</a>.*?<div class="u">(.*?)</div>',re.S)

27 items = re.findall(pattern,html)

28 #print items

29

30 for item in items:

31 try:

32 book_auther = item[0].encode('gbk')

33 book_size = item[1].encode('gbk')

34 book_updatetime = item[2].encode('gbk')

35 book_link = item[3].encode('gbk')

36 book_name = item[4].encode('gbk')

37 book_note = item[5].encode('gbk')

38

39 book_full_link = webroot + book_link # 构建书的绝对地址

40

41 #请求地址

42 try:

43 request = urllib2.Request(book_full_link,headers=headers)

44 response = urllib2.urlopen(request,timeout=180)

45 except urllib2.URLError, e:

46 if hasattr(e,"code"):

47 print e.code

48 if hasattr(e,"reason"):

49 print e.reason

50 html = response.read().decode('utf-8')

51 #print html

52 pattern = re.compile('<a class="downButton.*?<a class="downButton" href=\'(.*?)\'.*?Txt.*?</a>',re.S)

53 down_link = re.findall(pattern,html)

54 print book_name

55 print down_link

56

57 # down txt

58 try:

59 request = urllib2.Request(down_link[0].encode('utf-8'),headers=headers)

60 response = urllib2.urlopen(request,timeout=180)

61 except urllib2.URLError, e:

62 if hasattr(e,"code"):

63 print e.code

64 if hasattr(e,"reason"):

65 print e.reason

66 try:

67 fp = open(book_name+'.txt','w')

68 except IOError,e:

69 pattern = re.compile('<strong>.*?>(.*?)<.*?</strong>',re.S)

70 book_name = re.findall(pattern,book_name)

71 fp = open(book_name[0]+'.txt','w')

72 print 'start download'

73 fp.write(response.read())

74 print 'down finish\n'

75 fp.close()

76 except Exception,e:

77 print '该条目解析出现错误,忽略'

78 print e

79 print ''

80 fp = open('error.log','a')

81 fp.write('page:'+str(page)+'\n')

82 fp.write(item[4].encode('gbk'))

83 #fp.write(e)

84 fp.write('\nThere is an error in parsing process.\n\n')

85 fp.close()

86

87

注意

该脚本只定向抓取“选书网”小说站,“玄幻奇幻”分类下的小说。供网友们参考,可自行修改。

写得比较粗糙,勿喷……

Freecode# : www.cnblogs.com/yym2013

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Linux系列:如何用heaptrack跟踪.NET程序的非托管内存泄露

· 开发者必知的日志记录最佳实践

· SQL Server 2025 AI相关能力初探

· Linux系列:如何用 C#调用 C方法造成内存泄露

· AI与.NET技术实操系列(二):开始使用ML.NET

· 无需6万激活码!GitHub神秘组织3小时极速复刻Manus,手把手教你使用OpenManus搭建本

· C#/.NET/.NET Core优秀项目和框架2025年2月简报

· Manus爆火,是硬核还是营销?

· 一文读懂知识蒸馏

· 终于写完轮子一部分:tcp代理 了,记录一下

2014-01-01 hdu 1009:FatMouse' Trade(贪心)