HDFS 在本地使用java API上传文件到阿里云ECS报错 org.apache.hadoop.hdfs.BlockMissingException: Could not obtain block | could only be replicated to 0 nodes instead of minReplication (=1)

HDFS 在本地使用java API上传文件到阿里云ECS报错

org.apache.hadoop.hdfs.BlockMissingException: Could not obtain block

org.apache.hadoop.ipc.RemoteException(java.io.IOException): could only be replicated to 0 nodes instead of minReplication (=1)

问题描述

在本地使用Java API操作HDFS文件系统上传和下载文件时获取不到数据,连接DataNode异常,按照常规思路百度报错检查后没有问题,意识到可能是集群搭载在阿里云ECS上的缘故。

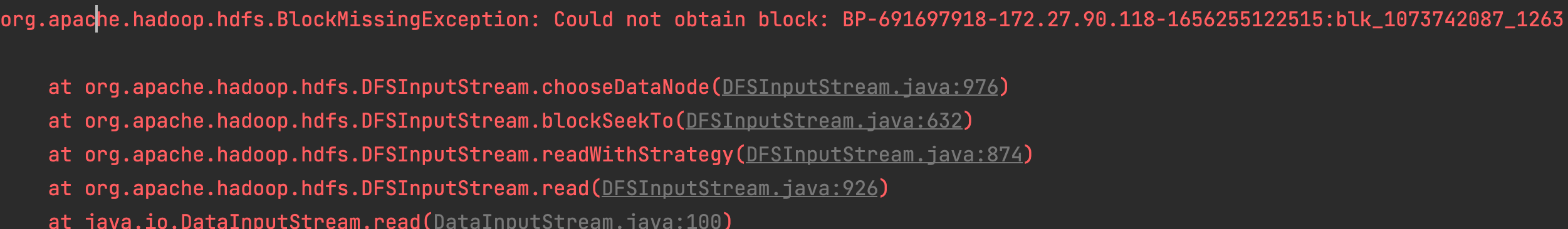

文件下载时报错

org.apache.hadoop.hdfs.BlockMissingException: Could not obtain block: BP-691697918-172.27.90.118-1656255122515:blk_1073742087_1263 file=/dir1/score.txt

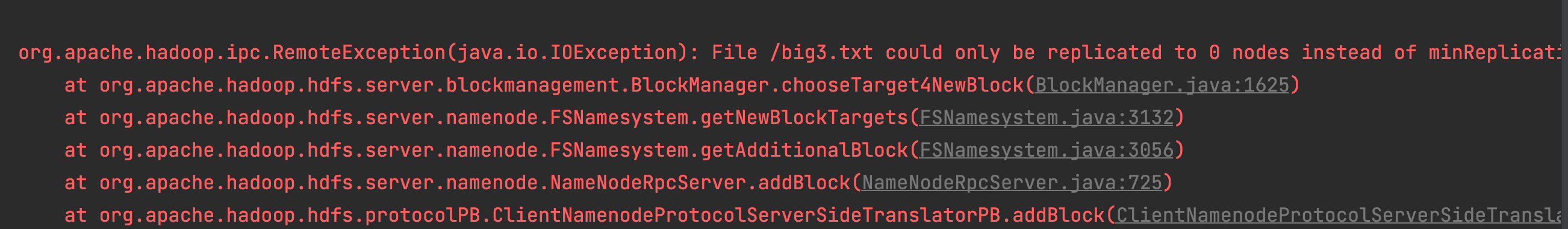

文件上传时候报错

org.apache.hadoop.ipc.RemoteException(java.io.IOException): File /big3.txt could only be replicated to 0 nodes instead of minReplication (=1). There are 3 datanode(s) running and 3 node(s) are excluded in this operation

问题原因

文件夹和文件名都是存放在 NameNode 上的,本地可以通过公网访问 NameNode,所以创建文件夹和文件都可以,但是读写数据的时候,NameNode 和DataNode 是通过内网通信的,NameNode 会返回给本地 DataNode 的内网 IP,本地就访问不了了。

解决办法

在代码中添加配置设置Hadoop的dfs客户端使用hostname访问datanode

//创建Configuration对象

Configuration conf = new Configuration();

//设置Hadoop的dfs客户端使用hostname访问datanode

conf.set("dfs.client.use.datanode.hostname", "true");

注意

在本地电脑hosts文件中需要配置主机名与DataNode服务器公网ip的映射

参考链接

posted on 2022-06-28 18:29 yang_12138 阅读(483) 评论(0) 收藏 举报

浙公网安备 33010602011771号

浙公网安备 33010602011771号