KafKa文件存储机制

KafKa的内部工作流程:

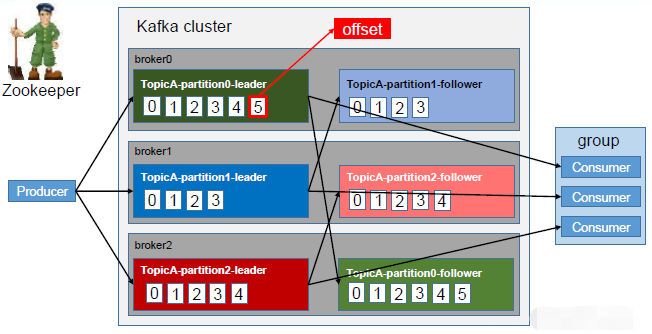

Kafka 中消息是以topic 进行分类的,生产者生产消息,消费者消费消息,都是面向topic的。topic 是逻辑上的概念,而partition 是物理上的概念(实际存在的),每个partition 对应于一个log 文件,该log 文件中存储的就是producer 生产的数据。Producer 生产的数据会被不断追加到该log文件末端,且每条数据都有自己的offset。消费者组中的每个消费者,都会实时记录自己消费到了哪个offset,以便出错恢复时,从上次的位置继续消费。下图是存放在Kafka集群的某个节点中的某个分区下的内容,可以看到有对应的log文件。

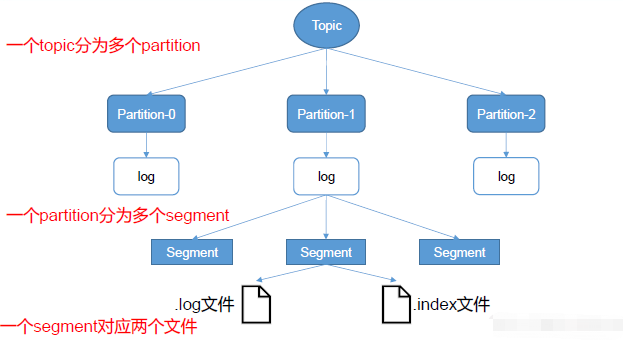

log文件存放生产者发布到topic分区的数据,但是该文件的大小也是有限制的,随着数据量的增加,当log文件的大小超过1GB的时候,会产生一个新的文件,那么新产生的文件会怎么去命名呢?可以看到log文件前面有一串数字,改动的正是这些数字,命名的规则就是以当前文件中最小的偏移量的值命名。

采取这种措施,也是为了防止log文件过大导致数据定位效率低下,Kafka 采取了分片和索引机制,将每个partition 分为多个segment。每个segment对应两个文件——“.index”文件和“.log”文件。这些文件位于一个文件夹下,该文件夹的命名规则为:topic 名称+分区序号。例如,first 这个topic 有三个分区,则其对应的文件夹为first-0,first-1,first-2。

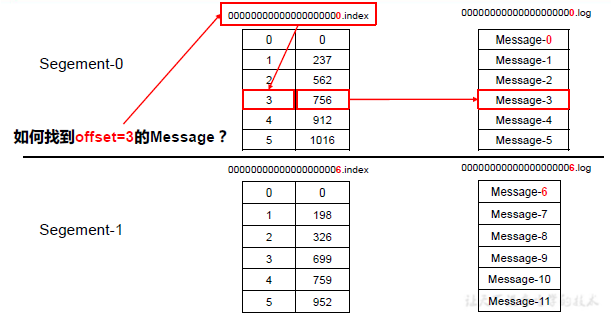

log文件和index文件都是以当前文件中的最小偏移量的值命名。index文件存储大量的索引信息,log文件存储大量的数据,索引文件中的元数据对应数据文件中消息的物理偏移地址。查找消息的时候,会根据offset值以二分查找的方式查找对应的索引文件,找到消息在log文件中的偏移量,最终找到消息。这也就能够保证,消费者挂掉重启的时候,可以根据offset值快速找到上次消费的断点位置。

浙公网安备 33010602011771号

浙公网安备 33010602011771号