resnet残差网络模型结构的简单理解

resnet残差网络模型结构的简单理解

一、提出

通常在深度学习中,越深的网络结构越能获得更具有代表性的特征,但是在网络层数加深的时候往往会出现梯度消失和梯度爆炸的问题,

问题主要是网路越深的时候变化量越小,梯度就逐渐消失,所以就提出学习残差来代替学习原始信号。

残差网络提出就是为了解决怎样在加深网络的情况下又不会发生梯度消失的问题。

二、来源

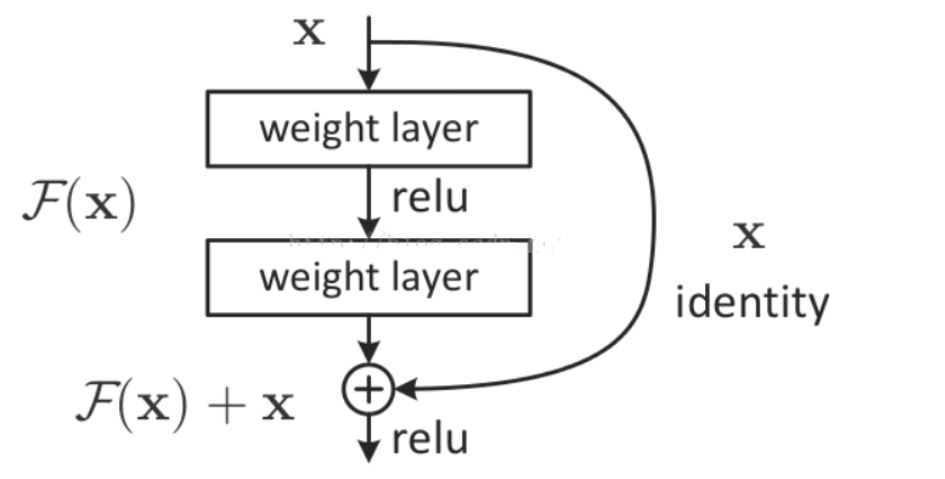

RESNET的灵感来源就是使用恒等映射把前一层的输出直接传送到后面层的输出结果中。

学习目标改变,由h(x)变为h(x)-x,即学习前一步的残差

残差模块输出结果为h(x),h(x)=f(x)+x, 在这里把学习目标从h(x)变为h(x)-x, 梯度不会随深度消失。在反向传播的时候梯度始终保持一个很大的值。

伴随着残差学习的重新表达,如果恒等映射是最优的,那么求解器驱使多个非线性层的权重趋向于零来逼近恒等映射。

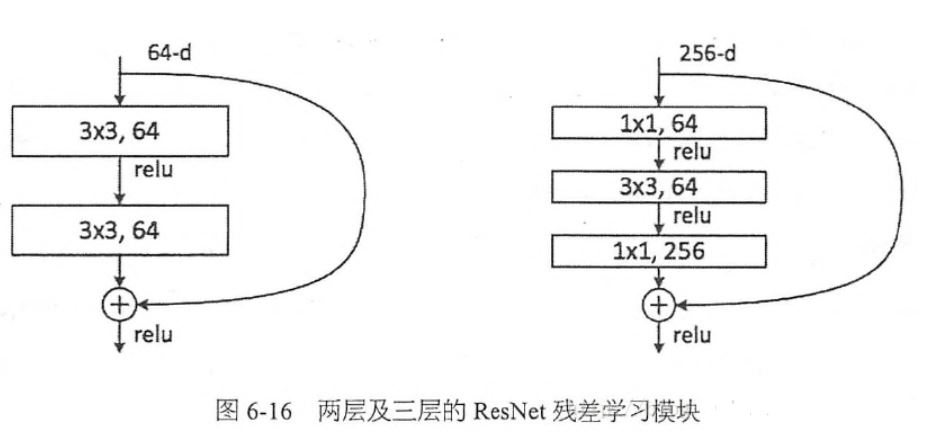

三、残差块构成残差网络模型:

残差模块的结构又称为shortcut和skip connection

详细解释以及各种经典卷积神经网络的模型结构见:https://www.cnblogs.com/guoyaohua/p/8534077.html

凤舞九天