强化学习之基于函数逼近的同轨策略预测(一)-- 价值函数逼近和预测目标

注:本节内容是对Sutton的《Reinforcement Learning:An Introduction》第九章的理解整理~ 这里是第一、二节

我们知道 强化学习主要是通过对状态或动作状态组的值函数估计来进行决策。在之前的讨论中,每个状态的状态值函数只受前继、后继状态的影响,一次更新只影响一个状态(可以看做状态与状态之间的关系是线型 有序的 贝尔曼方程保证),这种情况更适合处理离散状态的问题。本章及以后将会讨论函数逼近法,近似的价值函数不再表示成一个表格,而是一个具有权值向量的函数。这就会出现一个状态被更新时,许多其他状态的价值函数也会被更改(状态之间的关系像一张图 牵一发而动全身)。这样的泛化可能会使学习能力更加强大,但也可能更加难以控制与理解。

价值函数逼近

本书中所有的预测方法都可以表示为对一个待估计的价值函数的更新,这种更新使得某个特定状态下的价值移向一个回溯值。使用符号s→u表示一次单独的更新,s表示更新的状态,u表示s的估计价值朝向的更新目标【朝着这个方向去更新】。每一次的状态对应状态更新值作为理想的“输入-输出”范例样本。

在之前的讨论中,我们使用更新只是简单地向待估计的价值函数方向进行了一定比例的移动,而其它状态的估计价值保持不变。现在则允许使用任意复杂的方法来进行更新,在s上进行的更新会泛化,使得其它状态的估计价值同样发生变化。

理论上有样本就可以利用有监督学习进行逼近,包括人工神经网络、决策树以及各种多元回归多种方法。但并不是所有方法都适用于强化学习。首先要能够从逐步得到的数据中有效地学习,还要处理非平稳的目标函数(随时间变化的目标函数),符合这些条件的估计方法才能应用在强化学习中。

预测目标

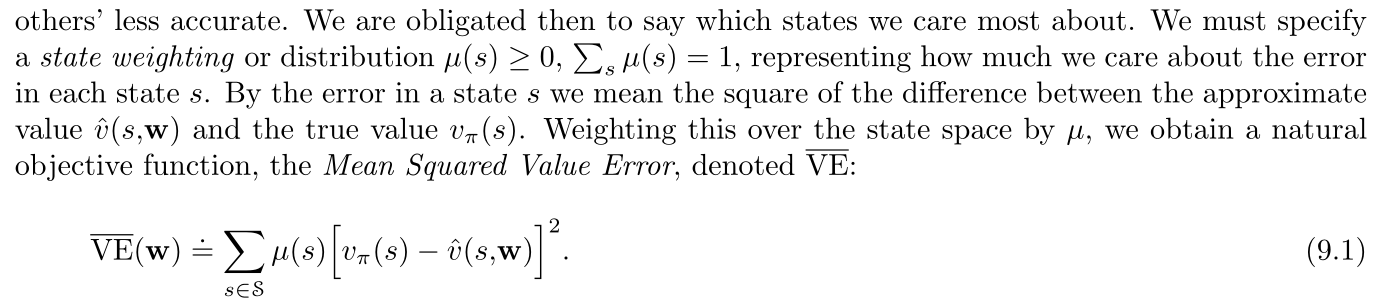

有了样本就需要设置像损失函数一样的衡量标准来判断目前逼近程度的好坏。

需要注意的是在表格型情况下学习到的值函数与真实的值函数相等,不需要对预测质量的连续函数进行衡量。但在连续型函数逼近时,不可能让所有状态的值函数都完全拟合。在无法全部都准确的情况下,我们需要做适当的舍弃和聚焦,给出自己更关注什么的信息来帮助拟合。

指定状态分布\(\mu(s)\)来表示【一般定义为在状态s上消耗的计算时间的比例,在持续性任务中,该分布是\(\pi\)下的平稳分布】,作为均方误差的加权值。

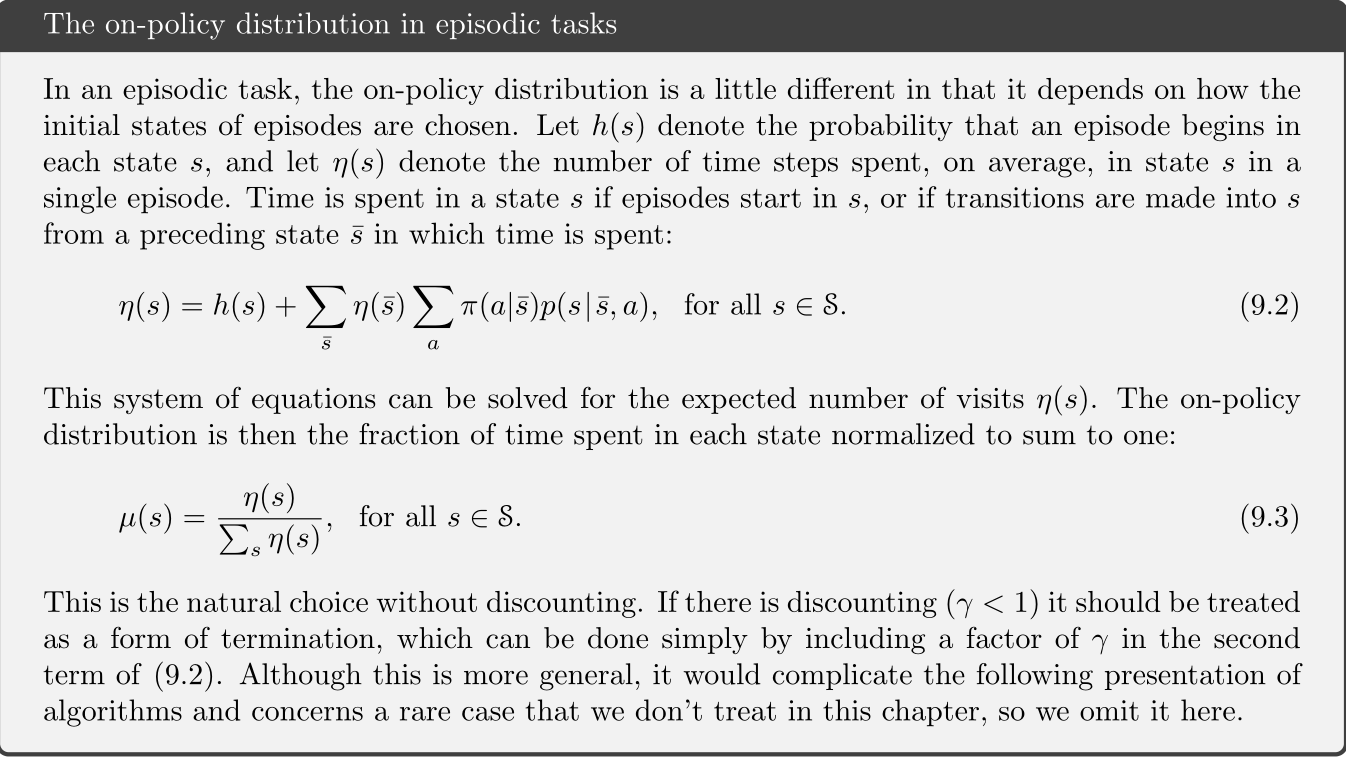

以下是分幕式任务中的同轨策略分布:

这个指标不一定是最好的指标,本身是为了寻找更好的策略,实际上可以视为比较不同序列之间的优劣得到每个队员的好坏。价值函数预测是否精准可能并不重要,我们只是想要它们的相对大小。但就目前而言,我们还是先研究上文中提到的均方价值误差(VE bar)