spark包链接kafka集群报错org.apache.kafka.common.KafkaException: Failed to construct kafka consumer

1、如果是spark执行的包请到spark下面的jars文件夹里检索是否拥有相关的jar包

可以看到我这里是有的,那就不是jar包的问题

2、确认是不是版本问题,在自己的本地测试里看一下maven的包

我这边版本是一致的,所以也不是版本问题,那是什么原因造成创建消费失败的呢

3、kafka的链接

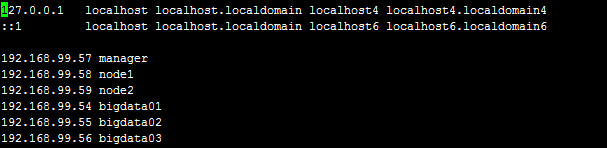

可以看到kafka是用了集群的,三个链接是配置了hosts的,我们看一下我们运行节点的hosts

但是因为我们前面的粗心我其他两个节点并没有配置kafka集群的hosts文件,当我所有节点都加上kafka链接的地址后运行正常