[论文笔记] Crowdsourcing Translation: Professional Quality from Non-Professionals (ACL, 2011)

Time: 4 hours

Timespan: Apr 15 – May 3, 2012

Omar Zaidan, Chris Callison-Burch: Crowdsourcing Translation: Professional Quality from Non-Professionals. ACL 2011: 1220-1229

作者Omar Zaidan是Johns Hopkins University的博士生,主要对NLP感兴趣,专注于text classification and machine translation,编写过一个软件MAISE(Java编写,帮助在mTurk上创建任务、上传文件等)。

下面是主要内容:

1. 本文介绍了一种基于众包的翻译流程,通过redundancy、post edit、rank等手段,来获得质量接近专业水准的译文。

2. (S3) 介绍了整个流程

- (S3.1) 本文使用的数据集是"Urdu-to-English 2009 NITS Evaluation", 包含1792句Urdu语,每句Urdu语有四句参考翻译(由专业人士提供)。

- (S3.2) 作者将这些句子放到了mTurks上,任务是获取这些句子的英文翻译,进行了两轮:第一轮的任务是翻译整个文档,每句Urdu语获得了一份翻译;第二轮进行了改进,拆分了文档,每个任务是翻译10句,并且这些待翻译的句子是以图片的形式展示给worker,这一轮每句Urdu语获得了三份翻译。

- (S3.3) 然后进入Post-editing和Ranking(没找到文中具体描述如何ranking的文字)的步骤,这个步骤的任务也是在mTurk上以任务形式完成,但要求US-based worker才能参与。第一轮获得的翻译被编辑一次,第二轮获得的三份翻译各被编辑三次(不明白为什么要这样区分处理),这样对于一句Urdu语,总共就得到了10份编辑后的翻译和4份初始翻译。

3. 通过(S3)介绍的流程,一份Urdu语获得了14份翻译,而在(S4)中便在介绍如果通过建立恰当的模型以便从这14份中找出最佳的一份。

作者在(S4.1)中介绍了一些features(分为三类):

| 类别 | Feature名称 | 描述 |

| Sentence-level | Language model features | 一种判断句子质量高低的属性,具体不太清楚 (use a 5-gram language model trained on the English Gigaword corpus) |

| Sentence-level | Sentence length features | 质量高的句子长度应该适中 |

| Sentence-level | Web n-gram match percentage | 一种根据n-gram百分比来给句子打分的方法,具体不太清楚(使用了Google N-Gram Database) |

| Sentence-level | Web n-gram geometric average | 一种根据n-gram匹配百分比来给句子进行打分的方法,具体不太清楚 |

| Sentence-level | Edit rate to other translations | edit rate distance from the other translation(使用了TER metric) |

| Worker-level | Aggregate features | 该worker所有translation的sentence-level feature值计算而得 |

| Worker-level | Language abilities | 是否母语,使用年限等 |

| Worker-level | Worker location | 所在地 |

| Ranking | Average rank | 根据ranking label而来 |

| Ranking | Is-Best percentage | 根据ranking label而来 |

| Ranking | Is-Better percentage | 根据ranking label而来 |

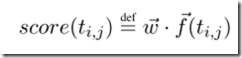

其中f(ti,j)是上面定义的feature,w是权重向量, (S4.2)介绍如何调试出较优的权重值(使用了"linear search method of Och")。这个打分方法算是一种多属性决策方法吧,比较容易理解。

4. 其他可关注的信息

(S1)中提到了SMT(Statistical Machine Translation),对于有大量配对语句的语言来说,这种翻译技术会比较有效。

(S2)中提到mTurks上的一个不足之处是不能提供Turkers的个人背景(比如教育背景、母语等信息)。