Apr 2023-Event Tables for Efficient Experience Replay

Abstract

经验回放(ER)是许多深度强化学习(RL)系统的重要组成部分。然而,从ER缓冲区均匀采样会导致收敛速度慢和渐近行为不稳定。

提出了事件表的分层抽样方法(SSET),它将ER缓冲区划分为多个事件表,每个事件表捕获最优行为的重要子序列。

本文证明了SSET比传统的单块缓冲方法的理论优势,并将SSET与现有的优先采样策略相结合,以进一步提高学习速度和稳定性。在具有挑战性的迷你网格域、基准强化学习环境和高保真汽车比赛模拟器中的经验结果表明,SSET比现有的ER缓冲采样方法具有优势和通用性。

1 Introduction

针对现有ER方法的局限性,引入事件表、保存事件子轨迹的ERB分区,以及相应的包装器算法SSET,为离线强化学习构建训练样本

在大型域中,简单地对事件发生时的少量不连接状态/动作进行过采样不太可能是有益的,因为初始状态值仍然依赖于事件发生之间的状态的均匀采样。相反,我们从以前关于基于轨迹的备份的工作中吸取教训,并将事件之前的有限长度历史存储在相应的事件表中。直观地说,这些数据为事件发生之间的备份形成了一条“快速通道”,可以链接到初始状态。通过从每个表i.i.d中采样单个步骤,SSET使用时间相关数据的小批量避免了不稳定性

为快速车道的直觉建立了理论基础,并表明,如果事件与最优行为相关,并且历史足够长,与使用均匀采样甚至PER相比,SSET可以显著加快非策略学习的收敛。即使这些条件失效,偏差修正项也会保留Bellman目标,尽管收敛速度可能会减慢

贡献:

(1)介绍事件表和事件表SSET框架

(2)我们推导出理论保证,通过适当设计的事件量化样本复杂性的改善,并提供偏差校正,确保Bellman目标保持不变。

(3)我们在具有挑战性的MiniGrid环境和连续RL基准(MuJoCo和Lunar Lander)中实证证明了SSET优于均匀采样或PER的优势,并发现将SSET与TD-error PER或基于潜在的奖励塑造相结合可以进一步改善学习

2 Terminology

3 Related Work

人们提出了许多ERB优先采样的方法。使用最广泛的是优先经验回放(PER),它优先考虑具有最大TD错误的状态/动作。然而,PER并不专门关注与最优策略一致的状态:实际上,即使在行为策略改变后,在一个策略下具有零TD误差的经验也可能永远不会再次采样。除了与PER的经验比较外,本文表明,SSET可以与PER一起使用,以利用这两种方法的好处:专注于依赖与最优策略一致的高价值事件轨迹,但也对那些具有高贝尔曼误差的轨迹上的状态进行优先级排序。其他基于模型误差或元学习过程的优先级来增强vanilla PER的方法也可以类似地与SSET结合使用

事件表概括了erb的几种“多表”划分方案中探索的思想:

(2015)使用不同的表来存储高(或高和低)奖励转换,而不是普通转换,并使用分层抽样来构建小批量。相比之下,SSET允许任何基于状态的事件对ERB进行划分,更重要的是存储导致事件的轨迹,而不仅仅是事件本身,这对于确保样本复杂度至关重要。

清醒梦(2022)将产生比当前值估计更好的蒙特卡洛回报的轨迹存储在一个单独的表中,但依赖于对域的生成访问来创建它们,这不是SSET的要求。

还有(2016)保留两个缓冲区,一个用于策略上的数据,另一个更“统一”的缓冲区,但需要繁重的内核计算来维护它们

4 事件表分层抽样

给定n个事件规范{νi |i∈[1,n]}, ERB被划分为n个事件表Bνi 和一个“默认”表B0。每个Bνi只包含ωi(s')为真的时间步长,或者在事件发生前的时间τi长度的历史中。默认的表B0保存了所有的时间步长,包括发生事件的时间步长。数据以FIFO的方式插入到每个表中,表的容量由参数κi控制,然后用于构建off-policy RL算法A的训练数据。

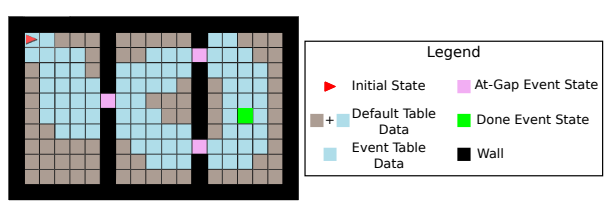

直观地说,每个表都包含了在接近事件发生区域训练值函数所需的数据,并链接在一起形成了备份的“快车道”(图1),与单一的ER相比,这些数据会被过度采样

一个示例MiniGrid域,具有达到目标或房间之间的间隙的事件条件。蓝色方块表示可以过度采样的状态的“快车道”,因为它们同时出现在事件表和默认表中。灰色状态只出现在默认表中。

与PER和其他ERB优先级方案一样,SSET在随机环境中会引入偏差

我们现在陈述论文的主要理论结果.直观地说,该定理表明,使用与最优策略相关的事件条件和足够长的历史的SSET,将有样本复杂度N Bν∪B0,K 用于在状态空间(Sf)的必要部分中学习Q∗(s,a),并且N Bv∪B0,K(大概率)小于使用相同大小的单块缓存进行学习的样本复杂度。